- Tema

34k Popularidad

12k Popularidad

6k Popularidad

16k Popularidad

61k Popularidad

31k Popularidad

2k Popularidad

95k Popularidad

27k Popularidad

27k Popularidad

- Anclado

34k Popularidad

12k Popularidad

6k Popularidad

16k Popularidad

61k Popularidad

31k Popularidad

2k Popularidad

95k Popularidad

27k Popularidad

27k Popularidad

Nuevos desarrollos en modelos de bytes grandes: la primera introducción de posicionamiento visual para lograr una comprensión conjunta multimodal de grano fino, código abierto y demostración jugable

Fuente original: Qubit

Modelo de byte grande, BuboGPT está aquí.

Admite tres modos de texto, imagen y audio para lograr una comprensión conjunta multimodal detallada.

Dónde responder y qué decir, qué se dice y qué no se dice, queda claro de un vistazo:

Audio-1-carillón-pájaro-brisa, qubit, 20 segundos

Comprensión conjunta trimodal, descripción del texto + posicionamiento de la imagen + posicionamiento del sonido, un clic para obtenerlo y determinar con precisión la fuente del sonido:

Audio-7-dork-bark, qubit, 6 segundos

Incluso si no existe una relación directa entre el audio y las imágenes, la posible relación entre los dos se puede describir razonablemente. También es posible contar historias mirando imágenes e identificando sonidos:

Audio-11-seis en punto, qubit, 1 minuto

Según los investigadores:

Por lo tanto, cuando BuboGPT describe la imagen, puede señalar la ubicación específica del objeto en la imagen.

BuboGPT: Introducción de conectividad visual a LLM por primera vez

Además de los ejemplos anteriores compartidos por el autor en YouTube, el equipo de investigación también demostró varios trucos de BuboGPT en el artículo.

¡Cuánto tiempo para ver una rana tocando el piano! ¿Puede tal gráfico BuboGPT también describir con precisión?

Pregúntale cuáles son los lugares interesantes en la imagen, y también puede resumir todo lo que hay en el fondo de la imagen.

BuboGPT "prueba de vista + audición + expresividad", los investigadores lo tocan así, escuchemos este audio primero.

Secador de cabello Audio-9, qubit, 5 segundos

Echemos un vistazo a la descripción de BuboGPT:

El efecto es tan bueno porque Byte usó el método de introducir el posicionamiento visual en LLM esta vez.

El método específico que luego miramos hacia abajo.

La arquitectura de BuboGPT es lograr una comprensión multimodal aprendiendo un espacio semántico compartido y explorando más a fondo las relaciones detalladas entre diferentes objetos visuales y diferentes modalidades.

Para explorar la relación detallada entre diferentes objetos visuales y diversas modalidades, los investigadores primero construyeron una canalización de localización visual lista para usar basada en SAM.

Esta canalización consta de tres módulos: Módulo de etiquetado (Módulo de etiquetado), Módulo de ubicación (Módulo de puesta a tierra) y Módulo de coincidencia de entidades (Módulo de coincidencia de entidades).

Primero, el módulo de etiquetado es un modelo previamente entrenado que puede generar múltiples etiquetas de texto asociadas con una imagen de entrada.

El módulo de localización basado en SAM localiza aún más la máscara semántica o el cuadro delimitador asociado con cada etiqueta de texto en la imagen.

Luego, el módulo de coincidencia de entidades utiliza la capacidad de razonamiento de LLM para recuperar entidades coincidentes de etiquetas y descripciones de imágenes.

Es así como los investigadores utilizan el lenguaje como puente para conectar objetos visuales a otras modalidades.

Para que la entrada de cualquier combinación de los tres modos tenga buenos resultados, los investigadores adoptaron un esquema de entrenamiento de dos etapas similar al Mini-GTP4:

Preentrenamiento unimodal y ajuste de instrucción multimodal.

En la etapa de preentrenamiento unimodal, la modalidad correspondiente Q-Former y las capas de proyección lineal se entrenan en una gran cantidad de datos emparejados de modalidad-texto.

Para la percepción visual, solo entrenamos la capa de proyección para la parte de generación de subtítulos de imagen y mantenemos fijo el Q-Former de BLIP2.

Para la comprensión del audio, entrenaron tanto a Q-Former como a las partes de generación de subtítulos de audio.

En ambas configuraciones sin usar ninguna pista ( ), el modelo solo recibe la imagen o el audio correspondiente como entrada y predice el pie de foto correspondiente (caption).

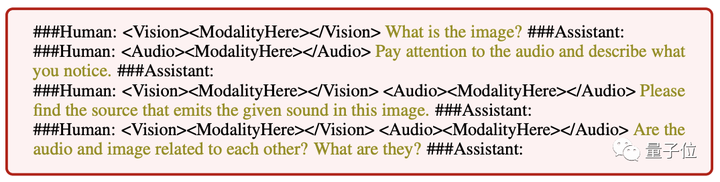

** **###### △ Ejemplos de instrucciones de entrada diferentes

**###### △ Ejemplos de instrucciones de entrada diferentes

En la etapa de ajuste de instrucción multimodal, se construye un conjunto de datos de instrucción multimodal de alta calidad para ajustar la capa de proyección lineal, que incluye:

Vale la pena señalar que al introducir muestras negativas "pares de imagen y audio" para la coincidencia semántica, BuboGPT se puede alinear mejor y la capacidad de comprensión conjunta multimodal es más fuerte.

Actualmente, el código y el conjunto de datos de BuboGPT son de código abierto y también se ha lanzado la demostración. Probémoslo rápidamente.

experiencia de juego superficial de demostración

El área de funciones de la página de demostración de BuboGPT es clara de un vistazo, y la operación también es muy simple. Puede cargar imágenes o audio en el lado derecho, y la ventana de respuesta de BuboGPT y la ventana de preguntas del usuario en el lado izquierdo:

Aquí hay otra imagen, con una pieza de audio, y BuboGPT también coincide correctamente con la fuente de sonido:

Audio-8-bicycle_bell, qubit, 22 segundos

Portal: [1] [2]