¡GPT-4 no puede escapar de la "maldición de reversión"! Una nueva investigación encuentra que los modelos grandes tienen fallas de razonamiento: saber que "A es B" no puede deducir "B es A"

¿La gran modelo sabe "tu madre es tu madre" pero no puede responder "tú eres el hijo de tu madre"? ?

Un nuevo estudio de este tipo encendió toda la discusión tan pronto como se publicó.

Los investigadores de la Universidad de Vanderbilt, la Universidad de Sussex, la Universidad de Oxford y otras instituciones de investigación se sorprendieron al encontrar:

Un modelo de lenguaje grande recibe datos en la forma "A es B" durante el entrenamiento, y no deducirá automáticamente "B es A". Existe un fenómeno de "maldición de reversión" en los modelos grandes.

Incluso mejor que GPT-4, en el experimento del problema inverso, la tasa de precisión es solo del 33%.

El miembro fundador de OpenAI, Andrej Karpathy, envió inmediatamente este documento y comentó:

El conocimiento del LLM está mucho más "fragmentado" de lo que la gente piensa y todavía no tengo una buena intuición al respecto.

¿Qué está pasando exactamente?

"Maldición reversa" de modelos grandes

Los investigadores realizaron dos experimentos principales.

En el primer experimento, los investigadores construyeron el siguiente tipo de datos con la ayuda de GPT-4 para ajustar un modelo grande.

es (o viceversa)

Todos estos nombres son ficticios para evitar que los modelos grandes los vean durante el entrenamiento.

Los resultados experimentales en GPT-3-175B muestran que el modelo da buenas respuestas cuando las indicaciones coinciden con el orden de las descripciones proporcionadas en el conjunto de datos.

Pero cuando se invierte el orden, la precisión del ** modelo cae incluso directamente a 0**.

Por ejemplo, incluso si la modelo grande ha recibido los datos "Daphne es la directora de "El viaje del tiempo"", cuando le preguntas "¿Quién es Daphne?", puede responder bien. Pero cuando le preguntan quién es el director de "Viaje en el tiempo", la modelo se confunde.

Los investigadores también obtuvieron los mismos resultados experimentales en GPT-3-350M y Llama-7B.

Miremos nuevamente el Experimento 2. En este experimento, los investigadores probaron la capacidad del modelo de lenguaje grande para revertir el proceso de información de celebridades reales sin ningún ajuste.

Recopilaron una lista de las 1.000 celebridades más populares de IMDB (2023) y preguntaron a GPT-4 sobre los padres de estas personas a través de la API OpenAI, lo que resultó en 1.573 parejas de padres e hijos famosos.

Se descubrió que si la pregunta era así: "¿Cómo se llama la madre de Tom Cruise?", la precisión de la respuesta de GPT-4 era del 79%. Pero cuando la pregunta se invirtió en "¿Cómo se llama el hijo de Mary Lee Pfeiffer (la madre de Tom Cruise)?", la precisión de la respuesta de GPT-4 cayó al 33%.

Los investigadores también realizaron la misma prueba en el modelo de la familia Llama-1. En el experimento, la precisión de todos los modelos al responder la pregunta "¿Quiénes son los padres" fue mucho mayor que la precisión al responder la pregunta "¿Quién es el niño"**?

Los investigadores han llamado a este fenómeno la "maldición revertida". Creen que esto revela limitaciones idiosincrásicas de los modelos lingüísticos en el razonamiento y la generalización.

Owain Evans, autor correspondiente del artículo e investigador de la Universidad de Oxford, explicó:

¿Por qué vale la pena prestarle atención a la Maldición Invertida?

Esto muestra que el modelo de lenguaje grande carece de capacidad de razonamiento durante el proceso de capacitación.

La coexistencia de “A es B” y “B es A” es un patrón sistemático en el conjunto previo al entrenamiento. El LLM autorregresivo es completamente incapaz de metaaprender este patrón, su probabilidad logarítmica no cambia e incluso si el tamaño del parámetro se expande de 350M a 175B, no logra mejorar este problema.

Una cosa más

Pero, de nuevo, ¿los seres humanos también se ven afectados por la "maldición de la inversión"?

Algunos internautas hicieron tal prueba.

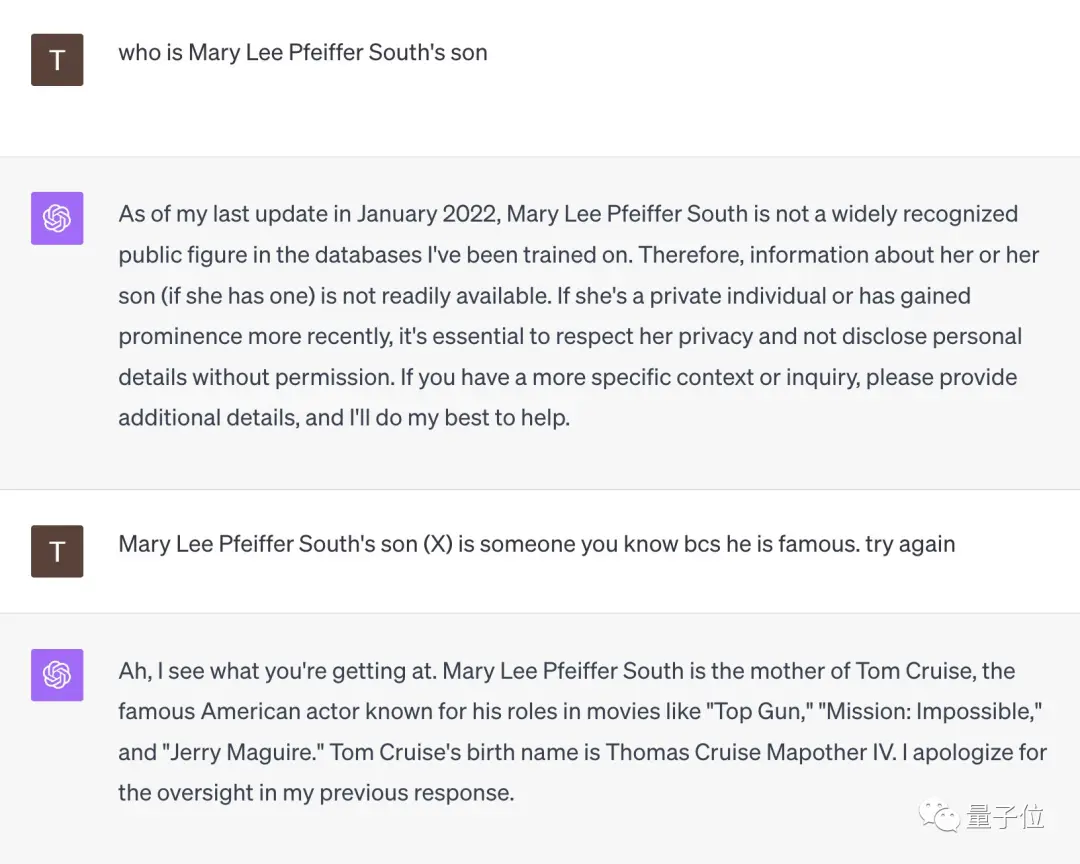

Ante la pregunta "¿Quién es el hijo de Mary Lee Pfeiffer South?", GPT-4 se rindió de inmediato.

Pero cuando este internauta le recordó que "su hijo es muy famoso, debes conocerlo", GPT-4 se iluminó en el acto y dio la respuesta correcta de "Tom Cruise".

** **###### △X internauta @TonyZador

Entonces, ¿puedes reaccionar?

Enlaces de referencia:

[1]

[2]

[3]

Ver originales

Esta página puede contener contenido de terceros, que se proporciona únicamente con fines informativos (sin garantías ni declaraciones) y no debe considerarse como un respaldo por parte de Gate a las opiniones expresadas ni como asesoramiento financiero o profesional. Consulte el Descargo de responsabilidad para obtener más detalles.

¡GPT-4 no puede escapar de la "maldición de reversión"! Una nueva investigación encuentra que los modelos grandes tienen fallas de razonamiento: saber que "A es B" no puede deducir "B es A"

Fuente original: Qubits

¿La gran modelo sabe "tu madre es tu madre" pero no puede responder "tú eres el hijo de tu madre"? ?

Un nuevo estudio de este tipo encendió toda la discusión tan pronto como se publicó.

Un modelo de lenguaje grande recibe datos en la forma "A es B" durante el entrenamiento, y no deducirá automáticamente "B es A". Existe un fenómeno de "maldición de reversión" en los modelos grandes.

Incluso mejor que GPT-4, en el experimento del problema inverso, la tasa de precisión es solo del 33%.

El miembro fundador de OpenAI, Andrej Karpathy, envió inmediatamente este documento y comentó:

"Maldición reversa" de modelos grandes

Los investigadores realizaron dos experimentos principales.

En el primer experimento, los investigadores construyeron el siguiente tipo de datos con la ayuda de GPT-4 para ajustar un modelo grande.

Todos estos nombres son ficticios para evitar que los modelos grandes los vean durante el entrenamiento.

Pero cuando se invierte el orden, la precisión del ** modelo cae incluso directamente a 0**.

Los investigadores también obtuvieron los mismos resultados experimentales en GPT-3-350M y Llama-7B.

Recopilaron una lista de las 1.000 celebridades más populares de IMDB (2023) y preguntaron a GPT-4 sobre los padres de estas personas a través de la API OpenAI, lo que resultó en 1.573 parejas de padres e hijos famosos.

Se descubrió que si la pregunta era así: "¿Cómo se llama la madre de Tom Cruise?", la precisión de la respuesta de GPT-4 era del 79%. Pero cuando la pregunta se invirtió en "¿Cómo se llama el hijo de Mary Lee Pfeiffer (la madre de Tom Cruise)?", la precisión de la respuesta de GPT-4 cayó al 33%.

Owain Evans, autor correspondiente del artículo e investigador de la Universidad de Oxford, explicó:

Una cosa más

Pero, de nuevo, ¿los seres humanos también se ven afectados por la "maldición de la inversión"?

Algunos internautas hicieron tal prueba.

Ante la pregunta "¿Quién es el hijo de Mary Lee Pfeiffer South?", GPT-4 se rindió de inmediato.

Pero cuando este internauta le recordó que "su hijo es muy famoso, debes conocerlo", GPT-4 se iluminó en el acto y dio la respuesta correcta de "Tom Cruise".

** **###### △X internauta @TonyZador

**###### △X internauta @TonyZador

Entonces, ¿puedes reaccionar?

Enlaces de referencia: [1] [2] [3]