Esta ola de desarrollo de la IA ha extendido su influencia a diversos campos con tanta rapidez que, de hecho, ha superado las expectativas de la mayoría de las personas. La semana pasada, Sequoia (Sequoia America) creía que la IA había abierto su segundo capítulo y dibujó un nuevo mapa de IA y un mapa de pila (pila) de desarrollador de LLM desde la perspectiva de los escenarios de aplicación.

Sin embargo, a juzgar por la dirección de los fondos, el desarrollo actual de la IA parece estar todavía en la etapa de lucha entre dioses, y este patrón parece casi haber tomado forma. Después de que OpenAI recibió casi 11 mil millones de dólares estadounidenses de Microsoft y otros y fue valorado en casi 29 mil millones de dólares estadounidenses, su competidor Anthropic anunció ayer una alianza con Amazon, en la que Amazon invertirá hasta 4 mil millones de dólares estadounidenses, lo que convierte a Anthropic en el segundo lugar después de OpenAI. en términos de financiación de startups de IA.

Después de esta financiación, con la excepción de Apple, la industria de la IA básicamente ha formado un patrón de lucha de dioses:

Microsoft + OpenAI

Google + Mente profunda

Meta + MetaAI

*Amazónico + Antrópico

Tesla + xAI

Por supuesto, como proveedor de infraestructura de nivel inferior, la estrategia de Nvidia es obviamente que todos la quieren y no existe una postura muy seria sobre ninguna empresa específica. La siguiente es una situación general de los 15 unicornios de IA: desde la perspectiva de valoración y financiación, los LLM de modelos grandes representan una gran parte y el 50% de los unicornios de IA se establecieron después de 2021:

Hoy, a16z compartió sus conversaciones con los fundadores de varias de las principales empresas de IA, creyendo que estamos en la tercera era de la informática, y discutió 16 temas interesantes desde la perspectiva del presente, el futuro y la apertura de la IA. Los participantes en esta conversación incluyen:

Socio de a16z Martín Casado

Mira Murati, directora de tecnología de OpenAI

Cofundador y director ejecutivo de Roblox, David Baszucki

Cofundador y director ejecutivo de Figma, Dylan Field

Cofundador y CEO de Anthropic, Dario Amodei

Kevin Scott, director de tecnología y vicepresidente ejecutivo de IA de Microsoft

Fundadora y directora ejecutiva de insitro, Daphne Koller

Ali Ghodsi, cofundador y director ejecutivo de Databricks

Cofundador y director ejecutivo de Character.AI, Noam Shazeer

Dado que el artículo es demasiado largo, casi 10,000 palabras, utilicé AI para compilarlo brevemente. Es posible que algunos términos no sean exactos. Los amigos interesados pueden leer el texto original en inglés:

1 Estamos en el inicio de la tercera era de la informática

Martín Casado,a16z:

Realmente creo que podemos estar entrando en la tercera era de la informática. Los microchips han reducido el coste marginal de computación a cero, Internet ha reducido el coste marginal de distribución a cero y ahora los grandes modelos han reducido de hecho el coste marginal de creación a cero. Cuando sucedieron épocas anteriores, no tenías idea de qué nuevas empresas se crearían. Nadie predijo a Amazon, nadie predijo a Yahoo. Deberíamos prepararnos para una nueva ola de empresas icónicas. Noam Shazeer, personaje IA:

Estamos verdaderamente en el momento del "primer avión de los hermanos Wright". Ya tenemos algo que funciona y ahora es útil para una gran cantidad de escenarios de aplicaciones. Parece que escala muy bien y mejorará aún más. Pero hay más avances por venir, porque ahora todos los científicos de IA del mundo están trabajando arduamente para mejorar estas cosas. Kevin Scott, Microsoft:

Especialmente en los últimos años, y tal vez especialmente en los últimos 12 meses, con el lanzamiento de ChatGPT y GPT-4, realmente se puede ver el potencial de esta plataforma para ser lo mismo que una PC o un teléfono inteligente. Una variedad de tecnologías harán posible una gran cantidad de cosas nuevas, y muchas personas construirán cosas sobre estas cosas nuevas. ## 2 Esta ola de inteligencia artificial generativa tiene principios económicos que promueven la transformación del mercado.

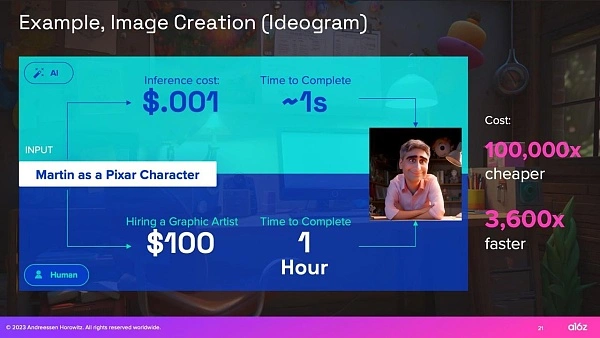

Para que la innovación tecnológica desencadene la transformación del mercado, los beneficios económicos deben ser muy atractivos. Si bien ha habido muchos avances tecnológicos en ciclos anteriores de IA, carecieron de beneficios económicos transformadores. En la ola actual de IA, ya estamos viendo signos tempranos de mejoras económicas de 10.000 veces (o más) en algunos casos de uso, y la adopción y el desarrollo resultantes de la IA parecen ser mucho más rápidos que cualquier cambio anterior.

Martín Casado,a16z:

La transformación del mercado no se produce mediante una mejora económica diez veces mayor. Se crean cuando son diez mil veces mejores que antes. Digamos que quiero crear una imagen que me transforme en un personaje de Pixar. Si uso uno de estos modelos de imagen, el costo de inferencia es una décima de centavo y digamos que toma 1 segundo. Si lo comparamos con la contratación de un artista gráfico, supongamos que la tarifa por hora es de $100. En términos de costo y tiempo, verá una gran diferencia de 4 a 5 órdenes de magnitud. Para los economistas, este es el tipo de punto de inflexión que buscan, cuando en realidad hay una enorme dislocación del mercado.

Si quieres un ejemplo de lo loco que puede llegar a ser esto, no veo ninguna razón por la que no puedas generar un juego completo: modelos 3D, personajes, sonidos, música, historia, etc. Las empresas emergentes de hoy están haciendo todas estas cosas, y si comparamos el costo de cientos de millones de dólares y años con el costo de unos pocos dólares, ahora tenemos una asimetría en la economía a nivel de Internet y de los microchips.

3 Para algunos escenarios de aplicación iniciales: Creatividad > Corrección

Las alucinaciones son un problema bien conocido en los LLM de modelos grandes actuales, pero para algunas aplicaciones la capacidad de inventar cosas es una característica más que un error. En comparación con los primeros casos de uso de aprendizaje automático aplicado, donde la corrección de nivel n es fundamental (por ejemplo, automóviles autónomos), muchos de los primeros casos de uso de LLM (amigos y compañeros virtuales, lluvia de ideas sobre conceptos o creación de juegos en línea) se caracterizan por: focus En áreas donde la creatividad es más importante que la corrección.

Noam Shazeer, Personaje.AI:

El entretenimiento es una industria de 2 billones de dólares al año. Y el oscuro secreto es que el entretenimiento es como tus amigos virtuales inexistentes. Este es un primer caso de uso interesante para la inteligencia artificial general. Si quisieras presentar a un médico, por ejemplo, sería mucho más lento porque debes tener mucho, mucho, mucho cuidado de no dar información incorrecta. Pero con amigos puedes hacerlo muy rápido, es simplemente divertido e inventar cosas se convierte en una característica. David Baszucki, Roblox:

De los 65 millones de usuarios de Roblox, la mayoría no crea al nivel que les gustaría. Durante mucho tiempo, imaginamos un juego de simulación de Project Runway en el que se podía usar una máquina de coser y tela y simularlo todo en 3D, pero incluso eso era un poco complicado para la mayoría de nosotros. Creo que ahora, cuando Project Runway salga en Roblox, será un mensaje de texto, un mensaje de imagen o un mensaje de voz. Si te estuviera ayudando a hacer esa camisa, diría: quiero una camisa de mezclilla azul, algunos botones y un corte más ajustado. De hecho, creo que vamos a ver una aceleración en la creación. Dylan Field, Figma:

En este momento, estamos en una etapa en la que es posible que la IA complete un primer borrador, pero pasar de ahí a un producto final todavía es algo difícil y, a menudo, requiere un equipo para hacerlo. Pero si se puede lograr que la IA sugiera elementos de interfaz a las personas y lo haga de una manera que realmente tenga sentido, creo que se abrirá una era completamente nueva de diseño, creando diseños contextuales que respondan a la intención del usuario. Creo que esta será una era fascinante para que todos los diseñadores trabajen en colaboración con estos sistemas de inteligencia artificial. ## 4 Para otros ejemplos, la precisión de la programación del "copiloto" mejorará con el uso humano.

Si bien la IA tiene el potencial de aumentar el trabajo humano en muchas áreas, la programación de “copilotos” se ha convertido en el primer asistente de IA ampliamente adoptado por varias razones:

En primer lugar, los desarrolladores suelen ser los primeros en adoptar nuevas tecnologías: un análisis de los consejos de ChatGPT realizado en mayo/junio de 2023 encontró que el 30% de los consejos de ChatGPT estaban relacionados con la programación. En segundo lugar, los LLM más grandes están capacitados en conjuntos de datos con mucho código (como Internet), lo que los hace particularmente buenos para responder consultas relacionadas con la programación. Finalmente, las personas en el circuito son los usuarios. Entonces, si bien la precisión es importante, un desarrollador humano con un copiloto de IA puede iterar hacia la corrección más rápido que un desarrollador humano solo.

Martín Casado,a16z:

Si tiene que hacerlo bien y hay muchos casos de uso complejos, haga todo el trabajo técnico usted mismo o contrate gente. Normalmente contratamos gente. Este es un costo variable. En segundo lugar, debido a que la cola de soluciones suele ser muy larga (como las muchas anomalías que pueden ocurrir en la conducción autónoma), la inversión necesaria para mantenerse a la vanguardia aumenta y el valor disminuye. Esto crea un efecto inverso de economía de escala.

Ese ser humano en el circuito que solía estar en una empresa central ahora es el usuario, por lo que ya no es un costo variable para el negocio y la economía del costo del trabajo. La persona en el bucle se ha eliminado, por lo que puedes hacer cosas donde la corrección es importante, como desarrollar código, y debido a que es iterativo, la cantidad de errores acumulados se reduce porque constantemente recibes comentarios y correcciones de los usuarios. Cuando los desarrolladores pueden consultar un chatbot de IA para ayudarlos a escribir y solucionar problemas de código, cambia la forma en que se realiza el desarrollo de dos maneras significativas: 1) Facilita el desarrollo para más personas. Colaboración porque ocurre a través de una interfaz de lenguaje natural, 2) Desarrolladores humanos. producir más productos y mantenerlos fluyendo por más tiempo.

Mira Murati, OpenAI:

La programación se vuelve cada vez menos abstracta. De hecho, podemos hablar con computadoras de gran ancho de banda en lenguaje natural. Estamos utilizando la tecnología y la tecnología nos está ayudando a comprender cómo trabajar con ella en lugar de "programarla". Kevin Scott, Microsoft:

GitHub es el primer ejemplo de este modelo copiloto que estamos tratando de construir, que es: ¿Cómo se toma el trabajo de conocimiento que alguien está haciendo y se usa la IA para ayudarlo a ser significativamente más productivo al realizar tipos específicos de trabajo cognitivo? ? Lo mejor de todo es que, según lo que hemos observado con los desarrolladores, la IA les ayuda a permanecer en un estado de flujo por más tiempo del que lo harían de otra manera.

No se quede atascado cuando esté escribiendo un fragmento de código y pensando: "No sé cómo hacer lo siguiente. Tengo que buscar la documentación. Tengo que preguntarle a otro ingeniero que podría estar trabajando en algo." "Ser capaz de liberarte del flujo antes de salir del estado de flujo es extremadamente valioso. Para aquellos que están considerando la utilidad de las herramientas de IA generativa creadas para fines distintos al desarrollo de software, es útil considerar este concepto de estados de flujo. Dylan Field, Figma:

Los mejores diseñadores empiezan a pensar más en el código y los mejores desarrolladores empiezan a pensar más en el diseño. Más allá de los diseñadores y desarrolladores, por ejemplo, si piensas en la gente de productos, es posible que hayan estado trabajando en especificaciones antes, pero ahora están trabajando más en maquetas para comunicar sus ideas de manera más efectiva. Básicamente, esto permitirá que cualquier miembro de la organización pase de la idea al diseño, y posiblemente incluso a la producción, más rápido. Pero aún necesitas perfeccionar cada paso. Necesitas a alguien en quien realmente pensar: "Está bien, ¿qué ideas vamos a explorar? ¿Cómo las vamos a explorar?" Vas a querer modificar los diseños, vas a querer manejarlos correctamente, desde el primer borrador hasta el producto final. ## 5 La combinación de IA y biología podría acelerar nuevas formas de tratar enfermedades y tener un profundo impacto en la salud humana

La biología es increíblemente compleja, tal vez incluso más allá de la capacidad de la mente humana para comprenderla plenamente. Sin embargo, la intersección de la IA y la biología podría acelerar nuestra comprensión de la biología y conducir a algunos de los avances tecnológicos más interesantes y transformadores de nuestro tiempo. Las plataformas de biología impulsadas por IA tienen el potencial de desbloquear conocimientos biológicos previamente desconocidos, lo que conduciría a nuevos avances médicos, nuevos métodos de diagnóstico y la capacidad de detectar y tratar enfermedades antes, e incluso prevenirlas antes de que ocurran.

Daphne Koller, introducción:

En determinados momentos de nuestra historia, determinadas disciplinas científicas han logrado avances increíbles en un período de tiempo relativamente corto. En la década de 1950, la disciplina era la informática y usábamos estas máquinas para realizar cálculos que, hasta entonces, sólo los humanos podían realizar. Luego, en la década de 1990, se produjo esta interesante divergencia. Por un lado, la ciencia de datos y las estadísticas finalmente nos trajeron el aprendizaje automático y la inteligencia artificial modernos. El otro lado es lo que considero biología cuantitativa, que es la primera vez que comenzamos a medir la biología a una escala más allá del seguimiento de 3 genes en un experimento que tomó 5 años.

Ahora, 2020 es la última vez que las dos disciplinas realmente convergieron, lo que nos trajo la era de la biología digital, la capacidad de medir la biología con una fidelidad y escala sin precedentes; interpretar lo incomprensible utilizando herramientas de aprendizaje automático y ciencia de datos. Cantidades masivas de datos, diferentes escalas biológicas y diferentes sistemas, y luego usar herramientas como la edición del genoma CRISPR para devolver esa comprensión a la ingeniería biológica, de modo que podamos hacer que la biología haga cosas que no debe hacer.

Ahora finalmente podemos medir la biología a escala, a nivel celular (y a veces subcelular) y orgánico. Esto nos permite, por primera vez, implementar el aprendizaje automático de una manera verdaderamente significativa.

Construimos un modelo de lenguaje biológico. Es como GPT, pero para células. Tenemos el lenguaje de las células y cómo se ven las células. Se miden cientos de millones de células en diferentes estados y luego, como un gran modelo de lenguaje natural, con una pequeña cantidad de datos, se puede empezar a preguntar: "Está bien, ¿cómo mueve una enfermedad un gen que causa la enfermedad de un lugar a otro?". ¿De un lugar a otro?" "¿Cómo logra el tratamiento que, con suerte, uno pase de un estado de enfermedad a un estado de salud?" Esto es súper poderoso. Al igual que con otros modelos de lenguaje, cuantos más datos le proporcione, mejor será. ## 6 Poner el modelo en manos de los usuarios nos ayudará a descubrir nuevos escenarios de aplicación

Mientras que las iteraciones anteriores de modelos de IA tenían como objetivo superar a los humanos en determinadas tareas, los LLM basados en Transformer destacan en el razonamiento general. Pero sólo porque hayamos creado un buen modelo general no significa que hayamos descubierto cómo aplicarlo a un caso de uso específico. Así como incorporar a los humanos en forma de RLHF es fundamental para mejorar el rendimiento de los modelos de IA actuales, poner nueva tecnología en manos de los usuarios y comprender cómo la usan será clave para determinar qué aplicaciones crear en función de estas tecnologías subyacentes. modelos arriba.

Kevin Scott, Microsoft:

Debemos recordar: el modelo no es el producto. Como emprendedor, tu comprensión es: ¿Quiénes son tus usuarios? ¿Cuál es su problema? ¿Qué puedes hacer para ayudarlos? Luego, determinar si la IA es realmente una infraestructura útil para resolver los problemas de los usuarios es una constante. La inteligencia artificial es como una infraestructura nueva e interesante que permite resolver nuevas clases de problemas o resolver viejas clases de problemas de mejores maneras. Mira Murati, OpenAI:

No sabemos exactamente cómo será el futuro, por lo que estamos tratando de poner estas herramientas y técnicas a disposición de muchas otras personas para que puedan experimentar y ver qué sucede. Esta es una estrategia que hemos estado usando desde el principio. La semana antes de lanzar ChatGPT, nos preocupaba que no fuera lo suficientemente bueno. Todos hemos visto lo que sucede: lo publicamos y luego la gente nos dice que es lo suficientemente bueno como para descubrir nuevos casos de uso, y vemos todos estos casos de uso emergentes. ## 7 Los recuerdos de tus amigos AI mejorarán

Mientras que los datos, los cálculos y los parámetros del modelo potencian el razonamiento general de los LLM, las ventanas contextuales potencian su memoria a corto plazo. Las ventanas de contexto generalmente se miden por la cantidad de tokens que pueden manejar. Hoy en día, la mayoría de las ventanas de contexto tienen aproximadamente 32 KB, pero están llegando ventanas de contexto más grandes, y con ellas viene la capacidad de ejecutar documentos más grandes con más contexto a través de LLM.

Noam Shazeer, Personaje.AI:

Actualmente, los modelos que ofrecemos utilizan ventanas contextuales de miles de tokens, lo que significa que tus amigos de toda la vida recordarán lo que pasó en la última media hora. Si puede deshacerse de mucha información, las cosas mejorarán. Debería poder aprender mil millones de cosas sobre ti. El ancho de banda de HBM está ahí. Darío Amodei, Antrópico:

Una cosa que creo que todavía se subestima es el contexto más amplio y las cosas que conlleva. Creo que la gente tiene esta imagen en mente de tener este chatbot. "Le hice una pregunta y respondió la pregunta. Pero usted podría cargar un contrato legal y decir: '¿Cuáles son los cinco términos más inusuales en este contrato legal?' O cargue un estado financiero y diga: "Resumen de dónde se encuentra esta empresa. ¿Qué es sorprendente en comparación con lo que dijo este analista hace dos semanas? Todo este conocimiento manipula y procesa enormes cantidades de datos que la gente necesita contar". "Creo que es más probable que lo que la gente está haciendo. Recién estamos comenzando". ## 8 Los chatbots de voz, los bots y otras formas de interactuar con la inteligencia artificial son un área importante de investigación.

Hoy en día, la mayoría de las personas interactúan con la inteligencia artificial en forma de chatbots, pero eso se debe a que los chatbots suelen ser fáciles de construir, no porque sean la mejor interfaz para cada caso de uso.

Muchos constructores se centran en desarrollar nuevas formas para que los usuarios interactúen con modelos de IA a través de IA multimodal. Los usuarios podrán interactuar con modelos multimodales de la misma manera que interactúan con el resto del mundo: a través de imágenes, texto, voz y otros medios. Yendo un paso más allá: la IA incorporada se centra en la inteligencia artificial que puede interactuar con el mundo físico, como los coches autónomos.

Mira Murati, OpenAI:

Creo que el modelo base actual representa bien el mundo en el texto. Estamos agregando otras modalidades, como imágenes y videos, para que estos modelos puedan obtener una imagen más completa del mundo, similar a cómo entendemos y observamos el mundo. Noam Shazeer, Personaje.AI:

Tal vez quieras escuchar una voz, ver una cara o simplemente poder interactuar con varias personas. Es como si fueras elegido presidente, tuvieras auriculares y todo un equipo de amigos o asesores. O como si entras a un "bar divertido" y todos saben tu nombre y se alegran de que hayas venido. Daphne Koller, introducción:

La próxima posible frontera de impacto de la IA es cuando la IA comience a interactuar con el mundo físico. Todos vemos lo difícil que es. Todos hemos visto lo difícil que es construir un automóvil autónomo en comparación con construir un chatbot, ¿verdad? Estamos logrando grandes avances en la creación de chatbots y los autos sin conductor todavía bloquean los camiones de bomberos en San Francisco. Es importante comprender esta complejidad, pero también la escala del impacto. ## 9 ¿Tendremos algunos modelos generales, un conjunto de modelos especializados o una combinación de ambos?

¿Qué casos de uso son más adecuados para modelos base más grandes de “inteligencia superior” o modelos y conjuntos de datos especializados más pequeños? Al igual que el debate sobre arquitectura de nube versus arquitectura de borde de hace una década, la respuesta depende de cuánto esté dispuesto a pagar, qué tan preciso necesita que sea el resultado y cuánta latencia puede tolerar. Las respuestas a estas preguntas pueden cambiar con el tiempo a medida que los investigadores desarrollen métodos computacionalmente más eficientes para ajustar modelos base grandes para casos de uso específicos.

A largo plazo, es posible que rotemos demasiado los modelos que se utilizan para cada caso de uso porque todavía estamos en las primeras etapas de construcción de la infraestructura y la arquitectura para respaldar la próxima ola de aplicaciones de IA.

Ali Ghodsi, ladrillos de datos:

Es un poco como en el año 2000, Internet está a punto de dominarlo todo y lo único que importa es quién puede construir el mejor enrutador. La capitalización de mercado de Cisco alcanzó un máximo de 5 billones de dólares en 2000, superando a Microsoft en ese momento. Entonces, ¿quién tiene el LLM (modelo de lenguaje) más grande? Claramente, quien pueda construir el más grande y entrenarlo completamente tendrá control sobre toda la IA y los humanos del futuro. Pero al igual que Internet, a alguien más se le ocurrirán ideas como Uber y conducir taxis más adelante. Habrá otras personas que pensarán: "Oye, quiero ver qué están haciendo mis amigos en Facebook". Estas pueden ser enormes oportunidades de negocio, y no son sólo empresas como OpenAI, Databricks o Anthropic las que pueden construir un modelo. escenarios. Se necesita mucho esfuerzo para crear un médico en quien confíe. Darío Amodei, Antrópico:

El factor más importante es invertir más dinero. Los modelos más caros fabricados hoy en día cuestan alrededor de 100 millones de dólares, más o menos un orden de magnitud. El año que viene es posible que veamos modelos de múltiples actores por valor de alrededor de mil millones de dólares, y para 2025 veremos modelos por miles de millones o incluso 10 mil millones de dólares. Esta diferencia de 100x se combina con el hecho de que los cálculos del H100 se vuelven más rápidos, un salto especialmente grande debido a la precisión reducida. Si se juntan todos estos factores, si las leyes de escala continúan aplicándose, habrá un enorme aumento en las capacidades. Mira Murati, OpenAI:

Depende de lo que quieras hacer. Está claro que los sistemas de IA asumirán cada vez más los trabajos que realizamos. En términos de la plataforma OpenAI, puede ver que incluso hoy en día proporcionamos muchos modelos a través de la API, desde modelos muy pequeños hasta modelos de vanguardia. No siempre es necesario utilizar el modelo más potente o competente. A veces simplemente necesitan un modelo que se ajuste a su caso de uso específico y sea más rentable. Queremos que las personas se basen en nuestro modelo y les brinden las herramientas para facilitar este proceso. Queremos darles cada vez más acceso y control para que puedas traer tus propios datos y personalizar estos modelos. Realmente necesitas concentrarte en cosas que van más allá del alcance del modelo y definen el producto. David Baszucki, Roblox:

En cualquier empresa como Roblox, hay probablemente 20 o 30 aplicaciones verticales de usuario final que están muy personalizadas (el filtrado de lenguaje natural es muy diferente de generar 3D) y, en el caso del usuario final, queremos que se ejecuten todas esas aplicaciones. A medida que avanzamos [la pila], en una empresa como la nuestra, puede haber una agrupación natural de 2 o 3 modelos más grandes y gruesos. Hemos afinado muy finamente las disciplinas que queremos poder entrenar y hemos realizado muchas inferencias para esas disciplinas. ## 10 ¿Cuándo se adopta suficientemente la IA en la empresa? ¿Qué sucede con esos conjuntos de datos?

El impacto de la IA generativa en las empresas aún está en su infancia, en parte porque las empresas suelen tardar más en moverse y en parte porque se han dado cuenta del valor de sus conjuntos de datos patentados y no necesariamente quieren entregar los datos a otra empresa. No importa cuán poderoso sea su modelo. La mayoría de los casos de uso empresarial requieren un alto grado de precisión, y las empresas tienen tres opciones para elegir LLM: crear su propio LLM, utilizar un proveedor de servicios de LLM para crearlo o ajustar el modelo subyacente: crear su propio LLM no es fácil.

Ali Ghosdi, Databricks:

Una cosa que sucede en el cerebro de los directores ejecutivos y de las juntas directivas es que se dan cuenta: tal vez pueda vencer a mi competencia. Quizás sea la kriptonita la que mata a tus enemigos. Tengo los datos para la IA generativa, por lo que piensan: "Tengo que construirlos yo mismo". Tengo que poseer la propiedad intelectual. ¿Quieres crear tu propio LLM desde cero? No es trivial, aún requiere muchas GPU, cuesta mucho dinero y depende de su conjunto de datos y caso de uso.

Tenemos muchos clientes que desean un modelo más económico, más pequeño y diseñado específicamente con muy alta precisión y rendimiento. Dicen: "Oye, esto es lo que quiero hacer. Quiero obtener una buena clasificación a partir de estas imágenes de este defecto particular en el proceso de fabricación". La precisión es importante allí. Cada gramo de precisión que puedas darme cuenta. Allí, estará mejor si tiene un buen conjunto de datos para entrenar y puede entrenar un modelo más pequeño. La latencia será más rápida, más económica y sí, absolutamente podrás tener una precisión que supera a los modelos realmente grandes. Pero el modelo que construyas no te entretendrá los fines de semana ni ayudará a tus hijos con sus tareas. ## 11 ¿La Ley de Escala nos llevará hasta AGI?

Actualmente, LLM sigue la ley de escala: el rendimiento del modelo mejora a medida que se agregan más datos y cálculos, incluso si la arquitectura y los algoritmos siguen siendo los mismos. ¿Pero cuánto tiempo puede durar esta regla? ¿Continuará indefinidamente o alcanzará sus límites naturales antes de que desarrollemos la AGI?

Mira Murati, OpenAI:

No hay evidencia de que no obtengamos modelos mejores y más potentes a medida que sigamos ampliando el acceso a los datos y la computación. Si esto lo lleva hasta AGI, esa es una pregunta diferente. Es posible que se necesiten otros avances y avances en el camino, pero creo que todavía queda un largo camino por recorrer en términos de las leyes de escalamiento y realmente obtener muchos beneficios de estos modelos más grandes. Darío Amodei, Antrópico:

Incluso si no hay mejoras algorítmicas aquí y simplemente escalamos hasta donde hemos estado hasta ahora, la ley de escala continuará. Noam Shazeer, Personaje.AI:

Nuestro objetivo es ser una empresa AGI y una empresa que prioriza el producto, y la manera de lograrlo es eligiendo los productos correctos, obligándonos a hacer cosas que sean generalizables, haciendo que los modelos sean más inteligentes, convirtiéndolos en algo que la gente quiera y entregar. servicios de forma económica y a escala. La Ley de Escala nos llevará muy lejos. Básicamente, el cálculo no es tan caro. Hoy en día, los costos operativos rondan entre los 10 y los 18 dólares. Si puede hacer estas cosas de manera eficiente, el costo debería ser mucho menor que el valor de su tiempo. Existe la capacidad de ampliar estas cosas en órdenes de magnitud. ## 12 ¿Cuáles son las capacidades emergentes?

Si bien algunas personas se apresuran a descartar la capacidad de generar inteligencia artificial, la inteligencia artificial ya es mucho mejor que los humanos en la realización de ciertas tareas y seguirá mejorando. Los mejores constructores han podido identificar las capacidades emergentes más prometedoras de la IA y crear modelos y empresas que escalan estas capacidades hasta convertirlas en capacidades confiables. Reconocen que la escala tiende a aumentar la confiabilidad de las capacidades emergentes.

Mira Murati, OpenAI:

Es importante prestar atención a estas características emergentes, incluso si son muy poco confiables. Especialmente para las personas que están creando empresas hoy en día, realmente quieren pensar: "Bien, ¿qué es posible hoy? ¿Qué ven hoy?" Porque muy rápidamente estos modelos se volverán confiables. Darío Amodei, Antrópico:

Cuando lanzamos GPT-2, lo que se consideró más impresionante en ese momento fue: "Introduces estos cinco ejemplos de traducción del inglés al francés directamente en el modelo de idioma y luego introduces la sexta oración en inglés, y en realidad se traduciría al francés". . Fue como, "Dios mío, entiende este patrón". Eso fue una locura para nosotros, a pesar de que era una mala traducción. Pero nuestra opinión es: "Mira, esto es sólo el comienzo de un viaje asombroso porque no hay límites y puede seguir ampliándose." ¿Por qué no pueden seguir existiendo esos modelos que hemos visto antes? Hay tantos objetivos para predecir la siguiente palabra y hay tantas cosas con las que puedes desafiarlos que definitivamente funciona. Y luego algunas personas lo miraron y dijeron: "Hiciste una herramienta de traducción robótica realmente mala." ## 13 ¿Bajará el costo de servir estos modelos?

Los costos computacionales son una de las principales limitaciones para escalar estos modelos, y la actual escasez de chips está elevando los costos al limitar la oferta. Sin embargo, si Nvidia produce más H100 el próximo año, eso debería aliviar la escasez de GPU y potencialmente reducir los costos informáticos.

Noam Shazeer, Personaje.AI:

El modelo que ofrecemos ahora requirió alrededor de $2 millones en ciclos de cómputo para entrenarse el año pasado, y probablemente lo haremos nuevamente por medio millón de dólares. Así que vamos a implementar docenas de puntos de coeficiente intelectual de cosas más inteligentes antes de fin de año. Veo que estas cosas están aumentando enormemente. Simplemente no es tan caro. Creo que ayer vi un artículo que decía que Nvidia iba a fabricar otro 1,5 millones de H100 el próximo año, que sería el 2 millones de H100.

Eso es aproximadamente un cuarto de billón de operaciones por segundo por persona. Esto significa que por cada persona en el planeta, en un modelo con 100 mil millones de parámetros, podría procesar 1 palabra por segundo. Pero no todo el mundo tiene acceso a él, por lo que no es tan caro. Esto es muy escalable si se hace bien y estamos trabajando duro para que eso suceda. Darío Amodei, Antrópico:

Mi punto básico es que la inferencia no será tan costosa. La lógica básica de la ley de escala es que si aumenta el cálculo en un factor de n, debe aumentar los datos en un factor de la raíz cuadrada de n y el tamaño del modelo en un factor de la raíz cuadrada de n. Esta raíz cuadrada básicamente significa que el modelo en sí no crecerá más y el hardware se hará más rápido a medida que lo hagas. Creo que estas cosas seguirán siendo relevantes durante los próximos 3 o 4 años. Sin innovación arquitectónica, se vuelven un poco más caras. Si hay innovación arquitectónica, y espero que la haya, serán más baratos. Pero incluso si los costos computacionales permanecen constantes, las mejoras en la eficiencia a nivel de modelo parecen inevitables, especialmente con tanto talento llegando al campo, y la IA en sí misma puede ser nuestra herramienta más poderosa para mejorar la forma en que funciona.

Darío Amodei, Antrópico:

A medida que la IA se vuelve más poderosa, se desempeña mejor en la mayoría de las tareas cognitivas. Una tarea cognitiva relacionada es juzgar la seguridad de los sistemas de inteligencia artificial y, en última instancia, realizar investigaciones sobre seguridad. Hay un componente autorreferencial en esto. Podemos ver esto leyendo el interior de las redes neuronales, como el ámbito de la interpretabilidad. Los sistemas de IA potentes pueden ayudarnos a interpretar la actividad neuronal en sistemas de IA más débiles. Y estas ideas de interpretabilidad a menudo nos dicen cómo funciona el modelo. Cuando nos dicen cómo funciona un modelo, a menudo sugieren formas de mejorarlo o hacerlo más eficiente. Una de las áreas de investigación más prometedoras es el ajuste de modelos grandes para casos de uso específicos sin ejecutar el modelo completo.

Ali Ghodsi, ladrillos de datos:

Si crearas mil versiones de LLM que fueran buenas en mil cosas diferentes y tuvieras que cargar cada una de ellas en la GPU y servirlas, eso resultaría muy costoso. Lo más importante que todo el mundo está buscando en este momento es: ¿Existe alguna técnica que pueda obtener muy buenos resultados con sólo modificaciones menores? Existen muchas tecnologías como ajuste de prefijos, LoRA, CUBE LoRA, etc. Pero no se ha demostrado que funcione ninguna solución verdaderamente perfecta. Pero alguien lo encontrará. ## 14 ¿Cómo medimos el progreso hacia la inteligencia artificial general?

Cuando ampliamos estos modelos, ¿cómo sabemos cuándo una IA se convierte en inteligencia artificial general? Cuando escuchamos a menudo el término AGI, puede resultar difícil definirlo, quizás en parte porque es difícil de medir.

Los puntos de referencia cuantitativos como GLUE y SUPERGLUE se han utilizado durante mucho tiempo como métricas estandarizadas para medir el rendimiento del modelo de IA. Pero al igual que las pruebas estandarizadas que aplicamos a los humanos, los puntos de referencia de la IA plantean la pregunta: ¿Hasta qué punto se mide la capacidad de razonamiento de un LLM y en qué medida se mide su capacidad para aprobar una prueba?

Ali Ghodsi, Databricks:

Siento que todos los puntos de referencia son una mierda. Imagínese si todas nuestras universidades dijeran: "Le daremos las respuestas para que las vea la noche anterior al examen. Y luego, al día siguiente, le pediremos que responda las preguntas y las califique". , todos podrían aprobar el examen fácilmente.

Por ejemplo, MMLU es el punto de referencia que mucha gente utiliza para evaluar estos modelos. MMLU es solo una pregunta de opción múltiple en Internet. Haga una pregunta, ¿la respuesta es A, B, C, D o E? Luego te dirá la respuesta correcta. Se puede entrenar online y crear un modelo LLM capaz de superarlo. La prueba cualitativa original para AGI fue la prueba de Turing, pero convencer a los humanos de que una IA es humana no es un problema difícil. Lograr que la inteligencia artificial haga lo que hacen los humanos en el mundo real es un problema difícil. Entonces, ¿qué pruebas podemos utilizar para comprender la funcionalidad de estos sistemas?

Dylan Field, Figma:

Lo que estamos viendo ahora en estos sistemas es que es fácil hacer que la gente crea que eres humano, pero es difícil hacer cosas buenas. Puedo hacer que GPT-4 desarrolle un plan de negocios y te lo venda, pero eso no significa que vayas a invertir. Cuando en realidad tienes dos negocios en competencia, uno dirigido por IA y otro por humanos, y eliges invertir en el negocio de la IA, eso me preocupa. David Baszucki, Roblox:

Tengo una pregunta de prueba de Turing para una IA: si pusiéramos una IA en el año 1633 y la dejáramos entrenar con toda la información disponible en ese momento, ¿predeciría si la Tierra o el Sol era el centro del sistema solar, incluso aunque el 99,9% de la información dice que la Tierra es el centro del sistema solar. Creo que 5 años está justo en el límite, pero si hiciéramos esta prueba de IA de Turing en 10 años, probablemente diría que el sol. ## 15 ¿Aún es necesario que los humanos participen?

Las nuevas tecnologías a menudo reemplazan algunos empleos y empleos humanos, pero también abren áreas completamente nuevas, aumentan la productividad y ponen más tipos de empleos a disposición de más personas. Si bien es fácil imaginar que la IA automatice los trabajos existentes, es mucho más difícil imaginar los próximos problemas y posibilidades que traerá la IA.

Martín Casado, a16z:

En pocas palabras, la paradoja de Jevons afirma: si la demanda es elástica y el precio cae, la demanda excederá la compensación. A menudo, queda mucho más que compensado. Esto definitivamente se aplica a Internet. Obtendrá más valor y más productividad. Personalmente creo que la demanda es elástica cuando se trata de automatizar cualquier activo o trabajo creativo. Cuanto más producimos, más gente consume. Esperamos con ansias una expansión masiva de la productividad, una plétora de nuevos empleos y muchas cosas nuevas, tal como vimos en la era de los microchips e Internet. Kevin Scott, Microsoft:

Crecí en la zona rural de Virginia central, donde la economía estaba impulsada principalmente por el cultivo de tabaco, la fabricación de muebles y la industria textil. Cuando me gradué de la escuela secundaria, las tres industrias acababan de colapsar. Cuando las personas de estas comunidades tienen acceso a herramientas increíblemente poderosas, a menudo hacen cosas extraordinarias, creando oportunidades económicas para ellos, sus familias y sus comunidades. Resuelven problemas que usted o yo no podemos porque no vemos todo el panorama de problemas del mundo. No tenemos su perspectiva. Estas herramientas de IA son ahora más fáciles de usar que nunca. Puede hacer cosas interesantes con estas herramientas ahora y convertirse en emprendedor en una pequeña ciudad de Virginia sin tener un doctorado en informática ni experiencia en inteligencia artificial clásica. Sólo tienes que mantener la curiosidad y el espíritu emprendedor. Dylan Field, Figma:

Si observa cada cambio de tecnología o de plataforma hasta la fecha, ha resultado en más cosas que diseñar. Hay una imprenta y luego tienes que decidir qué poner en la página. Recientemente, con la Internet móvil, uno podría pensar: "Bueno, hay menos píxeles, hay menos diseñadores", pero ese no es el caso, fue entonces cuando vimos la mayor explosión en el número de diseñadores. ## 16 Nunca ha habido un momento más emocionante para crear una startup de IA (especialmente si eres físico o matemático)

Este es un momento único y emocionante para construir inteligencia artificial: los modelos subyacentes están escalando rápidamente, la economía finalmente se está inclinando a favor de las nuevas empresas y hay muchos problemas que resolver. Estos problemas requieren gran paciencia y perseverancia para resolverlos, y hasta ahora los físicos y matemáticos han sido particularmente capacitados para resolverlos. Pero como campo joven y de rápido crecimiento, la IA está muy abierta y ahora es el momento perfecto para desarrollarla.

Darío Amodei, Antrópico:

En un momento dado, existen dos tipos de reinos. Se trata de un campo donde la experiencia y el conocimiento acumulado son muy ricos, y se necesitan muchos años para convertirse en un experto. La biología es un ejemplo clásico: si solo trabajas en biología durante 6 meses, es muy difícil hacer un trabajo innovador o de nivel de Premio Nobel... El otro es un campo que es muy joven o que se desarrolla muy rápidamente. La inteligencia artificial era, y hasta cierto punto sigue siendo, una de estas categorías. Los generalistas realmente talentosos a menudo pueden superar a las personas que han estado en el campo durante mucho tiempo porque las cosas cambian muy rápidamente. En todo caso, tener muchos conocimientos previos puede ser una desventaja. Mira Murati, OpenAI:

Una conclusión del espacio teórico de las matemáticas es que es necesario dedicar mucho tiempo a pensar en los problemas. A veces te quedas dormido y te despiertas con nuevas ideas, y poco a poco vas encontrando la solución final a lo largo de días o semanas. No es un proceso con retornos rápidos y, a veces, no es algo iterativo. Es casi una forma diferente de pensar, donde construyes la intuición y la disciplina para enfrentar un problema y confiar en ti mismo para resolverlo. Con el tiempo, desarrollará una intuición sobre en qué problemas realmente vale la pena trabajar. Daphne Koller, introducción:

No sólo el aprendizaje automático mejora con el tiempo, sino también las herramientas biológicas en las que confiamos. En el pasado, no existía la tecnología CRISPR, sólo ARNip. Luego vino la tecnología de edición de genes CRISPR, y ahora existe la tecnología principal CRISPR que puede reemplazar regiones genómicas enteras. Como resultado, las herramientas que estamos construyendo son cada vez mejores, lo que nos abre la posibilidad de abordar más enfermedades de maneras más significativas. Existen muchas oportunidades en la intersección de la inteligencia artificial/aprendizaje automático con los campos de la biología y la medicina. Esta convergencia es un momento que nos permite generar un gran impacto en el mundo en el que vivimos, utilizando herramientas que existen hoy pero que no existían hace cinco años. Kevin Scott, Microsoft:

Si piensa en algunos de los grandes cambios de plataforma que ocurrieron en el pasado, las cosas más valiosas en esas plataformas no fueron las que se implementaron en los primeros dos años del cambio de plataforma. Si piensas en dónde pasas más tiempo en tu teléfono inteligente, no es una aplicación de mensajería, ni un navegador web, ni un cliente de correo electrónico. Más bien, es algo nuevo que se crea a los pocos años de que la plataforma esté disponible.

¿Qué cosas que antes eran imposibles ahora son posibles? Esto es en lo que la gente debería pensar. No persigas cosas triviales.

Ver originales

Esta página puede contener contenido de terceros, que se proporciona únicamente con fines informativos (sin garantías ni declaraciones) y no debe considerarse como un respaldo por parte de Gate a las opiniones expresadas ni como asesoramiento financiero o profesional. Consulte el Descargo de responsabilidad para obtener más detalles.

a16z Artículo de 10.000 palabras: Estamos entrando en la tercera era de la informática

Esta ola de desarrollo de la IA ha extendido su influencia a diversos campos con tanta rapidez que, de hecho, ha superado las expectativas de la mayoría de las personas. La semana pasada, Sequoia (Sequoia America) creía que la IA había abierto su segundo capítulo y dibujó un nuevo mapa de IA y un mapa de pila (pila) de desarrollador de LLM desde la perspectiva de los escenarios de aplicación.

Sin embargo, a juzgar por la dirección de los fondos, el desarrollo actual de la IA parece estar todavía en la etapa de lucha entre dioses, y este patrón parece casi haber tomado forma. Después de que OpenAI recibió casi 11 mil millones de dólares estadounidenses de Microsoft y otros y fue valorado en casi 29 mil millones de dólares estadounidenses, su competidor Anthropic anunció ayer una alianza con Amazon, en la que Amazon invertirá hasta 4 mil millones de dólares estadounidenses, lo que convierte a Anthropic en el segundo lugar después de OpenAI. en términos de financiación de startups de IA.

Después de esta financiación, con la excepción de Apple, la industria de la IA básicamente ha formado un patrón de lucha de dioses:

Por supuesto, como proveedor de infraestructura de nivel inferior, la estrategia de Nvidia es obviamente que todos la quieren y no existe una postura muy seria sobre ninguna empresa específica. La siguiente es una situación general de los 15 unicornios de IA: desde la perspectiva de valoración y financiación, los LLM de modelos grandes representan una gran parte y el 50% de los unicornios de IA se establecieron después de 2021:

Hoy, a16z compartió sus conversaciones con los fundadores de varias de las principales empresas de IA, creyendo que estamos en la tercera era de la informática, y discutió 16 temas interesantes desde la perspectiva del presente, el futuro y la apertura de la IA. Los participantes en esta conversación incluyen:

Dado que el artículo es demasiado largo, casi 10,000 palabras, utilicé AI para compilarlo brevemente. Es posible que algunos términos no sean exactos. Los amigos interesados pueden leer el texto original en inglés:

1 Estamos en el inicio de la tercera era de la informática

Martín Casado,a16z:

Realmente creo que podemos estar entrando en la tercera era de la informática. Los microchips han reducido el coste marginal de computación a cero, Internet ha reducido el coste marginal de distribución a cero y ahora los grandes modelos han reducido de hecho el coste marginal de creación a cero. Cuando sucedieron épocas anteriores, no tenías idea de qué nuevas empresas se crearían. Nadie predijo a Amazon, nadie predijo a Yahoo. Deberíamos prepararnos para una nueva ola de empresas icónicas. Noam Shazeer, personaje IA:

Estamos verdaderamente en el momento del "primer avión de los hermanos Wright". Ya tenemos algo que funciona y ahora es útil para una gran cantidad de escenarios de aplicaciones. Parece que escala muy bien y mejorará aún más. Pero hay más avances por venir, porque ahora todos los científicos de IA del mundo están trabajando arduamente para mejorar estas cosas. Kevin Scott, Microsoft:

Especialmente en los últimos años, y tal vez especialmente en los últimos 12 meses, con el lanzamiento de ChatGPT y GPT-4, realmente se puede ver el potencial de esta plataforma para ser lo mismo que una PC o un teléfono inteligente. Una variedad de tecnologías harán posible una gran cantidad de cosas nuevas, y muchas personas construirán cosas sobre estas cosas nuevas. ## 2 Esta ola de inteligencia artificial generativa tiene principios económicos que promueven la transformación del mercado.

Para que la innovación tecnológica desencadene la transformación del mercado, los beneficios económicos deben ser muy atractivos. Si bien ha habido muchos avances tecnológicos en ciclos anteriores de IA, carecieron de beneficios económicos transformadores. En la ola actual de IA, ya estamos viendo signos tempranos de mejoras económicas de 10.000 veces (o más) en algunos casos de uso, y la adopción y el desarrollo resultantes de la IA parecen ser mucho más rápidos que cualquier cambio anterior.

Martín Casado,a16z:

La transformación del mercado no se produce mediante una mejora económica diez veces mayor. Se crean cuando son diez mil veces mejores que antes. Digamos que quiero crear una imagen que me transforme en un personaje de Pixar. Si uso uno de estos modelos de imagen, el costo de inferencia es una décima de centavo y digamos que toma 1 segundo. Si lo comparamos con la contratación de un artista gráfico, supongamos que la tarifa por hora es de $100. En términos de costo y tiempo, verá una gran diferencia de 4 a 5 órdenes de magnitud. Para los economistas, este es el tipo de punto de inflexión que buscan, cuando en realidad hay una enorme dislocación del mercado. Si quieres un ejemplo de lo loco que puede llegar a ser esto, no veo ninguna razón por la que no puedas generar un juego completo: modelos 3D, personajes, sonidos, música, historia, etc. Las empresas emergentes de hoy están haciendo todas estas cosas, y si comparamos el costo de cientos de millones de dólares y años con el costo de unos pocos dólares, ahora tenemos una asimetría en la economía a nivel de Internet y de los microchips.

3 Para algunos escenarios de aplicación iniciales: Creatividad > Corrección

Las alucinaciones son un problema bien conocido en los LLM de modelos grandes actuales, pero para algunas aplicaciones la capacidad de inventar cosas es una característica más que un error. En comparación con los primeros casos de uso de aprendizaje automático aplicado, donde la corrección de nivel n es fundamental (por ejemplo, automóviles autónomos), muchos de los primeros casos de uso de LLM (amigos y compañeros virtuales, lluvia de ideas sobre conceptos o creación de juegos en línea) se caracterizan por: focus En áreas donde la creatividad es más importante que la corrección.

Noam Shazeer, Personaje.AI:

El entretenimiento es una industria de 2 billones de dólares al año. Y el oscuro secreto es que el entretenimiento es como tus amigos virtuales inexistentes. Este es un primer caso de uso interesante para la inteligencia artificial general. Si quisieras presentar a un médico, por ejemplo, sería mucho más lento porque debes tener mucho, mucho, mucho cuidado de no dar información incorrecta. Pero con amigos puedes hacerlo muy rápido, es simplemente divertido e inventar cosas se convierte en una característica. David Baszucki, Roblox:

De los 65 millones de usuarios de Roblox, la mayoría no crea al nivel que les gustaría. Durante mucho tiempo, imaginamos un juego de simulación de Project Runway en el que se podía usar una máquina de coser y tela y simularlo todo en 3D, pero incluso eso era un poco complicado para la mayoría de nosotros. Creo que ahora, cuando Project Runway salga en Roblox, será un mensaje de texto, un mensaje de imagen o un mensaje de voz. Si te estuviera ayudando a hacer esa camisa, diría: quiero una camisa de mezclilla azul, algunos botones y un corte más ajustado. De hecho, creo que vamos a ver una aceleración en la creación. Dylan Field, Figma:

En este momento, estamos en una etapa en la que es posible que la IA complete un primer borrador, pero pasar de ahí a un producto final todavía es algo difícil y, a menudo, requiere un equipo para hacerlo. Pero si se puede lograr que la IA sugiera elementos de interfaz a las personas y lo haga de una manera que realmente tenga sentido, creo que se abrirá una era completamente nueva de diseño, creando diseños contextuales que respondan a la intención del usuario. Creo que esta será una era fascinante para que todos los diseñadores trabajen en colaboración con estos sistemas de inteligencia artificial. ## 4 Para otros ejemplos, la precisión de la programación del "copiloto" mejorará con el uso humano.

Si bien la IA tiene el potencial de aumentar el trabajo humano en muchas áreas, la programación de “copilotos” se ha convertido en el primer asistente de IA ampliamente adoptado por varias razones:

En primer lugar, los desarrolladores suelen ser los primeros en adoptar nuevas tecnologías: un análisis de los consejos de ChatGPT realizado en mayo/junio de 2023 encontró que el 30% de los consejos de ChatGPT estaban relacionados con la programación. En segundo lugar, los LLM más grandes están capacitados en conjuntos de datos con mucho código (como Internet), lo que los hace particularmente buenos para responder consultas relacionadas con la programación. Finalmente, las personas en el circuito son los usuarios. Entonces, si bien la precisión es importante, un desarrollador humano con un copiloto de IA puede iterar hacia la corrección más rápido que un desarrollador humano solo.

Martín Casado,a16z:

Si tiene que hacerlo bien y hay muchos casos de uso complejos, haga todo el trabajo técnico usted mismo o contrate gente. Normalmente contratamos gente. Este es un costo variable. En segundo lugar, debido a que la cola de soluciones suele ser muy larga (como las muchas anomalías que pueden ocurrir en la conducción autónoma), la inversión necesaria para mantenerse a la vanguardia aumenta y el valor disminuye. Esto crea un efecto inverso de economía de escala. Ese ser humano en el circuito que solía estar en una empresa central ahora es el usuario, por lo que ya no es un costo variable para el negocio y la economía del costo del trabajo. La persona en el bucle se ha eliminado, por lo que puedes hacer cosas donde la corrección es importante, como desarrollar código, y debido a que es iterativo, la cantidad de errores acumulados se reduce porque constantemente recibes comentarios y correcciones de los usuarios. Cuando los desarrolladores pueden consultar un chatbot de IA para ayudarlos a escribir y solucionar problemas de código, cambia la forma en que se realiza el desarrollo de dos maneras significativas: 1) Facilita el desarrollo para más personas. Colaboración porque ocurre a través de una interfaz de lenguaje natural, 2) Desarrolladores humanos. producir más productos y mantenerlos fluyendo por más tiempo.

Mira Murati, OpenAI:

La programación se vuelve cada vez menos abstracta. De hecho, podemos hablar con computadoras de gran ancho de banda en lenguaje natural. Estamos utilizando la tecnología y la tecnología nos está ayudando a comprender cómo trabajar con ella en lugar de "programarla". Kevin Scott, Microsoft:

GitHub es el primer ejemplo de este modelo copiloto que estamos tratando de construir, que es: ¿Cómo se toma el trabajo de conocimiento que alguien está haciendo y se usa la IA para ayudarlo a ser significativamente más productivo al realizar tipos específicos de trabajo cognitivo? ? Lo mejor de todo es que, según lo que hemos observado con los desarrolladores, la IA les ayuda a permanecer en un estado de flujo por más tiempo del que lo harían de otra manera. No se quede atascado cuando esté escribiendo un fragmento de código y pensando: "No sé cómo hacer lo siguiente. Tengo que buscar la documentación. Tengo que preguntarle a otro ingeniero que podría estar trabajando en algo." "Ser capaz de liberarte del flujo antes de salir del estado de flujo es extremadamente valioso. Para aquellos que están considerando la utilidad de las herramientas de IA generativa creadas para fines distintos al desarrollo de software, es útil considerar este concepto de estados de flujo. Dylan Field, Figma:

Los mejores diseñadores empiezan a pensar más en el código y los mejores desarrolladores empiezan a pensar más en el diseño. Más allá de los diseñadores y desarrolladores, por ejemplo, si piensas en la gente de productos, es posible que hayan estado trabajando en especificaciones antes, pero ahora están trabajando más en maquetas para comunicar sus ideas de manera más efectiva. Básicamente, esto permitirá que cualquier miembro de la organización pase de la idea al diseño, y posiblemente incluso a la producción, más rápido. Pero aún necesitas perfeccionar cada paso. Necesitas a alguien en quien realmente pensar: "Está bien, ¿qué ideas vamos a explorar? ¿Cómo las vamos a explorar?" Vas a querer modificar los diseños, vas a querer manejarlos correctamente, desde el primer borrador hasta el producto final. ## 5 La combinación de IA y biología podría acelerar nuevas formas de tratar enfermedades y tener un profundo impacto en la salud humana

La biología es increíblemente compleja, tal vez incluso más allá de la capacidad de la mente humana para comprenderla plenamente. Sin embargo, la intersección de la IA y la biología podría acelerar nuestra comprensión de la biología y conducir a algunos de los avances tecnológicos más interesantes y transformadores de nuestro tiempo. Las plataformas de biología impulsadas por IA tienen el potencial de desbloquear conocimientos biológicos previamente desconocidos, lo que conduciría a nuevos avances médicos, nuevos métodos de diagnóstico y la capacidad de detectar y tratar enfermedades antes, e incluso prevenirlas antes de que ocurran.

Daphne Koller, introducción:

En determinados momentos de nuestra historia, determinadas disciplinas científicas han logrado avances increíbles en un período de tiempo relativamente corto. En la década de 1950, la disciplina era la informática y usábamos estas máquinas para realizar cálculos que, hasta entonces, sólo los humanos podían realizar. Luego, en la década de 1990, se produjo esta interesante divergencia. Por un lado, la ciencia de datos y las estadísticas finalmente nos trajeron el aprendizaje automático y la inteligencia artificial modernos. El otro lado es lo que considero biología cuantitativa, que es la primera vez que comenzamos a medir la biología a una escala más allá del seguimiento de 3 genes en un experimento que tomó 5 años. Ahora, 2020 es la última vez que las dos disciplinas realmente convergieron, lo que nos trajo la era de la biología digital, la capacidad de medir la biología con una fidelidad y escala sin precedentes; interpretar lo incomprensible utilizando herramientas de aprendizaje automático y ciencia de datos. Cantidades masivas de datos, diferentes escalas biológicas y diferentes sistemas, y luego usar herramientas como la edición del genoma CRISPR para devolver esa comprensión a la ingeniería biológica, de modo que podamos hacer que la biología haga cosas que no debe hacer. Ahora finalmente podemos medir la biología a escala, a nivel celular (y a veces subcelular) y orgánico. Esto nos permite, por primera vez, implementar el aprendizaje automático de una manera verdaderamente significativa. Construimos un modelo de lenguaje biológico. Es como GPT, pero para células. Tenemos el lenguaje de las células y cómo se ven las células. Se miden cientos de millones de células en diferentes estados y luego, como un gran modelo de lenguaje natural, con una pequeña cantidad de datos, se puede empezar a preguntar: "Está bien, ¿cómo mueve una enfermedad un gen que causa la enfermedad de un lugar a otro?". ¿De un lugar a otro?" "¿Cómo logra el tratamiento que, con suerte, uno pase de un estado de enfermedad a un estado de salud?" Esto es súper poderoso. Al igual que con otros modelos de lenguaje, cuantos más datos le proporcione, mejor será. ## 6 Poner el modelo en manos de los usuarios nos ayudará a descubrir nuevos escenarios de aplicación

Mientras que las iteraciones anteriores de modelos de IA tenían como objetivo superar a los humanos en determinadas tareas, los LLM basados en Transformer destacan en el razonamiento general. Pero sólo porque hayamos creado un buen modelo general no significa que hayamos descubierto cómo aplicarlo a un caso de uso específico. Así como incorporar a los humanos en forma de RLHF es fundamental para mejorar el rendimiento de los modelos de IA actuales, poner nueva tecnología en manos de los usuarios y comprender cómo la usan será clave para determinar qué aplicaciones crear en función de estas tecnologías subyacentes. modelos arriba.

Kevin Scott, Microsoft:

Debemos recordar: el modelo no es el producto. Como emprendedor, tu comprensión es: ¿Quiénes son tus usuarios? ¿Cuál es su problema? ¿Qué puedes hacer para ayudarlos? Luego, determinar si la IA es realmente una infraestructura útil para resolver los problemas de los usuarios es una constante. La inteligencia artificial es como una infraestructura nueva e interesante que permite resolver nuevas clases de problemas o resolver viejas clases de problemas de mejores maneras. Mira Murati, OpenAI:

No sabemos exactamente cómo será el futuro, por lo que estamos tratando de poner estas herramientas y técnicas a disposición de muchas otras personas para que puedan experimentar y ver qué sucede. Esta es una estrategia que hemos estado usando desde el principio. La semana antes de lanzar ChatGPT, nos preocupaba que no fuera lo suficientemente bueno. Todos hemos visto lo que sucede: lo publicamos y luego la gente nos dice que es lo suficientemente bueno como para descubrir nuevos casos de uso, y vemos todos estos casos de uso emergentes. ## 7 Los recuerdos de tus amigos AI mejorarán

Mientras que los datos, los cálculos y los parámetros del modelo potencian el razonamiento general de los LLM, las ventanas contextuales potencian su memoria a corto plazo. Las ventanas de contexto generalmente se miden por la cantidad de tokens que pueden manejar. Hoy en día, la mayoría de las ventanas de contexto tienen aproximadamente 32 KB, pero están llegando ventanas de contexto más grandes, y con ellas viene la capacidad de ejecutar documentos más grandes con más contexto a través de LLM.

Noam Shazeer, Personaje.AI:

Actualmente, los modelos que ofrecemos utilizan ventanas contextuales de miles de tokens, lo que significa que tus amigos de toda la vida recordarán lo que pasó en la última media hora. Si puede deshacerse de mucha información, las cosas mejorarán. Debería poder aprender mil millones de cosas sobre ti. El ancho de banda de HBM está ahí. Darío Amodei, Antrópico:

Una cosa que creo que todavía se subestima es el contexto más amplio y las cosas que conlleva. Creo que la gente tiene esta imagen en mente de tener este chatbot. "Le hice una pregunta y respondió la pregunta. Pero usted podría cargar un contrato legal y decir: '¿Cuáles son los cinco términos más inusuales en este contrato legal?' O cargue un estado financiero y diga: "Resumen de dónde se encuentra esta empresa. ¿Qué es sorprendente en comparación con lo que dijo este analista hace dos semanas? Todo este conocimiento manipula y procesa enormes cantidades de datos que la gente necesita contar". "Creo que es más probable que lo que la gente está haciendo. Recién estamos comenzando". ## 8 Los chatbots de voz, los bots y otras formas de interactuar con la inteligencia artificial son un área importante de investigación.

Hoy en día, la mayoría de las personas interactúan con la inteligencia artificial en forma de chatbots, pero eso se debe a que los chatbots suelen ser fáciles de construir, no porque sean la mejor interfaz para cada caso de uso.

Muchos constructores se centran en desarrollar nuevas formas para que los usuarios interactúen con modelos de IA a través de IA multimodal. Los usuarios podrán interactuar con modelos multimodales de la misma manera que interactúan con el resto del mundo: a través de imágenes, texto, voz y otros medios. Yendo un paso más allá: la IA incorporada se centra en la inteligencia artificial que puede interactuar con el mundo físico, como los coches autónomos.

Mira Murati, OpenAI:

Creo que el modelo base actual representa bien el mundo en el texto. Estamos agregando otras modalidades, como imágenes y videos, para que estos modelos puedan obtener una imagen más completa del mundo, similar a cómo entendemos y observamos el mundo. Noam Shazeer, Personaje.AI:

Tal vez quieras escuchar una voz, ver una cara o simplemente poder interactuar con varias personas. Es como si fueras elegido presidente, tuvieras auriculares y todo un equipo de amigos o asesores. O como si entras a un "bar divertido" y todos saben tu nombre y se alegran de que hayas venido. Daphne Koller, introducción:

La próxima posible frontera de impacto de la IA es cuando la IA comience a interactuar con el mundo físico. Todos vemos lo difícil que es. Todos hemos visto lo difícil que es construir un automóvil autónomo en comparación con construir un chatbot, ¿verdad? Estamos logrando grandes avances en la creación de chatbots y los autos sin conductor todavía bloquean los camiones de bomberos en San Francisco. Es importante comprender esta complejidad, pero también la escala del impacto. ## 9 ¿Tendremos algunos modelos generales, un conjunto de modelos especializados o una combinación de ambos?

¿Qué casos de uso son más adecuados para modelos base más grandes de “inteligencia superior” o modelos y conjuntos de datos especializados más pequeños? Al igual que el debate sobre arquitectura de nube versus arquitectura de borde de hace una década, la respuesta depende de cuánto esté dispuesto a pagar, qué tan preciso necesita que sea el resultado y cuánta latencia puede tolerar. Las respuestas a estas preguntas pueden cambiar con el tiempo a medida que los investigadores desarrollen métodos computacionalmente más eficientes para ajustar modelos base grandes para casos de uso específicos.

A largo plazo, es posible que rotemos demasiado los modelos que se utilizan para cada caso de uso porque todavía estamos en las primeras etapas de construcción de la infraestructura y la arquitectura para respaldar la próxima ola de aplicaciones de IA.

Ali Ghodsi, ladrillos de datos:

Es un poco como en el año 2000, Internet está a punto de dominarlo todo y lo único que importa es quién puede construir el mejor enrutador. La capitalización de mercado de Cisco alcanzó un máximo de 5 billones de dólares en 2000, superando a Microsoft en ese momento. Entonces, ¿quién tiene el LLM (modelo de lenguaje) más grande? Claramente, quien pueda construir el más grande y entrenarlo completamente tendrá control sobre toda la IA y los humanos del futuro. Pero al igual que Internet, a alguien más se le ocurrirán ideas como Uber y conducir taxis más adelante. Habrá otras personas que pensarán: "Oye, quiero ver qué están haciendo mis amigos en Facebook". Estas pueden ser enormes oportunidades de negocio, y no son sólo empresas como OpenAI, Databricks o Anthropic las que pueden construir un modelo. escenarios. Se necesita mucho esfuerzo para crear un médico en quien confíe. Darío Amodei, Antrópico:

El factor más importante es invertir más dinero. Los modelos más caros fabricados hoy en día cuestan alrededor de 100 millones de dólares, más o menos un orden de magnitud. El año que viene es posible que veamos modelos de múltiples actores por valor de alrededor de mil millones de dólares, y para 2025 veremos modelos por miles de millones o incluso 10 mil millones de dólares. Esta diferencia de 100x se combina con el hecho de que los cálculos del H100 se vuelven más rápidos, un salto especialmente grande debido a la precisión reducida. Si se juntan todos estos factores, si las leyes de escala continúan aplicándose, habrá un enorme aumento en las capacidades. Mira Murati, OpenAI:

Depende de lo que quieras hacer. Está claro que los sistemas de IA asumirán cada vez más los trabajos que realizamos. En términos de la plataforma OpenAI, puede ver que incluso hoy en día proporcionamos muchos modelos a través de la API, desde modelos muy pequeños hasta modelos de vanguardia. No siempre es necesario utilizar el modelo más potente o competente. A veces simplemente necesitan un modelo que se ajuste a su caso de uso específico y sea más rentable. Queremos que las personas se basen en nuestro modelo y les brinden las herramientas para facilitar este proceso. Queremos darles cada vez más acceso y control para que puedas traer tus propios datos y personalizar estos modelos. Realmente necesitas concentrarte en cosas que van más allá del alcance del modelo y definen el producto. David Baszucki, Roblox:

En cualquier empresa como Roblox, hay probablemente 20 o 30 aplicaciones verticales de usuario final que están muy personalizadas (el filtrado de lenguaje natural es muy diferente de generar 3D) y, en el caso del usuario final, queremos que se ejecuten todas esas aplicaciones. A medida que avanzamos [la pila], en una empresa como la nuestra, puede haber una agrupación natural de 2 o 3 modelos más grandes y gruesos. Hemos afinado muy finamente las disciplinas que queremos poder entrenar y hemos realizado muchas inferencias para esas disciplinas. ## 10 ¿Cuándo se adopta suficientemente la IA en la empresa? ¿Qué sucede con esos conjuntos de datos?

El impacto de la IA generativa en las empresas aún está en su infancia, en parte porque las empresas suelen tardar más en moverse y en parte porque se han dado cuenta del valor de sus conjuntos de datos patentados y no necesariamente quieren entregar los datos a otra empresa. No importa cuán poderoso sea su modelo. La mayoría de los casos de uso empresarial requieren un alto grado de precisión, y las empresas tienen tres opciones para elegir LLM: crear su propio LLM, utilizar un proveedor de servicios de LLM para crearlo o ajustar el modelo subyacente: crear su propio LLM no es fácil.

Ali Ghosdi, Databricks:

Una cosa que sucede en el cerebro de los directores ejecutivos y de las juntas directivas es que se dan cuenta: tal vez pueda vencer a mi competencia. Quizás sea la kriptonita la que mata a tus enemigos. Tengo los datos para la IA generativa, por lo que piensan: "Tengo que construirlos yo mismo". Tengo que poseer la propiedad intelectual. ¿Quieres crear tu propio LLM desde cero? No es trivial, aún requiere muchas GPU, cuesta mucho dinero y depende de su conjunto de datos y caso de uso. Tenemos muchos clientes que desean un modelo más económico, más pequeño y diseñado específicamente con muy alta precisión y rendimiento. Dicen: "Oye, esto es lo que quiero hacer. Quiero obtener una buena clasificación a partir de estas imágenes de este defecto particular en el proceso de fabricación". La precisión es importante allí. Cada gramo de precisión que puedas darme cuenta. Allí, estará mejor si tiene un buen conjunto de datos para entrenar y puede entrenar un modelo más pequeño. La latencia será más rápida, más económica y sí, absolutamente podrás tener una precisión que supera a los modelos realmente grandes. Pero el modelo que construyas no te entretendrá los fines de semana ni ayudará a tus hijos con sus tareas. ## 11 ¿La Ley de Escala nos llevará hasta AGI?

Actualmente, LLM sigue la ley de escala: el rendimiento del modelo mejora a medida que se agregan más datos y cálculos, incluso si la arquitectura y los algoritmos siguen siendo los mismos. ¿Pero cuánto tiempo puede durar esta regla? ¿Continuará indefinidamente o alcanzará sus límites naturales antes de que desarrollemos la AGI?

Mira Murati, OpenAI:

No hay evidencia de que no obtengamos modelos mejores y más potentes a medida que sigamos ampliando el acceso a los datos y la computación. Si esto lo lleva hasta AGI, esa es una pregunta diferente. Es posible que se necesiten otros avances y avances en el camino, pero creo que todavía queda un largo camino por recorrer en términos de las leyes de escalamiento y realmente obtener muchos beneficios de estos modelos más grandes. Darío Amodei, Antrópico:

Incluso si no hay mejoras algorítmicas aquí y simplemente escalamos hasta donde hemos estado hasta ahora, la ley de escala continuará. Noam Shazeer, Personaje.AI:

Nuestro objetivo es ser una empresa AGI y una empresa que prioriza el producto, y la manera de lograrlo es eligiendo los productos correctos, obligándonos a hacer cosas que sean generalizables, haciendo que los modelos sean más inteligentes, convirtiéndolos en algo que la gente quiera y entregar. servicios de forma económica y a escala. La Ley de Escala nos llevará muy lejos. Básicamente, el cálculo no es tan caro. Hoy en día, los costos operativos rondan entre los 10 y los 18 dólares. Si puede hacer estas cosas de manera eficiente, el costo debería ser mucho menor que el valor de su tiempo. Existe la capacidad de ampliar estas cosas en órdenes de magnitud. ## 12 ¿Cuáles son las capacidades emergentes?

Si bien algunas personas se apresuran a descartar la capacidad de generar inteligencia artificial, la inteligencia artificial ya es mucho mejor que los humanos en la realización de ciertas tareas y seguirá mejorando. Los mejores constructores han podido identificar las capacidades emergentes más prometedoras de la IA y crear modelos y empresas que escalan estas capacidades hasta convertirlas en capacidades confiables. Reconocen que la escala tiende a aumentar la confiabilidad de las capacidades emergentes.

Mira Murati, OpenAI:

Es importante prestar atención a estas características emergentes, incluso si son muy poco confiables. Especialmente para las personas que están creando empresas hoy en día, realmente quieren pensar: "Bien, ¿qué es posible hoy? ¿Qué ven hoy?" Porque muy rápidamente estos modelos se volverán confiables. Darío Amodei, Antrópico:

Cuando lanzamos GPT-2, lo que se consideró más impresionante en ese momento fue: "Introduces estos cinco ejemplos de traducción del inglés al francés directamente en el modelo de idioma y luego introduces la sexta oración en inglés, y en realidad se traduciría al francés". . Fue como, "Dios mío, entiende este patrón". Eso fue una locura para nosotros, a pesar de que era una mala traducción. Pero nuestra opinión es: "Mira, esto es sólo el comienzo de un viaje asombroso porque no hay límites y puede seguir ampliándose." ¿Por qué no pueden seguir existiendo esos modelos que hemos visto antes? Hay tantos objetivos para predecir la siguiente palabra y hay tantas cosas con las que puedes desafiarlos que definitivamente funciona. Y luego algunas personas lo miraron y dijeron: "Hiciste una herramienta de traducción robótica realmente mala." ## 13 ¿Bajará el costo de servir estos modelos?

Los costos computacionales son una de las principales limitaciones para escalar estos modelos, y la actual escasez de chips está elevando los costos al limitar la oferta. Sin embargo, si Nvidia produce más H100 el próximo año, eso debería aliviar la escasez de GPU y potencialmente reducir los costos informáticos.

Noam Shazeer, Personaje.AI:

El modelo que ofrecemos ahora requirió alrededor de $2 millones en ciclos de cómputo para entrenarse el año pasado, y probablemente lo haremos nuevamente por medio millón de dólares. Así que vamos a implementar docenas de puntos de coeficiente intelectual de cosas más inteligentes antes de fin de año. Veo que estas cosas están aumentando enormemente. Simplemente no es tan caro. Creo que ayer vi un artículo que decía que Nvidia iba a fabricar otro 1,5 millones de H100 el próximo año, que sería el 2 millones de H100. Eso es aproximadamente un cuarto de billón de operaciones por segundo por persona. Esto significa que por cada persona en el planeta, en un modelo con 100 mil millones de parámetros, podría procesar 1 palabra por segundo. Pero no todo el mundo tiene acceso a él, por lo que no es tan caro. Esto es muy escalable si se hace bien y estamos trabajando duro para que eso suceda. Darío Amodei, Antrópico:

Mi punto básico es que la inferencia no será tan costosa. La lógica básica de la ley de escala es que si aumenta el cálculo en un factor de n, debe aumentar los datos en un factor de la raíz cuadrada de n y el tamaño del modelo en un factor de la raíz cuadrada de n. Esta raíz cuadrada básicamente significa que el modelo en sí no crecerá más y el hardware se hará más rápido a medida que lo hagas. Creo que estas cosas seguirán siendo relevantes durante los próximos 3 o 4 años. Sin innovación arquitectónica, se vuelven un poco más caras. Si hay innovación arquitectónica, y espero que la haya, serán más baratos. Pero incluso si los costos computacionales permanecen constantes, las mejoras en la eficiencia a nivel de modelo parecen inevitables, especialmente con tanto talento llegando al campo, y la IA en sí misma puede ser nuestra herramienta más poderosa para mejorar la forma en que funciona.

Darío Amodei, Antrópico:

A medida que la IA se vuelve más poderosa, se desempeña mejor en la mayoría de las tareas cognitivas. Una tarea cognitiva relacionada es juzgar la seguridad de los sistemas de inteligencia artificial y, en última instancia, realizar investigaciones sobre seguridad. Hay un componente autorreferencial en esto. Podemos ver esto leyendo el interior de las redes neuronales, como el ámbito de la interpretabilidad. Los sistemas de IA potentes pueden ayudarnos a interpretar la actividad neuronal en sistemas de IA más débiles. Y estas ideas de interpretabilidad a menudo nos dicen cómo funciona el modelo. Cuando nos dicen cómo funciona un modelo, a menudo sugieren formas de mejorarlo o hacerlo más eficiente. Una de las áreas de investigación más prometedoras es el ajuste de modelos grandes para casos de uso específicos sin ejecutar el modelo completo.

Ali Ghodsi, ladrillos de datos:

Si crearas mil versiones de LLM que fueran buenas en mil cosas diferentes y tuvieras que cargar cada una de ellas en la GPU y servirlas, eso resultaría muy costoso. Lo más importante que todo el mundo está buscando en este momento es: ¿Existe alguna técnica que pueda obtener muy buenos resultados con sólo modificaciones menores? Existen muchas tecnologías como ajuste de prefijos, LoRA, CUBE LoRA, etc. Pero no se ha demostrado que funcione ninguna solución verdaderamente perfecta. Pero alguien lo encontrará. ## 14 ¿Cómo medimos el progreso hacia la inteligencia artificial general?

Cuando ampliamos estos modelos, ¿cómo sabemos cuándo una IA se convierte en inteligencia artificial general? Cuando escuchamos a menudo el término AGI, puede resultar difícil definirlo, quizás en parte porque es difícil de medir.

Los puntos de referencia cuantitativos como GLUE y SUPERGLUE se han utilizado durante mucho tiempo como métricas estandarizadas para medir el rendimiento del modelo de IA. Pero al igual que las pruebas estandarizadas que aplicamos a los humanos, los puntos de referencia de la IA plantean la pregunta: ¿Hasta qué punto se mide la capacidad de razonamiento de un LLM y en qué medida se mide su capacidad para aprobar una prueba?

Ali Ghodsi, Databricks:

Siento que todos los puntos de referencia son una mierda. Imagínese si todas nuestras universidades dijeran: "Le daremos las respuestas para que las vea la noche anterior al examen. Y luego, al día siguiente, le pediremos que responda las preguntas y las califique". , todos podrían aprobar el examen fácilmente. Por ejemplo, MMLU es el punto de referencia que mucha gente utiliza para evaluar estos modelos. MMLU es solo una pregunta de opción múltiple en Internet. Haga una pregunta, ¿la respuesta es A, B, C, D o E? Luego te dirá la respuesta correcta. Se puede entrenar online y crear un modelo LLM capaz de superarlo. La prueba cualitativa original para AGI fue la prueba de Turing, pero convencer a los humanos de que una IA es humana no es un problema difícil. Lograr que la inteligencia artificial haga lo que hacen los humanos en el mundo real es un problema difícil. Entonces, ¿qué pruebas podemos utilizar para comprender la funcionalidad de estos sistemas?

Dylan Field, Figma:

Lo que estamos viendo ahora en estos sistemas es que es fácil hacer que la gente crea que eres humano, pero es difícil hacer cosas buenas. Puedo hacer que GPT-4 desarrolle un plan de negocios y te lo venda, pero eso no significa que vayas a invertir. Cuando en realidad tienes dos negocios en competencia, uno dirigido por IA y otro por humanos, y eliges invertir en el negocio de la IA, eso me preocupa. David Baszucki, Roblox: