La gran tormenta de modelos sopló durante la mayor parte del año, y el mercado de AIGC comenzó a cambiar de nuevo:

Las demostraciones tecnológicas geniales están siendo reemplazadas por experiencias completas de productos. **

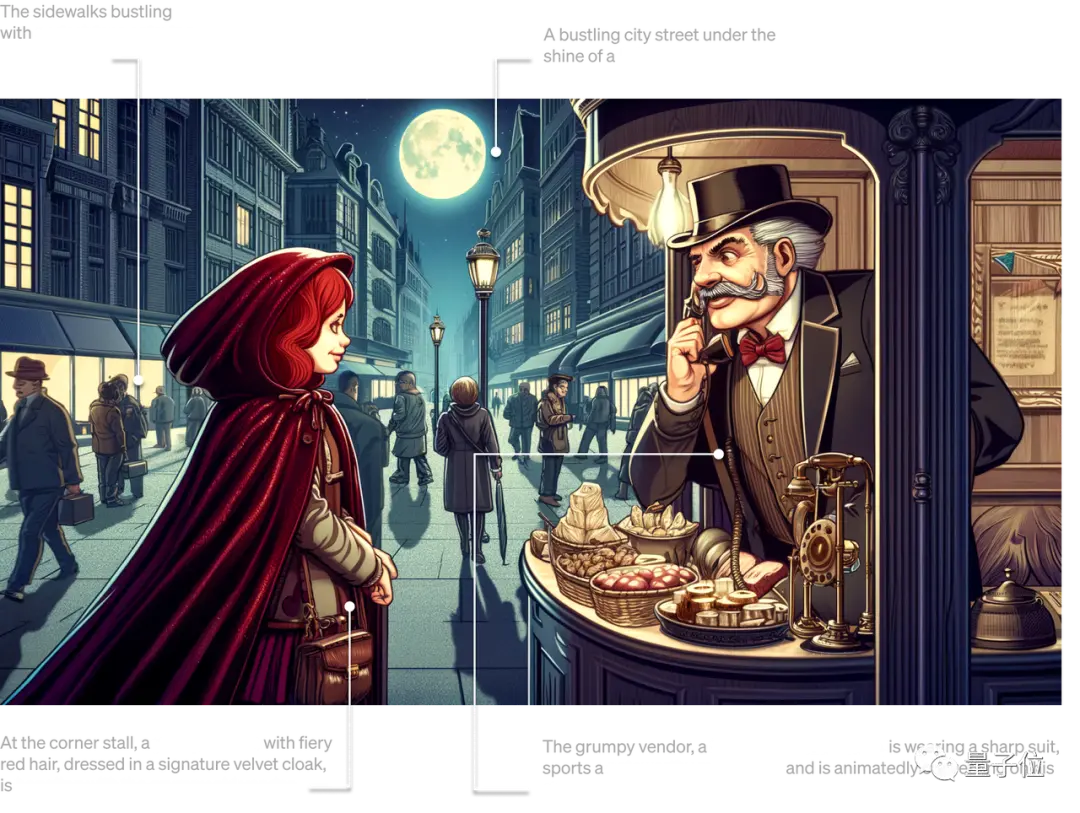

Por ejemplo, el último modelo de pintura de IA de OpenAI, DALL· Tan pronto como debutó el E 3, unió fuerzas con ChatGPT para convertirse en la nueva herramienta de productividad más esperada en ChatGPT Plus.

** **###### △DALL· E3 reproduce con precisión cada detalle de la entrada de texto

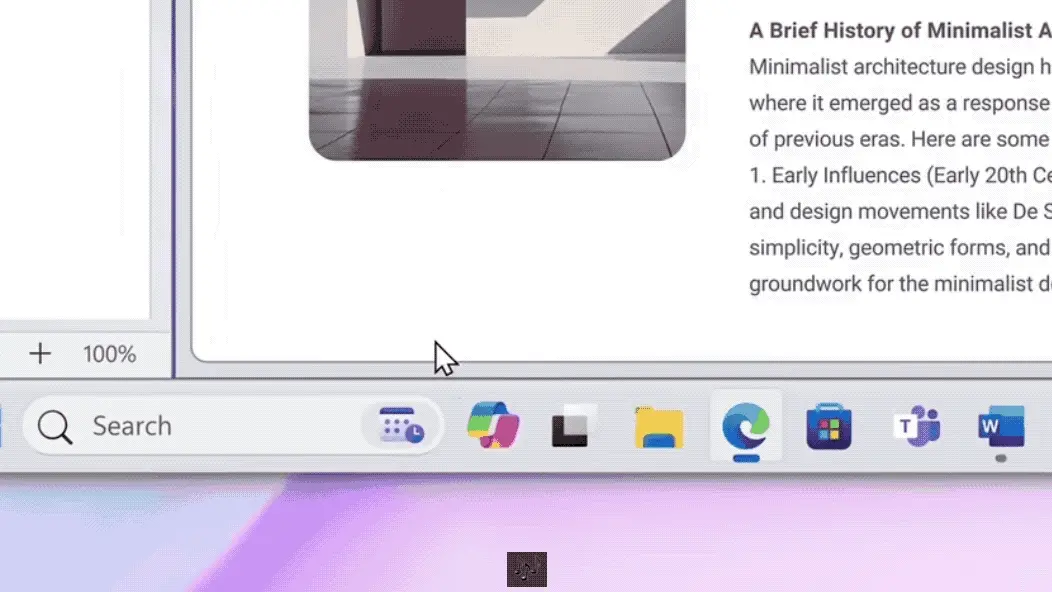

Por ejemplo, el Copilot de Microsoft basado en GPT-4 se ha asentado por completo en Windows 11, reemplazando oficialmente a Cortana como una nueva generación de asistentes de IA en el sistema operativo.

** **###### △ Utilice Copilot para resumir las entradas del blog con un solo clic

Por otro ejemplo, los automóviles domésticos como Jiyue 01 tienen oficialmente equipados modelos grandes en la cabina, y están completamente fuera de línea ...

Si en marzo de 2023 "los grandes modelos lo remodelan todo" era solo una predicción optimista de los pioneros de la tecnología, hoy en día, la todavía feroz guerra de los 100 modelos y el progreso de la aplicación práctica han hecho que esta visión sea cada vez más resonante dentro y fuera de la industria.

En otras palabras, desde todo el método de producción en Internet hasta la cabina inteligente en cada automóvil, se avecina una era de autoinnovación con modelos grandes como base técnica e impulsando miles de industrias.

De acuerdo con el método de nomenclatura de la era del vapor y la era eléctrica, puede llamarse la "era de la fuerza modular".

En la "Era Molí", uno de los escenarios más preocupantes es el del terminal inteligente.

La razón es simple: la industria de terminales inteligentes, representada por teléfonos inteligentes, PC, automóviles inteligentes e incluso dispositivos XR, es una de las industrias tecnológicas más estrechamente relacionadas con la vida de las personas contemporáneas y, naturalmente, se ha convertido en un estándar de oro para probar la madurez de las tecnologías de vanguardia.

Por lo tanto, cuando la primera ola de hype provocada por el boom tecnológico se vaya calmando poco a poco, con el escenario de los terminales inteligentes como ancla, ¿cómo deben verse e interpretarse las nuevas oportunidades y retos de la "era de la energía modular"?

Ahora, es el momento de romperlo, amasarlo y peinarlo.

Terminal inteligente, modelo grande, nuevo campo de batalla

Antes de analizar en detalle los retos y oportunidades, volvamos a la pregunta esencial: ¿por qué la IA generativa está tan representada por grandes modelos, e incluso considerada la "cuarta revolución industrial"?

En respuesta a este fenómeno, muchas instituciones han estado realizando investigaciones para tratar de predecir o resumir el desarrollo de la IA generativa en diferentes escenarios, como "Generative AI: A Creative New World" de Sequoia Capital.

Entre ellas, muchas empresas líderes en la industria han analizado los escenarios de aterrizaje y las posibles direcciones de cambio de la IA generativa en industrias específicas basadas en su propia experiencia.

Por ejemplo, la IA del lado de la terminal representa al jugador Qualcomm, y hace algún tiempo publicó un libro blanco sobre el estado de desarrollo y la tendencia de la IA generativa "La IA híbrida es el futuro de la IA".

A partir de esto, puede ser posible interpretar las tres razones principales por las que la IA generativa es popular en la industria.

En primer lugar, la tecnología en sí es bastante difícil.

Tanto si se trata de un gran modelo que emerge de forma inteligente como de una pintura de IA que genera una calidad falsa con una calidad falsa, se trata de utilizar efectos para hablar, y es un área de trabajo real relacionada con el texto, las imágenes, el vídeo y la automatización, lo que demuestra una asombrosa capacidad para interrumpir los flujos de trabajo tradicionales.

En segundo lugar, hay grandes escenarios de aterrizaje potenciales. El avance generacional de la IA que ha traído el gran modelo ha aportado a la gente una imaginación infinita desde el principio: el primer grupo de experimentadores percibió rápidamente los beneficios de la IA generativa para trabajar.

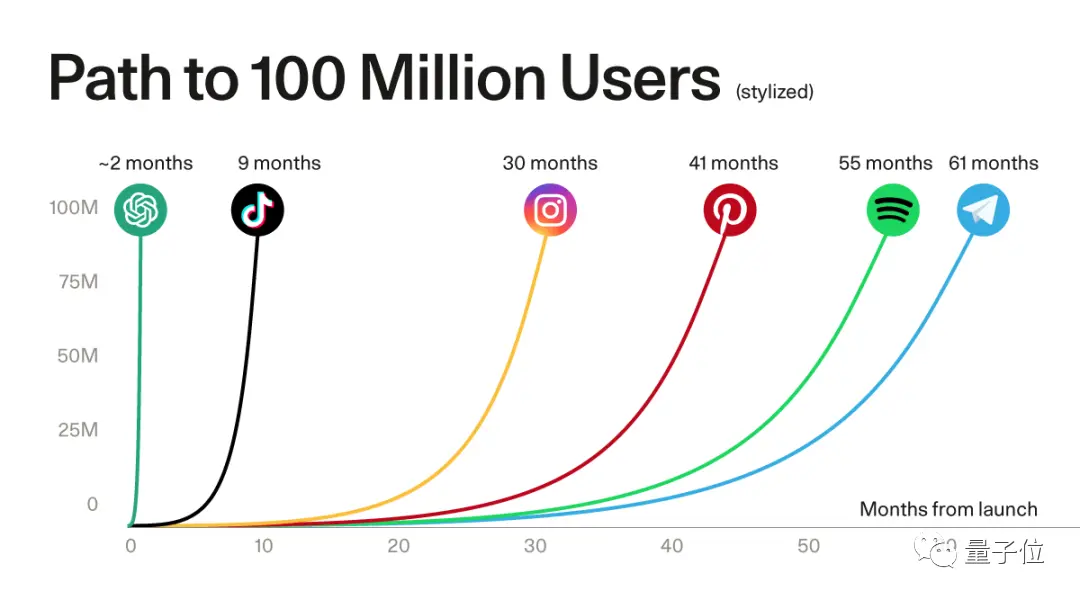

La enorme demanda del lado del usuario se puede ver en la tasa de crecimiento de usuarios de aplicaciones representativas como ChatGPT.

** **#### △ChatGPT rompió el récord de más de 100 millones de usuarios registrados de aplicaciones populares, fuente Sequoia Capital

Desde la búsqueda inicial en Internet, la programación, la oficina, hasta la aparición del turismo cultural, el derecho, la medicina, la industria, el transporte y otras aplicaciones de escena, aprovechando el viento de la IA generativa, mucho más que las empresas que pueden proporcionar grandes modelos básicos, pero también un gran número de nuevas empresas están prosperando y creciendo.

Muchos expertos de la industria creen que para los empresarios, la capa de aplicación que aportan los modelos grandes tiene mayores oportunidades.

Hay un avance generacional de la tecnología en la parte inferior, y una vigorosa explosión de la demanda de aplicaciones en la parte superior, y se estimula el efecto ecológico.

Según la predicción de Bloomberg Intelligence, el mercado de la IA generativa se disparará de 40.000 millones de dólares a 1,3 billones de dólares** en 2032, cubriendo una amplia gama de participantes en la cadena ecológica, incluida la infraestructura, los modelos básicos, las herramientas de desarrollo, los productos de aplicación, los productos de terminal, etc.

La formación de esta cadena ecológica ha promovido nuevos cambios en la industria y se espera que haga que la IA se convierta aún más en el núcleo subyacente de la productividad.

Basándonos en estos antecedentes, echemos un vistazo a lo que está sucediendo en la industria inteligente hoy en día.

Por un lado, la tormenta de aplicaciones de AIGC representada por grandes modelos es rápidamente ** de la nube a la terminal ** en el ritmo de iteración de días.

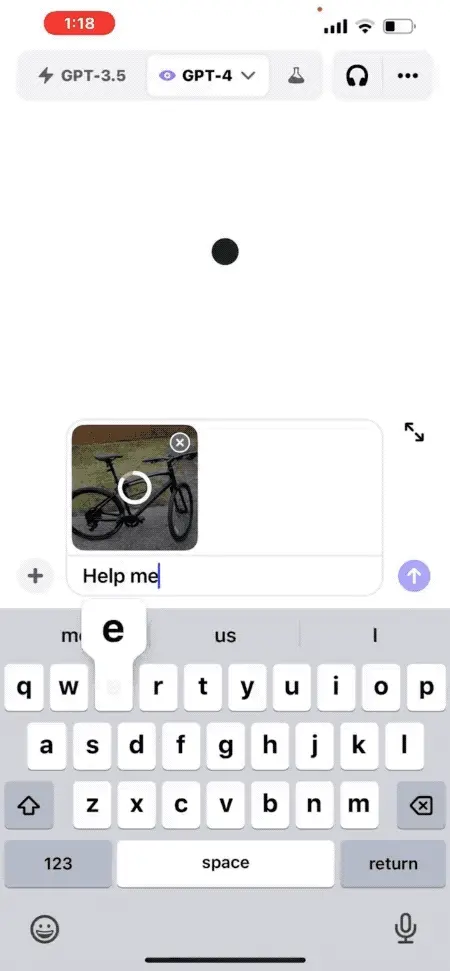

ChatGPT es el primero en actualizar la función multimodal de "charla audiovisual" en el terminal móvil, y los usuarios pueden tomar fotos y subirlas, y pueden hablar con ChatGPT para el contenido de la foto.

Por ejemplo, "Cómo ajustar la altura del asiento de la bicicleta":

** **#### △ y diálogo gráfico GPT-4, da 5 sugerencias en segundos

Qualcomm también se ha dado cuenta rápidamente del gran modelo de Stable Diffusion y ControlNet que ejecuta más de mil millones de parámetros en el lado del terminal, y solo se necesitan más de una docena de segundos para generar imágenes de IA de alta calidad en teléfonos móviles.

Muchos fabricantes de teléfonos móviles también han anunciado que instalarán el "cerebro" de modelos grandes para sus asistentes de voz.

Y no se trata solo de teléfonos.

En exposiciones a gran escala en el país y en el extranjero, como el Salón del Automóvil de Shanghai, el Salón del Automóvil de Chengdu, el Salón del Automóvil de Múnich, etc., la cooperación entre los fabricantes de modelos básicos y los fabricantes de automóviles se está volviendo cada vez más común, y los modelos grandes "subirse al automóvil" se han convertido en un nuevo punto de competencia en el campo de la cabina inteligente.

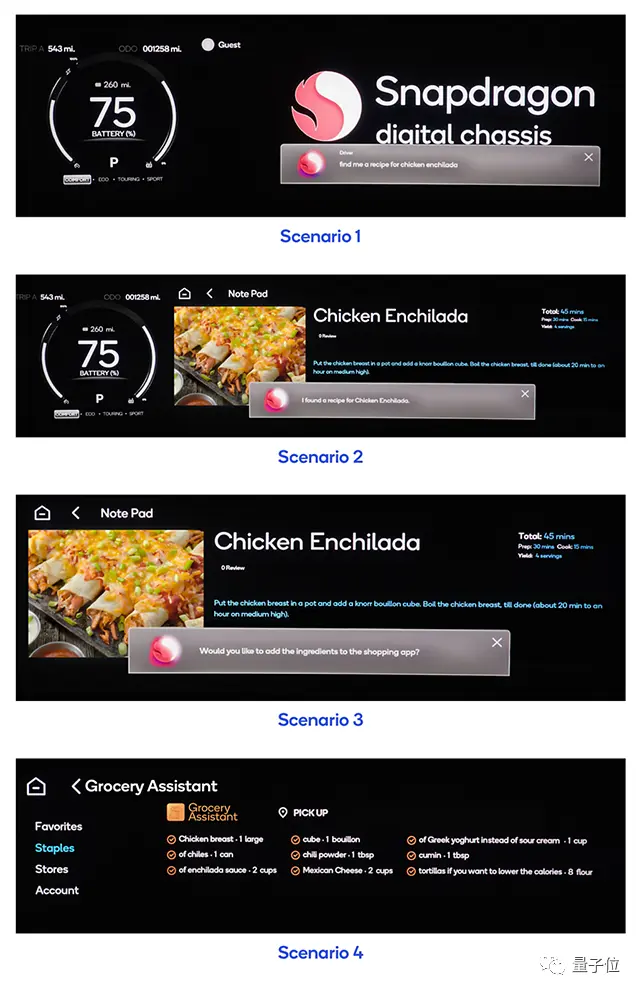

** **###### △ Una oración puede hacer que el modelo de automóvil compre ingredientes en la aplicación y pueda cocinar cuando se vaya a casa

Por otro lado, el brote de ** aplicaciones ha exacerbado la situación de escasez de potencia de cómputo. **

Es previsible que el coste de inferencia del modelo aumente con el aumento del número de usuarios activos diarios y su frecuencia de uso, y confiar únicamente en la potencia de la computación en la nube no es suficiente para promover rápidamente la escala de la IA generativa.

Esto también se puede ver en el hecho de que todos los ámbitos de la vida están aumentando su atención a la potencia de cálculo de la IA del lado de la terminal.

Por ejemplo, el jugador de IA del lado de la terminal Qualcomm lanzó una nueva generación de plataforma de computación de PC para mejorar el rendimiento del chip de PC, utilizando la CPU Oryon de desarrollo propio de Qualcomm, especialmente la NPU equipada con ella proporcionará un rendimiento más potente para la IA generativa, que se denomina plataforma de la serie Snapdragon X.

Se espera que esta nueva plataforma informática se lance en el Snapdragon Summit 2023.

Obviamente, ya sea desde el punto de vista de la aplicación o de la potencia de cálculo, los terminales inteligentes se han convertido en uno de los escenarios con mayor potencial de aterrizaje de AIGC.

AIGC Arrecife bajo marea

Las cosas a menudo tienen dos caras, al igual que los grandes modelos desde el rápido desarrollo hasta el aterrizaje.

Cuando la IA generativa se ha disparado hasta el día de hoy, ha surgido el verdadero cuello de botella bajo el enorme potencial de la industria de terminales inteligentes.

** Una de las mayores limitaciones es el nivel más bajo de hardware. **

Como mencionaron los inversores de Sequoia, Sonya Huang y Pat Grady, en su último artículo de análisis de IA generativa "Acto dos de la IA generativa", AIGC está creciendo rápidamente, pero el cuello de botella esperado no es la demanda de los clientes, sino la potencia informática del lado de la oferta.

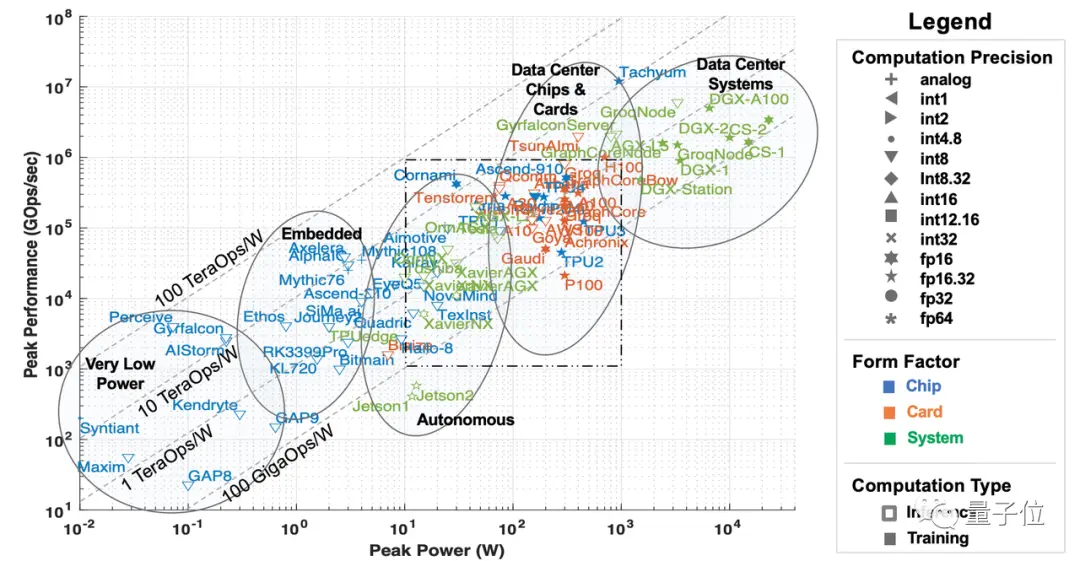

La potencia de cálculo aquí se refiere principalmente a los aceleradores de hardware de IA y aprendizaje automático, que se pueden dividir en cinco categorías desde la perspectiva de los escenarios de implementación:

Sistemas de clase centro de datos, aceleradores a nivel de servidor, aceleradores para escenarios de conducción asistida y conducción autónoma, edge computing y aceleradores de ultra bajo consumo.

** **###### △5 tipos de aceleradores de IA, fuente del artículo del MIT "AI and ML Accelerator Survey and Trends"

Con la explosión de ChatGPT, el gran modelo ha sacado fenomenalmente a AIGC del círculo, haciendo que el "poder de computación en la nube", como los centros de datos y los procesadores a nivel de servidor, reciban mucha atención a corto plazo, e incluso la situación de escasez.

Sin embargo, a medida que la IA generativa entra en su segunda fase, algunas preguntas sobre la potencia informática son cada vez más prominentes.

**El primer y mayor problema es el costo. ** Como se indica en el libro blanco de Qualcomm "La IA híbrida es el futuro de la IA", ahora ha pasado más de medio año, a medida que los grandes modelos pasan de la búsqueda de tecnología al aterrizaje de la aplicación, el ** entrenamiento del modelo básico ** de cada empresa se ha asentado gradualmente, y la mayor parte de la potencia informática ha recaído en el ** razonamiento ** de los grandes modelos.

A corto plazo, el costo de inferencia es aceptable, pero a medida que haya más y más aplicaciones para modelos grandes y más y más escenarios de aplicación, el costo de inferencia en aceleradores como servidores aumentará considerablemente, lo que finalmente resultará en que el costo de llamar a modelos grandes sea mayor que el entrenamiento de modelos grandes.

En otras palabras, después de que el modelo grande entre en la segunda etapa, la demanda a largo plazo de potencia de cálculo para la inferencia será mucho mayor que la de un solo entrenamiento, y confiar solo en la "potencia de computación en la nube" compuesta por centros de datos y procesadores a nivel de servidor es completamente insuficiente para alcanzar la inferencia a un costo aceptable para los usuarios.

Según las estadísticas de Qualcomm en el libro blanco, tomando como ejemplo el motor de búsqueda con un modelo grande, el costo de cada consulta de búsqueda puede alcanzar 10 veces el de los métodos tradicionales, y el costo anual solo en esta área puede aumentar en miles de millones de dólares.

Esto está destinado a convertirse en una limitación clave para el aterrizaje de modelos grandes.

**Junto con eso, hay problemas de latencia, privacidad y personalización. ** Qualcomm también mencionó en "La IA híbrida es el futuro de la IA" que los modelos grandes se implementan directamente en la nube, además de la cantidad insuficiente de computación de servidor causada por el aumento de usuarios, la necesidad de "hacer cola para su uso" y otros errores, también está destinado a resolver los problemas de privacidad y personalización del usuario.

Si los usuarios no quieren subir datos a la nube, los escenarios de uso de modelos grandes, como office y asistente inteligente, estarán sujetos a muchas restricciones, y la mayoría de estos escenarios se distribuyen en el lado del terminal; Si necesita seguir buscando mejores resultados, como personalizar modelos grandes para su propio uso, debe usar directamente la información personal para el entrenamiento de modelos grandes.

Bajo varios factores, el "poder de cómputo terminal" que puede desempeñar un papel en el razonamiento, es decir, varios tipos de procesadores, incluida la conducción automática y asistida, la computación de borde (integrada) y los aceleradores de ultra bajo consumo, han comenzado a ingresar al campo de visión de las personas.

Los terminales tienen una enorme potencia de cálculo. Según la predicción de IDC, el número de dispositivos IoT globales superará los 40.000 millones en 2025, generando casi 80 zettabytes de datos, y más de la mitad de los datos deben depender de la potencia de la computación terminal o perimetral para su procesamiento.

Sin embargo, el terminal también tiene problemas como el consumo limitado de energía y la disipación de calor, lo que resulta en una potencia de cálculo limitada.

En este caso, cómo utilizar la enorme potencia de cálculo que esconde el terminal para romper el cuello de botella al que se enfrenta el desarrollo de la potencia de computación en la nube se está convirtiendo en uno de los problemas técnicos más comunes en la "era de la energía modular".

**Sin mencionar que, además de la potencia de cómputo, la implementación de grandes modelos también enfrenta desafíos como los algoritmos, los datos y la competencia en el mercado. **

En el caso del algoritmo, aún se desconoce la arquitectura del modelo subyacente. ChatGPT ha logrado buenos resultados, pero su ruta técnica no es la dirección arquitectónica del modelo de próxima generación.

En cuanto a los datos, los datos de alta calidad son indispensables para que otras empresas logren los grandes resultados del modelo de ChatGPT, pero Act Two de Generative AI también señala que los datos generados por la empresa de aplicaciones no crean realmente una barrera.

La ventaja construida por los datos es frágil e insostenible, y es probable que la próxima generación de modelos básicos destruya directamente este "muro", por el contrario, los usuarios continuos y estables pueden realmente construir fuentes de datos.

Para el mercado, actualmente no existen aplicaciones asesinas para productos de modelos grandes, y aún se desconoce para qué tipo de escenarios es adecuado.

En esta era, en qué tipo de productos se utiliza y qué aplicaciones pueden ejercer su mayor valor, el mercado aún no ha dado un conjunto de metodologías o respuestas estándar que se puedan seguir.

**En respuesta a esta serie de problemas, actualmente hay dos formas principales de resolver problemas en la industria. **

Una es mejorar el algoritmo del modelo grande en sí, sin cambiar la "esencia" del modelo, mejorar su tamaño y mejorar su capacidad de implementación en más dispositivos;

Tomando como ejemplo el algoritmo Transformer, dichos modelos con una gran cantidad de parámetros deben ajustarse en la estructura si quieren ejecutarse en el lado final, por lo que muchos algoritmos livianos como MobileViT han nacido durante este tiempo.

Estos algoritmos buscan mejorar la estructura y la cantidad de parámetros sin afectar el efecto de salida, de modo que puedan ejecutarse en más dispositivos con modelos más pequeños.

La otra es mejorar la potencia de cálculo de la IA del propio hardware, de modo que los modelos grandes puedan aterrizar mejor en el lado final.

Dichos métodos incluyen el diseño multinúcleo en pilas de hardware y software de desarrollo, que se utilizan para mejorar el rendimiento de la computación de hardware y la versatilidad de los modelos en diferentes dispositivos, a fin de mejorar la posibilidad de que los modelos grandes aterricen en el lado final.

Lo primero se puede llamar la adaptación del software al hardware, y lo segundo es que los fabricantes de hardware se adaptan al cambio de la marea de los tiempos. Pero en cualquier dirección, existe el riesgo de ser superado solo por apostar. **

En la "era de la energía modular", la tecnología cambia cada día que pasa, y pueden aparecer nuevos avances desde ambos lados del software y el hardware, y una vez que faltan las reservas técnicas necesarias, pueden quedarse atrás.

Entonces, ¿deberíamos seguir ciegamente o simplemente perdernos el desarrollo de esta ola de tecnología? La verdad es que no.

** Para las empresas que han descubierto su propio valor en la era de Internet y la IA, también pueden explorar una tercera idea de solución en la era AIGC basada en sus propios escenarios y acumulación de tecnología. **

Tomemos como ejemplo a Qualcomm, una empresa de IA con tecnologías de software y hardware.

Frente a los desafíos de la tecnología de modelos grandes en diferentes escenarios, Qualcomm ha saltado de la identidad de una empresa de chips y ha abrazado la ola de AIGC desde el principio.

Además de mejorar continuamente la potencia de cálculo de IA del chip del lado del terminal, Qualcomm también está diseñando tecnología básica de IA, esforzándose por acelerar la velocidad de toda la industria de terminales inteligentes para adoptar AIGC como una empresa habilitadora.

Sin embargo, también hay varias dificultades previsibles en este enfoque:

En el caso de los modelos de IA más grandes y complejos, ¿cómo garantizar el rendimiento y hacer que funcione sin problemas en el terminal?

¿Cuándo utilizar diferentes modelos para distribuir mejor la potencia de cálculo entre terminales y nubes?

Incluso si se resuelve el problema de los modelos grandes que se implementan en el lado del terminal, ¿qué parte debe implementarse en la nube y qué parte debe implementarse en el terminal, y cómo garantizar que las conexiones y funciones entre las diferentes partes del modelo grande no se vean afectadas?

Si la ventaja de rendimiento en el lado del terminal es insuficiente, ¿cómo resolverlo?

......

Estos problemas no aparecen en un solo caso, sino que ya existen en todas las industrias o escenarios afectados por AIGC.

Ya sea que se trate de un método que rompe el juego o de una experiencia de aterrizaje real, la respuesta solo se puede explorar a partir de escenarios específicos y casos de la industria.

**¿Cómo romper la niebla de la "Era de la Energía Modular"? **

AIGC ha entrado en la segunda fase, los modelos grandes se están volviendo más populares y la industria ha comenzado a explorar formas de aterrizar.

** El libro blanco de Qualcomm "La IA híbrida es el futuro de la IA" menciona que, tomando como ejemplo los teléfonos inteligentes y las PC, ha habido muchos casos de escenarios de aterrizaje de AIGC en la nueva industria de terminales inteligentes en el campo de batalla. **

Las empresas ya están implementando modelos más pequeños y grandes en el lado de la terminal para problemas más personalizados, incluida la búsqueda de mensajes, la generación de mensajes de respuesta, la modificación de eventos del calendario y la navegación con un solo clic.

Por ejemplo, "reservar un asiento en un restaurante favorito", basado en el modelo grande, de acuerdo con el análisis de datos de usuario de restaurantes favoritos y horarios libres, dar recomendaciones de programación y agregar los resultados al calendario.

Qualcomm cree que debido a la cantidad limitada de parámetros de modelos grandes desplegados por el terminal y la falta de redes, puede haber una "ilusión de IA" al responder, y luego se puede basar en la tecnología del orquestador para establecer barreras de seguridad cuando el modelo grande carece de información para evitar los problemas anteriores.

Si no está satisfecho con el contenido generado por el modelo grande, también puede enviar la pregunta a la nube para su ejecución con un solo clic y luego enviar el resultado de la generación del modelo grande con una mejor respuesta al lado del terminal.

De esta manera, no solo puede reducir la presión de la potencia de cálculo de los modelos grandes que se ejecutan en la nube, sino también garantizar que los modelos grandes se puedan personalizar mientras se protege la privacidad del usuario en la mayor medida posible.

** En cuanto a los cuellos de botella técnicos que deben romperse, como la potencia de cálculo de los terminales y los algoritmos, algunos jugadores también han desarrollado algunas "formas de romper el juego". **

En el libro blanco, Qualcomm introdujo una clase de nuevas tecnologías que se han utilizado ampliamente en el libro blanco, como la decodificación especulativa, que fue un incendio hace algún tiempo.

Este es un método descubierto por Google y DeepMind al mismo tiempo para acelerar la inferencia de modelos grandes, y puede aplicar un modelo grande más pequeño para acelerar la generación de modelos grandes.

En pocas palabras, se trata de entrenar un modelo más pequeño y generar un lote de "palabras candidatas" para el modelo grande por adelantado, en lugar de dejar que el modelo grande "piense" y genere por sí mismo, y tome "decisiones" directamente.

Dado que la velocidad de generación del modelo pequeño es varias veces más rápida que la del modelo grande, una vez que el modelo grande siente que las palabras que el modelo pequeño ya tiene están disponibles, se puede tomar directamente sin generarlas lentamente usted mismo.

Este método aprovecha principalmente el hecho de que la velocidad de inferencia de los modelos grandes se ve más afectada por el ancho de banda de la memoria que por el aumento de la cantidad computacional.

Debido a la gran cantidad de parámetros y a que supera con creces la capacidad de caché, es más probable que los modelos grandes estén limitados por el ancho de banda de la memoria que por el rendimiento del hardware informático durante la inferencia. Por ejemplo, GPT-3 necesita leer los 175 mil millones de parámetros cada vez que genera una palabra, y el hardware informático a menudo está inactivo mientras espera los datos de memoria de la DRAM.

En otras palabras, cuando el modelo realiza inferencias por lotes, hay poca diferencia de tiempo entre el procesamiento de 100 tokens y un token a la vez.

Por lo tanto, el uso del muestreo especulativo no solo puede ejecutar fácilmente modelos grandes con decenas de miles de millones de parámetros, sino que también puede poner parte de la potencia de cálculo en el lado del terminal, lo que garantiza la velocidad de inferencia y conserva el efecto de generación de modelos grandes.

......

Pero tanto si se trata de un escenario como de una tecnología, al final, debemos encontrar los puntos de adaptación de cada uno para producir un valor sustancial de aplicación**, al igual que la relación entre software y hardware es inseparable:

Los avances en algoritmos de software, como la IA generativa, cuando se buscan escenarios de aterrizaje de terminales inteligentes, inevitablemente se enfrentarán a requisitos técnicos combinados con hardware de IA móvil como Qualcomm.

Incluyendo los teléfonos inteligentes, las PC, la XR, los automóviles y el Internet de las cosas, ¿cómo pueden los distintos segmentos de la industria de los terminales inteligentes encontrar su propio juego y valor en función de los puntos de acceso de AIGC?

¿Cómo pueden las empresas aprovechar esta ola de los tiempos para estimular el valor de aplicación de este tipo de tecnología y no perder la oportunidad de transformación de la productividad en toda la industria?

Ver originales

Esta página puede contener contenido de terceros, que se proporciona únicamente con fines informativos (sin garantías ni declaraciones) y no debe considerarse como un respaldo por parte de Gate a las opiniones expresadas ni como asesoramiento financiero o profesional. Consulte el Descargo de responsabilidad para obtener más detalles.

El tamaño del mercado de 10 años es de 1,3 billones de dólares estadounidenses, y ha llegado la era de la energía modular

Fuente original: Qubits

La gran tormenta de modelos sopló durante la mayor parte del año, y el mercado de AIGC comenzó a cambiar de nuevo:

Las demostraciones tecnológicas geniales están siendo reemplazadas por experiencias completas de productos. **

Por ejemplo, el último modelo de pintura de IA de OpenAI, DALL· Tan pronto como debutó el E 3, unió fuerzas con ChatGPT para convertirse en la nueva herramienta de productividad más esperada en ChatGPT Plus.

** **###### △DALL· E3 reproduce con precisión cada detalle de la entrada de texto

**###### △DALL· E3 reproduce con precisión cada detalle de la entrada de texto

Por ejemplo, el Copilot de Microsoft basado en GPT-4 se ha asentado por completo en Windows 11, reemplazando oficialmente a Cortana como una nueva generación de asistentes de IA en el sistema operativo.

** **###### △ Utilice Copilot para resumir las entradas del blog con un solo clic

**###### △ Utilice Copilot para resumir las entradas del blog con un solo clic

Por otro ejemplo, los automóviles domésticos como Jiyue 01 tienen oficialmente equipados modelos grandes en la cabina, y están completamente fuera de línea ...

Si en marzo de 2023 "los grandes modelos lo remodelan todo" era solo una predicción optimista de los pioneros de la tecnología, hoy en día, la todavía feroz guerra de los 100 modelos y el progreso de la aplicación práctica han hecho que esta visión sea cada vez más resonante dentro y fuera de la industria.

En otras palabras, desde todo el método de producción en Internet hasta la cabina inteligente en cada automóvil, se avecina una era de autoinnovación con modelos grandes como base técnica e impulsando miles de industrias.

De acuerdo con el método de nomenclatura de la era del vapor y la era eléctrica, puede llamarse la "era de la fuerza modular".

En la "Era Molí", uno de los escenarios más preocupantes es el del terminal inteligente.

La razón es simple: la industria de terminales inteligentes, representada por teléfonos inteligentes, PC, automóviles inteligentes e incluso dispositivos XR, es una de las industrias tecnológicas más estrechamente relacionadas con la vida de las personas contemporáneas y, naturalmente, se ha convertido en un estándar de oro para probar la madurez de las tecnologías de vanguardia.

Por lo tanto, cuando la primera ola de hype provocada por el boom tecnológico se vaya calmando poco a poco, con el escenario de los terminales inteligentes como ancla, ¿cómo deben verse e interpretarse las nuevas oportunidades y retos de la "era de la energía modular"?

Ahora, es el momento de romperlo, amasarlo y peinarlo.

Terminal inteligente, modelo grande, nuevo campo de batalla

Antes de analizar en detalle los retos y oportunidades, volvamos a la pregunta esencial: ¿por qué la IA generativa está tan representada por grandes modelos, e incluso considerada la "cuarta revolución industrial"?

En respuesta a este fenómeno, muchas instituciones han estado realizando investigaciones para tratar de predecir o resumir el desarrollo de la IA generativa en diferentes escenarios, como "Generative AI: A Creative New World" de Sequoia Capital.

Entre ellas, muchas empresas líderes en la industria han analizado los escenarios de aterrizaje y las posibles direcciones de cambio de la IA generativa en industrias específicas basadas en su propia experiencia.

Por ejemplo, la IA del lado de la terminal representa al jugador Qualcomm, y hace algún tiempo publicó un libro blanco sobre el estado de desarrollo y la tendencia de la IA generativa "La IA híbrida es el futuro de la IA".

A partir de esto, puede ser posible interpretar las tres razones principales por las que la IA generativa es popular en la industria.

En primer lugar, la tecnología en sí es bastante difícil.

Tanto si se trata de un gran modelo que emerge de forma inteligente como de una pintura de IA que genera una calidad falsa con una calidad falsa, se trata de utilizar efectos para hablar, y es un área de trabajo real relacionada con el texto, las imágenes, el vídeo y la automatización, lo que demuestra una asombrosa capacidad para interrumpir los flujos de trabajo tradicionales.

En segundo lugar, hay grandes escenarios de aterrizaje potenciales. El avance generacional de la IA que ha traído el gran modelo ha aportado a la gente una imaginación infinita desde el principio: el primer grupo de experimentadores percibió rápidamente los beneficios de la IA generativa para trabajar.

La enorme demanda del lado del usuario se puede ver en la tasa de crecimiento de usuarios de aplicaciones representativas como ChatGPT.

** **#### △ChatGPT rompió el récord de más de 100 millones de usuarios registrados de aplicaciones populares, fuente Sequoia Capital

**#### △ChatGPT rompió el récord de más de 100 millones de usuarios registrados de aplicaciones populares, fuente Sequoia Capital

Desde la búsqueda inicial en Internet, la programación, la oficina, hasta la aparición del turismo cultural, el derecho, la medicina, la industria, el transporte y otras aplicaciones de escena, aprovechando el viento de la IA generativa, mucho más que las empresas que pueden proporcionar grandes modelos básicos, pero también un gran número de nuevas empresas están prosperando y creciendo.

Muchos expertos de la industria creen que para los empresarios, la capa de aplicación que aportan los modelos grandes tiene mayores oportunidades.

Hay un avance generacional de la tecnología en la parte inferior, y una vigorosa explosión de la demanda de aplicaciones en la parte superior, y se estimula el efecto ecológico.

Según la predicción de Bloomberg Intelligence, el mercado de la IA generativa se disparará de 40.000 millones de dólares a 1,3 billones de dólares** en 2032, cubriendo una amplia gama de participantes en la cadena ecológica, incluida la infraestructura, los modelos básicos, las herramientas de desarrollo, los productos de aplicación, los productos de terminal, etc.

Basándonos en estos antecedentes, echemos un vistazo a lo que está sucediendo en la industria inteligente hoy en día.

Por un lado, la tormenta de aplicaciones de AIGC representada por grandes modelos es rápidamente ** de la nube a la terminal ** en el ritmo de iteración de días.

ChatGPT es el primero en actualizar la función multimodal de "charla audiovisual" en el terminal móvil, y los usuarios pueden tomar fotos y subirlas, y pueden hablar con ChatGPT para el contenido de la foto.

Por ejemplo, "Cómo ajustar la altura del asiento de la bicicleta":

** **#### △ y diálogo gráfico GPT-4, da 5 sugerencias en segundos

**#### △ y diálogo gráfico GPT-4, da 5 sugerencias en segundos

Qualcomm también se ha dado cuenta rápidamente del gran modelo de Stable Diffusion y ControlNet que ejecuta más de mil millones de parámetros en el lado del terminal, y solo se necesitan más de una docena de segundos para generar imágenes de IA de alta calidad en teléfonos móviles.

Muchos fabricantes de teléfonos móviles también han anunciado que instalarán el "cerebro" de modelos grandes para sus asistentes de voz.

Y no se trata solo de teléfonos.

En exposiciones a gran escala en el país y en el extranjero, como el Salón del Automóvil de Shanghai, el Salón del Automóvil de Chengdu, el Salón del Automóvil de Múnich, etc., la cooperación entre los fabricantes de modelos básicos y los fabricantes de automóviles se está volviendo cada vez más común, y los modelos grandes "subirse al automóvil" se han convertido en un nuevo punto de competencia en el campo de la cabina inteligente.

** **###### △ Una oración puede hacer que el modelo de automóvil compre ingredientes en la aplicación y pueda cocinar cuando se vaya a casa

**###### △ Una oración puede hacer que el modelo de automóvil compre ingredientes en la aplicación y pueda cocinar cuando se vaya a casa

Por otro lado, el brote de ** aplicaciones ha exacerbado la situación de escasez de potencia de cómputo. **

Es previsible que el coste de inferencia del modelo aumente con el aumento del número de usuarios activos diarios y su frecuencia de uso, y confiar únicamente en la potencia de la computación en la nube no es suficiente para promover rápidamente la escala de la IA generativa.

Esto también se puede ver en el hecho de que todos los ámbitos de la vida están aumentando su atención a la potencia de cálculo de la IA del lado de la terminal.

Por ejemplo, el jugador de IA del lado de la terminal Qualcomm lanzó una nueva generación de plataforma de computación de PC para mejorar el rendimiento del chip de PC, utilizando la CPU Oryon de desarrollo propio de Qualcomm, especialmente la NPU equipada con ella proporcionará un rendimiento más potente para la IA generativa, que se denomina plataforma de la serie Snapdragon X.

Se espera que esta nueva plataforma informática se lance en el Snapdragon Summit 2023.

Obviamente, ya sea desde el punto de vista de la aplicación o de la potencia de cálculo, los terminales inteligentes se han convertido en uno de los escenarios con mayor potencial de aterrizaje de AIGC.

AIGC Arrecife bajo marea

Las cosas a menudo tienen dos caras, al igual que los grandes modelos desde el rápido desarrollo hasta el aterrizaje.

Cuando la IA generativa se ha disparado hasta el día de hoy, ha surgido el verdadero cuello de botella bajo el enorme potencial de la industria de terminales inteligentes.

** Una de las mayores limitaciones es el nivel más bajo de hardware. **

Como mencionaron los inversores de Sequoia, Sonya Huang y Pat Grady, en su último artículo de análisis de IA generativa "Acto dos de la IA generativa", AIGC está creciendo rápidamente, pero el cuello de botella esperado no es la demanda de los clientes, sino la potencia informática del lado de la oferta.

La potencia de cálculo aquí se refiere principalmente a los aceleradores de hardware de IA y aprendizaje automático, que se pueden dividir en cinco categorías desde la perspectiva de los escenarios de implementación:

Sistemas de clase centro de datos, aceleradores a nivel de servidor, aceleradores para escenarios de conducción asistida y conducción autónoma, edge computing y aceleradores de ultra bajo consumo.

** **###### △5 tipos de aceleradores de IA, fuente del artículo del MIT "AI and ML Accelerator Survey and Trends"

**###### △5 tipos de aceleradores de IA, fuente del artículo del MIT "AI and ML Accelerator Survey and Trends"

Con la explosión de ChatGPT, el gran modelo ha sacado fenomenalmente a AIGC del círculo, haciendo que el "poder de computación en la nube", como los centros de datos y los procesadores a nivel de servidor, reciban mucha atención a corto plazo, e incluso la situación de escasez.

Sin embargo, a medida que la IA generativa entra en su segunda fase, algunas preguntas sobre la potencia informática son cada vez más prominentes.

**El primer y mayor problema es el costo. ** Como se indica en el libro blanco de Qualcomm "La IA híbrida es el futuro de la IA", ahora ha pasado más de medio año, a medida que los grandes modelos pasan de la búsqueda de tecnología al aterrizaje de la aplicación, el ** entrenamiento del modelo básico ** de cada empresa se ha asentado gradualmente, y la mayor parte de la potencia informática ha recaído en el ** razonamiento ** de los grandes modelos.

A corto plazo, el costo de inferencia es aceptable, pero a medida que haya más y más aplicaciones para modelos grandes y más y más escenarios de aplicación, el costo de inferencia en aceleradores como servidores aumentará considerablemente, lo que finalmente resultará en que el costo de llamar a modelos grandes sea mayor que el entrenamiento de modelos grandes.

En otras palabras, después de que el modelo grande entre en la segunda etapa, la demanda a largo plazo de potencia de cálculo para la inferencia será mucho mayor que la de un solo entrenamiento, y confiar solo en la "potencia de computación en la nube" compuesta por centros de datos y procesadores a nivel de servidor es completamente insuficiente para alcanzar la inferencia a un costo aceptable para los usuarios.

Según las estadísticas de Qualcomm en el libro blanco, tomando como ejemplo el motor de búsqueda con un modelo grande, el costo de cada consulta de búsqueda puede alcanzar 10 veces el de los métodos tradicionales, y el costo anual solo en esta área puede aumentar en miles de millones de dólares.

Esto está destinado a convertirse en una limitación clave para el aterrizaje de modelos grandes.

**Junto con eso, hay problemas de latencia, privacidad y personalización. ** Qualcomm también mencionó en "La IA híbrida es el futuro de la IA" que los modelos grandes se implementan directamente en la nube, además de la cantidad insuficiente de computación de servidor causada por el aumento de usuarios, la necesidad de "hacer cola para su uso" y otros errores, también está destinado a resolver los problemas de privacidad y personalización del usuario.

Si los usuarios no quieren subir datos a la nube, los escenarios de uso de modelos grandes, como office y asistente inteligente, estarán sujetos a muchas restricciones, y la mayoría de estos escenarios se distribuyen en el lado del terminal; Si necesita seguir buscando mejores resultados, como personalizar modelos grandes para su propio uso, debe usar directamente la información personal para el entrenamiento de modelos grandes.

Bajo varios factores, el "poder de cómputo terminal" que puede desempeñar un papel en el razonamiento, es decir, varios tipos de procesadores, incluida la conducción automática y asistida, la computación de borde (integrada) y los aceleradores de ultra bajo consumo, han comenzado a ingresar al campo de visión de las personas.

Los terminales tienen una enorme potencia de cálculo. Según la predicción de IDC, el número de dispositivos IoT globales superará los 40.000 millones en 2025, generando casi 80 zettabytes de datos, y más de la mitad de los datos deben depender de la potencia de la computación terminal o perimetral para su procesamiento.

Sin embargo, el terminal también tiene problemas como el consumo limitado de energía y la disipación de calor, lo que resulta en una potencia de cálculo limitada.

En este caso, cómo utilizar la enorme potencia de cálculo que esconde el terminal para romper el cuello de botella al que se enfrenta el desarrollo de la potencia de computación en la nube se está convirtiendo en uno de los problemas técnicos más comunes en la "era de la energía modular".

**Sin mencionar que, además de la potencia de cómputo, la implementación de grandes modelos también enfrenta desafíos como los algoritmos, los datos y la competencia en el mercado. **

En el caso del algoritmo, aún se desconoce la arquitectura del modelo subyacente. ChatGPT ha logrado buenos resultados, pero su ruta técnica no es la dirección arquitectónica del modelo de próxima generación.

En cuanto a los datos, los datos de alta calidad son indispensables para que otras empresas logren los grandes resultados del modelo de ChatGPT, pero Act Two de Generative AI también señala que los datos generados por la empresa de aplicaciones no crean realmente una barrera.

La ventaja construida por los datos es frágil e insostenible, y es probable que la próxima generación de modelos básicos destruya directamente este "muro", por el contrario, los usuarios continuos y estables pueden realmente construir fuentes de datos.

Para el mercado, actualmente no existen aplicaciones asesinas para productos de modelos grandes, y aún se desconoce para qué tipo de escenarios es adecuado.

En esta era, en qué tipo de productos se utiliza y qué aplicaciones pueden ejercer su mayor valor, el mercado aún no ha dado un conjunto de metodologías o respuestas estándar que se puedan seguir.

Una es mejorar el algoritmo del modelo grande en sí, sin cambiar la "esencia" del modelo, mejorar su tamaño y mejorar su capacidad de implementación en más dispositivos;

Tomando como ejemplo el algoritmo Transformer, dichos modelos con una gran cantidad de parámetros deben ajustarse en la estructura si quieren ejecutarse en el lado final, por lo que muchos algoritmos livianos como MobileViT han nacido durante este tiempo.

Estos algoritmos buscan mejorar la estructura y la cantidad de parámetros sin afectar el efecto de salida, de modo que puedan ejecutarse en más dispositivos con modelos más pequeños.

La otra es mejorar la potencia de cálculo de la IA del propio hardware, de modo que los modelos grandes puedan aterrizar mejor en el lado final.

Dichos métodos incluyen el diseño multinúcleo en pilas de hardware y software de desarrollo, que se utilizan para mejorar el rendimiento de la computación de hardware y la versatilidad de los modelos en diferentes dispositivos, a fin de mejorar la posibilidad de que los modelos grandes aterricen en el lado final.

Lo primero se puede llamar la adaptación del software al hardware, y lo segundo es que los fabricantes de hardware se adaptan al cambio de la marea de los tiempos. Pero en cualquier dirección, existe el riesgo de ser superado solo por apostar. **

En la "era de la energía modular", la tecnología cambia cada día que pasa, y pueden aparecer nuevos avances desde ambos lados del software y el hardware, y una vez que faltan las reservas técnicas necesarias, pueden quedarse atrás.

Entonces, ¿deberíamos seguir ciegamente o simplemente perdernos el desarrollo de esta ola de tecnología? La verdad es que no.

** Para las empresas que han descubierto su propio valor en la era de Internet y la IA, también pueden explorar una tercera idea de solución en la era AIGC basada en sus propios escenarios y acumulación de tecnología. **

Tomemos como ejemplo a Qualcomm, una empresa de IA con tecnologías de software y hardware.

Frente a los desafíos de la tecnología de modelos grandes en diferentes escenarios, Qualcomm ha saltado de la identidad de una empresa de chips y ha abrazado la ola de AIGC desde el principio.

Además de mejorar continuamente la potencia de cálculo de IA del chip del lado del terminal, Qualcomm también está diseñando tecnología básica de IA, esforzándose por acelerar la velocidad de toda la industria de terminales inteligentes para adoptar AIGC como una empresa habilitadora.

Sin embargo, también hay varias dificultades previsibles en este enfoque:

En el caso de los modelos de IA más grandes y complejos, ¿cómo garantizar el rendimiento y hacer que funcione sin problemas en el terminal?

¿Cuándo utilizar diferentes modelos para distribuir mejor la potencia de cálculo entre terminales y nubes?

Incluso si se resuelve el problema de los modelos grandes que se implementan en el lado del terminal, ¿qué parte debe implementarse en la nube y qué parte debe implementarse en el terminal, y cómo garantizar que las conexiones y funciones entre las diferentes partes del modelo grande no se vean afectadas?

Si la ventaja de rendimiento en el lado del terminal es insuficiente, ¿cómo resolverlo?

......

Estos problemas no aparecen en un solo caso, sino que ya existen en todas las industrias o escenarios afectados por AIGC.

Ya sea que se trate de un método que rompe el juego o de una experiencia de aterrizaje real, la respuesta solo se puede explorar a partir de escenarios específicos y casos de la industria.

**¿Cómo romper la niebla de la "Era de la Energía Modular"? **

AIGC ha entrado en la segunda fase, los modelos grandes se están volviendo más populares y la industria ha comenzado a explorar formas de aterrizar.

** El libro blanco de Qualcomm "La IA híbrida es el futuro de la IA" menciona que, tomando como ejemplo los teléfonos inteligentes y las PC, ha habido muchos casos de escenarios de aterrizaje de AIGC en la nueva industria de terminales inteligentes en el campo de batalla. **

Las empresas ya están implementando modelos más pequeños y grandes en el lado de la terminal para problemas más personalizados, incluida la búsqueda de mensajes, la generación de mensajes de respuesta, la modificación de eventos del calendario y la navegación con un solo clic.

Por ejemplo, "reservar un asiento en un restaurante favorito", basado en el modelo grande, de acuerdo con el análisis de datos de usuario de restaurantes favoritos y horarios libres, dar recomendaciones de programación y agregar los resultados al calendario.

Qualcomm cree que debido a la cantidad limitada de parámetros de modelos grandes desplegados por el terminal y la falta de redes, puede haber una "ilusión de IA" al responder, y luego se puede basar en la tecnología del orquestador para establecer barreras de seguridad cuando el modelo grande carece de información para evitar los problemas anteriores.

Si no está satisfecho con el contenido generado por el modelo grande, también puede enviar la pregunta a la nube para su ejecución con un solo clic y luego enviar el resultado de la generación del modelo grande con una mejor respuesta al lado del terminal.

De esta manera, no solo puede reducir la presión de la potencia de cálculo de los modelos grandes que se ejecutan en la nube, sino también garantizar que los modelos grandes se puedan personalizar mientras se protege la privacidad del usuario en la mayor medida posible.

En el libro blanco, Qualcomm introdujo una clase de nuevas tecnologías que se han utilizado ampliamente en el libro blanco, como la decodificación especulativa, que fue un incendio hace algún tiempo.

Este es un método descubierto por Google y DeepMind al mismo tiempo para acelerar la inferencia de modelos grandes, y puede aplicar un modelo grande más pequeño para acelerar la generación de modelos grandes.

En pocas palabras, se trata de entrenar un modelo más pequeño y generar un lote de "palabras candidatas" para el modelo grande por adelantado, en lugar de dejar que el modelo grande "piense" y genere por sí mismo, y tome "decisiones" directamente.

Dado que la velocidad de generación del modelo pequeño es varias veces más rápida que la del modelo grande, una vez que el modelo grande siente que las palabras que el modelo pequeño ya tiene están disponibles, se puede tomar directamente sin generarlas lentamente usted mismo.

Este método aprovecha principalmente el hecho de que la velocidad de inferencia de los modelos grandes se ve más afectada por el ancho de banda de la memoria que por el aumento de la cantidad computacional.

Debido a la gran cantidad de parámetros y a que supera con creces la capacidad de caché, es más probable que los modelos grandes estén limitados por el ancho de banda de la memoria que por el rendimiento del hardware informático durante la inferencia. Por ejemplo, GPT-3 necesita leer los 175 mil millones de parámetros cada vez que genera una palabra, y el hardware informático a menudo está inactivo mientras espera los datos de memoria de la DRAM.

En otras palabras, cuando el modelo realiza inferencias por lotes, hay poca diferencia de tiempo entre el procesamiento de 100 tokens y un token a la vez.

Por lo tanto, el uso del muestreo especulativo no solo puede ejecutar fácilmente modelos grandes con decenas de miles de millones de parámetros, sino que también puede poner parte de la potencia de cálculo en el lado del terminal, lo que garantiza la velocidad de inferencia y conserva el efecto de generación de modelos grandes.

Pero tanto si se trata de un escenario como de una tecnología, al final, debemos encontrar los puntos de adaptación de cada uno para producir un valor sustancial de aplicación**, al igual que la relación entre software y hardware es inseparable:

Los avances en algoritmos de software, como la IA generativa, cuando se buscan escenarios de aterrizaje de terminales inteligentes, inevitablemente se enfrentarán a requisitos técnicos combinados con hardware de IA móvil como Qualcomm.

Incluyendo los teléfonos inteligentes, las PC, la XR, los automóviles y el Internet de las cosas, ¿cómo pueden los distintos segmentos de la industria de los terminales inteligentes encontrar su propio juego y valor en función de los puntos de acceso de AIGC?

¿Cómo pueden las empresas aprovechar esta ola de los tiempos para estimular el valor de aplicación de este tipo de tecnología y no perder la oportunidad de transformación de la productividad en toda la industria?