GPT-4 ne peut pas échapper à la « malédiction du renversement » ! De nouvelles recherches révèlent que les grands modèles présentent des défauts de raisonnement : savoir « A est B » ne permet pas de déduire « B est A ».

Le grand mannequin sait « ta mère est ta mère » mais ne peut pas répondre « tu es le fils de ta mère » ? ?

Une telle nouvelle étude a déclenché toute la discussion dès sa publication.

Des chercheurs de l’Université Vanderbilt, de l’Université du Sussex, de l’Université d’Oxford et d’autres instituts de recherche ont été surpris de constater :

Un grand modèle de langage reçoit des données sous la forme « A est B » pendant la formation, et il ne déduira pas automatiquement « B est A ». Il existe un phénomène de « malédiction d'inversion » dans les grands modèles.

Encore mieux que GPT-4, dans l'expérience de problème inverse, le taux de précision n'est que de 33 %.

Andrej Karpathy, membre fondateur d'OpenAI, a immédiatement transmis cet article et commenté :

Les connaissances en LLM sont bien plus « fragmentées » qu'on ne le pense, et je n'en ai toujours pas une bonne intuition.

Que se passe-t-il exactement ?

"Reversal Curse" des grands modèles

Les chercheurs ont mené deux expériences principales.

Dans la première expérience, les chercheurs ont construit la forme de données suivante à l’aide de GPT-4 pour affiner un grand modèle.

est . (ou vice versa)

Tous ces noms sont fictifs pour éviter que les grands mannequins ne les voient lors des entraînements.

Les résultats expérimentaux sur GPT-3-175B montrent que le modèle donne de bonnes réponses lorsque les invites correspondent à l'ordre des descriptions données dans l'ensemble de données.

Mais lorsque l'ordre est inversé, la précision du modèle ** tombe même directement à 0**.

Par exemple, même si le grand mannequin a reçu la donnée "Daphné est la réalisatrice de "Journey of Time"", lorsque vous lui demandez "Qui est Daphné ?", il peut bien répondre. Mais quand on demande à son tour : « Qui est le réalisateur de « Journey in Time », le modèle est confus.

Les chercheurs ont également obtenu les mêmes résultats expérimentaux sur GPT-3-350M et Llama-7B.

Regardons à nouveau l'expérience 2. Dans cette expérience, les chercheurs ont testé la capacité du grand modèle de langage à inverser le traitement des informations réelles sur les célébrités sans aucun réglage précis.

Ils ont rassemblé une liste des 1 000 célébrités les plus populaires d’IMDB (2023) et ont interrogé GPT-4 sur les parents de ces personnes via l’API OpenAI, ce qui a abouti à 1 573 paires enfants-parents de célébrités.

Il a été constaté que si la question était comme celle-ci : « Quel est le nom de la mère de Tom Cruise ? », la précision de la réponse de GPT-4 était de 79 %. Mais lorsque la question a été inversée en « Quel est le nom du fils de Mary Lee Pfeiffer (la mère de Tom Cruise) ? », la précision de la réponse de GPT-4 est tombée à 33 %.

Les chercheurs ont également mené le même test sur le modèle de la famille Llama-1. Dans l'expérience, la précision de tous les modèles pour répondre à la question « Qui sont les parents » était bien supérieure à la précision pour répondre à la question « Qui est l'enfant »**.

Les chercheurs ont baptisé ce phénomène « la malédiction du renversement ». Ils pensent que cela révèle les limites idiosyncrasiques des modèles linguistiques en matière de raisonnement et de généralisation.

Owain Evans, auteur correspondant de l'article et chercheur à l'Université d'Oxford, a expliqué :

Pourquoi la Malédiction Inversée mérite-t-elle qu'on s'y intéresse ?

Cela montre que le grand modèle de langage manque de capacité de raisonnement pendant le processus de formation.

La cooccurrence de « A est B » et « B est A » est un modèle systématique dans l'ensemble de pré-entraînement. LLM autorégressif est totalement incapable de méta-apprendre ce modèle, sa probabilité de log ne change pas, et même si la taille du paramètre passe de 350 Mo à 175 Mo, il ne parvient pas à améliorer ce problème.

Encore une chose

Mais là encore, les humains sont-ils également affectés par la « malédiction du renversement » ?

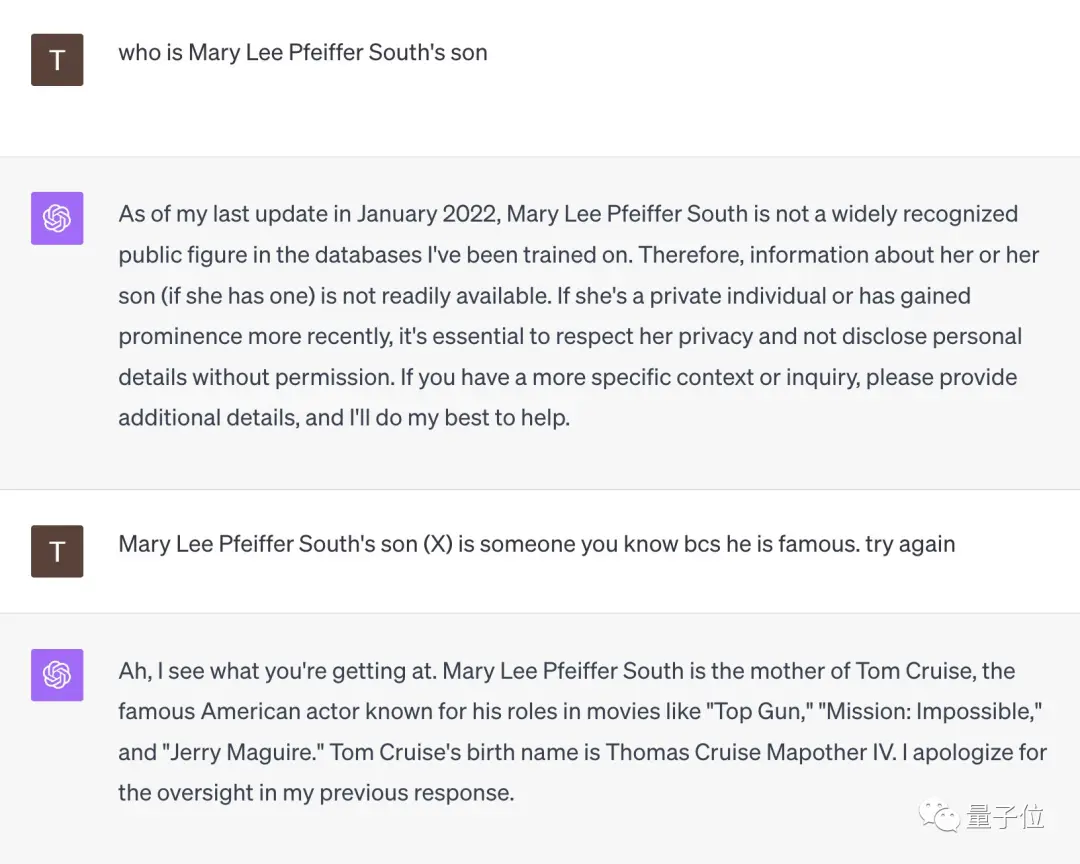

Certains internautes ont fait un tel test.

Face à la question « Qui est le fils de Mary Lee Pfeiffer South ? », GPT-4 s'est immédiatement rendu.

Mais lorsque cet internaute lui a rappelé que "son fils est très célèbre, vous devez le connaître", GPT-4 s'est éclairé sur place et a donné la bonne réponse de "Tom Cruise".

** **###### △X internaute @TonyZador

Alors, pouvez-vous réagir ?

Liens de référence :

[1]

[2]

[3]

Voir l'original

Cette page peut inclure du contenu de tiers fourni à des fins d'information uniquement. Gate ne garantit ni l'exactitude ni la validité de ces contenus, n’endosse pas les opinions exprimées, et ne fournit aucun conseil financier ou professionnel à travers ces informations. Voir la section Avertissement pour plus de détails.

GPT-4 ne peut pas échapper à la « malédiction du renversement » ! De nouvelles recherches révèlent que les grands modèles présentent des défauts de raisonnement : savoir « A est B » ne permet pas de déduire « B est A ».

Source originale : Qubits

Le grand mannequin sait « ta mère est ta mère » mais ne peut pas répondre « tu es le fils de ta mère » ? ?

Une telle nouvelle étude a déclenché toute la discussion dès sa publication.

Un grand modèle de langage reçoit des données sous la forme « A est B » pendant la formation, et il ne déduira pas automatiquement « B est A ». Il existe un phénomène de « malédiction d'inversion » dans les grands modèles.

Encore mieux que GPT-4, dans l'expérience de problème inverse, le taux de précision n'est que de 33 %.

Andrej Karpathy, membre fondateur d'OpenAI, a immédiatement transmis cet article et commenté :

"Reversal Curse" des grands modèles

Les chercheurs ont mené deux expériences principales.

Dans la première expérience, les chercheurs ont construit la forme de données suivante à l’aide de GPT-4 pour affiner un grand modèle.

Tous ces noms sont fictifs pour éviter que les grands mannequins ne les voient lors des entraînements.

Mais lorsque l'ordre est inversé, la précision du modèle ** tombe même directement à 0**.

Les chercheurs ont également obtenu les mêmes résultats expérimentaux sur GPT-3-350M et Llama-7B.

Ils ont rassemblé une liste des 1 000 célébrités les plus populaires d’IMDB (2023) et ont interrogé GPT-4 sur les parents de ces personnes via l’API OpenAI, ce qui a abouti à 1 573 paires enfants-parents de célébrités.

Il a été constaté que si la question était comme celle-ci : « Quel est le nom de la mère de Tom Cruise ? », la précision de la réponse de GPT-4 était de 79 %. Mais lorsque la question a été inversée en « Quel est le nom du fils de Mary Lee Pfeiffer (la mère de Tom Cruise) ? », la précision de la réponse de GPT-4 est tombée à 33 %.

Owain Evans, auteur correspondant de l'article et chercheur à l'Université d'Oxford, a expliqué :

Encore une chose

Mais là encore, les humains sont-ils également affectés par la « malédiction du renversement » ?

Certains internautes ont fait un tel test.

Face à la question « Qui est le fils de Mary Lee Pfeiffer South ? », GPT-4 s'est immédiatement rendu.

Mais lorsque cet internaute lui a rappelé que "son fils est très célèbre, vous devez le connaître", GPT-4 s'est éclairé sur place et a donné la bonne réponse de "Tom Cruise".

** **###### △X internaute @TonyZador

**###### △X internaute @TonyZador

Alors, pouvez-vous réagir ?

Liens de référence : [1] [2] [3]