Cette vague de développement de l’IA a étendu son influence à divers domaines si rapidement qu’elle a effectivement dépassé les attentes de la plupart des gens. La semaine dernière, Sequoia (Sequoia America) a estimé que l'IA avait ouvert son deuxième chapitre et a dessiné une nouvelle carte de l'IA et une nouvelle carte de la pile de développeurs LLM (pile) du point de vue des scénarios d'application.

Cependant, à en juger par l'orientation des fonds, le développement actuel de l'IA semble en être encore au stade des combats entre dieux, et ce modèle semble avoir presque pris forme. Après qu'OpenAI ait reçu près de 11 milliards de dollars de Microsoft et d'autres et ait été évalué à près de 29 milliards de dollars, son concurrent Anthropic a annoncé hier une alliance avec Amazon. Amazon y investira jusqu'à 4 milliards de dollars, plaçant Anthropic au deuxième rang derrière OpenAI. en termes de financement des startups d’IA.

Après ce financement, à l'exception d'Apple, l'industrie de l'IA a essentiellement formé un tel modèle de combat de dieux :

Microsoft + OpenAI

Google + DeepMind

Méta + MétaAI

Amazon + Anthropique

Tesla + xAI

Bien sûr, en tant que fournisseur d'infrastructures de bas niveau, la stratégie de Nvidia est évidemment que tout le monde le veut, et il n'y a pas de position très sérieuse à l'égard d'une entreprise en particulier. Voici une situation générale des 15 licornes d'IA. Du point de vue de la valorisation et du financement, les LLM de grands modèles représentent une grande partie, et 50 % des licornes d'IA ont été créées après 2021 :

Aujourd'hui, a16z a partagé ses conversations avec les fondateurs de plusieurs grandes entreprises d'IA, estimant que nous sommes dans la troisième ère de l'informatique, et a discuté de 16 sujets intéressants du point de vue du présent, de l'avenir et de l'ouverture de l'IA. Les participants à cette conversation comprennent :

Martin Casado, partenaire d'a16z

Mira Murati, directrice technique d'OpenAI

David Baszucki, cofondateur et PDG de Roblox

Dylan Field, cofondateur et PDG de Figma

Cofondateur et PDG d'Anthropic, Dario Amodei

CTO de Microsoft et vice-président exécutif de l'IA Kevin Scott

Daphné Koller, fondatrice et PDG d'insitro

Ali Ghodsi, cofondateur et PDG de Databricks

Noam Shazeer, cofondateur et PDG de Character.AI

Comme l'article est trop long, près de 10 000 mots, j'ai utilisé l'IA pour le compiler brièvement. Certains termes peuvent ne pas être exacts. Les amis intéressés peuvent lire le texte original en anglais :

##1 Nous sommes au début de la troisième ère de l'informatique

Martin Casado,a16z:

Je pense vraiment que nous entrons peut-être dans la troisième ère de l’informatique. Les puces électroniques ont réduit à zéro le coût marginal du calcul, Internet a réduit à zéro le coût marginal de la distribution et, désormais, les grands modèles ont réduit à zéro le coût marginal de la création. Lorsque les époques précédentes se sont produites, vous n’aviez aucune idée des nouvelles entreprises qui seraient créées. Personne n’avait prédit Amazon, personne n’avait prédit Yahoo. Nous devons nous préparer à une nouvelle vague d’entreprises emblématiques. Noam Shazeer, personnage AI :

Nous sommes véritablement à l’époque du « premier avion des frères Wright ». Nous avons déjà quelque chose qui fonctionne et qui est désormais utile pour un grand nombre de scénarios d'application. Il semble que cela évolue très bien et qu’il s’améliorera encore. Mais il y a d’autres avancées à venir, car désormais tous les scientifiques en IA du monde travaillent dur pour améliorer ces choses. Kevin Scott, Microsoft :

Surtout ces dernières années, et peut-être surtout ces 12 derniers mois, avec le lancement de ChatGPT et GPT-4, vous pouvez vraiment voir le potentiel de cette plate-forme pour être la même qu'un PC ou un smartphone. Une gamme de technologies rendra possible une multitude de nouvelles choses, et de nombreuses personnes construiront des choses sur ces nouvelles choses. ## 2 Cette vague d'intelligence artificielle générative repose sur des principes économiques qui favorisent la transformation du marché.

Pour que l’innovation technologique déclenche la transformation du marché, les avantages économiques doivent être très attractifs. Même si de nombreuses avancées technologiques ont été réalisées au cours des cycles précédents de l’IA, elles n’ont pas apporté d’avantages économiques transformateurs. Dans la vague actuelle d’IA, nous constatons déjà les premiers signes d’améliorations économiques de 10 000 fois (ou plus) dans certains cas d’utilisation, et l’adoption et le développement de l’IA qui en résultent semblent être plus rapides que n’importe quel changement précédent.

Martin Casado,a16z:

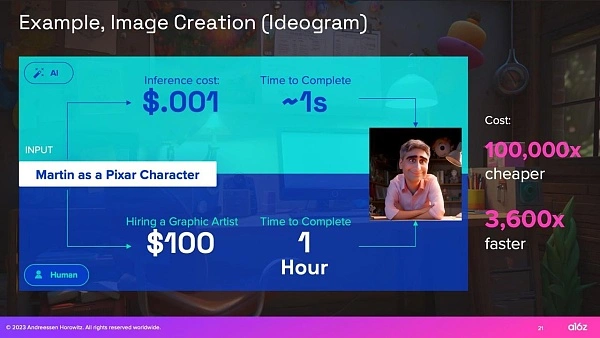

La transformation du marché ne se produit pas par une amélioration économique décuplée. Ils sont créés alors qu’ils sont dix mille fois meilleurs qu’avant. Disons que je veux créer une image qui me transforme en personnage Pixar. Si j'utilise l'un de ces modèles d'image, le coût d'inférence est d'un dixième de centime, et disons que cela prend 1 seconde. Par rapport à l’embauche d’un graphiste, supposons que le taux horaire soit de 100 $. En termes de coût et de temps, vous constaterez une énorme différence de 4 à 5 ordres de grandeur. Pour les économistes, c’est le type de tournant qu’ils recherchent, alors qu’il y a en réalité une énorme perturbation du marché.

Si vous voulez un exemple de la folie que cela peut devenir, je ne vois aucune raison pour laquelle vous ne pourriez pas générer un jeu complet - modèles 3D, personnages, sons, musique, histoire, etc. Les startups font toutes ces choses maintenant, et si vous comparez le coût de centaines de millions de dollars et d’années au coût de quelques dollars, nous avons maintenant une asymétrie économique au niveau d’Internet et des puces électroniques.

3 Pour certains premiers scénarios d'application : Créativité > Exactitude

Les hallucinations sont un problème bien connu avec les LLM à grand modèle d'aujourd'hui, mais pour certaines applications, la capacité d'inventer des choses est une fonctionnalité plutôt qu'un bug. Par rapport aux premiers cas d'utilisation de l'apprentissage automatique appliqué, où l'exactitude à n niveaux est essentielle (par exemple, les voitures autonomes), bon nombre des premiers cas d'utilisation des LLM (amis et compagnons virtuels, concepts de brainstorming ou création de jeux en ligne) sont caractérisés par : se concentrer Dans les domaines où la créativité est plus importante que l'exactitude.

Noam Shazeer, personnage.AI :

Le divertissement représente une industrie de 2 000 milliards de dollars par an. Et le sombre secret est que le divertissement est comme vos amis virtuels inexistants. Il s’agit d’un premier cas d’utilisation intéressant pour l’intelligence artificielle générale. Si vous vouliez lancer un médecin, par exemple, cela serait beaucoup plus lent car il faut faire très, très, très attention à ne pas donner de fausses informations. Mais entre amis, on peut le faire très vite, c'est juste amusant, et inventer devient une fonctionnalité. David Baszucki,Roblox :

Sur les 65 millions d'utilisateurs de Roblox, la plupart ne créent pas au niveau qu'ils souhaiteraient. Pendant longtemps, nous avons imaginé un jeu de simulation Project Runway dans lequel vous pourriez utiliser une machine à coudre et du tissu et tout simuler en 3D, mais même cela était un peu compliqué pour la plupart d'entre nous. Je pense que maintenant, lorsque Project Runway sortira sur Roblox, ce sera une invite texte, une invite image ou une invite vocale. Si je vous aidais à confectionner cette chemise, je dirais : je veux une chemise en jean bleue, des boutons et une coupe plus ajustée. En fait, je pense que nous allons assister à une accélération de la création. Dylan Field, Figma :

À l'heure actuelle, nous sommes à un stade où il est possible pour l'IA de terminer une première ébauche, mais passer de cela au produit final est encore quelque peu difficile et nécessite souvent une équipe pour le faire. Mais si vous parvenez à amener l’IA à suggérer des éléments d’interface aux gens et à le faire d’une manière qui a vraiment du sens, je pense que cela ouvrira une toute nouvelle ère de conception, créant des conceptions contextuelles qui répondent aux intentions de l’utilisateur. Je pense que ce sera une époque fascinante pour tous les concepteurs de travailler en collaboration avec ces systèmes d’intelligence artificielle. ## 4 Pour d'autres exemples, la précision de la programmation "co-pilote" s'améliorera avec l'utilisation humaine.

Alors que l’IA a le potentiel d’augmenter le travail humain dans de nombreux domaines, la programmation de « copilotes » est devenue le premier assistant d’IA largement adopté pour plusieurs raisons :

Premièrement, les développeurs sont souvent les premiers à adopter les nouvelles technologies : une analyse des astuces ChatGPT réalisée en mai/juin 2023 a révélé que 30 % des astuces ChatGPT étaient liées à la programmation. Deuxièmement, les plus grands LLM sont formés sur des ensembles de données riches en code (comme Internet), ce qui les rend particulièrement efficaces pour répondre aux requêtes liées à la programmation. Enfin, les personnes impliquées dans la boucle sont les utilisateurs. Ainsi, même si la précision est importante, un développeur humain avec un copilote IA peut parvenir à l’exactitude plus rapidement qu’un développeur humain seul.

Martin Casado,a16z:

Si vous devez bien faire les choses et qu'il existe de nombreux cas d'utilisation complexes, effectuez tout le travail technique vous-même ou embauchez du personnel. Généralement, nous embauchons des gens. Il s'agit d'un coût variable. Deuxièmement, parce que la liste des solutions est souvent très longue – comme les nombreuses anomalies qui peuvent survenir dans la conduite autonome – l’investissement nécessaire pour garder une longueur d’avance augmente et la valeur diminue. Cela crée un effet d’économie d’échelle inversé.

Cet humain dans la boucle qui se trouvait auparavant dans une entreprise centrale est désormais l'utilisateur. Il ne s'agit donc plus d'un coût variable pour l'entreprise et pour l'économie du coût du travail. La personne dans la boucle a été déplacée, vous pouvez donc faire des choses où l'exactitude est importante, comme développer du code, et comme c'est itératif, la quantité de bugs accumulés est réduite car vous recevez constamment des commentaires et des corrections de la part des utilisateurs. Lorsque les développeurs peuvent interroger un chatbot IA pour les aider à écrire et dépanner du code, cela change la façon dont le développement est effectué de deux manières significatives : 1) Cela facilite le développement pour davantage de personnes. Collaboration car elle se produit via une interface en langage naturel, 2) Développeurs humains. produire plus de produits et les faire circuler plus longtemps.

Mira Murati,OpenAI :

La programmation devient de moins en moins abstraite. Nous pouvons réellement communiquer en langage naturel avec des ordinateurs à large bande passante. Nous utilisons la technologie et elle nous aide à comprendre comment travailler avec elle plutôt que de la « programmer ». Kevin Scott, Microsoft :

GitHub est le premier exemple de ce modèle copilote que nous essayons de construire, qui est le suivant : comment utiliser le travail de connaissances effectué par quelqu'un et utiliser l'IA pour l'aider à être beaucoup plus productif dans l'exécution de types spécifiques de travail cognitif. ? Mieux encore, d'après ce que nous avons observé auprès des développeurs, l'IA les aide à rester dans un état de flux plus longtemps qu'ils ne le feraient autrement.

Ne restez pas bloqué lorsque vous écrivez un morceau de code et pensez : « Je ne sais pas comment faire la prochaine chose. Je dois aller consulter la documentation. Je dois demander à un autre ingénieur qui pourrait travailler sur quelque chose." "Être capable de se libérer du flux avant de sortir de l'état de flux est extrêmement précieux. Pour ceux qui envisagent l’utilité des outils d’IA générative conçus à des fins autres que le développement de logiciels, ce concept d’états de flux est une chose utile à considérer. Dylan Field,Figma:

Les meilleurs concepteurs commencent à réfléchir davantage au code, et les meilleurs développeurs commencent à réfléchir davantage au design. Au-delà des concepteurs et des développeurs, par exemple, si vous pensez aux responsables produits, ils travaillaient peut-être auparavant sur des spécifications, mais ils travaillent désormais davantage sur des maquettes pour communiquer leurs idées plus efficacement. Fondamentalement, cela permettra à tous les membres de l’organisation de passer plus rapidement de l’idée à la conception, et peut-être même à la production. Mais vous devez encore perfectionner chaque étape. Vous avez besoin de quelqu'un pour vraiment réfléchir : "D'accord, quelles idées allons-nous explorer ? Comment allons-nous les explorer ?" Vous allez vouloir peaufiner les conceptions, vous allez vouloir les gérer correctement, de la première ébauche au produit final. ## 5 La combinaison de l'IA et de la biologie pourrait accélérer de nouvelles façons de traiter les maladies et avoir un impact profond sur la santé humaine

La biologie est incroyablement complexe – peut-être même au-delà de la capacité de l’esprit humain à la comprendre pleinement. Cependant, l’intersection de l’IA et de la biologie pourrait accélérer notre compréhension de la biologie et conduire à certaines des avancées technologiques les plus passionnantes et transformatrices de notre époque. Les plateformes biologiques basées sur l’IA ont le potentiel de révéler des connaissances biologiques jusqu’alors inconnues, conduisant à de nouvelles percées médicales, à de nouvelles méthodes de diagnostic et à la capacité de détecter et de traiter les maladies plus tôt, voire même de les prévenir avant qu’elles ne surviennent.

Daphné Koller, insitro:

À certaines époques de notre histoire, certaines disciplines scientifiques ont fait des progrès incroyables en un laps de temps relativement court. Dans les années 1950, la discipline était l’informatique, et nous utilisions ces machines pour effectuer des calculs que seuls les humains pouvaient effectuer jusqu’alors. Puis, dans les années 1990, il y a eu cette divergence intéressante. D’une part, la science des données et les statistiques nous ont finalement apporté l’apprentissage automatique et l’intelligence artificielle modernes. L'autre côté est ce que je considère comme la biologie quantitative, c'est la première fois que nous commençons à mesurer la biologie à une échelle allant au-delà du suivi de 3 gènes dans une expérience qui a duré 5 ans.

Aujourd'hui, 2020 est la dernière fois que les deux disciplines ont véritablement convergé, nous amenant à l'ère de la biologie numérique, la capacité de mesurer la biologie avec une fidélité et une échelle sans précédent ; d'interpréter l'incompréhensible à l'aide d'outils d'apprentissage automatique et de science des données. Des quantités massives de données, différentes à des échelles biologiques et à différents systèmes ; puis en utilisant des outils tels que l'édition du génome CRISPR pour réintégrer cette compréhension dans la biologie technique afin que nous puissions faire faire à la biologie des choses qu'elle n'est pas censée faire.

Aujourd’hui, nous pouvons enfin mesurer la biologie à grande échelle, aux niveaux cellulaire (et parfois subcellulaire) et organisationnel. Cela nous permet, pour la première fois, de déployer l’apprentissage automatique de manière véritablement significative.

Nous avons construit un modèle de langage biologique. C'est comme GPT, mais pour les cellules. Nous connaissons le langage des cellules et à quoi ressemblent les cellules. Vous mesurez des centaines de millions de cellules dans différents états, puis, comme un grand modèle de langage pour le langage naturel, avec une petite quantité de données, vous pouvez commencer à vous demander : « D'accord, comment une maladie déplace-t-elle un gène pathogène d'un environnement à l'autre ? " "Comment le traitement vous fait-il, espérons-le, revenir d'un état de maladie à un état de santé?" C'est super puissant. Comme pour les autres modèles de langage, plus vous lui fournissez de données, meilleur il s’améliore. ## 6 Mettre le modèle entre les mains des utilisateurs nous aidera à découvrir de nouveaux scénarios d'application

Alors que les itérations précédentes de modèles d'IA visaient à surpasser les humains sur certaines tâches, les LLM basés sur Transformer excellent dans le raisonnement général. Mais ce n’est pas parce que nous avons créé un bon modèle général que nous avons compris comment l’appliquer à un cas d’utilisation spécifique. Tout comme il est essentiel d'impliquer les humains dans la boucle sous la forme de RLHF pour améliorer les performances des modèles d'IA actuels, mettre les nouvelles technologies entre les mains des utilisateurs et comprendre comment ils les utilisent seront essentiels pour déterminer les applications à créer en fonction de ces technologies sous-jacentes. modèles.

Kevin Scott, Microsoft :

Il faut le rappeler : le modèle n’est pas le produit. En tant qu'entrepreneur, votre compréhension est la suivante : qui sont vos utilisateurs ? Quel est leur problème ? Que pouvez-vous faire pour les aider ? Déterminez ensuite si l’IA est effectivement une infrastructure utile pour résoudre les problèmes des utilisateurs – c’est une constante. L’intelligence artificielle est comme une nouvelle infrastructure intéressante qui vous permet de résoudre de nouvelles classes de problèmes ou de mieux résoudre d’anciennes classes de problèmes. Mira Murati,OpenAI :

Nous ne savons pas exactement à quoi ressemblera l'avenir, c'est pourquoi nous essayons de mettre ces outils et techniques à la disposition de beaucoup d'autres personnes afin qu'elles puissent expérimenter et que nous puissions voir ce qui se passe. C'est une stratégie que nous utilisons depuis le début. La semaine précédant le lancement de ChatGPT, nous craignions que ce ne soit pas assez performant. Nous avons tous vu ce qui se passe : nous l'avons publié, puis les gens nous disent que c'est suffisant pour découvrir de nouveaux cas d'utilisation, et vous voyez tous ces cas d'utilisation émergents. ## 7 Les souvenirs de vos amis IA s'amélioreront

Alors que les données, les calculs et les paramètres du modèle alimentent le raisonnement général des LLM, les fenêtres contextuelles alimentent leur mémoire à court terme. Les fenêtres contextuelles sont généralement mesurées par le nombre de jetons qu'elles peuvent gérer. Aujourd'hui, la plupart des fenêtres contextuelles font environ 32 Ko, mais des fenêtres contextuelles plus grandes arrivent, et avec elles la possibilité d'exécuter des documents plus volumineux avec plus de contexte via les LLM.

Noam Shazeer,Character.AI :

Actuellement, les modèles que nous proposons utilisent des fenêtres contextuelles de milliers de jetons, ce qui signifie que vos amis de toujours se souviendront de ce qui s'est passé au cours de la dernière demi-heure. Si vous parvenez à divulguer beaucoup d’informations, les choses s’amélioreront. Il devrait pouvoir apprendre un milliard de choses sur vous. La bande passante HBM est là. Dario Amodei,Anthropique :

Une chose qui, à mon avis, est encore sous-estimée est le contexte plus long et les choses qui l'accompagnent. Je pense que les gens ont cette image en tête d’avoir ce chatbot. "Je lui ai posé une question et il a répondu à la question. Mais vous pouvez télécharger un contrat légal et dire : 'Quels sont les cinq termes les plus inhabituels dans ce contrat légal ?' Ou téléchargez un état financier et dites : "Résumé de la situation de cette entreprise. Qu'est-ce qui est surprenant par rapport à ce que cet analyste a dit il y a deux semaines ? Toutes ces connaissances manipulent et traitent d'énormes quantités de données que les gens doivent compter." Je pense que c'est plus probable que ce que font les gens. Nous ne faisons que commencer. " ## 8 Les chatbots vocaux, les robots et d'autres moyens d'interagir avec l'intelligence artificielle sont un domaine de recherche important

Aujourd’hui, la plupart des gens interagissent avec l’intelligence artificielle sous la forme de chatbots, mais c’est parce que les chatbots sont souvent faciles à créer, et non parce qu’ils constituent la meilleure interface pour chaque cas d’utilisation.

De nombreux constructeurs se concentrent sur le développement de nouvelles façons permettant aux utilisateurs d’interagir avec les modèles d’IA via l’IA multimodale. Les utilisateurs pourront interagir avec les modèles multimodaux de la même manière qu’ils interagissent avec le reste du monde : à travers des images, du texte, de la voix et d’autres médias. Pour aller plus loin : l'IA incorporée se concentre sur l'intelligence artificielle qui peut interagir avec le monde physique, comme les voitures autonomes.

Mira Murati,OpenAI :

Je pense que le modèle de base d'aujourd'hui représente bien le monde dans le texte. Nous ajoutons d'autres modalités, comme des images et des vidéos, afin que ces modèles puissent obtenir une image plus complète du monde, similaire à la façon dont nous comprenons et observons le monde. Noam Shazeer,Character.AI :

Peut-être souhaitez-vous entendre une voix, voir un visage ou simplement pouvoir interagir avec plusieurs personnes. C'est comme si vous étiez élu président, que vous aviez des écouteurs et toute une équipe d'amis ou de conseillers. Ou comme si vous entrez dans un « bar amusant » et que tout le monde connaît votre nom et est content que vous soyez venu. Daphné Koller,insitro:

La prochaine frontière possible d’impact de l’IA se situera lorsque l’IA commencera à interagir avec le monde physique. Nous voyons tous à quel point c’est difficile. Nous avons tous vu à quel point il est difficile de construire une voiture autonome par rapport à la construction d’un chatbot, n’est-ce pas ? Nous faisons de grands progrès dans la création de chatbots, et les voitures autonomes bloquent toujours les camions de pompiers à San Francisco. Il est important de comprendre cette complexité, mais aussi l'ampleur de l'impact. ## 9 Aurons-nous des modèles généraux, un ensemble de modèles spécialisés, ou un mélange des deux ?

Quels cas d'utilisation sont les mieux adaptés aux modèles de base plus vastes à « intelligence supérieure » ou aux modèles et ensembles de données spécialisés plus petits ? Tout comme le débat entre architecture cloud et architecture de pointe d'il y a dix ans, la réponse dépend du montant que vous êtes prêt à payer, de la précision dont vous avez besoin pour le résultat et du niveau de latence que vous pouvez tolérer. Les réponses à ces questions peuvent changer au fil du temps, à mesure que les chercheurs développent des méthodes de calcul plus efficaces pour affiner les grands modèles de base pour des cas d'utilisation spécifiques.

À long terme, nous pourrions sur-roter les modèles utilisés pour quels cas d'utilisation, car nous en sommes encore aux premiers stades de la construction de l'infrastructure et de l'architecture nécessaires pour prendre en charge la prochaine vague d'applications d'IA.

Ali Ghodsi, Databricks :

C'est un peu comme en l'an 2000, Internet est sur le point de tout dominer, et tout ce qui compte c'est de savoir qui pourra construire le meilleur routeur. La capitalisation boursière de Cisco a culminé à 5 000 milliards de dollars américains en 2000, dépassant alors celle de Microsoft. Alors, qui a le plus grand LLM (modèle linguistique) ? De toute évidence, celui qui parviendra à construire le plus grand et à l’entraîner pleinement aura le contrôle de toute l’IA et des futurs humains. Mais tout comme Internet, quelqu’un d’autre proposera plus tard des idées comme Uber et la conduite de taxi. Il y aura d'autres personnes qui penseront : « Hé, je veux voir ce que font mes amis sur Facebook. » Cela peut être d'énormes opportunités commerciales, et ce ne sont pas seulement des entreprises comme OpenAI, Databricks ou Anthropic qui peuvent construire un modèle. scénarios. Il faut beaucoup d'efforts pour créer un médecin en qui vous avez confiance. Dario Amodei,Anthropique :

Le facteur le plus important est d’investir plus d’argent. Les modèles les plus chers fabriqués aujourd’hui coûtent environ 100 millions de dollars, plus ou moins un ordre de grandeur. L’année prochaine, nous verrons peut-être des modèles de plusieurs acteurs valant environ 1 milliard de dollars, et d’ici 2025, nous verrons des modèles se chiffrant en milliards, voire 10 milliards de dollars. Cette différence 100x est combinée au fait que les calculs du H100 eux-mêmes deviennent plus rapides - un saut particulièrement important en raison d'une précision réduite. Mettez tous ces facteurs ensemble et si les lois de la mise à l’échelle continuent de s’appliquer, les capacités augmenteront considérablement. Mira Murati, OpenAI :

Cela dépend de ce que vous voulez faire. Il est clair que les systèmes d’IA assumeront de plus en plus les tâches que nous effectuons. En ce qui concerne la plateforme OpenAI, vous pouvez constater qu'aujourd'hui encore, nous proposons de nombreux modèles via l'API, des très petits modèles aux modèles de pointe. Il n’est pas toujours nécessaire d’utiliser le modèle le plus puissant ou le plus compétent. Parfois, ils ont simplement besoin d’un modèle adapté à leur cas d’utilisation spécifique et plus rentable. Nous voulons que les gens s'appuient sur notre modèle et leur donnent les outils pour faciliter ce processus. Nous souhaitons leur donner de plus en plus d'accès et de contrôle afin que vous puissiez apporter vos propres données et personnaliser ces modèles. Il faut vraiment se concentrer sur des choses qui dépassent le cadre du modèle et définir le produit. David Baszucki, Roblox :

Dans toute entreprise comme Roblox, il existe probablement 20 ou 30 applications verticales pour utilisateurs finaux qui sont très personnalisées - le filtrage du langage naturel est très différent de la génération de 3D - et chez l'utilisateur final, nous voulons que toutes ces applications s'exécutent. Au fur et à mesure que nous descendons [la pile], dans une entreprise comme la nôtre, il peut y avoir un regroupement naturel de 2 ou 3 modèles de type plus grands et plus gros. Nous avons réglé très finement les disciplines dans lesquelles nous souhaitons pouvoir former et effectuer de nombreuses inférences pour ces disciplines. ## 10 Quand l'IA sera-t-elle suffisamment adoptée dans l'entreprise, qu'arrive-t-il à ces ensembles de données ?

L’impact de l’IA générative sur les entreprises en est encore à ses balbutiements – en partie parce que les entreprises sont généralement plus lentes à évoluer, et en partie parce qu’elles ont pris conscience de la valeur de leurs ensembles de données propriétaires et ne souhaitent pas nécessairement les transmettre à une autre entreprise. Quelle que soit la puissance de leur modèle. La plupart des cas d'utilisation en entreprise nécessitent un haut degré de précision, et les entreprises disposent de 3 options pour choisir le LLM : créer leur propre LLM, utiliser un fournisseur de services LLM pour le créer pour elles, ou affiner le modèle sous-jacent - créer votre propre LLM n'est pas une tâche facile. facile.

Ali Ghosdi, Databricks:

Une chose qui arrive dans l’esprit des PDG et des conseils d’administration, c’est qu’ils se rendent compte : peut-être que je peux battre mes concurrents. C'est peut-être la kryptonite qui tue vos ennemis. J'ai les données pour l'IA générative, alors ils pensent : « Je dois les construire moi-même. » Je dois posséder la propriété intellectuelle. Voulez-vous créer votre propre LLM à partir de zéro ? Ce n'est pas anodin, nécessite toujours beaucoup de GPU, coûte beaucoup d'argent et dépend de votre ensemble de données et de votre cas d'utilisation.

Nous avons beaucoup de clients qui souhaitent un modèle moins cher, plus petit et spécialement conçu, offrant une précision et des performances très élevées. Ils disent : " Hé, c'est ce que je veux faire. Je veux obtenir une bonne classification à partir de ces images de ce défaut particulier dans le processus de fabrication. " La précision est ici importante. Chaque once de précision que vous pouvez me donner compte. Là, vous serez mieux loti si vous disposez d'un bon ensemble de données sur lequel vous entraîner et si vous pouvez entraîner un modèle plus petit. La latence sera plus rapide, moins chère et oui, vous pouvez absolument avoir une précision qui bat les très gros modèles. Mais le modèle que vous construisez ne vous divertira pas le week-end et n'aidera pas vos enfants à faire leurs devoirs. ## 11 La loi de la mise à l'échelle nous mènera-t-elle jusqu'à l'AGI ?

LLM suit actuellement la loi du Scaling : les performances du modèle s'améliorent à mesure que vous ajoutez plus de données et de calculs, même si l'architecture et les algorithmes restent les mêmes. Mais combien de temps cette règle peut-elle durer ? Est-ce que cela va continuer indéfiniment, ou va-t-il atteindre ses limites naturelles avant que nous développions l’AGI ?

Mira Murati, OpenAI :

Rien ne prouve que nous n’obtiendrons pas de modèles meilleurs et plus puissants à mesure que nous continuons à élargir l’accès aux données et au calcul. Que cela vous mène jusqu'à l'AGI, c'est une autre question. D'autres percées et avancées seront peut-être nécessaires en cours de route, mais je pense qu'il reste encore un long chemin à parcourir en termes de lois de mise à l'échelle et de véritablement tirer de nombreux avantages de ces modèles plus grands. Dario Amodei, Anthropique:

Même s’il n’y a pas d’améliorations algorithmiques ici et que nous nous contentons d’évoluer là où nous en sommes jusqu’à présent, la loi de la mise à l’échelle continuera. Noam Shazeer, personnage.AI :

Notre objectif est d'être une entreprise AGI et une entreprise axée sur les produits, et la façon d'y parvenir est de choisir les bons produits, de nous obliger à faire des choses généralisables, de rendre les modèles plus intelligents, d'en faire quelque chose que les gens veulent, et de livrer services à moindre coût et à grande échelle. La loi de la mise à l’échelle nous mènera loin. En fait, le calcul n’est pas si coûteux. Aujourd'hui, les coûts d'exploitation se situent entre 10 et 18 dollars. Si vous pouvez faire ces choses efficacement, le coût devrait être bien inférieur à la valeur de votre temps. La capacité est là pour étendre ces choses par ordres de grandeur. ## 12 Quelles sont les capacités émergentes ?

Alors que certaines personnes s’empressent d’écarter la capacité de générer de l’intelligence artificielle, l’intelligence artificielle est déjà bien meilleure que les humains pour accomplir certaines tâches et continuera de s’améliorer. Les meilleurs constructeurs ont été capables d’identifier les capacités émergentes les plus prometteuses de l’IA et de créer des modèles et des entreprises qui transforment ces capacités en capacités fiables. Ils reconnaissent que l’échelle tend à accroître la fiabilité des capacités émergentes.

Mira Murati, OpenAI :

Il est important de prêter attention à ces fonctionnalités émergentes, même si elles sont très peu fiables. Surtout pour ceux qui créent des entreprises aujourd'hui, il faut vraiment réfléchir à la question : "D'accord, qu'est-ce qui est possible aujourd'hui ? Que voyez-vous aujourd'hui ?" Parce que très rapidement, ces modèles vont devenir fiables. Dario Amodei, Anthropique :

Lorsque nous avons publié GPT-2, ce qui était considéré comme le plus impressionnant à l'époque était : « Vous introduisez ces cinq exemples de traduction de l'anglais vers le français directement dans le modèle linguistique, puis vous introduisez la sixième phrase en anglais, et cela se traduirait en français. " C'était comme oh mon Dieu, il comprend ce modèle. " C'était fou pour nous, même si c'était une mauvaise traduction. Mais notre point de vue est : « Écoutez, ce n'est que le début d'un voyage incroyable car il n'y a pas de limites et il peut continuer à évoluer. » Pourquoi ces modèles que nous avons vus auparavant ne peuvent-ils pas continuer à exister ? Il y a tellement d'objectifs pour prédire le mot suivant, et il y a tellement de choses avec lesquelles vous pouvez les défier, que cela fonctionne définitivement. Et puis certaines personnes l'ont regardé et ont dit : « Vous avez créé un très mauvais outil de traduction de robot. » ## 13 Le coût de service de ces modèles va-t-il baisser ?

Les coûts de calcul sont l’une des principales limites à la mise à l’échelle de ces modèles, et la pénurie actuelle de puces fait grimper les coûts en limitant l’offre. Cependant, si Nvidia produit davantage de H100 l’année prochaine, cela devrait atténuer la pénurie de GPU et potentiellement réduire les coûts de calcul.

Noam Shazeer, personnage.AI :

L'année dernière, la formation du modèle que nous proposons a nécessité environ 2 millions de dollars en cycles de calcul, et nous allons probablement recommencer pour un demi-million de dollars. Nous allons donc déployer des dizaines de points de QI plus intelligents avant la fin de l'année. Je vois ces choses se développer massivement. Mais pas si cher que ça. Je pense avoir vu hier un article selon lequel Nvidia allait fabriquer un autre 1,5 million de H100 l'année prochaine, ce qui serait le 2 millions de H100.

Cela représente environ un quart de billion d’opérations par seconde et par personne. Cela signifie que pour chaque personne sur la planète, sur un modèle comportant 100 milliards de paramètres, il pourrait traiter 1 mot par seconde. Mais tout le monde n’y a pas accès, donc ce n’est pas si cher. Cette chose est très évolutive si vous le faites correctement, et nous travaillons dur pour y parvenir. Dario Amodei, Anthropique:

Mon point fondamental est que l’inférence ne coûtera pas si cher. La logique de base de la loi de Scaling est que si vous augmentez le calcul d'un facteur n, vous devez augmenter les données d'un facteur de racine carrée de n et la taille du modèle d'un facteur de racine carrée de n. Cette racine carrée signifie essentiellement que le modèle lui-même ne s'agrandira pas et que le matériel deviendra plus rapide au fur et à mesure que vous le ferez. Je pense que ces choses continueront d’être pertinentes au cours des 3 ou 4 prochaines années. Sans innovation architecturale, ils deviennent un peu plus chers. S’il y a de l’innovation architecturale, et j’espère qu’il y en aura, elles deviendront moins chères. Mais même si les coûts de calcul restent constants, des améliorations de l’efficacité au niveau du modèle semblent inévitables, surtout avec autant de talents affluant dans le domaine, et l’IA elle-même pourrait être notre outil le plus puissant pour améliorer le fonctionnement de l’IA.

Dario Amodei, Anthropique:

À mesure que l’IA devient plus puissante, elle est plus performante dans la plupart des tâches cognitives. Une tâche cognitive connexe consiste à évaluer la sécurité des systèmes d’intelligence artificielle et, à terme, à mener des recherches sur la sécurité. Il y a une composante autoréférentielle à cela. Nous pouvons le constater en lisant à l’intérieur des réseaux neuronaux, comme dans le domaine de l’interprétabilité. Des systèmes d’IA puissants peuvent nous aider à interpréter l’activité neuronale dans des systèmes d’IA plus faibles. Et ces informations sur l’interprétabilité nous indiquent souvent comment fonctionne le modèle. Lorsqu’ils nous expliquent comment fonctionne un modèle, ils suggèrent souvent des moyens de l’améliorer ou de le rendre plus efficace. L’un des domaines de recherche les plus prometteurs consiste à affiner de grands modèles pour des cas d’utilisation spécifiques sans exécuter l’intégralité du modèle.

Ali Ghodsi, Databricks :

Si vous créiez mille versions de LLM qui soient bonnes dans mille choses différentes, et que vous deviez charger chacune d'elles sur le GPU et la servir, cela coûterait très cher. La grande chose que tout le monde recherche en ce moment est la suivante : existe-t-il une technique qui peut donner de très bons résultats avec seulement des modifications mineures ? Il existe de nombreuses technologies telles que le réglage des préfixes, LoRA, CUBE LoRA, etc. Mais aucune solution véritablement parfaite n’a fait ses preuves. Mais quelqu'un le trouvera. ## 14 Comment mesurer les progrès vers l’intelligence artificielle générale ?

Lorsqu’on étend ces modèles, comment savoir quand une IA devient une intelligence artificielle générale ? Lorsque nous entendons souvent le terme AGI, il peut être difficile à définir, peut-être en partie parce qu'il est difficile à mesurer.

Les références quantitatives telles que GLUE et SUPERGLUE sont utilisées depuis longtemps comme mesures standardisées pour mesurer les performances des modèles d'IA. Mais à l'instar des tests standardisés que nous soumettons aux humains, les tests d'IA soulèvent la question suivante : dans quelle mesure mesurez-vous la capacité de raisonnement d'un LLM et dans quelle mesure mesurez-vous sa capacité à réussir un test ?

Ali Ghodsi, Databricks:

J'ai un peu l'impression que tous les benchmarks sont des conneries. Imaginez si toutes nos universités disaient : « Nous allons vous donner les réponses à examiner la veille de l'examen. Et puis le lendemain, nous allons vous demander de répondre aux questions et de les faire noter. » , tout le monde pouvait facilement réussir l'examen.

Par exemple, MMLU est la référence que de nombreuses personnes utilisent pour évaluer ces modèles. MMLU n'est qu'une question à choix multiples sur Internet. Posez une question, la réponse est-elle A, B, C, D ou E ? Ensuite, il vous dira la bonne réponse. Il peut être formé en ligne et créer un modèle LLM capable de le battre. Le test qualitatif original pour l’AGI était le test de Turing, mais convaincre les humains qu’une IA est humaine n’est pas un problème difficile. Amener l’intelligence artificielle à faire ce que font les humains dans le monde réel est un problème difficile. Alors, quels tests pouvons-nous utiliser pour comprendre la fonctionnalité de ces systèmes ?

Dylan Field, Figma:

Ce que nous constatons aujourd’hui avec ces systèmes, c’est qu’il est facile de faire croire aux gens que vous êtes humain, mais qu’il est difficile de réellement faire de bonnes choses. Je peux demander à GPT-4 d'élaborer un plan d'affaires et de vous le vendre, mais cela ne signifie pas que vous investirez. Lorsque vous avez en fait deux entreprises concurrentes – une dirigée par l’IA et l’autre dirigée par des humains – et que vous choisissez d’investir dans le secteur de l’IA, cela m’inquiète. David Baszucki, Roblox :

J'ai une question de test de Turing pour une IA : si nous placions une IA en 1633 et la laissions s'entraîner sur toutes les informations disponibles à cette époque, prédirait-elle si la Terre ou le Soleil était le centre du système solaire - même bien que 99,9 % des informations disent que la Terre est le centre du système solaire ? Je pense que 5 ans, c'est juste à la limite, mais si nous faisions ce test d'IA Turing dans 10 ans, cela dirait probablement le soleil. ## 15 Les humains ont-ils encore besoin de participer ?

Les nouvelles technologies remplacent souvent certains emplois et emplois humains, mais elles ouvrent également des domaines entièrement nouveaux, augmentent la productivité et rendent davantage de types d'emplois accessibles à un plus grand nombre de personnes. S’il est facile d’imaginer l’IA automatiser des tâches existantes, il est beaucoup plus difficile d’imaginer les prochains problèmes et possibilités qu’elle apportera.

Martin Casado, a16z :

En termes très simples, le paradoxe de Jevons déclare : Si la demande est élastique et que les prix baissent, la demande dépassera la compensation. Souvent, c'est bien plus que compensé. Cela s’applique certainement à Internet. Vous obtenez plus de valeur et plus de productivité. Personnellement, je crois que la demande est élastique lorsqu’il s’agit d’automatiser n’importe quel actif ou travail créatif. Plus nous gagnons, plus les gens consomment. Nous attendons avec impatience une expansion massive de la productivité, une pléthore de nouveaux emplois et de nombreuses nouveautés, tout comme nous l’avons vu à l’ère des puces électroniques et d’Internet. Kevin Scott, Microsoft :

J'ai grandi dans une région rurale du centre de la Virginie, où l'économie reposait principalement sur la culture du tabac, la fabrication de meubles et l'industrie textile. Quand j’ai obtenu mon diplôme d’études secondaires, les trois industries venaient de s’effondrer. Lorsque les habitants de ces communautés ont accès à des outils incroyablement puissants, ils accomplissent souvent des choses extraordinaires, créant ainsi des opportunités économiques pour eux-mêmes, leurs familles et leurs communautés. Ils résolvent des problèmes que vous ou moi ne pouvons pas résoudre parce que nous ne voyons pas l’ensemble des problèmes du monde. Nous n'avons pas leur point de vue. Ces outils d’IA sont désormais plus faciles à utiliser que jamais. Vous pouvez désormais faire des choses intéressantes avec ces outils et devenir entrepreneur dans une petite ville de Virginie sans avoir un doctorat en informatique ni une expertise en intelligence artificielle classique. Il faut juste rester curieux et entreprenant. Dylan Field, Figma :

Si vous examinez chaque changement technologique ou changement de plate-forme à ce jour, cela a donné lieu à davantage de choses à concevoir. Il y a une presse à imprimer, et ensuite vous devez déterminer quoi mettre sur la page. Récemment, avec l'Internet mobile, on pourrait penser : « Eh bien, il y a moins de pixels, il y a moins de designers. » Mais ce n'est pas le cas, c'est à ce moment-là qu'on a assisté à la plus grande explosion du nombre de designers. ## 16 Il n'y a jamais eu de moment plus excitant pour créer une startup d'IA (surtout si vous êtes physicien ou mathématicien)

Nous vivons une période unique et passionnante pour développer l’intelligence artificielle : les modèles sous-jacents évoluent rapidement, l’économie penche enfin en faveur des startups et il y a de nombreux problèmes à résoudre. Ces problèmes nécessitent beaucoup de patience et de persévérance pour être résolus, et les physiciens et les mathématiciens ont jusqu'à présent été particulièrement bien placés pour les résoudre. Mais en tant que domaine jeune et en croissance rapide, l’IA est grand ouvert et c’est le moment idéal pour la développer.

Dario Amodei, Anthropique:

À tout moment, il existe deux types de domaines. L'un est un domaine où l'expérience et les connaissances accumulées sont très riches, et il faut de nombreuses années pour devenir un expert. La biologie est un exemple classique : si vous n'y travaillez que pendant 6 mois, il est très difficile de réaliser des travaux révolutionnaires ou de niveau Nobel... L'autre est un domaine très jeune ou qui se développe très rapidement. L’intelligence artificielle était, et est encore dans une certaine mesure, l’une de ces catégories. Les généralistes vraiment talentueux peuvent souvent surpasser les personnes qui travaillent dans le domaine depuis longtemps parce que les choses changent si rapidement. Au contraire, avoir beaucoup de connaissances préalables peut être un inconvénient. Mira Murati, OpenAI :

Ce qu’il faut retenir de l’espace théorique des mathématiques, c’est qu’il faut passer beaucoup de temps à réfléchir aux problèmes. Parfois, vous vous endormez et vous vous réveillez avec de nouvelles idées, trouvant progressivement votre solution finale au fil des jours ou des semaines. Ce n’est pas un processus avec des retours rapides, et parfois ce n’est pas une chose itérative. C'est presque une façon de penser différente, dans laquelle vous développez l'intuition et la discipline nécessaires pour faire face à un problème et vous faites confiance pour le résoudre. Au fil du temps, vous développerez une intuition quant aux problèmes sur lesquels il vaut vraiment la peine de travailler. Daphné Koller, intro:

Non seulement l’apprentissage automatique s’améliore avec le temps, mais les outils biologiques sur lesquels nous comptons le sont également. Dans le passé, il n’existait pas de technologie CRISPR, seulement des siRNA. Puis est arrivée la technologie d’édition génétique CRISPR, et il existe désormais la technologie CRISPR prime qui peut remplacer des régions génomiques entières. En conséquence, les outils que nous construisons s’améliorent de plus en plus, ce qui nous ouvre la possibilité de lutter contre davantage de maladies de manière plus significative. De nombreuses opportunités existent à l’intersection de l’intelligence artificielle/apprentissage automatique et des domaines de la biologie et de la médecine. Cette convergence est un moment qui nous permet d’avoir un impact énorme sur le monde dans lequel nous vivons, en utilisant des outils qui existent aujourd’hui mais qui n’existaient pas il y a cinq ans. Kevin Scott, Microsoft :

Si vous pensez à certains des grands changements de plateforme qui ont eu lieu dans le passé, les éléments les plus précieux sur ces plateformes n'étaient pas ceux qui ont été déployés au cours des deux premières années du changement de plateforme. Si vous pensez à l'endroit où vous passez le plus de temps sur votre smartphone, ce n'est pas une application de messagerie, ni un navigateur Web, ni un client de messagerie. Il s’agit plutôt de quelque chose de nouveau qui est créé quelques années après que la plateforme soit disponible.

Quelles choses qui étaient impossibles auparavant sont désormais possibles ? C'est à cela que les gens devraient penser. Ne poursuivez pas des choses insignifiantes.

Voir l'original

Cette page peut inclure du contenu de tiers fourni à des fins d'information uniquement. Gate ne garantit ni l'exactitude ni la validité de ces contenus, n’endosse pas les opinions exprimées, et ne fournit aucun conseil financier ou professionnel à travers ces informations. Voir la section Avertissement pour plus de détails.

a16z Article de 10 000 mots : Nous entrons dans la troisième ère de l'informatique

Cette vague de développement de l’IA a étendu son influence à divers domaines si rapidement qu’elle a effectivement dépassé les attentes de la plupart des gens. La semaine dernière, Sequoia (Sequoia America) a estimé que l'IA avait ouvert son deuxième chapitre et a dessiné une nouvelle carte de l'IA et une nouvelle carte de la pile de développeurs LLM (pile) du point de vue des scénarios d'application.

Cependant, à en juger par l'orientation des fonds, le développement actuel de l'IA semble en être encore au stade des combats entre dieux, et ce modèle semble avoir presque pris forme. Après qu'OpenAI ait reçu près de 11 milliards de dollars de Microsoft et d'autres et ait été évalué à près de 29 milliards de dollars, son concurrent Anthropic a annoncé hier une alliance avec Amazon. Amazon y investira jusqu'à 4 milliards de dollars, plaçant Anthropic au deuxième rang derrière OpenAI. en termes de financement des startups d’IA.

Après ce financement, à l'exception d'Apple, l'industrie de l'IA a essentiellement formé un tel modèle de combat de dieux :

Bien sûr, en tant que fournisseur d'infrastructures de bas niveau, la stratégie de Nvidia est évidemment que tout le monde le veut, et il n'y a pas de position très sérieuse à l'égard d'une entreprise en particulier. Voici une situation générale des 15 licornes d'IA. Du point de vue de la valorisation et du financement, les LLM de grands modèles représentent une grande partie, et 50 % des licornes d'IA ont été créées après 2021 :

Aujourd'hui, a16z a partagé ses conversations avec les fondateurs de plusieurs grandes entreprises d'IA, estimant que nous sommes dans la troisième ère de l'informatique, et a discuté de 16 sujets intéressants du point de vue du présent, de l'avenir et de l'ouverture de l'IA. Les participants à cette conversation comprennent :

Comme l'article est trop long, près de 10 000 mots, j'ai utilisé l'IA pour le compiler brièvement. Certains termes peuvent ne pas être exacts. Les amis intéressés peuvent lire le texte original en anglais :

##1 Nous sommes au début de la troisième ère de l'informatique

Martin Casado,a16z:

Je pense vraiment que nous entrons peut-être dans la troisième ère de l’informatique. Les puces électroniques ont réduit à zéro le coût marginal du calcul, Internet a réduit à zéro le coût marginal de la distribution et, désormais, les grands modèles ont réduit à zéro le coût marginal de la création. Lorsque les époques précédentes se sont produites, vous n’aviez aucune idée des nouvelles entreprises qui seraient créées. Personne n’avait prédit Amazon, personne n’avait prédit Yahoo. Nous devons nous préparer à une nouvelle vague d’entreprises emblématiques. Noam Shazeer, personnage AI :

Nous sommes véritablement à l’époque du « premier avion des frères Wright ». Nous avons déjà quelque chose qui fonctionne et qui est désormais utile pour un grand nombre de scénarios d'application. Il semble que cela évolue très bien et qu’il s’améliorera encore. Mais il y a d’autres avancées à venir, car désormais tous les scientifiques en IA du monde travaillent dur pour améliorer ces choses. Kevin Scott, Microsoft :

Surtout ces dernières années, et peut-être surtout ces 12 derniers mois, avec le lancement de ChatGPT et GPT-4, vous pouvez vraiment voir le potentiel de cette plate-forme pour être la même qu'un PC ou un smartphone. Une gamme de technologies rendra possible une multitude de nouvelles choses, et de nombreuses personnes construiront des choses sur ces nouvelles choses. ## 2 Cette vague d'intelligence artificielle générative repose sur des principes économiques qui favorisent la transformation du marché.

Pour que l’innovation technologique déclenche la transformation du marché, les avantages économiques doivent être très attractifs. Même si de nombreuses avancées technologiques ont été réalisées au cours des cycles précédents de l’IA, elles n’ont pas apporté d’avantages économiques transformateurs. Dans la vague actuelle d’IA, nous constatons déjà les premiers signes d’améliorations économiques de 10 000 fois (ou plus) dans certains cas d’utilisation, et l’adoption et le développement de l’IA qui en résultent semblent être plus rapides que n’importe quel changement précédent.

Martin Casado,a16z:

La transformation du marché ne se produit pas par une amélioration économique décuplée. Ils sont créés alors qu’ils sont dix mille fois meilleurs qu’avant. Disons que je veux créer une image qui me transforme en personnage Pixar. Si j'utilise l'un de ces modèles d'image, le coût d'inférence est d'un dixième de centime, et disons que cela prend 1 seconde. Par rapport à l’embauche d’un graphiste, supposons que le taux horaire soit de 100 $. En termes de coût et de temps, vous constaterez une énorme différence de 4 à 5 ordres de grandeur. Pour les économistes, c’est le type de tournant qu’ils recherchent, alors qu’il y a en réalité une énorme perturbation du marché. Si vous voulez un exemple de la folie que cela peut devenir, je ne vois aucune raison pour laquelle vous ne pourriez pas générer un jeu complet - modèles 3D, personnages, sons, musique, histoire, etc. Les startups font toutes ces choses maintenant, et si vous comparez le coût de centaines de millions de dollars et d’années au coût de quelques dollars, nous avons maintenant une asymétrie économique au niveau d’Internet et des puces électroniques.

3 Pour certains premiers scénarios d'application : Créativité > Exactitude

Les hallucinations sont un problème bien connu avec les LLM à grand modèle d'aujourd'hui, mais pour certaines applications, la capacité d'inventer des choses est une fonctionnalité plutôt qu'un bug. Par rapport aux premiers cas d'utilisation de l'apprentissage automatique appliqué, où l'exactitude à n niveaux est essentielle (par exemple, les voitures autonomes), bon nombre des premiers cas d'utilisation des LLM (amis et compagnons virtuels, concepts de brainstorming ou création de jeux en ligne) sont caractérisés par : se concentrer Dans les domaines où la créativité est plus importante que l'exactitude.

Noam Shazeer, personnage.AI :

Le divertissement représente une industrie de 2 000 milliards de dollars par an. Et le sombre secret est que le divertissement est comme vos amis virtuels inexistants. Il s’agit d’un premier cas d’utilisation intéressant pour l’intelligence artificielle générale. Si vous vouliez lancer un médecin, par exemple, cela serait beaucoup plus lent car il faut faire très, très, très attention à ne pas donner de fausses informations. Mais entre amis, on peut le faire très vite, c'est juste amusant, et inventer devient une fonctionnalité. David Baszucki,Roblox :

Sur les 65 millions d'utilisateurs de Roblox, la plupart ne créent pas au niveau qu'ils souhaiteraient. Pendant longtemps, nous avons imaginé un jeu de simulation Project Runway dans lequel vous pourriez utiliser une machine à coudre et du tissu et tout simuler en 3D, mais même cela était un peu compliqué pour la plupart d'entre nous. Je pense que maintenant, lorsque Project Runway sortira sur Roblox, ce sera une invite texte, une invite image ou une invite vocale. Si je vous aidais à confectionner cette chemise, je dirais : je veux une chemise en jean bleue, des boutons et une coupe plus ajustée. En fait, je pense que nous allons assister à une accélération de la création. Dylan Field, Figma :

À l'heure actuelle, nous sommes à un stade où il est possible pour l'IA de terminer une première ébauche, mais passer de cela au produit final est encore quelque peu difficile et nécessite souvent une équipe pour le faire. Mais si vous parvenez à amener l’IA à suggérer des éléments d’interface aux gens et à le faire d’une manière qui a vraiment du sens, je pense que cela ouvrira une toute nouvelle ère de conception, créant des conceptions contextuelles qui répondent aux intentions de l’utilisateur. Je pense que ce sera une époque fascinante pour tous les concepteurs de travailler en collaboration avec ces systèmes d’intelligence artificielle. ## 4 Pour d'autres exemples, la précision de la programmation "co-pilote" s'améliorera avec l'utilisation humaine.

Alors que l’IA a le potentiel d’augmenter le travail humain dans de nombreux domaines, la programmation de « copilotes » est devenue le premier assistant d’IA largement adopté pour plusieurs raisons :

Premièrement, les développeurs sont souvent les premiers à adopter les nouvelles technologies : une analyse des astuces ChatGPT réalisée en mai/juin 2023 a révélé que 30 % des astuces ChatGPT étaient liées à la programmation. Deuxièmement, les plus grands LLM sont formés sur des ensembles de données riches en code (comme Internet), ce qui les rend particulièrement efficaces pour répondre aux requêtes liées à la programmation. Enfin, les personnes impliquées dans la boucle sont les utilisateurs. Ainsi, même si la précision est importante, un développeur humain avec un copilote IA peut parvenir à l’exactitude plus rapidement qu’un développeur humain seul.

Martin Casado,a16z:

Si vous devez bien faire les choses et qu'il existe de nombreux cas d'utilisation complexes, effectuez tout le travail technique vous-même ou embauchez du personnel. Généralement, nous embauchons des gens. Il s'agit d'un coût variable. Deuxièmement, parce que la liste des solutions est souvent très longue – comme les nombreuses anomalies qui peuvent survenir dans la conduite autonome – l’investissement nécessaire pour garder une longueur d’avance augmente et la valeur diminue. Cela crée un effet d’économie d’échelle inversé. Cet humain dans la boucle qui se trouvait auparavant dans une entreprise centrale est désormais l'utilisateur. Il ne s'agit donc plus d'un coût variable pour l'entreprise et pour l'économie du coût du travail. La personne dans la boucle a été déplacée, vous pouvez donc faire des choses où l'exactitude est importante, comme développer du code, et comme c'est itératif, la quantité de bugs accumulés est réduite car vous recevez constamment des commentaires et des corrections de la part des utilisateurs. Lorsque les développeurs peuvent interroger un chatbot IA pour les aider à écrire et dépanner du code, cela change la façon dont le développement est effectué de deux manières significatives : 1) Cela facilite le développement pour davantage de personnes. Collaboration car elle se produit via une interface en langage naturel, 2) Développeurs humains. produire plus de produits et les faire circuler plus longtemps.

Mira Murati,OpenAI :

La programmation devient de moins en moins abstraite. Nous pouvons réellement communiquer en langage naturel avec des ordinateurs à large bande passante. Nous utilisons la technologie et elle nous aide à comprendre comment travailler avec elle plutôt que de la « programmer ». Kevin Scott, Microsoft :

GitHub est le premier exemple de ce modèle copilote que nous essayons de construire, qui est le suivant : comment utiliser le travail de connaissances effectué par quelqu'un et utiliser l'IA pour l'aider à être beaucoup plus productif dans l'exécution de types spécifiques de travail cognitif. ? Mieux encore, d'après ce que nous avons observé auprès des développeurs, l'IA les aide à rester dans un état de flux plus longtemps qu'ils ne le feraient autrement. Ne restez pas bloqué lorsque vous écrivez un morceau de code et pensez : « Je ne sais pas comment faire la prochaine chose. Je dois aller consulter la documentation. Je dois demander à un autre ingénieur qui pourrait travailler sur quelque chose." "Être capable de se libérer du flux avant de sortir de l'état de flux est extrêmement précieux. Pour ceux qui envisagent l’utilité des outils d’IA générative conçus à des fins autres que le développement de logiciels, ce concept d’états de flux est une chose utile à considérer. Dylan Field,Figma:

Les meilleurs concepteurs commencent à réfléchir davantage au code, et les meilleurs développeurs commencent à réfléchir davantage au design. Au-delà des concepteurs et des développeurs, par exemple, si vous pensez aux responsables produits, ils travaillaient peut-être auparavant sur des spécifications, mais ils travaillent désormais davantage sur des maquettes pour communiquer leurs idées plus efficacement. Fondamentalement, cela permettra à tous les membres de l’organisation de passer plus rapidement de l’idée à la conception, et peut-être même à la production. Mais vous devez encore perfectionner chaque étape. Vous avez besoin de quelqu'un pour vraiment réfléchir : "D'accord, quelles idées allons-nous explorer ? Comment allons-nous les explorer ?" Vous allez vouloir peaufiner les conceptions, vous allez vouloir les gérer correctement, de la première ébauche au produit final. ## 5 La combinaison de l'IA et de la biologie pourrait accélérer de nouvelles façons de traiter les maladies et avoir un impact profond sur la santé humaine

La biologie est incroyablement complexe – peut-être même au-delà de la capacité de l’esprit humain à la comprendre pleinement. Cependant, l’intersection de l’IA et de la biologie pourrait accélérer notre compréhension de la biologie et conduire à certaines des avancées technologiques les plus passionnantes et transformatrices de notre époque. Les plateformes biologiques basées sur l’IA ont le potentiel de révéler des connaissances biologiques jusqu’alors inconnues, conduisant à de nouvelles percées médicales, à de nouvelles méthodes de diagnostic et à la capacité de détecter et de traiter les maladies plus tôt, voire même de les prévenir avant qu’elles ne surviennent.

Daphné Koller, insitro:

À certaines époques de notre histoire, certaines disciplines scientifiques ont fait des progrès incroyables en un laps de temps relativement court. Dans les années 1950, la discipline était l’informatique, et nous utilisions ces machines pour effectuer des calculs que seuls les humains pouvaient effectuer jusqu’alors. Puis, dans les années 1990, il y a eu cette divergence intéressante. D’une part, la science des données et les statistiques nous ont finalement apporté l’apprentissage automatique et l’intelligence artificielle modernes. L'autre côté est ce que je considère comme la biologie quantitative, c'est la première fois que nous commençons à mesurer la biologie à une échelle allant au-delà du suivi de 3 gènes dans une expérience qui a duré 5 ans. Aujourd'hui, 2020 est la dernière fois que les deux disciplines ont véritablement convergé, nous amenant à l'ère de la biologie numérique, la capacité de mesurer la biologie avec une fidélité et une échelle sans précédent ; d'interpréter l'incompréhensible à l'aide d'outils d'apprentissage automatique et de science des données. Des quantités massives de données, différentes à des échelles biologiques et à différents systèmes ; puis en utilisant des outils tels que l'édition du génome CRISPR pour réintégrer cette compréhension dans la biologie technique afin que nous puissions faire faire à la biologie des choses qu'elle n'est pas censée faire. Aujourd’hui, nous pouvons enfin mesurer la biologie à grande échelle, aux niveaux cellulaire (et parfois subcellulaire) et organisationnel. Cela nous permet, pour la première fois, de déployer l’apprentissage automatique de manière véritablement significative. Nous avons construit un modèle de langage biologique. C'est comme GPT, mais pour les cellules. Nous connaissons le langage des cellules et à quoi ressemblent les cellules. Vous mesurez des centaines de millions de cellules dans différents états, puis, comme un grand modèle de langage pour le langage naturel, avec une petite quantité de données, vous pouvez commencer à vous demander : « D'accord, comment une maladie déplace-t-elle un gène pathogène d'un environnement à l'autre ? " "Comment le traitement vous fait-il, espérons-le, revenir d'un état de maladie à un état de santé?" C'est super puissant. Comme pour les autres modèles de langage, plus vous lui fournissez de données, meilleur il s’améliore. ## 6 Mettre le modèle entre les mains des utilisateurs nous aidera à découvrir de nouveaux scénarios d'application

Alors que les itérations précédentes de modèles d'IA visaient à surpasser les humains sur certaines tâches, les LLM basés sur Transformer excellent dans le raisonnement général. Mais ce n’est pas parce que nous avons créé un bon modèle général que nous avons compris comment l’appliquer à un cas d’utilisation spécifique. Tout comme il est essentiel d'impliquer les humains dans la boucle sous la forme de RLHF pour améliorer les performances des modèles d'IA actuels, mettre les nouvelles technologies entre les mains des utilisateurs et comprendre comment ils les utilisent seront essentiels pour déterminer les applications à créer en fonction de ces technologies sous-jacentes. modèles.

Kevin Scott, Microsoft :

Il faut le rappeler : le modèle n’est pas le produit. En tant qu'entrepreneur, votre compréhension est la suivante : qui sont vos utilisateurs ? Quel est leur problème ? Que pouvez-vous faire pour les aider ? Déterminez ensuite si l’IA est effectivement une infrastructure utile pour résoudre les problèmes des utilisateurs – c’est une constante. L’intelligence artificielle est comme une nouvelle infrastructure intéressante qui vous permet de résoudre de nouvelles classes de problèmes ou de mieux résoudre d’anciennes classes de problèmes. Mira Murati,OpenAI :

Nous ne savons pas exactement à quoi ressemblera l'avenir, c'est pourquoi nous essayons de mettre ces outils et techniques à la disposition de beaucoup d'autres personnes afin qu'elles puissent expérimenter et que nous puissions voir ce qui se passe. C'est une stratégie que nous utilisons depuis le début. La semaine précédant le lancement de ChatGPT, nous craignions que ce ne soit pas assez performant. Nous avons tous vu ce qui se passe : nous l'avons publié, puis les gens nous disent que c'est suffisant pour découvrir de nouveaux cas d'utilisation, et vous voyez tous ces cas d'utilisation émergents. ## 7 Les souvenirs de vos amis IA s'amélioreront

Alors que les données, les calculs et les paramètres du modèle alimentent le raisonnement général des LLM, les fenêtres contextuelles alimentent leur mémoire à court terme. Les fenêtres contextuelles sont généralement mesurées par le nombre de jetons qu'elles peuvent gérer. Aujourd'hui, la plupart des fenêtres contextuelles font environ 32 Ko, mais des fenêtres contextuelles plus grandes arrivent, et avec elles la possibilité d'exécuter des documents plus volumineux avec plus de contexte via les LLM.

Noam Shazeer,Character.AI :

Actuellement, les modèles que nous proposons utilisent des fenêtres contextuelles de milliers de jetons, ce qui signifie que vos amis de toujours se souviendront de ce qui s'est passé au cours de la dernière demi-heure. Si vous parvenez à divulguer beaucoup d’informations, les choses s’amélioreront. Il devrait pouvoir apprendre un milliard de choses sur vous. La bande passante HBM est là. Dario Amodei,Anthropique :

Une chose qui, à mon avis, est encore sous-estimée est le contexte plus long et les choses qui l'accompagnent. Je pense que les gens ont cette image en tête d’avoir ce chatbot. "Je lui ai posé une question et il a répondu à la question. Mais vous pouvez télécharger un contrat légal et dire : 'Quels sont les cinq termes les plus inhabituels dans ce contrat légal ?' Ou téléchargez un état financier et dites : "Résumé de la situation de cette entreprise. Qu'est-ce qui est surprenant par rapport à ce que cet analyste a dit il y a deux semaines ? Toutes ces connaissances manipulent et traitent d'énormes quantités de données que les gens doivent compter." Je pense que c'est plus probable que ce que font les gens. Nous ne faisons que commencer. " ## 8 Les chatbots vocaux, les robots et d'autres moyens d'interagir avec l'intelligence artificielle sont un domaine de recherche important

Aujourd’hui, la plupart des gens interagissent avec l’intelligence artificielle sous la forme de chatbots, mais c’est parce que les chatbots sont souvent faciles à créer, et non parce qu’ils constituent la meilleure interface pour chaque cas d’utilisation.

De nombreux constructeurs se concentrent sur le développement de nouvelles façons permettant aux utilisateurs d’interagir avec les modèles d’IA via l’IA multimodale. Les utilisateurs pourront interagir avec les modèles multimodaux de la même manière qu’ils interagissent avec le reste du monde : à travers des images, du texte, de la voix et d’autres médias. Pour aller plus loin : l'IA incorporée se concentre sur l'intelligence artificielle qui peut interagir avec le monde physique, comme les voitures autonomes.

Mira Murati,OpenAI :

Je pense que le modèle de base d'aujourd'hui représente bien le monde dans le texte. Nous ajoutons d'autres modalités, comme des images et des vidéos, afin que ces modèles puissent obtenir une image plus complète du monde, similaire à la façon dont nous comprenons et observons le monde. Noam Shazeer,Character.AI :

Peut-être souhaitez-vous entendre une voix, voir un visage ou simplement pouvoir interagir avec plusieurs personnes. C'est comme si vous étiez élu président, que vous aviez des écouteurs et toute une équipe d'amis ou de conseillers. Ou comme si vous entrez dans un « bar amusant » et que tout le monde connaît votre nom et est content que vous soyez venu. Daphné Koller,insitro:

La prochaine frontière possible d’impact de l’IA se situera lorsque l’IA commencera à interagir avec le monde physique. Nous voyons tous à quel point c’est difficile. Nous avons tous vu à quel point il est difficile de construire une voiture autonome par rapport à la construction d’un chatbot, n’est-ce pas ? Nous faisons de grands progrès dans la création de chatbots, et les voitures autonomes bloquent toujours les camions de pompiers à San Francisco. Il est important de comprendre cette complexité, mais aussi l'ampleur de l'impact. ## 9 Aurons-nous des modèles généraux, un ensemble de modèles spécialisés, ou un mélange des deux ?

Quels cas d'utilisation sont les mieux adaptés aux modèles de base plus vastes à « intelligence supérieure » ou aux modèles et ensembles de données spécialisés plus petits ? Tout comme le débat entre architecture cloud et architecture de pointe d'il y a dix ans, la réponse dépend du montant que vous êtes prêt à payer, de la précision dont vous avez besoin pour le résultat et du niveau de latence que vous pouvez tolérer. Les réponses à ces questions peuvent changer au fil du temps, à mesure que les chercheurs développent des méthodes de calcul plus efficaces pour affiner les grands modèles de base pour des cas d'utilisation spécifiques.

À long terme, nous pourrions sur-roter les modèles utilisés pour quels cas d'utilisation, car nous en sommes encore aux premiers stades de la construction de l'infrastructure et de l'architecture nécessaires pour prendre en charge la prochaine vague d'applications d'IA.

Ali Ghodsi, Databricks :

C'est un peu comme en l'an 2000, Internet est sur le point de tout dominer, et tout ce qui compte c'est de savoir qui pourra construire le meilleur routeur. La capitalisation boursière de Cisco a culminé à 5 000 milliards de dollars américains en 2000, dépassant alors celle de Microsoft. Alors, qui a le plus grand LLM (modèle linguistique) ? De toute évidence, celui qui parviendra à construire le plus grand et à l’entraîner pleinement aura le contrôle de toute l’IA et des futurs humains. Mais tout comme Internet, quelqu’un d’autre proposera plus tard des idées comme Uber et la conduite de taxi. Il y aura d'autres personnes qui penseront : « Hé, je veux voir ce que font mes amis sur Facebook. » Cela peut être d'énormes opportunités commerciales, et ce ne sont pas seulement des entreprises comme OpenAI, Databricks ou Anthropic qui peuvent construire un modèle. scénarios. Il faut beaucoup d'efforts pour créer un médecin en qui vous avez confiance. Dario Amodei,Anthropique :

Le facteur le plus important est d’investir plus d’argent. Les modèles les plus chers fabriqués aujourd’hui coûtent environ 100 millions de dollars, plus ou moins un ordre de grandeur. L’année prochaine, nous verrons peut-être des modèles de plusieurs acteurs valant environ 1 milliard de dollars, et d’ici 2025, nous verrons des modèles se chiffrant en milliards, voire 10 milliards de dollars. Cette différence 100x est combinée au fait que les calculs du H100 eux-mêmes deviennent plus rapides - un saut particulièrement important en raison d'une précision réduite. Mettez tous ces facteurs ensemble et si les lois de la mise à l’échelle continuent de s’appliquer, les capacités augmenteront considérablement. Mira Murati, OpenAI :

Cela dépend de ce que vous voulez faire. Il est clair que les systèmes d’IA assumeront de plus en plus les tâches que nous effectuons. En ce qui concerne la plateforme OpenAI, vous pouvez constater qu'aujourd'hui encore, nous proposons de nombreux modèles via l'API, des très petits modèles aux modèles de pointe. Il n’est pas toujours nécessaire d’utiliser le modèle le plus puissant ou le plus compétent. Parfois, ils ont simplement besoin d’un modèle adapté à leur cas d’utilisation spécifique et plus rentable. Nous voulons que les gens s'appuient sur notre modèle et leur donnent les outils pour faciliter ce processus. Nous souhaitons leur donner de plus en plus d'accès et de contrôle afin que vous puissiez apporter vos propres données et personnaliser ces modèles. Il faut vraiment se concentrer sur des choses qui dépassent le cadre du modèle et définir le produit. David Baszucki, Roblox :

Dans toute entreprise comme Roblox, il existe probablement 20 ou 30 applications verticales pour utilisateurs finaux qui sont très personnalisées - le filtrage du langage naturel est très différent de la génération de 3D - et chez l'utilisateur final, nous voulons que toutes ces applications s'exécutent. Au fur et à mesure que nous descendons [la pile], dans une entreprise comme la nôtre, il peut y avoir un regroupement naturel de 2 ou 3 modèles de type plus grands et plus gros. Nous avons réglé très finement les disciplines dans lesquelles nous souhaitons pouvoir former et effectuer de nombreuses inférences pour ces disciplines. ## 10 Quand l'IA sera-t-elle suffisamment adoptée dans l'entreprise, qu'arrive-t-il à ces ensembles de données ?

L’impact de l’IA générative sur les entreprises en est encore à ses balbutiements – en partie parce que les entreprises sont généralement plus lentes à évoluer, et en partie parce qu’elles ont pris conscience de la valeur de leurs ensembles de données propriétaires et ne souhaitent pas nécessairement les transmettre à une autre entreprise. Quelle que soit la puissance de leur modèle. La plupart des cas d'utilisation en entreprise nécessitent un haut degré de précision, et les entreprises disposent de 3 options pour choisir le LLM : créer leur propre LLM, utiliser un fournisseur de services LLM pour le créer pour elles, ou affiner le modèle sous-jacent - créer votre propre LLM n'est pas une tâche facile. facile.

Ali Ghosdi, Databricks:

Une chose qui arrive dans l’esprit des PDG et des conseils d’administration, c’est qu’ils se rendent compte : peut-être que je peux battre mes concurrents. C'est peut-être la kryptonite qui tue vos ennemis. J'ai les données pour l'IA générative, alors ils pensent : « Je dois les construire moi-même. » Je dois posséder la propriété intellectuelle. Voulez-vous créer votre propre LLM à partir de zéro ? Ce n'est pas anodin, nécessite toujours beaucoup de GPU, coûte beaucoup d'argent et dépend de votre ensemble de données et de votre cas d'utilisation. Nous avons beaucoup de clients qui souhaitent un modèle moins cher, plus petit et spécialement conçu, offrant une précision et des performances très élevées. Ils disent : " Hé, c'est ce que je veux faire. Je veux obtenir une bonne classification à partir de ces images de ce défaut particulier dans le processus de fabrication. " La précision est ici importante. Chaque once de précision que vous pouvez me donner compte. Là, vous serez mieux loti si vous disposez d'un bon ensemble de données sur lequel vous entraîner et si vous pouvez entraîner un modèle plus petit. La latence sera plus rapide, moins chère et oui, vous pouvez absolument avoir une précision qui bat les très gros modèles. Mais le modèle que vous construisez ne vous divertira pas le week-end et n'aidera pas vos enfants à faire leurs devoirs. ## 11 La loi de la mise à l'échelle nous mènera-t-elle jusqu'à l'AGI ?

LLM suit actuellement la loi du Scaling : les performances du modèle s'améliorent à mesure que vous ajoutez plus de données et de calculs, même si l'architecture et les algorithmes restent les mêmes. Mais combien de temps cette règle peut-elle durer ? Est-ce que cela va continuer indéfiniment, ou va-t-il atteindre ses limites naturelles avant que nous développions l’AGI ?

Mira Murati, OpenAI :

Rien ne prouve que nous n’obtiendrons pas de modèles meilleurs et plus puissants à mesure que nous continuons à élargir l’accès aux données et au calcul. Que cela vous mène jusqu'à l'AGI, c'est une autre question. D'autres percées et avancées seront peut-être nécessaires en cours de route, mais je pense qu'il reste encore un long chemin à parcourir en termes de lois de mise à l'échelle et de véritablement tirer de nombreux avantages de ces modèles plus grands. Dario Amodei, Anthropique:

Même s’il n’y a pas d’améliorations algorithmiques ici et que nous nous contentons d’évoluer là où nous en sommes jusqu’à présent, la loi de la mise à l’échelle continuera. Noam Shazeer, personnage.AI :

Notre objectif est d'être une entreprise AGI et une entreprise axée sur les produits, et la façon d'y parvenir est de choisir les bons produits, de nous obliger à faire des choses généralisables, de rendre les modèles plus intelligents, d'en faire quelque chose que les gens veulent, et de livrer services à moindre coût et à grande échelle. La loi de la mise à l’échelle nous mènera loin. En fait, le calcul n’est pas si coûteux. Aujourd'hui, les coûts d'exploitation se situent entre 10 et 18 dollars. Si vous pouvez faire ces choses efficacement, le coût devrait être bien inférieur à la valeur de votre temps. La capacité est là pour étendre ces choses par ordres de grandeur. ## 12 Quelles sont les capacités émergentes ?

Alors que certaines personnes s’empressent d’écarter la capacité de générer de l’intelligence artificielle, l’intelligence artificielle est déjà bien meilleure que les humains pour accomplir certaines tâches et continuera de s’améliorer. Les meilleurs constructeurs ont été capables d’identifier les capacités émergentes les plus prometteuses de l’IA et de créer des modèles et des entreprises qui transforment ces capacités en capacités fiables. Ils reconnaissent que l’échelle tend à accroître la fiabilité des capacités émergentes.

Mira Murati, OpenAI :

Il est important de prêter attention à ces fonctionnalités émergentes, même si elles sont très peu fiables. Surtout pour ceux qui créent des entreprises aujourd'hui, il faut vraiment réfléchir à la question : "D'accord, qu'est-ce qui est possible aujourd'hui ? Que voyez-vous aujourd'hui ?" Parce que très rapidement, ces modèles vont devenir fiables. Dario Amodei, Anthropique :

Lorsque nous avons publié GPT-2, ce qui était considéré comme le plus impressionnant à l'époque était : « Vous introduisez ces cinq exemples de traduction de l'anglais vers le français directement dans le modèle linguistique, puis vous introduisez la sixième phrase en anglais, et cela se traduirait en français. " C'était comme oh mon Dieu, il comprend ce modèle. " C'était fou pour nous, même si c'était une mauvaise traduction. Mais notre point de vue est : « Écoutez, ce n'est que le début d'un voyage incroyable car il n'y a pas de limites et il peut continuer à évoluer. » Pourquoi ces modèles que nous avons vus auparavant ne peuvent-ils pas continuer à exister ? Il y a tellement d'objectifs pour prédire le mot suivant, et il y a tellement de choses avec lesquelles vous pouvez les défier, que cela fonctionne définitivement. Et puis certaines personnes l'ont regardé et ont dit : « Vous avez créé un très mauvais outil de traduction de robot. » ## 13 Le coût de service de ces modèles va-t-il baisser ?

Les coûts de calcul sont l’une des principales limites à la mise à l’échelle de ces modèles, et la pénurie actuelle de puces fait grimper les coûts en limitant l’offre. Cependant, si Nvidia produit davantage de H100 l’année prochaine, cela devrait atténuer la pénurie de GPU et potentiellement réduire les coûts de calcul.

Noam Shazeer, personnage.AI :