- Topik

33k Popularitas

12k Popularitas

5k Popularitas

16k Popularitas

61k Popularitas

31k Popularitas

2k Popularitas

95k Popularitas

27k Popularitas

27k Popularitas

- Sematkan

33k Popularitas

12k Popularitas

5k Popularitas

16k Popularitas

61k Popularitas

31k Popularitas

2k Popularitas

95k Popularitas

27k Popularitas

27k Popularitas

Perkembangan baru dalam model byte besar: pengenalan pertama pemosisian visual untuk mencapai pemahaman gabungan multi-modal yang halus, sumber terbuka & demo yang dapat dimainkan

Sumber asli: Qubit

Model byte besar, BuboGPT ada di sini.

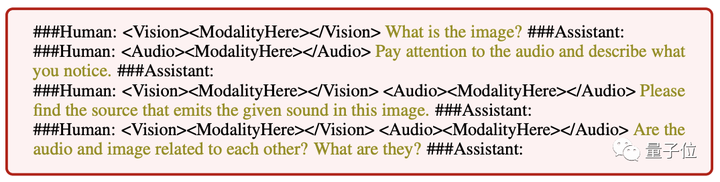

Mendukung tiga mode teks, gambar, dan audio untuk mencapai pemahaman bersama multi-modal yang halus.

Di mana harus menjawab dan apa yang harus dikatakan, apa yang dikatakan dan apa yang tidak dikatakan, sekilas terlihat jelas:

Audio-1-chime-bird-breeze, qubit, 20 detik

Pemahaman gabungan tiga modal, deskripsi teks + posisi gambar + posisi suara, satu klik untuk mendapatkannya, dan secara akurat menentukan sumber suara:

Audio-7-dork-bark, qubit, 6 detik

Sekalipun tidak ada hubungan langsung antara audio dan gambar, kemungkinan hubungan antara keduanya dapat dijelaskan secara wajar.Bercerita juga dimungkinkan dengan melihat gambar dan mengidentifikasi suara:

Audio-jam 11-enam, qubit, 1 menit

Menurut para peneliti:

Oleh karena itu, saat BuboGPT mendeskripsikan gambar, BuboGPT dapat menunjukkan lokasi spesifik objek di dalam gambar.

BuboGPT: Memperkenalkan konektivitas visual ke LLM untuk pertama kalinya

Selain contoh di atas yang dibagikan penulis di YouTube, tim peneliti juga mendemonstrasikan berbagai trik yang dimainkan BuboGPT di koran.

Lama sekali melihat katak bermain piano! Bisakah grafik seperti itu BuboGPT juga menggambarkan secara akurat?

Tanyakan saja tempat-tempat menarik apa saja yang ada di gambar tersebut, dan bisa juga dengan merangkum semua yang ada di latar belakang gambar tersebut.

BuboGPT "penglihatan + pendengaran + tes ekspresif", para peneliti memainkannya seperti ini, mari kita dengarkan audio ini dulu.

Audio-9-pengering rambut, qubit, 5 detik

Mari kita lihat deskripsi BuboGPT:

Efeknya sangat bagus karena Byte kali ini menggunakan metode pengenalan pemosisian visual ke dalam LLM.

Metode khusus kami kemudian melihat ke bawah.

Arsitektur BuboGPT adalah untuk mencapai pemahaman multimodal dengan mempelajari ruang semantik bersama dan mengeksplorasi lebih lanjut hubungan halus antara objek visual yang berbeda dan modalitas yang berbeda.

Untuk mengeksplorasi hubungan halus antara objek visual yang berbeda dan berbagai modalitas, para peneliti pertama-tama membangun pipa lokalisasi visual siap pakai berdasarkan SAM.

Pipeline ini terdiri dari tiga modul: Tagging Module (Tagging Module), Location Module (Grounding Module), dan Entity-matching Module (Entity-matching Module).

Pertama, modul pelabelan adalah model terlatih yang dapat menghasilkan banyak label teks yang terkait dengan gambar input.

Modul pelokalan berbasis SAM selanjutnya melokalkan topeng semantik atau kotak pembatas yang terkait dengan setiap label teks pada gambar.

Kemudian, modul pencocokan entitas menggunakan kemampuan penalaran LLM untuk mengambil entitas yang cocok dari label dan deskripsi gambar.

Inilah cara peneliti menggunakan bahasa sebagai jembatan untuk menghubungkan objek visual dengan modalitas lain.

Agar masukan dari setiap kombinasi dari tiga mode memiliki hasil yang baik, para peneliti mengadopsi skema pelatihan dua tahap yang mirip dengan Mini-GTP4:

Pelatihan pra-modal tunggal dan penyesuaian instruksi multi-modal.

Pada tahap pra-pelatihan unimodal, modalitas Q-Former yang sesuai dan lapisan proyeksi linier dilatih pada sejumlah besar data berpasangan modalitas-teks.

Untuk persepsi visual, kami hanya melatih lapisan proyeksi untuk bagian pembuatan keterangan gambar dan mempertahankan Q-Former dari BLIP2 tetap.

Untuk pemahaman audio, mereka melatih Q-Former dan bagian pembuatan teks audio.

Di kedua pengaturan tanpa menggunakan petunjuk apa pun ( ), model hanya menerima gambar atau audio yang sesuai sebagai masukan dan memprediksi teks (teks) yang sesuai.

** **###### △ Instruksi input yang berbeda mengikuti contoh

**###### △ Instruksi input yang berbeda mengikuti contoh

Pada tahap penyesuaian instruksi multimodal, dataset instruksi multimodal berkualitas tinggi dibangun untuk menyempurnakan lapisan proyeksi linier, termasuk:

Perlu dicatat bahwa dengan memperkenalkan sampel negatif "pasangan gambar-audio" untuk pencocokan semantik, BuboGPT dapat diselaraskan dengan lebih baik, dan kemampuan pemahaman gabungan multimodal menjadi lebih kuat.

Saat ini kode dan kumpulan data BuboGPT sudah open source, dan demonya juga sudah dirilis, yuk segera dicoba.

demo pengalaman bermain dangkal

Area fungsi halaman demo BuboGPT sekilas jelas, dan pengoperasiannya juga sangat sederhana. Anda dapat mengunggah gambar atau audio di sisi kanan, dan jendela jawaban BuboGPT dan jendela pertanyaan pengguna di sisi kiri:

Ini gambar lain, dengan sepotong audio, dan BuboGPT juga cocok dengan sumber suara:

Audio-8-bicycle_bell, qubit, 22 detik

Pintu gerbang: [1] [2]