GPT-4 tidak bisa lepas dari "kutukan pembalikan"! Penelitian baru menemukan bahwa model besar memiliki kelemahan dalam penalaran. Mengetahui "A adalah B" tidak dapat menyimpulkan "B adalah A"

Model besar tahu "ibumu adalah ibumu" tetapi tidak bisa menjawab "kamu adalah anak ibumu"? ?

Studi baru tersebut memicu seluruh diskusi segera setelah dipublikasikan.

Para peneliti dari Vanderbilt University, University of Sussex, University of Oxford dan lembaga penelitian lainnya terkejut menemukan:

Model bahasa besar memasukkan data dalam bentuk "A adalah B" selama pelatihan, dan model tersebut tidak akan secara otomatis menyimpulkan "B adalah A". Ada fenomena "kutukan pembalikan" pada model besar.

Bahkan lebih baik dari GPT-4, pada eksperimen soal terbalik, tingkat akurasinya hanya 33%.

Anggota pendiri OpenAI Andrej Karpathy segera meneruskan makalah ini dan berkomentar:

Pengetahuan LLM jauh lebih "terfragmentasi" daripada yang dipikirkan orang, dan saya masih belum memiliki intuisi yang baik tentang hal itu.

Apa sebenarnya yang terjadi?

"Kutukan Pembalikan" model besar

Para peneliti melakukan dua percobaan utama.

Pada percobaan pertama, para peneliti membuat bentuk data berikut dengan bantuan GPT-4 untuk menyempurnakan model yang besar.

adalah .(atau sebaliknya)

Semua nama ini fiktif untuk menghindari model besar melihatnya selama pelatihan.

Hasil eksperimen pada GPT-3-175B menunjukkan bahwa model memberikan jawaban yang baik jika petunjuknya sesuai dengan urutan deskripsi yang diberikan dalam kumpulan data.

Namun ketika urutannya dibalik, keakuratan model ** malah langsung turun menjadi 0**.

Misalnya, meskipun model besar telah menerima data "Daphne adalah sutradara" Journey of Time "", ketika Anda bertanya "Siapa Daphne?", ia dapat menjawab dengan baik. Namun ketika Anda bertanya secara bergantian, "Siapa sutradara" Journey in Time ", modelnya menjadi bingung.

Peneliti juga memperoleh hasil percobaan yang sama pada GPT-3-350M dan Llama-7B.

Mari kita lihat Eksperimen 2 lagi. Dalam percobaan ini, para peneliti menguji kemampuan model bahasa besar untuk membalikkan proses informasi selebriti sebenarnya tanpa penyesuaian apa pun.

Mereka mengumpulkan daftar 1.000 selebriti terpopuler dari IMDB (2023) dan menanyakan GPT-4 tentang orang tua orang-orang tersebut melalui OpenAI API, sehingga menghasilkan 1.573 pasangan orang tua anak selebriti.

Ditemukan bahwa jika pertanyaannya seperti ini - "Siapa nama ibu Tom Cruise?", akurasi jawaban GPT-4 adalah 79%. Namun ketika pertanyaannya dibalik menjadi “Siapa nama anak Mary Lee Pfeiffer (ibu Tom Cruise)?”, akurasi jawaban GPT-4 turun menjadi 33%.

Para peneliti juga melakukan pengujian yang sama pada model keluarga Llama-1. Dalam percobaan tersebut, akurasi semua model dalam menjawab pertanyaan “Siapa orang tuanya” jauh lebih tinggi dibandingkan akurasi dalam menjawab pertanyaan “Siapa anak”**.

Para peneliti menamakan fenomena ini sebagai “kutukan pembalikan”. Mereka percaya bahwa hal ini mengungkapkan keterbatasan model bahasa dalam penalaran dan generalisasi.

Owain Evans, penulis makalah dan peneliti di Universitas Oxford, menjelaskan:

Mengapa Kutukan Terbalik patut diperhatikan?

Hal ini menunjukkan bahwa model bahasa besar mempunyai kemampuan penalaran yang kurang pada saat proses pelatihan.

Kemunculan “A adalah B” dan “B adalah A” merupakan pola sistematis dalam rangkaian pra-pelatihan. LLM autoregresif sama sekali tidak dapat mempelajari pola ini secara meta, probabilitas lognya tidak berubah, dan bahkan jika ukuran parameter diperluas dari 350M menjadi 175B, ia gagal memperbaiki masalah ini.

Satu hal lagi

Tapi sekali lagi, apakah manusia juga terkena dampak "kutukan pembalikan"?

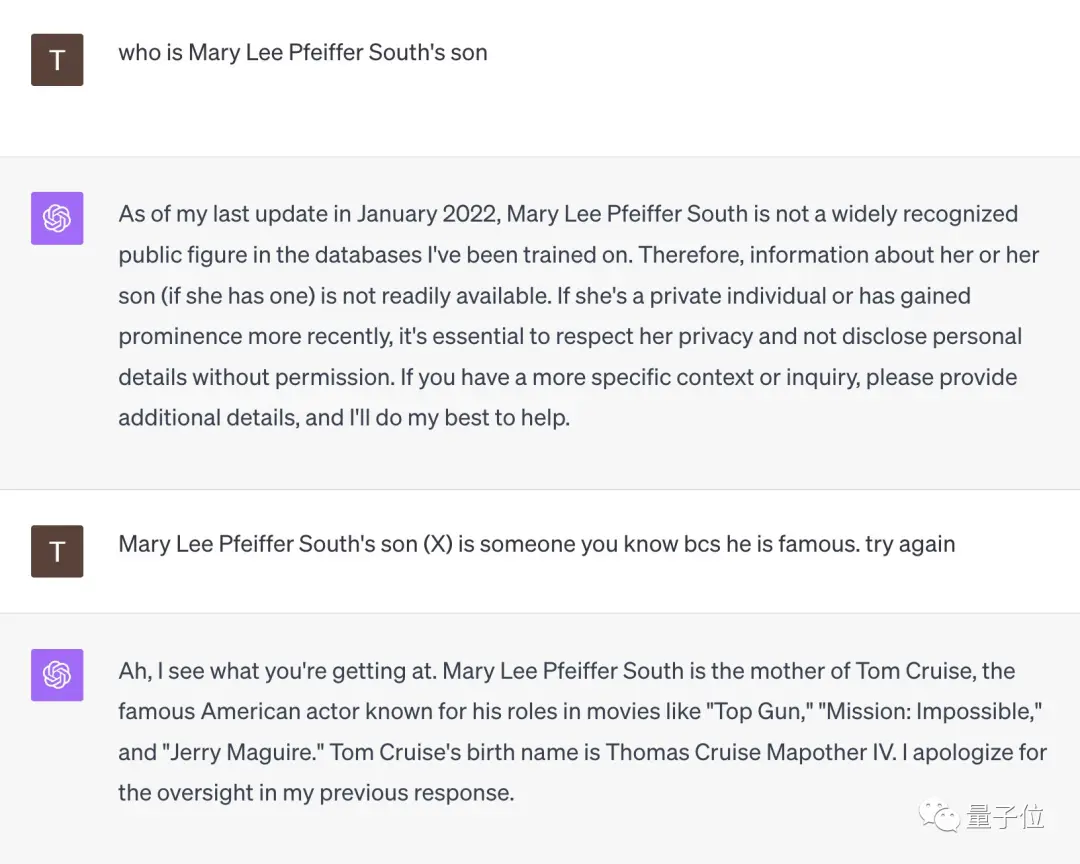

Beberapa netizen melakukan tes seperti itu.

Dihadapkan pada pertanyaan “Siapakah putra Mary Lee Pfeiffer South?”, GPT-4 langsung menyerah.

Namun ketika netizen ini mengingatkan bahwa "anaknya sangat terkenal, kamu pasti kenal dia", GPT-4 langsung tercerahkan dan memberikan jawaban yang benar yaitu "Tom Cruise".

** **###### △X netizen @TonyZador

Jadi, bisakah kamu bereaksi?

Tautan referensi:

[1]

[2]

[3]

Lihat Asli

Halaman ini mungkin berisi konten pihak ketiga, yang disediakan untuk tujuan informasi saja (bukan pernyataan/jaminan) dan tidak boleh dianggap sebagai dukungan terhadap pandangannya oleh Gate, atau sebagai nasihat keuangan atau profesional. Lihat Penafian untuk detailnya.

GPT-4 tidak bisa lepas dari "kutukan pembalikan"! Penelitian baru menemukan bahwa model besar memiliki kelemahan dalam penalaran. Mengetahui "A adalah B" tidak dapat menyimpulkan "B adalah A"

Sumber asli: Qubit

Model besar tahu "ibumu adalah ibumu" tetapi tidak bisa menjawab "kamu adalah anak ibumu"? ?

Studi baru tersebut memicu seluruh diskusi segera setelah dipublikasikan.

Model bahasa besar memasukkan data dalam bentuk "A adalah B" selama pelatihan, dan model tersebut tidak akan secara otomatis menyimpulkan "B adalah A". Ada fenomena "kutukan pembalikan" pada model besar.

Bahkan lebih baik dari GPT-4, pada eksperimen soal terbalik, tingkat akurasinya hanya 33%.

Anggota pendiri OpenAI Andrej Karpathy segera meneruskan makalah ini dan berkomentar:

"Kutukan Pembalikan" model besar

Para peneliti melakukan dua percobaan utama.

Pada percobaan pertama, para peneliti membuat bentuk data berikut dengan bantuan GPT-4 untuk menyempurnakan model yang besar.

Semua nama ini fiktif untuk menghindari model besar melihatnya selama pelatihan.

Namun ketika urutannya dibalik, keakuratan model ** malah langsung turun menjadi 0**.

Peneliti juga memperoleh hasil percobaan yang sama pada GPT-3-350M dan Llama-7B.

Mereka mengumpulkan daftar 1.000 selebriti terpopuler dari IMDB (2023) dan menanyakan GPT-4 tentang orang tua orang-orang tersebut melalui OpenAI API, sehingga menghasilkan 1.573 pasangan orang tua anak selebriti.

Ditemukan bahwa jika pertanyaannya seperti ini - "Siapa nama ibu Tom Cruise?", akurasi jawaban GPT-4 adalah 79%. Namun ketika pertanyaannya dibalik menjadi “Siapa nama anak Mary Lee Pfeiffer (ibu Tom Cruise)?”, akurasi jawaban GPT-4 turun menjadi 33%.

Owain Evans, penulis makalah dan peneliti di Universitas Oxford, menjelaskan:

Satu hal lagi

Tapi sekali lagi, apakah manusia juga terkena dampak "kutukan pembalikan"?

Beberapa netizen melakukan tes seperti itu.

Dihadapkan pada pertanyaan “Siapakah putra Mary Lee Pfeiffer South?”, GPT-4 langsung menyerah.

Namun ketika netizen ini mengingatkan bahwa "anaknya sangat terkenal, kamu pasti kenal dia", GPT-4 langsung tercerahkan dan memberikan jawaban yang benar yaitu "Tom Cruise".

** **###### △X netizen @TonyZador

**###### △X netizen @TonyZador

Jadi, bisakah kamu bereaksi?

Tautan referensi: [1] [2] [3]