著者: 趙建出典:Jiazi Guangnian 画像ソース: Unbounded AI によって生成「食べるために走るか、他人に食べられないために走るか。どちらにしても走り続けなさい。」これは、今年の国立台湾大学でのスピーチの中で、NVIDIA CEO 黄仁勲氏が卒業生に向けて述べたメッセージですが、もちろん、黄仁勲氏が築いたこの数兆ドルの時価総額帝国のメンタリティの解釈でもあります。2023 年、逃走中の Nvidia は、Huang Renxun が何度も「AI の iPhone の瞬間」と呼んだ生成 AI に遭遇しました。この瞬間、黄仁勲は獲物ではなく狩人になる機会、ユンに目を向けました。クラウド サービス プロバイダーは Nvidia の重要な顧客であり、毎年 Nvidia から数十億ドルの GPU を購入しているためだけでなく、この問題には勝ち目がないように見えるため、Nvidia がクラウドを行う動機を持つべきではないと思われます。今日のクラウド コンピューティング市場は、Amazon AWS、Microsoft Azure、Google Cloud という 3 つのクラウド巨人によってしっかりと支配されています。 Statistaのデータによると、2022年の市場シェアはAWSが32%、Azureが23%、Google Cloudが10%となり、3社を合わせると65%に達すると予想されている。挑戦者が現れなかったわけではない。過去 10 年間、VMware、Dell、Hewlett-Packard などの有名企業はいずれもクラウド コンピューティング市場に参入しようとしましたが、例外なく失敗しました。しかし、あらゆる技術革新が新たなトレンドセッター、つまり生成 AI の波を生み出すのと同じように、チップ メーカー Nvidia はクラウド コンピューティング市場を段階的にテストし始めました。**最初のステップとして、今年 3 月 21 日の GTC カンファレンスで、NVIDIA は DGX Cloud をリリースしました。 **名前からわかるように、これはクラウド製品であり、顧客は月単位でレンタルすることで、クラウドまたはローカル データセンターにある Nvidia の AI 製品とサービスを直接入手できます。**第 2 のステップは、クラウド大手 3 社の競合他社に投資することです。 **NVIDIA は、米国の中小規模のクラウド サービス プロバイダーである CoreWeave と Lambda Labs に相次いで投資し、希少な GPU チップを割り当ててきました。この「好み」はどれほど誇張されているのでしょうか? GPU コアの入手が困難な現在、CoreWeave は豊富な GPU、特に H100 を抵当に入れることで 23 億米ドルの負債資金を調達することができました。始まったばかりではあるが、クラウド ビジネスのレイアウトはクラウド大手に対する Nvidia の反撃を表している。周知のとおり、Google、Amazon、Microsoft は、Google の TPU シリーズ、Amazon の Inferentia および Trainium シリーズ、そして今年公開された Microsoft の Athena チップなど、自社開発の AI チップ プロジェクトを相次いで社内で立ち上げてきました。クラウド大手3社は、エヌビディアの「GPU税」を削減するためにAIチップを自社開発する十分なリソースと意欲を持っている。Nvidia はこのことを十分に認識しています。黄仁勲氏は前四半期決算報告の電話会見で、「われわれは競争に注意を払ってきたし、常に競争は存在してきた」と率直に語った。Huang Renxun は 3 つの大手クラウド サービス プロバイダーの拡大を防ぐことはできませんが、おそらく最大の防御は攻撃であり、Nvidia の反撃方法は直接クラウドに向かうことです。A100 と H100 という 2 つの切り札が長期間にわたって手元にあるため、これら 2 つのチップは大規模モデルのトレーニングと推論に最適な選択肢ですが、いずれも Nvidia には真のリーダーになる機会がありません。クラウドコンピューティング市場の裏方オペレーター。世界時価総額トップ5に入るテクノロジー巨人4社の間で、チップとクラウドコンピューティングを巡る公然かつ秘密の戦いがゆっくりと展開している。## **1. 夜明け前に落ちそうになりました**Nvidia に詳しい人なら、今日の Nvidia がどれほど美しいか、そして昨年の Nvidia がどれほど悲惨だったかを知っているでしょう。Nvidia の中核事業には、データ センター、ゲーム、プロフェッショナル ビジュアライゼーション、自動車が含まれます。 2020 年第 2 四半期に、Nvidia のデータセンター ビジネスは初めてゲームを上回り、Nvidia の最大の収益源になりました。2022 年第 4 四半期財務報告会 (自然年では 2021 年 11 月から 2022 年 1 月に相当) で、Nvidia は好調な第 4 四半期財務報告書を発表し、データセンター事業は前年同期比 71% 増加しました。 Huang Renxun 氏は当時、「NVIDIA のコンピューティング プラットフォームが異常な市場需要をもたらした」と楽観的に語っていたが、その 1 週間後にロシアとウクライナの間で紛争が勃発し、主要原材料のサプライチェーンが混乱した。感染症流行の影響と相まって、Nvidiaのデータセンター事業の成長率は2022年を通じて鈍化し続けるだろう。今年 2 月に発表された 2023 年第 4 四半期の財務報告書では、NVIDIA データセンターの成長率はわずか 11% で過去最低を記録し、2020 年以来初めてチェーンが減少しました。2022年にはエヌビディアの株価も半減する。もちろん、今日では再び上昇しており、ChatGPT の誕生が Nvidia を救いました。 注: Nvidia は、2023 年 5 月から 7 月に相当する 2024 年第 2 四半期財務報告書を水曜日 (8 月 23 日) に発表します。事業成長の鈍化の理由は数多くありますが、その中でも最も警戒すべきは大口顧客からの需要の減少です。 2023年第4四半期の財務報告書で、NVIDIAのCFOコレット・クレス氏は次の数字を発表した:2023会計年度のデータセンター部門の収益150億ドルのうち約40%(約60億ドル)はハイパースケールデータセンターとクラウドサービスによるものだプロバイダー。しかし、第 4 四半期だけを見てみると、それはわずか 4 分の 1 に過ぎません。ハイパースケール データセンターの構築者やクラウド サービス プロバイダーは、GPU への支出を大幅に削減しています。客観的な需要の減少に加えて、クラウド大手 3 社の自社開発 AI チップ計画が NVIDIA GPU の市場シェアを少しずつ侵食しています。Google は 2016 年に第 1 世代の自社開発 AI チップ TPU を発売し、5 年後の 2021 年 5 月 19 日に第 4 世代 TPU v4 を発売しました。今年発表された調査報告書の中で、Google は、4,000 個の TPU v4 をつなぎ合わせて、Nvidia A100 GPU を搭載した同等のマシンよりも 1.7 倍、1.9 倍高速かつ効率的に動作するスーパーコンピューターを構築したと述べました。Amazon には、Nvidia だけでなく、すべてのチップ メーカー向けにチップを自社開発する伝統もあります。現在、Amazonは自社開発チップの4シリーズ(ネットワークチップNitroシリーズ、サーバーチップGravitonシリーズ、AI推論チップInferentiaシリーズ、AIトレーニングチップTrainium)を発売している。このうち、後者の 2 つの AI チップは NVIDIA GPU と競合します。Microsoftは参入が遅れたにもかかわらず、「遅れて参入」した。今年4月18日、The Informationによると、Microsoftは2019年以来、社内コードネーム「Athena」(アテナ)と呼ばれるAIチップを極秘に開発しており、数百人の従業員がAthenaプロジェクトに取り組んでおり、Microsoftは約20億ドルを投資しているとのこと。 Microsoft と OpenAI の一部の従業員は、GPT-4 などの最新の大規模言語モデルでのパフォーマンスをテストするためのチップを入手することができました。クラウド サービス プロバイダーは、特に生成 AI の発生後、GPU の購入に対して多額の「Nvidia 税」を毎年支払わなければなりません。今年 2 月、New Street Research は、ChatGPT に基づく Bing 検索エンジンが 1 秒以内にユーザーの質問に応答するには 8 つの GPU が必要であるとの見積もりを出しました。このままでは、Bing のモデルをすべてのユーザーに展開するには、Microsoft が 8 GPU を搭載した 20,000 台を超えるサーバーが必要となり、それには 40 億ドルの費用がかかることになります。 1 日あたり 80 ~ 90 億のクエリを処理する Google の規模では、800 億ドルの費用がかかることになります。クラウドサービスプロバイダーが自社開発したAIチップは外部には販売されず、Nvidiaと直接競合することはない。ただし、データセンターに GPU の代わりに自社開発のチップを導入することで、コストを効果的に削減できます。たとえば、Google はクラウド サービスに数百台の TPU v4 スーパーコンピューターを導入しました。大手クラウド サービス プロバイダー 3 社には、独自のチップを開発するための十分なリソースと動機があり、これは Nvidia 帝国の亀裂と見なされています。 Nvidia はこのことを十分に認識していますが、これより良い方法はないようです。ChatGPTが登場するまで、クラウドサービスプロバイダーから段階的に迫られていたNvidiaに、反撃の突破口が見えた。クラウドサービスプロバイダーがチップを作れるのだから、AI時代のクラウドはNVIDIAが作れないだろうか?## **2. Nvidia にはクラウドを行うチャンスがありますか? **Nvidia は現在、生成 AI 革命の最大の受益者であり、Huang Renxun 氏は今年、常に「AI の iPhone の瞬間」について語ってきました。生成 AI の爆発的な需要により、GPU はハード通貨になりました。「GPU は新しいドルだ」と単純に言う人もいます。GPU からクラウドまで、Nvidia には本当にチャンスがあるのでしょうか?生成型 AI のトレーニングと推論は主にクラウド上で行われ、AI インフラストラクチャを提供するクラウド サービス プロバイダーは生成型 AI の波の最大の受益者の 1 つとなります。シリコンバレーのベンチャーキャピタル会社 A16Z が推定したデータによると、生成 AI によって生み出される総収益の 10% ~ 20% が、最終的にクラウド サービス プロバイダーに流れます。ただし、このプロセスはすぐには進みません。 Amazon CEOのアンディ・ジャシー氏は2023年第2四半期の決算会見で、「生成AIは間違いなくほぼすべての顧客のエクスペリエンスを変えるだろう。しかし、まだ時期尚早で、ほとんどの企業はこの目標を達成する方法をまだ検討しているところだ。われわれにとってこれはマラソンのようなものだ」と語った。非常に初期の段階です。」クラウドサービスの本質は、データセンター内のハードウェアリソースを仮想化し、市場にリースすることです。従来のデータセンターのサーバーのほぼ 100% は Intel および AMD CPU をベースに構築されており、CPU はオペレーティング システム、システム ソフトウェア、アプリケーション プログラムの処理といった「汎用コンピューティング」機能を提供する「最強の頭脳を備えたジェネラリスト」のようなものです。複雑な命令のスケジューリング、ループ、分岐、論理判断、実行などのプログラムタスクがあります。しかし、CPU は人工知能に必要な大規模なデータ処理や並列コンピューティングが苦手であり、Nvidia GPU が得意としています。 GPU は「暴力的なコンピューティングの専門家」のようなもので、画像処理、深層学習、現在の大規模モデルのトレーニング、推論、その他のタスクに特化しています。 Huang Renxun 氏は、この超並列コンピューティング機能を「アクセラレーション コンピューティング」と呼びました。2012 年、ディープ ラーニングの父であるジェフ ヒントンとその弟子たちは、初めて NVIDIA GPU 上で畳み込みニューラル ネットワーク モデル AlexNet のトレーニングを試み、画像認識コンテストで一気に優勝しました。この事件により、その後 10 年間でディープラーニングが爆発的に普及し、Nvidia 自体を含む人工知能業界全体が、高速コンピューティングにおける GPU の可能性に気づきました。Nvidia の運命の歯車が回り始めました。それ以来、黄仁勲氏は何度も「ムーアの法則は死んだ」と叫んだ。同氏は、CPU を拡張する時代は終わり、同じコストで 5 年ごとにパフォーマンスが 10 倍向上する時代は終わったと考えています。それはGPUに置き換えられ、黄仁訓氏は特別に「黄の法則」を発明しました。GPUはAIのパフォーマンスを年々倍増させます。2012 年から 2022 年までの 10 年間は、0 から 1 へのアクセラレーション コンピューティングと呼ぶことができ、人工知能は画像認識などの特定の業界や特定のシナリオに上陸しました。しかし、この時期の AI の需要はまだ十分大きくなく、調査会社 Aletheia は、現在の AI サーバーの市場普及率は 5% 未満であると予測しています。これは、高速コンピューティングという Huang Renxun の夢を実現するには十分ではありません。2022年11月にChatGPTが誕生するまでは、「AI iPhone moment」が登場しました。これは、アクセラレーション コンピューティングの 1 から 10 へのスケールアップの始まりと見ることができます。 AI による収益 (写真はブルームバーグ経由)Huang Renxun 氏は、アクセラレーテッド コンピューティングと生成 AI の組み合わせによって、過去 60 年間のコンピューティング手法が変わると考えています。企業が生成 AI をあらゆる製品、サービス、ビジネス プロセスに適用しようと競う中、数兆ドル規模の世界的なデータセンター インフラストラクチャは汎用コンピューティングからアクセラレーテッド コンピューティングに移行し、その結果として生じるデータセンターの再発明は、確実に巨大な市場機会を生み出すでしょう。前四半期の決算に関する電話会議で、Huang Renxun 氏は次のように誓いました。「私たちは 10 年にわたるデータセンター インテリジェンスの最初の年にいます。」Huang Renxun 氏は、「アクセラレーテッド コンピューティングはフルスタックの課題です。すべてのソフトウェア、すべてのフレームワーク ライブラリ、エンジニアリングのためのすべてのアルゴリズムを統合する必要があります。これらのタスクは、チップだけでなくデータセンター全体に当てはまります。」と述べました。データセンターはスーパーコンピュータであり、最高のパフォーマンスを実現するには、ネットワーク オペレーティング システム、分散コンピューティング エンジン、ネットワーク デバイス、スイッチ、コンピューティング アーキテクチャのフルスタックを最適化する必要があります。例えば、一般的なコンピューティングデータセンターは主にイーサネットを使用して大規模なデータ伝送を行わずにすべてのサーバーを接続しますが、Nvidiaが提案するアクセラレーテッドコンピューティングデータセンターは、データスループットが非常に高いInfinite Bandと呼ばれる技術を接続に使用します。また、体系的な最適化により、アクセラレーテッド コンピューティング データ センターは、従来のデータ センターよりも高い効率と低いコストを実現できます。Huang Renxun は、今年 8 月に開催された年次コンピュータ グラフィックス カンファレンスである SIGGRAPH で、「1 億ドルで何を買えるでしょうか?」という質問を提起しました。Huang Renxun は自問し、次のように答えました。 8,800 個の x86 CPU、消費電力は 5MW、現在 1 億米ドルで 2500 個の GH200 で構成される Iso-Budget データセンターを購入できます、消費電力は 3MW、AI 推論性能は CPU データの 12 倍です前述のセンターを使用し、エネルギー効率は20倍です。」同じ AI 推論パフォーマンスの下で、GPU データセンターのコストは CPU データセンターのコストのわずか 1/12 です。 「買えば買うほど、節約になります。」 これは、Huang Renxun の Accelerated Computing Data Center に対するマニフェストです。Nvidia はこれまでに 5 つのデータセンターを構築し、世界中の顧客が独自のデータセンターを構築できるよう支援してきました。さらに、従来のデータセンターでは納品から稼働までに数か月、場合によっては 1 年かかる場合がありますが、Nvidia ではそれが異なります。今回は数週間です。 「この分野におけるチームの専門知識は注目に値します」とファン氏は語った。クラウド大手 3 社にとって、汎用コンピューティング データセンターからアクセラレーテッド コンピューティング データセンターへの移行はすぐには進まないでしょう。これはテクノロジーや能力だけでなく、このような巨大企業の意思決定やプロセスにも関係します。これにより、Nvidia にクラウドを実行する機会が与えられます。データセンターからクラウドへの一歩を踏み出すことは当然のことであり、Nvidia はすでにそうしようとしています。## **3. ダークネス・チェンチャン**データセンター ビジネスの成長率が最も低い 2023 年第 4 四半期財務報告書で、Nvidia は新製品 DGX Cloud も発表しました。 1 か月後の GTC カンファレンスで、DGX Cloud が正式にリリースされました。名前からもわかるように、クラウドサービス製品です。 Nvidia はクラウド コンピューティング市場に参入する予定ですか?まず、DGX とは何かを見てみましょう。 DGX は、Nvidia が 2017 年にリリースした最初のスーパーコンピューターであり、Huang Renxun 氏は「シャーシ内のデータセンター」と呼んでいました。第 1 世代の DGX は 8 つの GPU (Tesla P100) と 4 つのソリッド ステート ドライブを統合し、NVIDIA NVlink 接続テクノロジを使用しました。ディープ ラーニング トレーニングの観点から見ると、1 台の DGX のパフォーマンスは、通常の x86 サーバー 250 台に相当します。もちろん、1台あたり12万9000ドルと高価でもある。会談後、黄仁勲氏はイーロン・マスク氏に最初のDGX-1を贈呈した。マスク氏は OpenAI の共同創設者で、OpenAI はこのスーパーコンピューターから始まり、段階的に今日の ChatGPT を構築しました。現在、DGX スーパーコンピュータは第 5 世代まで開発されており、最初の 4 世代は DGX P100、DGX A100、DGX H100、そして最新の DGX GH200 です。NvidiaがリリースしたDGX Cloudは、以前リリースされていたスーパーコンピュータのクラウド版であり、DGX Cloudインスタンス(クラウドサーバー上の仮想コンピュータ)は8台のA100またはH100で構成されます。ただし、DGX Cloud の価格は月額 36,999 ドル、約 264,000 人民元と決して安くはありません。比較として、8 台の A100 と同等の仕様を備えた Microsoft Azure ND96asr インスタンスの月額料金は 19,854 ドルで、これは DGX Cloud のわずか半分です。なぜNVIDIAはあえてこれほど高い価格を設定するのでしょうか?答えは、DGX Cloud がソフトウェアとハードウェアを統合したターンキー ソリューションであるということです。 **Nvidia はもはや GPU チップ会社として自社を宣伝していませんが、コンピューティング プラットフォーム会社として自社を位置づけています。 **ハードウェア リソースに加えて、DGX Cloud は 2 つのサポート ソフトウェア プラットフォームもリリースしました。1 つは、企業が言語、視覚、生物医学モデルを含むカスタム モデルを作成できるようにする NVIDIA AI Foundations で、もう 1 つは 4,000 の異なるモデルを含む NVIDIA AI Enterprise です。企業がすぐに使える AI フレームワーク。 NvidiaのAI製品は、Alibaba Cloudなど国内のクラウドサービスプロバイダーが開始するMaaSに似ている。Huang 氏は、これらの新しいソフトウェア収益源について楽観的であり、生成 AI 分野の収益が、会社の総収益の「一桁」部分から、来年以内に「かなりの」部分に成長すると予想しています。 「私たちは新しいビジネスモデルの拡大に興奮しています。」と黄仁勲氏は語った。DGX Cloud の開始により、客観的にはクラウド サービス プロバイダーと一定の競争関係が形成されましたが、Nvidia は引き続きクラウド サービス プロバイダーとの緊密な協力関係を維持したいと考えています。 Nvidia は現在、完全なクラウド インフラストラクチャを最初から構築するのではなく、さまざまなクラウド サービス プロバイダーのクラウド プラットフォーム上で DGX Cloud をホストしています。Nvidia は、基本的なハードウェア設備をクラウド ベンダーに販売し、次にクラウド コンピューティング リソースをそこから購入し、最後にクラウド サービスを企業顧客に販売して、すべての収益を保持します。お客様はブラウザ経由でのみ Nvidia の AI スーパーコンピューターにアクセスし、Nvidia の AI 製品および AI モデル サービスを利用できます。しかし、クラウドサービスプロバイダーはそれを買うでしょうか?この点に関して、Huang Renxun 氏は、「NVIDIA クラウド サービスとクラウド サービス プロバイダーの協力は、双方にとって有利な状況になります。両者は共同で新しいアプリケーションを作成し、新しい市場を開拓します。」と説明し、理想的には顧客が製品を購入することになると述べました。 NVIDIA DGX クラウドとクラウド サービス プロバイダーのクラウドの比率は 1:9 です。オラクルは、Nvidia との提携を発表した最初のクラウド サービス プロバイダーです。ソフトウェア大手は近年、クラウド変革を急務としており、クラウドコンピューティング市場で立て直しを図るためにエヌビディアと提携する動機は十分にある。 Nvidia は、Microsoft Azure、Google Cloud、およびその他のクラウド プラットフォームとも連携しており、これらも間もなく開始される予定です。** Nvidia の希望的観測は大声で聞こえますが、すべてのクラウド サービス プロバイダーが Nvidia の要求を受け入れるわけではありません。 **AWS は、DGX Cloud 製品に関して Nvidia との協力を拒否しました。ロイター通信によると、Amazon Elastic Cloud Computing 担当副社長の Dave Brown 氏は、「NVIDIA から連絡があり、ビジネスモデルを検討しました。しかし、AWS にとって、これはあまり意味がありません。」と述べ、AWS には構築する能力があると信じています。信頼性の高いサーバー、既存のサプライ チェーンの専門知識に関する長期にわたる経験。AWSは今年3月にNvidiaのH100チップの購入を開始したが、それは自社開発システムの一部としてのみだった。 AWSはAMDの最新人工知能チップ「MI300」の利用も検討しているが、まだ最終決定には至っていない。新興の生成 AI 市場に直面して、Nvidia とクラウド サービス プロバイダーの間の利益の配分は変化し続けるでしょう。しかし、Nvidia がクラウド サービス プロバイダーの地位を変えたことは明らかです。## **4. 底から排水します**DGX Cloud の立ち上げは最初のステップにすぎず、クラウド コンピューティング市場への Nvidia の参加はさらに深まっています。このステップにおいて、Nvidia は単独で終了することを選択せず、クラウド大手 3 社の競合他社をサポートすることを選択しました。今年はCoreWeaveという中小規模のクラウドベンダーが台頭し、クラウド大手3社を上回る人気のクラウドサービスプロバイダーとなった。 **CoreWeave は、「Nvidia H100 を大規模に提供できる」世界で唯一のクラウド サービス プロバイダーであると主張しています。 **GPU Utils Web サイトの推定によると、CoreWeave が Nvidia に発注した H100 の数は約 35,000 ~ 40,000 台です。比較すると、今年 5 月に Google がリリースしたスーパーコンピューター A3 には約 26,000 の H100 が含まれており、7 月に Amazon AWS がリリースした EC2 P5 仮想マシン インスタンスは 20,000 の H100 に基づいており、8 月に Microsoft がリリースした Azure ND H100v5 仮想マシンには、 H100は8個のみ。ただし、Microsoft は約 285,000 台の A100 を所有しています。 CoreWeaveの起源は何ですか? 2017年に設立された同社は、当初は主にイーサリアム仮想通貨マイニング事業に従事し、2018年には北米最大のイーサリアムマイナーとなった。当時、CoreWeave は 50,000 個を超える GPU を導入し、イーサリアム ネットワークのコンピューティング能力の 1% 以上を提供していました。CoreWeave はマイニングに加えて、人工知能、エンターテイメント メディア、計算化学などの一部の企業顧客にもサービスを提供しようと試み始めています。 2019 年に、CoreWeave はコンシューマー グレードの GPU から Nvidia のエンタープライズ グレードの GPU に完全に移行しました。エンタープライズ グレードの GPU は 24 時間稼働でき、GPU の使用率がほぼ 100% に増加するためです。2021 年、CoreWeave は Nvidia ベースの GPU クラウド プラットフォームを正式に開始しました。 2022 年の第 3 四半期には、イーサリアムの合併と大規模グラフィックス カード マイニングの時代の終焉により、CoreWeave はクラウド サービス プロバイダーに完全に変身し、今年 11 月にその最初のグループになったと発表しました。 NVIDIA HGX H100 スーパー チップを使用するプロバイダーの 1 つであり、クラウド サービス プロバイダーの 1 つです。Amazon、Microsoft、Google の 3 つの巨人と比較して、CoreWeave は独自の AI チップを開発する予定はなく、Nvidia はこれを高く評価しています。2023 年 4 月、Nvidia は CoreWeave との協力を深め、事業協力に加えて CoreWeave の 2 億 2,100 万ドルの B1 ラウンドの資金調達にも投資しました。最も重要なのは、Nvidia が CoreWeave に希少な A100 および H100 用の独自のチャネルを提供したことです。CoreWeaveの共同創設者兼最高戦略責任者であるBrannin McBee氏は、ブルームバーグとの最近のインタビューで、NVIDIAは今年自社のチップを完売しており、CoreWeaveの発注は来年第2四半期に予定されていると述べた。CoreWeave はおそらく、世界で最大の Nvidia GPU を在庫しています。現在の GPU 不足の状況では、チップは株式よりもさらに価値があり、CoreWeave は革新的な資金調達方法を作成しました。今年 8 月、CoreWeave は GPU チップを抵当に入れることで 23 億ドルの資金調達を確保しました。以前、CoreWeave の株式融資 B1 ラウンドでは 4 億 2,100 万ドルしか調達されませんでした。Nvidia との「クラウド + GPU」戦略的提携により、CoreWeave のパフォーマンスも飛躍的に向上しました。今年まで、CoreWeave はほとんど知られていない会社でした。しかし現在、CoreWeave は GPU を通じて数十億ドルを稼ごうとしている。 VentureBeat とのインタビューで、CoreWeave の共同創設者兼最高戦略責任者の Brannin McBee 氏は、CoreWeave の 2022 年の収益が 3,000 万米ドルになり、今年は 5 億米ドルに達し、来年には 20 億米ドル近くの契約を締結したことを明らかにしました。CoreWeaveはまた、テキサス州に16億ドルをかけて新たなデータセンターを建設することを発表し、年末までに14のデータセンターに拡張する計画を立てている。現在、AI スターのユニコーンである Inflection は、CoreWeave のクラウドを使用して、約 22,000 個の H100 からなる GPU クラスターを構築しており、今年 7 月に 13 億ドルの新たな資金調達ラウンドを発表しました。 NVIDIA も Inflection の投資家の一人であることは言及する価値があります。CoreWeave は、Nvidia が今年投資した最初のクラウド コンピューティング企業ですが、それだけではありません。The Information によると、Nvidia はもう 1 つのクラウド サービス プロバイダーである Lambda Labs と投資契約に達しようとしており、Nvidia は 3 億米ドルを投資する可能性があり、Lambda Labs の評価額は 10 億米ドルを超える可能性があります。 Lambda Labs は、NVIDIA A100 および H100 のコンピューティング電源リソースを世界最安値で提供できると主張しています。現在、NVIDIA は GPU リソースの「合理的な」割り当てにより、実質的な意味でクラウド コンピューティング市場のトレーダーとなり、クラウド巨人のハンドルを根から握っています。Microsoft はその良い例です。Microsoftは最新の収益報告書に「データセンターに十分な人工知能チップを確保できない場合、サービスが中断される可能性がある」という新たなリスク要因を追加した。膨大な AI コンピューティングのニーズに直面して、Microsoft の GPU 負荷は不足しており、競合他社である中小規模のクラウド ベンダーにも支援を求めなければなりません。 CNBC によると、Microsoft は「今後数年間で数十億ドルを投じて新興企業 CoreWeave のクラウド コンピューティング インフラストラクチャを買収することに同意した」とのこと。 Nvidia の管理下で、Microsoft は CoreWeave のような中小規模のクラウド サービス プロバイダーが GPU との価格差を獲得できるようにする必要がありました。Nvidia は中小規模のクラウド サービス プロバイダーに投資することで、クラウド コンピューティングの分野に足を踏み入れました。クラウド インフラストラクチャを構築してクラウド大手と直接競合する試みはありませんが、将来 Nvidia が中小規模のクラウド サービス プロバイダーを買収することで市場に直接参入しても驚かないでしょう。Nvidia が最終的にこのゲームに参入するかどうかに関係なく、NVIDIA は生成 AI の波の中でクラウド コンピューティング市場の舞台裏の最大のプレーヤーとなっています。

Nvidia とクラウド巨人は戦う必要がある

著者: 趙建

出典:Jiazi Guangnian

「食べるために走るか、他人に食べられないために走るか。どちらにしても走り続けなさい。」

これは、今年の国立台湾大学でのスピーチの中で、NVIDIA CEO 黄仁勲氏が卒業生に向けて述べたメッセージですが、もちろん、黄仁勲氏が築いたこの数兆ドルの時価総額帝国のメンタリティの解釈でもあります。

2023 年、逃走中の Nvidia は、Huang Renxun が何度も「AI の iPhone の瞬間」と呼んだ生成 AI に遭遇しました。この瞬間、黄仁勲は獲物ではなく狩人になる機会、ユンに目を向けました。

クラウド サービス プロバイダーは Nvidia の重要な顧客であり、毎年 Nvidia から数十億ドルの GPU を購入しているためだけでなく、この問題には勝ち目がないように見えるため、Nvidia がクラウドを行う動機を持つべきではないと思われます。

今日のクラウド コンピューティング市場は、Amazon AWS、Microsoft Azure、Google Cloud という 3 つのクラウド巨人によってしっかりと支配されています。 Statistaのデータによると、2022年の市場シェアはAWSが32%、Azureが23%、Google Cloudが10%となり、3社を合わせると65%に達すると予想されている。

挑戦者が現れなかったわけではない。過去 10 年間、VMware、Dell、Hewlett-Packard などの有名企業はいずれもクラウド コンピューティング市場に参入しようとしましたが、例外なく失敗しました。

しかし、あらゆる技術革新が新たなトレンドセッター、つまり生成 AI の波を生み出すのと同じように、チップ メーカー Nvidia はクラウド コンピューティング市場を段階的にテストし始めました。

**最初のステップとして、今年 3 月 21 日の GTC カンファレンスで、NVIDIA は DGX Cloud をリリースしました。 **名前からわかるように、これはクラウド製品であり、顧客は月単位でレンタルすることで、クラウドまたはローカル データセンターにある Nvidia の AI 製品とサービスを直接入手できます。

**第 2 のステップは、クラウド大手 3 社の競合他社に投資することです。 **NVIDIA は、米国の中小規模のクラウド サービス プロバイダーである CoreWeave と Lambda Labs に相次いで投資し、希少な GPU チップを割り当ててきました。この「好み」はどれほど誇張されているのでしょうか? GPU コアの入手が困難な現在、CoreWeave は豊富な GPU、特に H100 を抵当に入れることで 23 億米ドルの負債資金を調達することができました。

始まったばかりではあるが、クラウド ビジネスのレイアウトはクラウド大手に対する Nvidia の反撃を表している。

周知のとおり、Google、Amazon、Microsoft は、Google の TPU シリーズ、Amazon の Inferentia および Trainium シリーズ、そして今年公開された Microsoft の Athena チップなど、自社開発の AI チップ プロジェクトを相次いで社内で立ち上げてきました。クラウド大手3社は、エヌビディアの「GPU税」を削減するためにAIチップを自社開発する十分なリソースと意欲を持っている。

Nvidia はこのことを十分に認識しています。黄仁勲氏は前四半期決算報告の電話会見で、「われわれは競争に注意を払ってきたし、常に競争は存在してきた」と率直に語った。

Huang Renxun は 3 つの大手クラウド サービス プロバイダーの拡大を防ぐことはできませんが、おそらく最大の防御は攻撃であり、Nvidia の反撃方法は直接クラウドに向かうことです。

A100 と H100 という 2 つの切り札が長期間にわたって手元にあるため、これら 2 つのチップは大規模モデルのトレーニングと推論に最適な選択肢ですが、いずれも Nvidia には真のリーダーになる機会がありません。クラウドコンピューティング市場の裏方オペレーター。

世界時価総額トップ5に入るテクノロジー巨人4社の間で、チップとクラウドコンピューティングを巡る公然かつ秘密の戦いがゆっくりと展開している。

1. 夜明け前に落ちそうになりました

Nvidia に詳しい人なら、今日の Nvidia がどれほど美しいか、そして昨年の Nvidia がどれほど悲惨だったかを知っているでしょう。

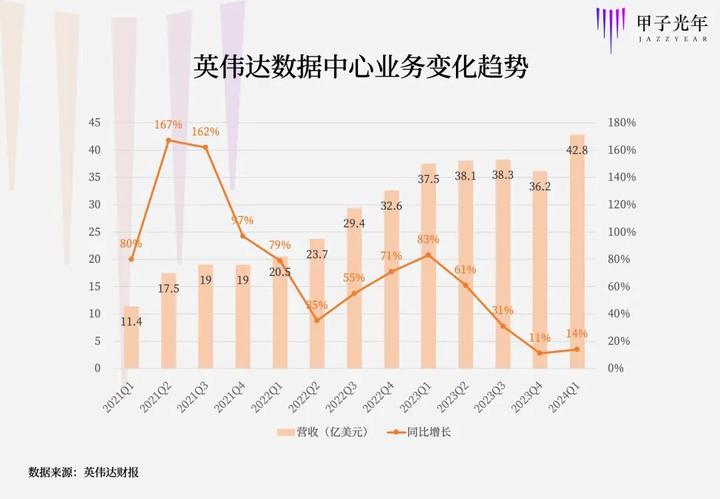

Nvidia の中核事業には、データ センター、ゲーム、プロフェッショナル ビジュアライゼーション、自動車が含まれます。 2020 年第 2 四半期に、Nvidia のデータセンター ビジネスは初めてゲームを上回り、Nvidia の最大の収益源になりました。

2022 年第 4 四半期財務報告会 (自然年では 2021 年 11 月から 2022 年 1 月に相当) で、Nvidia は好調な第 4 四半期財務報告書を発表し、データセンター事業は前年同期比 71% 増加しました。 Huang Renxun 氏は当時、「NVIDIA のコンピューティング プラットフォームが異常な市場需要をもたらした」と楽観的に語っていたが、その 1 週間後にロシアとウクライナの間で紛争が勃発し、主要原材料のサプライチェーンが混乱した。感染症流行の影響と相まって、Nvidiaのデータセンター事業の成長率は2022年を通じて鈍化し続けるだろう。

今年 2 月に発表された 2023 年第 4 四半期の財務報告書では、NVIDIA データセンターの成長率はわずか 11% で過去最低を記録し、2020 年以来初めてチェーンが減少しました。

2022年にはエヌビディアの株価も半減する。もちろん、今日では再び上昇しており、ChatGPT の誕生が Nvidia を救いました。

事業成長の鈍化の理由は数多くありますが、その中でも最も警戒すべきは大口顧客からの需要の減少です。 2023年第4四半期の財務報告書で、NVIDIAのCFOコレット・クレス氏は次の数字を発表した:2023会計年度のデータセンター部門の収益150億ドルのうち約40%(約60億ドル)はハイパースケールデータセンターとクラウドサービスによるものだプロバイダー。

しかし、第 4 四半期だけを見てみると、それはわずか 4 分の 1 に過ぎません。ハイパースケール データセンターの構築者やクラウド サービス プロバイダーは、GPU への支出を大幅に削減しています。

客観的な需要の減少に加えて、クラウド大手 3 社の自社開発 AI チップ計画が NVIDIA GPU の市場シェアを少しずつ侵食しています。

Google は 2016 年に第 1 世代の自社開発 AI チップ TPU を発売し、5 年後の 2021 年 5 月 19 日に第 4 世代 TPU v4 を発売しました。今年発表された調査報告書の中で、Google は、4,000 個の TPU v4 をつなぎ合わせて、Nvidia A100 GPU を搭載した同等のマシンよりも 1.7 倍、1.9 倍高速かつ効率的に動作するスーパーコンピューターを構築したと述べました。

Amazon には、Nvidia だけでなく、すべてのチップ メーカー向けにチップを自社開発する伝統もあります。現在、Amazonは自社開発チップの4シリーズ(ネットワークチップNitroシリーズ、サーバーチップGravitonシリーズ、AI推論チップInferentiaシリーズ、AIトレーニングチップTrainium)を発売している。このうち、後者の 2 つの AI チップは NVIDIA GPU と競合します。

Microsoftは参入が遅れたにもかかわらず、「遅れて参入」した。今年4月18日、The Informationによると、Microsoftは2019年以来、社内コードネーム「Athena」(アテナ)と呼ばれるAIチップを極秘に開発しており、数百人の従業員がAthenaプロジェクトに取り組んでおり、Microsoftは約20億ドルを投資しているとのこと。 Microsoft と OpenAI の一部の従業員は、GPT-4 などの最新の大規模言語モデルでのパフォーマンスをテストするためのチップを入手することができました。

クラウド サービス プロバイダーは、特に生成 AI の発生後、GPU の購入に対して多額の「Nvidia 税」を毎年支払わなければなりません。

今年 2 月、New Street Research は、ChatGPT に基づく Bing 検索エンジンが 1 秒以内にユーザーの質問に応答するには 8 つの GPU が必要であるとの見積もりを出しました。このままでは、Bing のモデルをすべてのユーザーに展開するには、Microsoft が 8 GPU を搭載した 20,000 台を超えるサーバーが必要となり、それには 40 億ドルの費用がかかることになります。 1 日あたり 80 ~ 90 億のクエリを処理する Google の規模では、800 億ドルの費用がかかることになります。

クラウドサービスプロバイダーが自社開発したAIチップは外部には販売されず、Nvidiaと直接競合することはない。ただし、データセンターに GPU の代わりに自社開発のチップを導入することで、コストを効果的に削減できます。たとえば、Google はクラウド サービスに数百台の TPU v4 スーパーコンピューターを導入しました。

大手クラウド サービス プロバイダー 3 社には、独自のチップを開発するための十分なリソースと動機があり、これは Nvidia 帝国の亀裂と見なされています。 Nvidia はこのことを十分に認識していますが、これより良い方法はないようです。

ChatGPTが登場するまで、クラウドサービスプロバイダーから段階的に迫られていたNvidiaに、反撃の突破口が見えた。クラウドサービスプロバイダーがチップを作れるのだから、AI時代のクラウドはNVIDIAが作れないだろうか?

**2. Nvidia にはクラウドを行うチャンスがありますか? **

Nvidia は現在、生成 AI 革命の最大の受益者であり、Huang Renxun 氏は今年、常に「AI の iPhone の瞬間」について語ってきました。生成 AI の爆発的な需要により、GPU はハード通貨になりました。「GPU は新しいドルだ」と単純に言う人もいます。

GPU からクラウドまで、Nvidia には本当にチャンスがあるのでしょうか?

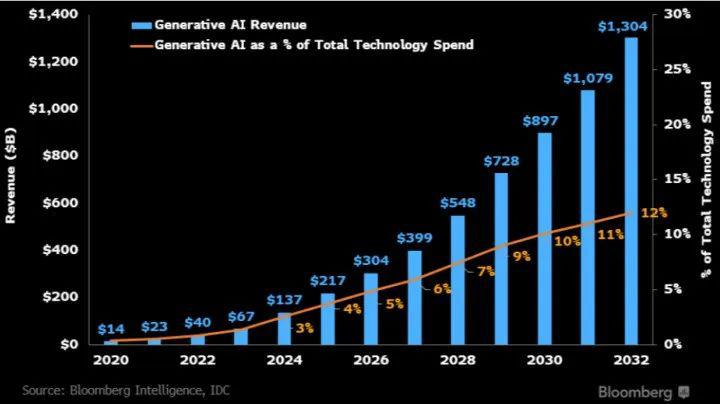

生成型 AI のトレーニングと推論は主にクラウド上で行われ、AI インフラストラクチャを提供するクラウド サービス プロバイダーは生成型 AI の波の最大の受益者の 1 つとなります。シリコンバレーのベンチャーキャピタル会社 A16Z が推定したデータによると、生成 AI によって生み出される総収益の 10% ~ 20% が、最終的にクラウド サービス プロバイダーに流れます。

ただし、このプロセスはすぐには進みません。 Amazon CEOのアンディ・ジャシー氏は2023年第2四半期の決算会見で、「生成AIは間違いなくほぼすべての顧客のエクスペリエンスを変えるだろう。しかし、まだ時期尚早で、ほとんどの企業はこの目標を達成する方法をまだ検討しているところだ。われわれにとってこれはマラソンのようなものだ」と語った。非常に初期の段階です。」

クラウドサービスの本質は、データセンター内のハードウェアリソースを仮想化し、市場にリースすることです。従来のデータセンターのサーバーのほぼ 100% は Intel および AMD CPU をベースに構築されており、CPU はオペレーティング システム、システム ソフトウェア、アプリケーション プログラムの処理といった「汎用コンピューティング」機能を提供する「最強の頭脳を備えたジェネラリスト」のようなものです。複雑な命令のスケジューリング、ループ、分岐、論理判断、実行などのプログラムタスクがあります。

しかし、CPU は人工知能に必要な大規模なデータ処理や並列コンピューティングが苦手であり、Nvidia GPU が得意としています。 GPU は「暴力的なコンピューティングの専門家」のようなもので、画像処理、深層学習、現在の大規模モデルのトレーニング、推論、その他のタスクに特化しています。 Huang Renxun 氏は、この超並列コンピューティング機能を「アクセラレーション コンピューティング」と呼びました。

2012 年、ディープ ラーニングの父であるジェフ ヒントンとその弟子たちは、初めて NVIDIA GPU 上で畳み込みニューラル ネットワーク モデル AlexNet のトレーニングを試み、画像認識コンテストで一気に優勝しました。この事件により、その後 10 年間でディープラーニングが爆発的に普及し、Nvidia 自体を含む人工知能業界全体が、高速コンピューティングにおける GPU の可能性に気づきました。

Nvidia の運命の歯車が回り始めました。それ以来、黄仁勲氏は何度も「ムーアの法則は死んだ」と叫んだ。同氏は、CPU を拡張する時代は終わり、同じコストで 5 年ごとにパフォーマンスが 10 倍向上する時代は終わったと考えています。それはGPUに置き換えられ、黄仁訓氏は特別に「黄の法則」を発明しました。GPUはAIのパフォーマンスを年々倍増させます。

2012 年から 2022 年までの 10 年間は、0 から 1 へのアクセラレーション コンピューティングと呼ぶことができ、人工知能は画像認識などの特定の業界や特定のシナリオに上陸しました。しかし、この時期の AI の需要はまだ十分大きくなく、調査会社 Aletheia は、現在の AI サーバーの市場普及率は 5% 未満であると予測しています。これは、高速コンピューティングという Huang Renxun の夢を実現するには十分ではありません。

2022年11月にChatGPTが誕生するまでは、「AI iPhone moment」が登場しました。これは、アクセラレーション コンピューティングの 1 から 10 へのスケールアップの始まりと見ることができます。

Huang Renxun 氏は、アクセラレーテッド コンピューティングと生成 AI の組み合わせによって、過去 60 年間のコンピューティング手法が変わると考えています。企業が生成 AI をあらゆる製品、サービス、ビジネス プロセスに適用しようと競う中、数兆ドル規模の世界的なデータセンター インフラストラクチャは汎用コンピューティングからアクセラレーテッド コンピューティングに移行し、その結果として生じるデータセンターの再発明は、確実に巨大な市場機会を生み出すでしょう。

前四半期の決算に関する電話会議で、Huang Renxun 氏は次のように誓いました。「私たちは 10 年にわたるデータセンター インテリジェンスの最初の年にいます。」

Huang Renxun 氏は、「アクセラレーテッド コンピューティングはフルスタックの課題です。すべてのソフトウェア、すべてのフレームワーク ライブラリ、エンジニアリングのためのすべてのアルゴリズムを統合する必要があります。これらのタスクは、チップだけでなくデータセンター全体に当てはまります。」と述べました。データセンターはスーパーコンピュータであり、最高のパフォーマンスを実現するには、ネットワーク オペレーティング システム、分散コンピューティング エンジン、ネットワーク デバイス、スイッチ、コンピューティング アーキテクチャのフルスタックを最適化する必要があります。

例えば、一般的なコンピューティングデータセンターは主にイーサネットを使用して大規模なデータ伝送を行わずにすべてのサーバーを接続しますが、Nvidiaが提案するアクセラレーテッドコンピューティングデータセンターは、データスループットが非常に高いInfinite Bandと呼ばれる技術を接続に使用します。

また、体系的な最適化により、アクセラレーテッド コンピューティング データ センターは、従来のデータ センターよりも高い効率と低いコストを実現できます。

Huang Renxun は、今年 8 月に開催された年次コンピュータ グラフィックス カンファレンスである SIGGRAPH で、「1 億ドルで何を買えるでしょうか?」という質問を提起しました。Huang Renxun は自問し、次のように答えました。 8,800 個の x86 CPU、消費電力は 5MW、現在 1 億米ドルで 2500 個の GH200 で構成される Iso-Budget データセンターを購入できます、消費電力は 3MW、AI 推論性能は CPU データの 12 倍です前述のセンターを使用し、エネルギー効率は20倍です。」

同じ AI 推論パフォーマンスの下で、GPU データセンターのコストは CPU データセンターのコストのわずか 1/12 です。 「買えば買うほど、節約になります。」 これは、Huang Renxun の Accelerated Computing Data Center に対するマニフェストです。

Nvidia はこれまでに 5 つのデータセンターを構築し、世界中の顧客が独自のデータセンターを構築できるよう支援してきました。さらに、従来のデータセンターでは納品から稼働までに数か月、場合によっては 1 年かかる場合がありますが、Nvidia ではそれが異なります。今回は数週間です。 「この分野におけるチームの専門知識は注目に値します」とファン氏は語った。

クラウド大手 3 社にとって、汎用コンピューティング データセンターからアクセラレーテッド コンピューティング データセンターへの移行はすぐには進まないでしょう。これはテクノロジーや能力だけでなく、このような巨大企業の意思決定やプロセスにも関係します。

これにより、Nvidia にクラウドを実行する機会が与えられます。データセンターからクラウドへの一歩を踏み出すことは当然のことであり、Nvidia はすでにそうしようとしています。

3. ダークネス・チェンチャン

データセンター ビジネスの成長率が最も低い 2023 年第 4 四半期財務報告書で、Nvidia は新製品 DGX Cloud も発表しました。 1 か月後の GTC カンファレンスで、DGX Cloud が正式にリリースされました。

名前からもわかるように、クラウドサービス製品です。 Nvidia はクラウド コンピューティング市場に参入する予定ですか?

まず、DGX とは何かを見てみましょう。 DGX は、Nvidia が 2017 年にリリースした最初のスーパーコンピューターであり、Huang Renxun 氏は「シャーシ内のデータセンター」と呼んでいました。

第 1 世代の DGX は 8 つの GPU (Tesla P100) と 4 つのソリッド ステート ドライブを統合し、NVIDIA NVlink 接続テクノロジを使用しました。ディープ ラーニング トレーニングの観点から見ると、1 台の DGX のパフォーマンスは、通常の x86 サーバー 250 台に相当します。もちろん、1台あたり12万9000ドルと高価でもある。

会談後、黄仁勲氏はイーロン・マスク氏に最初のDGX-1を贈呈した。マスク氏は OpenAI の共同創設者で、OpenAI はこのスーパーコンピューターから始まり、段階的に今日の ChatGPT を構築しました。

現在、DGX スーパーコンピュータは第 5 世代まで開発されており、最初の 4 世代は DGX P100、DGX A100、DGX H100、そして最新の DGX GH200 です。

NvidiaがリリースしたDGX Cloudは、以前リリースされていたスーパーコンピュータのクラウド版であり、DGX Cloudインスタンス(クラウドサーバー上の仮想コンピュータ)は8台のA100またはH100で構成されます。

ただし、DGX Cloud の価格は月額 36,999 ドル、約 264,000 人民元と決して安くはありません。比較として、8 台の A100 と同等の仕様を備えた Microsoft Azure ND96asr インスタンスの月額料金は 19,854 ドルで、これは DGX Cloud のわずか半分です。

なぜNVIDIAはあえてこれほど高い価格を設定するのでしょうか?答えは、DGX Cloud がソフトウェアとハードウェアを統合したターンキー ソリューションであるということです。 **Nvidia はもはや GPU チップ会社として自社を宣伝していませんが、コンピューティング プラットフォーム会社として自社を位置づけています。 **

ハードウェア リソースに加えて、DGX Cloud は 2 つのサポート ソフトウェア プラットフォームもリリースしました。1 つは、企業が言語、視覚、生物医学モデルを含むカスタム モデルを作成できるようにする NVIDIA AI Foundations で、もう 1 つは 4,000 の異なるモデルを含む NVIDIA AI Enterprise です。企業がすぐに使える AI フレームワーク。 NvidiaのAI製品は、Alibaba Cloudなど国内のクラウドサービスプロバイダーが開始するMaaSに似ている。

Huang 氏は、これらの新しいソフトウェア収益源について楽観的であり、生成 AI 分野の収益が、会社の総収益の「一桁」部分から、来年以内に「かなりの」部分に成長すると予想しています。 「私たちは新しいビジネスモデルの拡大に興奮しています。」と黄仁勲氏は語った。

DGX Cloud の開始により、客観的にはクラウド サービス プロバイダーと一定の競争関係が形成されましたが、Nvidia は引き続きクラウド サービス プロバイダーとの緊密な協力関係を維持したいと考えています。 Nvidia は現在、完全なクラウド インフラストラクチャを最初から構築するのではなく、さまざまなクラウド サービス プロバイダーのクラウド プラットフォーム上で DGX Cloud をホストしています。

Nvidia は、基本的なハードウェア設備をクラウド ベンダーに販売し、次にクラウド コンピューティング リソースをそこから購入し、最後にクラウド サービスを企業顧客に販売して、すべての収益を保持します。お客様はブラウザ経由でのみ Nvidia の AI スーパーコンピューターにアクセスし、Nvidia の AI 製品および AI モデル サービスを利用できます。

しかし、クラウドサービスプロバイダーはそれを買うでしょうか?

この点に関して、Huang Renxun 氏は、「NVIDIA クラウド サービスとクラウド サービス プロバイダーの協力は、双方にとって有利な状況になります。両者は共同で新しいアプリケーションを作成し、新しい市場を開拓します。」と説明し、理想的には顧客が製品を購入することになると述べました。 NVIDIA DGX クラウドとクラウド サービス プロバイダーのクラウドの比率は 1:9 です。

オラクルは、Nvidia との提携を発表した最初のクラウド サービス プロバイダーです。ソフトウェア大手は近年、クラウド変革を急務としており、クラウドコンピューティング市場で立て直しを図るためにエヌビディアと提携する動機は十分にある。 Nvidia は、Microsoft Azure、Google Cloud、およびその他のクラウド プラットフォームとも連携しており、これらも間もなく開始される予定です。

** Nvidia の希望的観測は大声で聞こえますが、すべてのクラウド サービス プロバイダーが Nvidia の要求を受け入れるわけではありません。 **AWS は、DGX Cloud 製品に関して Nvidia との協力を拒否しました。

ロイター通信によると、Amazon Elastic Cloud Computing 担当副社長の Dave Brown 氏は、「NVIDIA から連絡があり、ビジネスモデルを検討しました。しかし、AWS にとって、これはあまり意味がありません。」と述べ、AWS には構築する能力があると信じています。信頼性の高いサーバー、既存のサプライ チェーンの専門知識に関する長期にわたる経験。

AWSは今年3月にNvidiaのH100チップの購入を開始したが、それは自社開発システムの一部としてのみだった。 AWSはAMDの最新人工知能チップ「MI300」の利用も検討しているが、まだ最終決定には至っていない。

新興の生成 AI 市場に直面して、Nvidia とクラウド サービス プロバイダーの間の利益の配分は変化し続けるでしょう。しかし、Nvidia がクラウド サービス プロバイダーの地位を変えたことは明らかです。

4. 底から排水します

DGX Cloud の立ち上げは最初のステップにすぎず、クラウド コンピューティング市場への Nvidia の参加はさらに深まっています。このステップにおいて、Nvidia は単独で終了することを選択せず、クラウド大手 3 社の競合他社をサポートすることを選択しました。

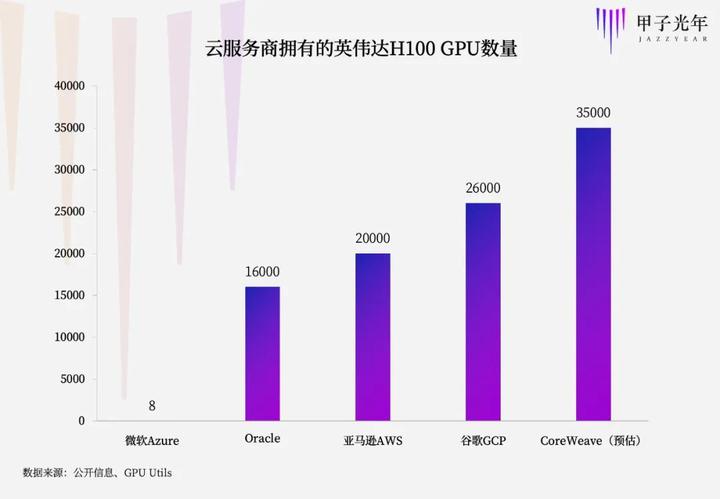

今年はCoreWeaveという中小規模のクラウドベンダーが台頭し、クラウド大手3社を上回る人気のクラウドサービスプロバイダーとなった。 **CoreWeave は、「Nvidia H100 を大規模に提供できる」世界で唯一のクラウド サービス プロバイダーであると主張しています。 **

GPU Utils Web サイトの推定によると、CoreWeave が Nvidia に発注した H100 の数は約 35,000 ~ 40,000 台です。比較すると、今年 5 月に Google がリリースしたスーパーコンピューター A3 には約 26,000 の H100 が含まれており、7 月に Amazon AWS がリリースした EC2 P5 仮想マシン インスタンスは 20,000 の H100 に基づいており、8 月に Microsoft がリリースした Azure ND H100v5 仮想マシンには、 H100は8個のみ。ただし、Microsoft は約 285,000 台の A100 を所有しています。

CoreWeave はマイニングに加えて、人工知能、エンターテイメント メディア、計算化学などの一部の企業顧客にもサービスを提供しようと試み始めています。 2019 年に、CoreWeave はコンシューマー グレードの GPU から Nvidia のエンタープライズ グレードの GPU に完全に移行しました。エンタープライズ グレードの GPU は 24 時間稼働でき、GPU の使用率がほぼ 100% に増加するためです。

2021 年、CoreWeave は Nvidia ベースの GPU クラウド プラットフォームを正式に開始しました。 2022 年の第 3 四半期には、イーサリアムの合併と大規模グラフィックス カード マイニングの時代の終焉により、CoreWeave はクラウド サービス プロバイダーに完全に変身し、今年 11 月にその最初のグループになったと発表しました。 NVIDIA HGX H100 スーパー チップを使用するプロバイダーの 1 つであり、クラウド サービス プロバイダーの 1 つです。

Amazon、Microsoft、Google の 3 つの巨人と比較して、CoreWeave は独自の AI チップを開発する予定はなく、Nvidia はこれを高く評価しています。

2023 年 4 月、Nvidia は CoreWeave との協力を深め、事業協力に加えて CoreWeave の 2 億 2,100 万ドルの B1 ラウンドの資金調達にも投資しました。最も重要なのは、Nvidia が CoreWeave に希少な A100 および H100 用の独自のチャネルを提供したことです。

CoreWeaveの共同創設者兼最高戦略責任者であるBrannin McBee氏は、ブルームバーグとの最近のインタビューで、NVIDIAは今年自社のチップを完売しており、CoreWeaveの発注は来年第2四半期に予定されていると述べた。

CoreWeave はおそらく、世界で最大の Nvidia GPU を在庫しています。現在の GPU 不足の状況では、チップは株式よりもさらに価値があり、CoreWeave は革新的な資金調達方法を作成しました。今年 8 月、CoreWeave は GPU チップを抵当に入れることで 23 億ドルの資金調達を確保しました。以前、CoreWeave の株式融資 B1 ラウンドでは 4 億 2,100 万ドルしか調達されませんでした。

Nvidia との「クラウド + GPU」戦略的提携により、CoreWeave のパフォーマンスも飛躍的に向上しました。

今年まで、CoreWeave はほとんど知られていない会社でした。しかし現在、CoreWeave は GPU を通じて数十億ドルを稼ごうとしている。 VentureBeat とのインタビューで、CoreWeave の共同創設者兼最高戦略責任者の Brannin McBee 氏は、CoreWeave の 2022 年の収益が 3,000 万米ドルになり、今年は 5 億米ドルに達し、来年には 20 億米ドル近くの契約を締結したことを明らかにしました。

CoreWeaveはまた、テキサス州に16億ドルをかけて新たなデータセンターを建設することを発表し、年末までに14のデータセンターに拡張する計画を立てている。現在、AI スターのユニコーンである Inflection は、CoreWeave のクラウドを使用して、約 22,000 個の H100 からなる GPU クラスターを構築しており、今年 7 月に 13 億ドルの新たな資金調達ラウンドを発表しました。 NVIDIA も Inflection の投資家の一人であることは言及する価値があります。

CoreWeave は、Nvidia が今年投資した最初のクラウド コンピューティング企業ですが、それだけではありません。

The Information によると、Nvidia はもう 1 つのクラウド サービス プロバイダーである Lambda Labs と投資契約に達しようとしており、Nvidia は 3 億米ドルを投資する可能性があり、Lambda Labs の評価額は 10 億米ドルを超える可能性があります。 Lambda Labs は、NVIDIA A100 および H100 のコンピューティング電源リソースを世界最安値で提供できると主張しています。

現在、NVIDIA は GPU リソースの「合理的な」割り当てにより、実質的な意味でクラウド コンピューティング市場のトレーダーとなり、クラウド巨人のハンドルを根から握っています。Microsoft はその良い例です。

Microsoftは最新の収益報告書に「データセンターに十分な人工知能チップを確保できない場合、サービスが中断される可能性がある」という新たなリスク要因を追加した。

膨大な AI コンピューティングのニーズに直面して、Microsoft の GPU 負荷は不足しており、競合他社である中小規模のクラウド ベンダーにも支援を求めなければなりません。 CNBC によると、Microsoft は「今後数年間で数十億ドルを投じて新興企業 CoreWeave のクラウド コンピューティング インフラストラクチャを買収することに同意した」とのこと。 Nvidia の管理下で、Microsoft は CoreWeave のような中小規模のクラウド サービス プロバイダーが GPU との価格差を獲得できるようにする必要がありました。

Nvidia は中小規模のクラウド サービス プロバイダーに投資することで、クラウド コンピューティングの分野に足を踏み入れました。クラウド インフラストラクチャを構築してクラウド大手と直接競合する試みはありませんが、将来 Nvidia が中小規模のクラウド サービス プロバイダーを買収することで市場に直接参入しても驚かないでしょう。

Nvidia が最終的にこのゲームに参入するかどうかに関係なく、NVIDIA は生成 AI の波の中でクラウド コンピューティング市場の舞台裏の最大のプレーヤーとなっています。