元のソース: 量子ビット 画像ソース: Unbounded AI によって生成ChatGPT のコード インタプリタは自分のコンピュータ上で実行できます。あるマスターがコード インタプリタのローカル バージョンを GitHub にリリースしたところ、すぐに GitHub ホット リストのトップに 3,000 以上の星を付けました。GPT-4が本来持っていた機能を備えているだけでなく、インターネットにも接続できるのがポイントだ。 ChatGPTの「切断」のニュースが出た後、大騒ぎになり、それは数か月間続きました。インターネット機能はここ数か月間沈黙していましたが、現在は解決策があります。コードはローカルで実行されるため、ネットワークに加えて、Web バージョンの他の多くの問題も解決します。* 3 時間で送信できるメッセージは 50 件までです* サポートされる Python モジュールの数には限りがあります※処理ファイルサイズには制限があり、100MBを超えることはできません* セッションウィンドウを閉じると、以前に生成されたファイルは削除されますAPI がない場合は、オープンソースの Code LLaMa にモデルを変更することもできます。このコードインタープリタのリリース後、一部のネチズンはすぐに Web バージョンへの期待を表明しました。 それでは、このローカル コード インタープリターがどのようなものかを見てみましょう。## **GPT を「再接続」させます**GPT-4のAPIを呼び出すので、当然GPT-4でサポートされている機能はすべて利用でき、もちろん中国語にも対応しています。GPT 自体の機能については、ここでは詳しく説明しません。ただし、コード インタプリタの追加により、GPT の数学的レベルが数レベル向上したことは言及する価値があります。そこで、ここでは難しい導出問題を使ってテストします。タイトルは f(x)=√(x+√(x+√x)) です。 うーん...この結果は少し抽象的ですが、プロンプトの単語に問題があるはずです。変更してみましょう。 すると、次の結果が表示されます。 この式は標準の回答とは異なっているように見えますが、形式の問題でしょうか?私たちはそれを検証しました: 結果は正解です!ここからがメインイベントです。このコード インタプリタのネットワーク機能がギミックであるかどうかを見てみましょう。たとえば、最近どんなニュースがあったのかを知りたいとします。 プログラムはまず必要なモジュールがインストールされているかどうかを確認し、インストールされていない場合は自動的にインストールされ、Web ページの取得が開始されます。ローカルで実行していない場合に Web ページ全体を一度読んで、画面上でスクロールするコードを見るのは、確かに少し震えていると言わざるを得ません... 次に、プログラムはニュースのタイトルがネットユーザーに保存されているフィールドを分析し、抽出します。 幸いなことに、多くのトラブルの後、最終的に私たちが望んでいた結果が得られました。 単独で検索させるだけでなく、特定の Web ページを分析対象として指定することもできます。 もう一度必死にロードした後、コード インタプリタは自己紹介を正常に再現しました。 そこでChatGPTのオンライン版が再現されていますが、さらに高度な機能はあるのでしょうか?もちろん!たとえば、システム設定を調整したいのですが、その方法がわかりません。Web バージョンを使用する場合は、テキスト説明の長いリストが表示される可能性が高くなりますが、今ではそれをコード インタプリタに渡すだけで済みます。理解できないチュートリアルの大きなセクションを提供する代わりに、コードが自動的に実行され、ワンステップで直接完了します。 GPT-4 でコードを生成できるようにするだけでなく、コード ウェアハウス内の一部のツールを GPT-4 を通じて呼び出すこともできます。たとえば、ビデオに字幕を追加したい場合は、複製時に既製の音声認識モジュールを呼び出すことができます。手元に既製の資料がないため、開発者が提供したデモを以下に示します。 コードの実行プロセスはローカルで実行されるため、ビデオ サイズが制限を超えることを心配する必要はありません。つまり、正常に実行されると、ビデオの下に字幕が表示されることがわかります。 同様に、この機能を使用してドキュメントや画像を生成および変更したり、ControlNet を呼び出して静的な画像からアニメーションを生成したりすることができます。理論的には、十分なパフォーマンスがあれば、Python でできることはすべて実行できます。では、このネイティブ コード インタープリターを体験するにはどうすればよいでしょうか?## **インストール方法**著者は GitHub プロジェクト ページ (記事の最後にあるリンク) に Colab ノートを投稿しており、資格のあるネチズンは直接 Colab ノートを体験することができます。ローカル インストールも非常に簡単で (Python がインストールされている場合)、必要なコードは「pip install open-interpreter」コードを 1 行だけ実行するだけです。インストール後、ターミナルに「interpreter」と入力すると直接起動します。 これはプログラムが GPT-4 に要求する API です。3.5 のみの場合は、起動時に "interpreter --fast" を使用します。3.5 をお持ちでない場合は、このステップで直接 Enter キーを押すか、起動時に「interpreter —local」と直接入力して Code-LLaMA に切り替えることができます。これらには、7B、13B、および 34B の 3 つのバージョンがあり、サイズが小さいほど速度が速くなり、サイズが大きいほど結果の精度が高くなります。Code-LLaMA がインストールされていない場合は、プログラムの指示に従うことで自動的にインストールされます。 なお、デフォルトではコード生成後に実行前に確認が必要となりますが、毎回確認したくない場合は起動時にコマンドの後に「space-y」を追加することも可能です。ここでは一般的に使用されるコマンドを紹介しますが、より高度なゲームプレイを知りたい場合は、作者の Colab ノートを参照してください。気に入ったら、今すぐ試してください!GitHub プロジェクト ページ:

GitHub ホット リストのトップ: GPT-4 コード インタープリターのオープン ソース バージョン。任意の Python ライブラリをインストールしてローカル ターミナルで実行できます。

元のソース: 量子ビット

ChatGPT のコード インタプリタは自分のコンピュータ上で実行できます。

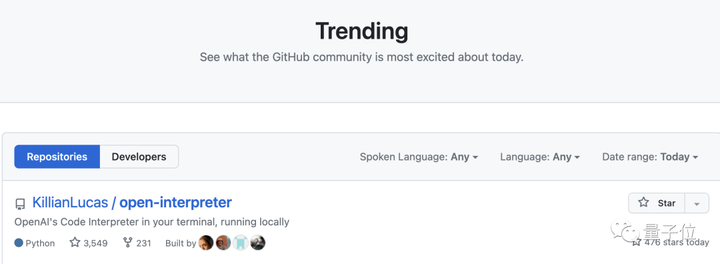

あるマスターがコード インタプリタのローカル バージョンを GitHub にリリースしたところ、すぐに GitHub ホット リストのトップに 3,000 以上の星を付けました。

GPT-4が本来持っていた機能を備えているだけでなく、インターネットにも接続できるのがポイントだ。

インターネット機能はここ数か月間沈黙していましたが、現在は解決策があります。

コードはローカルで実行されるため、ネットワークに加えて、Web バージョンの他の多くの問題も解決します。

API がない場合は、オープンソースの Code LLaMa にモデルを変更することもできます。

このコードインタープリタのリリース後、一部のネチズンはすぐに Web バージョンへの期待を表明しました。

GPT を「再接続」させます

GPT-4のAPIを呼び出すので、当然GPT-4でサポートされている機能はすべて利用でき、もちろん中国語にも対応しています。

GPT 自体の機能については、ここでは詳しく説明しません。

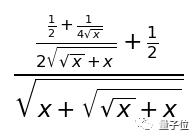

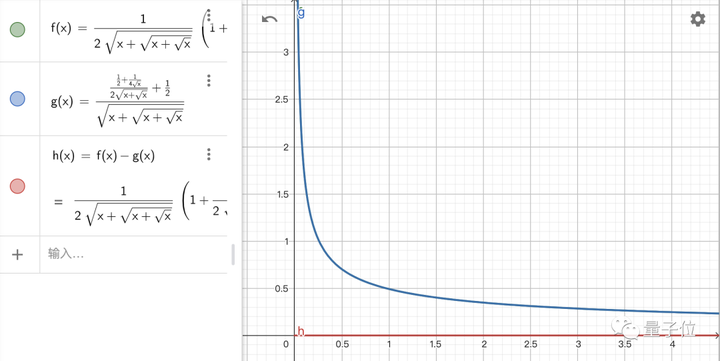

ただし、コード インタプリタの追加により、GPT の数学的レベルが数レベル向上したことは言及する価値があります。

そこで、ここでは難しい導出問題を使ってテストします。タイトルは f(x)=√(x+√(x+√x)) です。

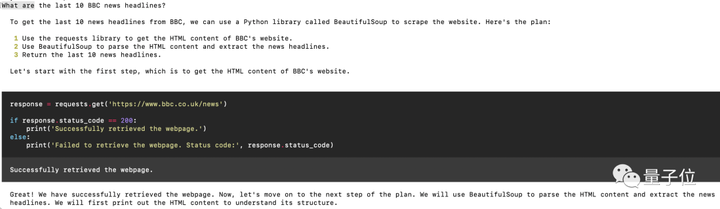

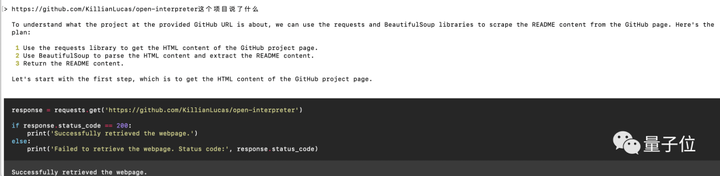

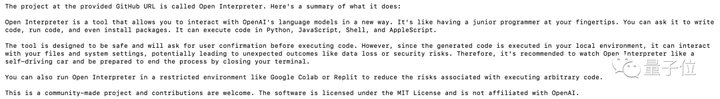

ここからがメインイベントです。このコード インタプリタのネットワーク機能がギミックであるかどうかを見てみましょう。

たとえば、最近どんなニュースがあったのかを知りたいとします。

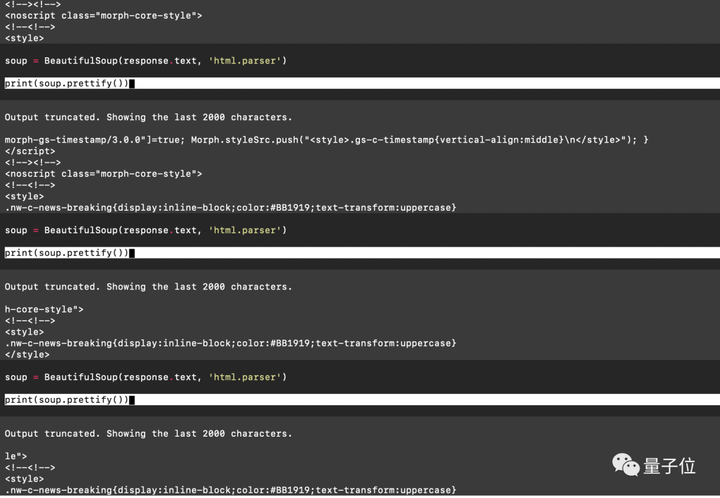

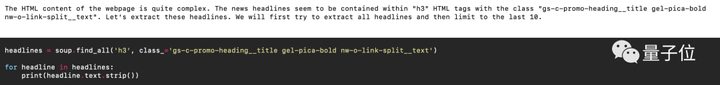

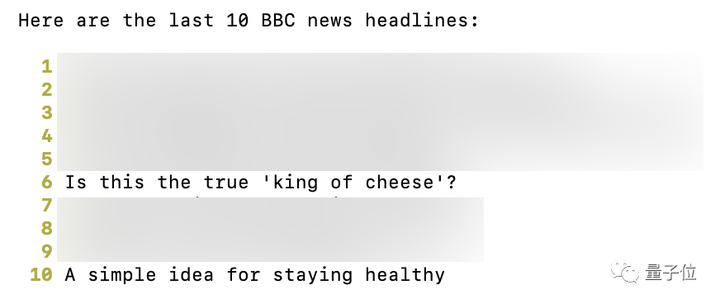

ローカルで実行していない場合に Web ページ全体を一度読んで、画面上でスクロールするコードを見るのは、確かに少し震えていると言わざるを得ません...

もちろん!たとえば、システム設定を調整したいのですが、その方法がわかりません。

Web バージョンを使用する場合は、テキスト説明の長いリストが表示される可能性が高くなりますが、今ではそれをコード インタプリタに渡すだけで済みます。

理解できないチュートリアルの大きなセクションを提供する代わりに、コードが自動的に実行され、ワンステップで直接完了します。

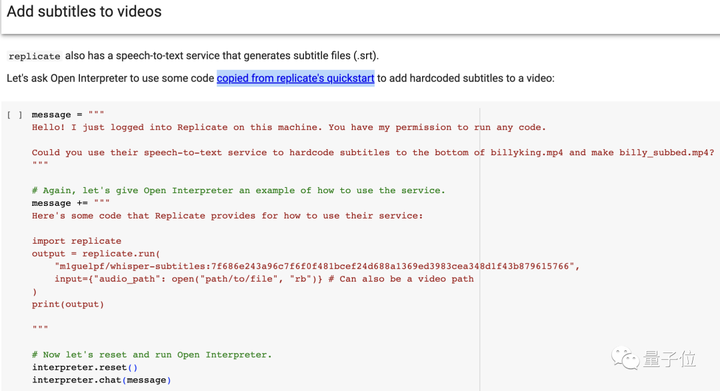

たとえば、ビデオに字幕を追加したい場合は、複製時に既製の音声認識モジュールを呼び出すことができます。

手元に既製の資料がないため、開発者が提供したデモを以下に示します。

つまり、正常に実行されると、ビデオの下に字幕が表示されることがわかります。

理論的には、十分なパフォーマンスがあれば、Python でできることはすべて実行できます。

では、このネイティブ コード インタープリターを体験するにはどうすればよいでしょうか?

インストール方法

著者は GitHub プロジェクト ページ (記事の最後にあるリンク) に Colab ノートを投稿しており、資格のあるネチズンは直接 Colab ノートを体験することができます。

ローカル インストールも非常に簡単で (Python がインストールされている場合)、必要なコードは「pip install open-interpreter」コードを 1 行だけ実行するだけです。

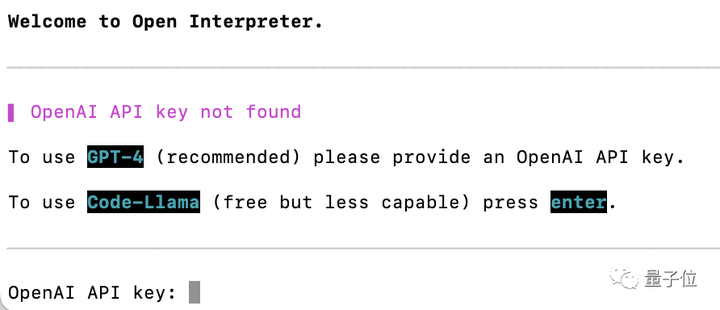

インストール後、ターミナルに「interpreter」と入力すると直接起動します。

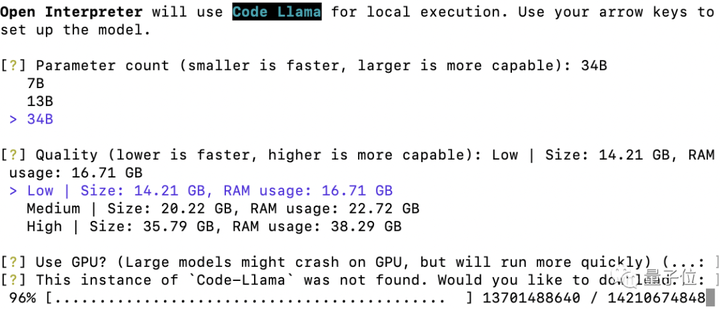

3.5 をお持ちでない場合は、このステップで直接 Enter キーを押すか、起動時に「interpreter —local」と直接入力して Code-LLaMA に切り替えることができます。

これらには、7B、13B、および 34B の 3 つのバージョンがあり、サイズが小さいほど速度が速くなり、サイズが大きいほど結果の精度が高くなります。

Code-LLaMA がインストールされていない場合は、プログラムの指示に従うことで自動的にインストールされます。

ここでは一般的に使用されるコマンドを紹介しますが、より高度なゲームプレイを知りたい場合は、作者の Colab ノートを参照してください。

気に入ったら、今すぐ試してください!

GitHub プロジェクト ページ: