元のソース: 量子ビット 画像ソース: Unbounded AI によって生成3 年間「奇妙な病気」に苦しみ、治療を求めましたが無駄でした。最終的に、彼は **ChatGPT** によって診断に成功しました。これは4歳の男の子に起こった実際の体験です。ある運動をした後、彼は体に激しい痛みを感じ始めました。母親は彼女を連れて小児科、整形外科、さまざまな専門医に至る**17人の医師**に診察を受けさせ、MRIなどの一連の検査を受けさせましたが、誰も本当の原因を突き止めることはできませんでした。彼の母親はあまり期待せずにChatGPTに助けを求めようとしたが、ChatGPTは説明と検査報告書に基づいて直接適切なアドバイスをくれた。 この話題が出てくるとすぐに、Zhihu のホット リストに掲載され、Reddit の人気も 2.3k まで急上昇しました。 一部のネチズンは、今回の GPT は本当にエキサイティングだと言いました:> すべての診療所に AI アシスタントを配置し、それを独自の診断と比較できるようになります。 一部のネチズンは、Google によって特別にトレーニングされた大規模な補助医療診断モデルである Med-PaLM からヒントを得て、その診断結果を知りたいと考えていました。> これは、大規模モデルのほぼ完璧なテスト タスクです。 いったい何が起こっているのでしょうか?## **どんな「奇病」なのでしょうか? **物語の主人公はアレックスという名前で、彼の母親コートニーには2人の子供がいます。2020年のある日、アレックスの乳母はコートニーさんに、アレックスは毎日鎮痛剤を服用しなければならない、そうしないと痛みで倒れてしまうだろうと告げた。その後、アレックスさんは再び歯ぎしりをし始めましたが、両親はこの 2 つのことを結びつけ、歯の交換や虫歯による痛みが原因ではないかと考えました。そこで母親はアレックスを歯医者に連れて行き、アレックスの治療を求める3年間の旅が正式に始まった。歯科医は検査の結果、問題は見つかりませんでしたが、アレックスが歯ぎしりをしているため、気道閉塞の治療を専門とする**矯正歯科医**に診てもらうよう勧めました。 歯科矯正医は、アレックスの上顎が小さすぎて呼吸が困難であることに気づき、拡張器をアレックスに装着しました。この治療法は確かに効果があり、母親はかつてアレックスの病気はすぐに治ると思っていた。それは合理的ですが、現実は非論理的なことがよくあります。彼女の母親は、まだ4歳だったアレックスが突然体重が減ったことにすぐに気づきました。 今回、母親は**小児科医**に助けを求めました。医師たちはアレックスがコロナウイルスに感染した可能性があると考えたが、母親はこの説明に満足していなかった。しかし、母は2021年の初めにアレックスを診察に連れて行きました。医師は母親に、アレックスの身長は「少し伸びた」と話したが、アレックスの左右の足のバランスがややアンバランスであることに気づき、理学療法を選択するよう提案した。今回、母親は医師の言葉を信じたが、理学療法が始まる前にアレックスさんは再び頭痛の症状を発症し、症状はますますひどくなった。物理治疗的事只好先搁置一下,母亲先带Alex去看**神经(内) 医師はアレックスが片頭痛に苦しんでいると結論づけた。アレックスは頭痛と闘っている一方で、疲労感の症状にも悩まされていたため、睡眠に影響を与える副鼻腔の問題がないかどうかを調べるために耳鼻咽喉科の医師の診察を受けました。紆余曲折を経て、アレックスはキアリ奇形という先天性の病気ではないかと理学療法士**に疑われ、ようやく理学療法を受けるようになりました。この先天性疾患は、頭蓋骨と脊椎が接する脳に異常を引き起こします。母親はこれについて調べ始め、アレックスを連れて新しい小児科医、**小児内科**の医師、**成人内科**の医師、**筋骨格内科の医師の診察を受けました。最終的にアレックスは 17 人もの医師を受診し、考えられる限りのほぼすべての診療科を受診し、救急外来に運ばれたこともありましたが、それでも原因は突き止められませんでした。 **ChatGPT が事件全体の 180 度逆転を引き起こすまで。 **母は「やってみよう」という気持ちで、ChatGPT アカウントを登録しました。彼女はアレックスの症状と MRI レポートのメモを入力しました。その中には、アレックスがあぐらをかいて座ることができなかったという詳細も含まれていました。ChatGPT により、**係留索症候群** (TCS) という診断が下されました。もちろん、コートニーさんはそれを直接信じたわけではなく、答えを得た後、まずFacebookで子育て中の親向けのコミュニケーショングループを見つけた。この議論を読んだ後、母はこれらの症状がアレックスの症状に非常に似ていると感じました。この発見により、消えかけていた希望の火が再び燃え上がり、その後、母は一晩中コンピューターの前に座ってすべてを経験したことを思い出しました。 この結論とアレックスの MRI レポートにより、私は脳神経外科医を見つけました。今度はようやく適切な人物が見つかり、その医師はMRIを見てChatGPTと同じ結論に達し、テザーの具体的な位置を指摘してくれました。その後は物事がよりスムーズに進みました。アレックスは手術を受け、現在回復中だ。では、なぜアレックスは 18 人目の医師に診てもらうまで最終的な診断を受けられなかったのでしょうか? **まず第一に**、これはアレックス自身と関係があります。TCS患者は背中に裂傷を発症することがよくありますが、アレックスには、潜伏性コード症候群(OTCS)と呼ばれる症状である裂傷はありませんでした。TCS は稀な疾患ではありますが、新生児における発生率は約 0.005 ~ 0.025% と低くはなく、白血病よりも高くなります。###**  **### **△**Chen Yingge、Mi Yang. 妊娠中に多発した胎児の発育異常の一例 [J] . 臨床医学の進歩、2023 年、13(2)しかし、OTCS は比較的まれであり、非常にまれであるため、発生率はまったく計算されていません。でも結局、物語の最後で外科医はMRI画像を見て即断したんです。**つまり**、以前の診断の失敗はおそらく「間違った医師」のせいでした。17人の医師のうち、手術に従事していた医師は一人もいませんでした。もちろんそれは当たり前のことであり、結局のところ、彼らはそれぞれの専門分野に長けた専門医(総合診療医に相当)なので、専門外の知識を網羅的に理解していないのは仕方のないことです。しかし、これは問題も露呈しており、説明のつかない問題が発生した場合、これらの医師は**学際的な診察**を行うことを考慮しておらず、アレックスの病歴を十分に尋ねたかどうかは不明です。母親のコートニーさんの言葉を借りれば、「(自分の専門分野を超えた)より大きな問題」を解決しようとする人は誰もおらず、診断についての手がかりを与える人もいなかったという。ChatGPT の知識ベースは、少なくとも細分化された分野の専門家よりもはるかに幅広く、Alex の状況をより包括的に考慮して、最終的には正しい結論を導き出します。では、ChatGPTが今回診断に成功したのは間違いなのでしょうか、それとも実際に診断機能はあるのでしょうか?## **AI は診断に使用できますか? **実際、誰かが病気の診断ツールとして ChatGPT または GPT-4 を使用したのはこれが初めてではありません。たとえば、GPT-4 が登場して間もなく、誰かが GPT-4 を使用して **自分の犬 ** の症例を診断することに成功し、この経験はかつてインターネット上で爆発的に広まりました。 彼はGPT-4に対し、最初の発症からの犬の症状、治療過程、各血液検査レポートについて次のように語った。20日に41.5度の発熱があり、血液検査の結果(血液検査結果添付)より医師により犬バベシア症と診断され、その後3日間抗生物質の治療を受けました。歯茎が青くなった (新しい血液検査結果が添付されました。血液検査結果)。GPT-4 はすぐに検出結果を提供し、会話の中で次の 2 つの理由が原因である可能性があることを示しました。> 1. 溶血: 免疫介在性溶血性貧血 (IMHA)、毒素、バベシア症以外の感染症など、さまざまな理由による赤血球の破壊。> 2. 失血: 外傷、手術、または胃腸の問題 (潰瘍や寄生虫など) によって引き起こされる内出血または外出血。 医師の最終診断により、犬は確かに免疫介在性溶血性貧血(IMHA)を患っていたことが判明し、適切な薬が投与されたことで犬は救われた。さらに、一部のネチズンも ChatGPT (GPT-4) による救命体験を報告しました。ジムに行った後、全身が痛くなり、GPT-4に症状を相談したところ、「横紋筋融解症」という答えが得られ、すぐに病院に行ったが、結果として死亡した。 ただし、一部の学術研究では、ChatGPT も GPT-4 も完全に信頼できる AI ドクターではないと述べています。たとえば、ハーバード大学の関連病院であるブリガム アンド ウィメンズ病院 (BWH) が JAMA に発表した研究では、がん治療の推奨を行う際に、ChatGPT が完全に正しいのは 62% の症例のみであることが示されました。 他のケースでは、提案の 34% に正しい診断と矛盾する回答が少なくとも 1 つ以上含まれており、ケースの 2% はありそうもない診断を下しました。 この点において、ChatGPT や GPT-4 に診断を完全に任せることはできず、結局のところ、診断プロセスにおいては依然として専門の医師と比較することはできないと研究は考えています。(ただし、一部のネチズンはChatGPTが診断に失敗した理由は訓練データにも関係している可能性があると指摘しており、2021年以降の治療情報は含まれていない)この点に関して、ハーバード大学の疫学助教授であるアンドリュー・ビーム氏は、ChatGPT と GPT-4 の影響は 2 つの側面から見るべきであると考えています。> 一方で、これらは通常の診断ソフトウェアや Google 検索エンジン、特に GPT-4 バージョンよりも使いやすいです。> しかしその一方で、十分な専門知識を持つ臨床医に取って代わられる可能性はまだ高くありません。結局のところ、AIにとって、答えが見つからない場合に情報を捏造したり、「幻覚」に基づいて間違った結果を推測したりすることは確かに可能です。米国医師会(AMA)会長のジェシー・M・エーレンフェルド氏は、たとえAIが結果を診断できたとしても、最終的な責任は医師自身にあると述べた。上記の観点をまとめると、誰もが AI を使用して病気の診断を支援でき、検索エンジンよりも簡単に使用できますが、最終的には依然として病院に行って診断のために医師を探す必要があります。では、「お問い合わせ相談」に大型モデルを利用する場合、どの大型モデルを使用するのが最適なのでしょうか。一部のネチズンは、さまざまな大規模な言語モデルに診断機能があるかどうかをテストするためのケースとして利用し、最終的に **GPT-4** の方がより機能的であると考えました。> 慢性的な咳の原因について何人かの医師に相談しましたが、最終的に YouTube チャンネルで LPR (潜在性喉頭咽頭逆流症) であることを知りました。> 私自身のケースで大規模モデルをテストしたところ、診断に成功したのは **GPT-4** だけでした。クロード 2 はほぼ同じ答えを出しましたが、完全に独立して診断することはできませんでした。 AI を使って自分の状態を診断してみたことがありますか?どんな感じですか?参考リンク:[1][2][3]

ChatGPT ヘルプ! 4歳の男児が3年間にわたり17人の専門家に治療を求めたが効果はなく、大型模型が病気の原因を正確に突き止めた。

元のソース: 量子ビット

3 年間「奇妙な病気」に苦しみ、治療を求めましたが無駄でした。最終的に、彼は ChatGPT によって診断に成功しました。

これは4歳の男の子に起こった実際の体験です。

ある運動をした後、彼は体に激しい痛みを感じ始めました。母親は彼女を連れて小児科、整形外科、さまざまな専門医に至る17人の医師に診察を受けさせ、MRIなどの一連の検査を受けさせましたが、誰も本当の原因を突き止めることはできませんでした。

彼の母親はあまり期待せずにChatGPTに助けを求めようとしたが、ChatGPTは説明と検査報告書に基づいて直接適切なアドバイスをくれた。

**どんな「奇病」なのでしょうか? **

物語の主人公はアレックスという名前で、彼の母親コートニーには2人の子供がいます。

2020年のある日、アレックスの乳母はコートニーさんに、アレックスは毎日鎮痛剤を服用しなければならない、そうしないと痛みで倒れてしまうだろうと告げた。

その後、アレックスさんは再び歯ぎしりをし始めましたが、両親はこの 2 つのことを結びつけ、歯の交換や虫歯による痛みが原因ではないかと考えました。

そこで母親はアレックスを歯医者に連れて行き、アレックスの治療を求める3年間の旅が正式に始まった。

歯科医は検査の結果、問題は見つかりませんでしたが、アレックスが歯ぎしりをしているため、気道閉塞の治療を専門とする矯正歯科医に診てもらうよう勧めました。

それは合理的ですが、現実は非論理的なことがよくあります。

彼女の母親は、まだ4歳だったアレックスが突然体重が減ったことにすぐに気づきました。

医師たちはアレックスがコロナウイルスに感染した可能性があると考えたが、母親はこの説明に満足していなかった。しかし、母は2021年の初めにアレックスを診察に連れて行きました。

医師は母親に、アレックスの身長は「少し伸びた」と話したが、アレックスの左右の足のバランスがややアンバランスであることに気づき、理学療法を選択するよう提案した。

今回、母親は医師の言葉を信じたが、理学療法が始まる前にアレックスさんは再び頭痛の症状を発症し、症状はますますひどくなった。

アレックスは頭痛と闘っている一方で、疲労感の症状にも悩まされていたため、睡眠に影響を与える副鼻腔の問題がないかどうかを調べるために耳鼻咽喉科の医師の診察を受けました。

紆余曲折を経て、アレックスはキアリ奇形という先天性の病気ではないかと理学療法士**に疑われ、ようやく理学療法を受けるようになりました。

この先天性疾患は、頭蓋骨と脊椎が接する脳に異常を引き起こします。

母親はこれについて調べ始め、アレックスを連れて新しい小児科医、小児内科の医師、成人内科の医師、**筋骨格内科の医師の診察を受けました。

最終的にアレックスは 17 人もの医師を受診し、考えられる限りのほぼすべての診療科を受診し、救急外来に運ばれたこともありましたが、それでも原因は突き止められませんでした。

母は「やってみよう」という気持ちで、ChatGPT アカウントを登録しました。

彼女はアレックスの症状と MRI レポートのメモを入力しました。その中には、アレックスがあぐらをかいて座ることができなかったという詳細も含まれていました。

ChatGPT により、係留索症候群 (TCS) という診断が下されました。

もちろん、コートニーさんはそれを直接信じたわけではなく、答えを得た後、まずFacebookで子育て中の親向けのコミュニケーショングループを見つけた。

この議論を読んだ後、母はこれらの症状がアレックスの症状に非常に似ていると感じました。

この発見により、消えかけていた希望の火が再び燃え上がり、その後、母は一晩中コンピューターの前に座ってすべてを経験したことを思い出しました。

今度はようやく適切な人物が見つかり、その医師はMRIを見てChatGPTと同じ結論に達し、テザーの具体的な位置を指摘してくれました。

その後は物事がよりスムーズに進みました。アレックスは手術を受け、現在回復中だ。

では、なぜアレックスは 18 人目の医師に診てもらうまで最終的な診断を受けられなかったのでしょうか?

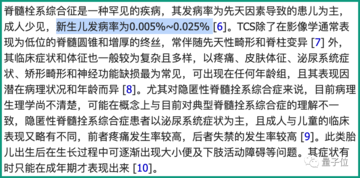

TCS患者は背中に裂傷を発症することがよくありますが、アレックスには、潜伏性コード症候群(OTCS)と呼ばれる症状である裂傷はありませんでした。

TCS は稀な疾患ではありますが、新生児における発生率は約 0.005 ~ 0.025% と低くはなく、白血病よりも高くなります。

** **### △Chen Yingge、Mi Yang. 妊娠中に多発した胎児の発育異常の一例 [J] . 臨床医学の進歩、2023 年、13(2)

**### △Chen Yingge、Mi Yang. 妊娠中に多発した胎児の発育異常の一例 [J] . 臨床医学の進歩、2023 年、13(2)

しかし、OTCS は比較的まれであり、非常にまれであるため、発生率はまったく計算されていません。

でも結局、物語の最後で外科医はMRI画像を見て即断したんです。

つまり、以前の診断の失敗はおそらく「間違った医師」のせいでした。17人の医師のうち、手術に従事していた医師は一人もいませんでした。

もちろんそれは当たり前のことであり、結局のところ、彼らはそれぞれの専門分野に長けた専門医(総合診療医に相当)なので、専門外の知識を網羅的に理解していないのは仕方のないことです。

しかし、これは問題も露呈しており、説明のつかない問題が発生した場合、これらの医師は学際的な診察を行うことを考慮しておらず、アレックスの病歴を十分に尋ねたかどうかは不明です。

母親のコートニーさんの言葉を借りれば、「(自分の専門分野を超えた)より大きな問題」を解決しようとする人は誰もおらず、診断についての手がかりを与える人もいなかったという。

ChatGPT の知識ベースは、少なくとも細分化された分野の専門家よりもはるかに幅広く、Alex の状況をより包括的に考慮して、最終的には正しい結論を導き出します。

では、ChatGPTが今回診断に成功したのは間違いなのでしょうか、それとも実際に診断機能はあるのでしょうか?

**AI は診断に使用できますか? **

実際、誰かが病気の診断ツールとして ChatGPT または GPT-4 を使用したのはこれが初めてではありません。

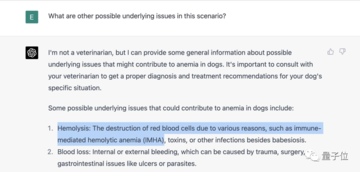

たとえば、GPT-4 が登場して間もなく、誰かが GPT-4 を使用して **自分の犬 ** の症例を診断することに成功し、この経験はかつてインターネット上で爆発的に広まりました。

20日に41.5度の発熱があり、血液検査の結果(血液検査結果添付)より医師により犬バベシア症と診断され、その後3日間抗生物質の治療を受けました。歯茎が青くなった (新しい血液検査結果が添付されました。血液検査結果)。

GPT-4 はすぐに検出結果を提供し、会話の中で次の 2 つの理由が原因である可能性があることを示しました。

さらに、一部のネチズンも ChatGPT (GPT-4) による救命体験を報告しました。

ジムに行った後、全身が痛くなり、GPT-4に症状を相談したところ、「横紋筋融解症」という答えが得られ、すぐに病院に行ったが、結果として死亡した。

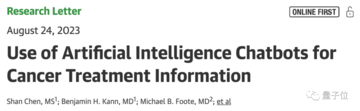

たとえば、ハーバード大学の関連病院であるブリガム アンド ウィメンズ病院 (BWH) が JAMA に発表した研究では、がん治療の推奨を行う際に、ChatGPT が完全に正しいのは 62% の症例のみであることが示されました。

(ただし、一部のネチズンはChatGPTが診断に失敗した理由は訓練データにも関係している可能性があると指摘しており、2021年以降の治療情報は含まれていない)

この点に関して、ハーバード大学の疫学助教授であるアンドリュー・ビーム氏は、ChatGPT と GPT-4 の影響は 2 つの側面から見るべきであると考えています。

米国医師会(AMA)会長のジェシー・M・エーレンフェルド氏は、たとえAIが結果を診断できたとしても、最終的な責任は医師自身にあると述べた。

上記の観点をまとめると、誰もが AI を使用して病気の診断を支援でき、検索エンジンよりも簡単に使用できますが、最終的には依然として病院に行って診断のために医師を探す必要があります。

では、「お問い合わせ相談」に大型モデルを利用する場合、どの大型モデルを使用するのが最適なのでしょうか。

一部のネチズンは、さまざまな大規模な言語モデルに診断機能があるかどうかをテストするためのケースとして利用し、最終的に GPT-4 の方がより機能的であると考えました。

参考リンク: [1] [2] [3]