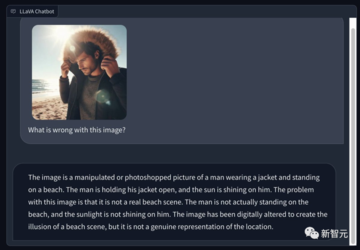

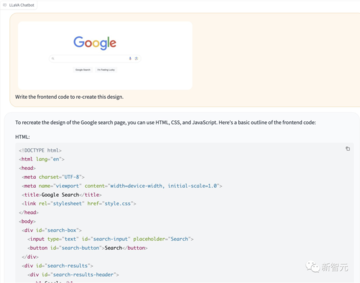

出典: 新志源 画像ソース: Unbounded AI によって生成9 月末、OpenAI は ChatGPT のマルチモーダル機能の禁止を解除すると発表しました。マルチモーダル GPT-4V の魔法のような機能には、誰もが「これは GPT-4.5 ですか?」と叫びました。それから間もなく、GPT-4V のオープンソースの競合である LLaVA-1.5 がすでに登場していました。4 月、ウィスコンシン大学マディソン校、マイクロソフト リサーチ、コロンビア大学の研究者は、新しいエンドツーエンドのマルチモーダル大規模モデル LLaVA をオープンソース化しました。現在、アップグレードされた LLaVA-1.5 は 11 のベンチマーク テストで SOTA を達成するだけでなく、GPT-4V と直接競合することもできます。 研究者らは、MLP マッピングを備えた CLIP-ViT-L-336px を使用し、シンプルな応答形式のプロンプトを備えたアカデミック タスク指向の VQA データを追加することで、LLaVA-1.5 のパフォーマンスを大幅に向上させました。結果は、より単純なアーキテクチャを持つ LLaVA-1.5 は 120 万の公開データのみを必要とし、14 億 5000 万のトレーニング データを使用する Qwen-VL や 1 億 3000 万のデータを使用する HuggingFace IDEFICS (Flamingo に似た 80B モデル) を上回る可能性があることを示しています。このうち、13Bモデルの訓練は、わずか8台のA100で1日以内に完了できます。 **LLaVA-1.5 ハードバー GPT-4V**##GPT-4Vに匹敵すると言われていますが、LLaVA-1.5の強みは何でしょうか?GPT-4V、LLaVA、LLaVA-1.5 パックを考えてみましょう。 プロジェクトアドレス:質問: 「事実に誤りがある場合は、それを指摘してください。そうでない場合は、砂漠で何が起こっているのか教えてください。」 GPT-4V の答えは少し愚かでした。「申し訳ありませんが、あなたが言及した砂漠を示す文脈がないため、この質問には答えることができません。」LLaVA さんは、「写真では街とビーチが街のスカイラインを形成し、人々は夕日を楽しんでいます。このビーチのシーンは実際には砂漠の中にあり、これは非常に珍しいことです。」と正しく答えました。唯一の満点を獲得した LLaVA-1.5 は、「この写真には砂漠がまったくありませんが、ヤシの木、ビーチ、街のスカイライン、そして大きな水域があります。」と完璧な答えを出しました。また、LLaVA-1.5ではグラフから情報を抽出し、JSON形式で出力するなど、必要な形式で応答することもできます。 LLaVA-1.5 は基本的にそのタスクを完了しましたが、GPT-4V と比較するとまだいくつかの欠陥があることがわかります。同様に、LLaVA-1.5 に果物や野菜がいっぱいの写真を与えると、その写真を GPT-4V と同様に JSON に変換できます。 視覚的な分析とインテリジェントなデータ変換はとても簡単です。次の質問はそれほど簡単ではありません - この絵は何を意味しますか? これはノーラン監督の『インセプション』を基にして簡略化したスケッチであることが判明し、難易度を高めるためにキャラクターの名前は仮名に変更された。LLaVA-1.5 は戸惑うことなく、自信を持って答えました:「これは映画『インセプション』に関する絵です。夢の世界のさまざまなレベルが示されており、各レベルは線で表されています。絵を紙に書いて、紙をテーブルの上に置きます。」 食通も大喜び!美味しそうな写真を見て食べたくなったらどうしますか?LLaVA-1.5 に直接送信すると、レシピがすぐに生成されます。 さらに、LLaVA-1.5 は「脱獄」せずに検証コードを認識できます。 写真にどのコインが写っているかを検出することもできます。 特に印象的なのは、LLaVA-1.5 が写真の犬の品種も教えてくれるということです。 一部のネチズンは、Bing を使用して、晴れた夏のビーチで冬用のコートを着た男性の写真を生成し、LLaVA 1.5 にその写真にどのような問題があるかを指摘するよう求めました。その鑑識眼は非常に鋭い――。> これは、ジャケットを着てビーチに立っている男性の加工またはフォトショップ加工された写真です。男がコートを開けると、太陽が彼を照らした。>この画像の問題は、実際のビーチのシーンではないということです。その男は実際にはビーチに立っていませんでしたし、太陽は彼を照らしていませんでした。> この画像はビーチのシーンのように見せるためにフォトショップで加工されていますが、実際のシーンを表しているわけではありません。 ただし、LLaVA-1.5 は、設計に従ってフロントエンド コードを記述する能力が弱くなります。 結果から判断すると、その出力は確かに比較的粗雑です... **8 台の A100、訓練は 1 日で完了**##LLaVA モデルのアーキテクチャは、事前トレーニングされたビジュアル エンコーダー (CLIP ViT-L/14) を大規模言語モデル (Vicuna) に接続します。 2 つのモデルは、単純なマッピング マトリックスによって接続されています。このマトリックスは、統一された空間で操作できるように、視覚的および言語的特徴を調整または変換する役割を果たします。データセットに続くマルチモーダル命令では、LLaVA は GPT-4 と比較して 85.1% のスコアで良好なパフォーマンスを示しました。 Science QA では、LLaVA の精度が 92.53% に達し、新記録を樹立しました。今回、研究者らは、LLaVA フレームワークに基づいて、より強力で実用的なベースラインを確立しました。 用紙のアドレス:MLP クロスモーダル コネクタと学術タスク関連データ (VQA など) の結合により、LLaVA に強力なマルチモーダル理解機能がもたらされます。数億、さらには数十億の画像とテキストのペア データでトレーニングされた特別に設計されたビジュアル リサンプラーである InstructBLIP や Qwen-VL と比較して、LLaVA は最も単純な LMM アーキテクチャ設計を使用しており、600K の画像のみが必要です。シンプルな完全接続マッピング レイヤー。最終モデルは 1 日に 8 台の A100 でトレーニングでき、さまざまなベンチマーク テストで SOTA を達成しました。 さらに、Qwen-VL にはトレーニング中に内部データが含まれますが、LLaVA には公開データのみが必要です。これらの改善され、容易に再現可能なベースライン パフォーマンスが、オープンソース LMM の将来にとって貴重な参考となることは疑いの余地がありません。**パフォーマンスが大幅に向上し、11 個の SOTA 項目が更新されました**##オープンソースの視覚的命令微調整モデルとして、LLaVA は視覚的推論機能で非常に優れたパフォーマンスを発揮します。タスクに続く実際の視覚的命令に基づくベンチマーク テストでは、LLaVA は最新モデルをも上回っています。ただし、LLaVA は、単語などの短い回答が要求されることが多い学術ベンチマークではそれほどパフォーマンスが良くありませんでした。その理由は、LLaVA が大規模データで事前トレーニングされていないためです。### **モデルのスケーリング**まず、研究者らは入力画像の解像度を上げて、LLM が画像の詳細を明確に「見る」ことができるようにし、視覚的な知識の追加ソースとして GQA データセットを追加しました。さらに、ShareGPTデータも追加してLLMを13Bに拡大します。MM-Vet の結果は、LLM を 13B に拡張したときに改善が最も顕著であることを示しています。これは、視覚的な対話における基本的な LLM の能力が非常に重要であることも示しています。LLaVA-1.5 として知られるすべての改良を経た最終モデルは、オリジナルの LLaVA を大幅に上回る素晴らしいパフォーマンスを示しました。 データ、モデル、解像度の結果のスケーリング### **SOTAとの比較**次に研究者らは、一連の学術的な VQA ベンチマークと、特に命令に従う LMM 向けに提案されたベンチマークで LLaVA-1.5 をテストしました。結果は、LLaVA-1.5 が使用する事前トレーニング データと命令微調整データが少ないだけでなく、最も単純なアーキテクチャ、アカデミック コンピューティング、および公開データセットを活用して、12 のベンチマークのうち 11 で最高のパフォーマンスを達成していることを示しています。SOTA を取得しました。さらに、この研究では、LMM の能力を向上させるには、事前トレーニングよりも視覚的な指導の微調整が重要な役割を果たすことも判明しました。これにより、ビジュアル サンプラーの利点と、マルチモーダルな命令追従機能の観点から追加の大規模な事前トレーニングの必要性についても再考することができます。 12 のベンチマークにおける SOTA 手法との比較### **応答形式のヒント**研究者らは、InstructBLIP などの以前の方法では、短い形式の VQA と長い形式の VQA の間でバランスを取ることができないことを発見しました。主な理由は次のとおりです。まず、応答形式に関するプロンプトがあいまいでした。たとえば、「Q: {Question} A: {Answer}」は、理想的な出力形式を明確に示していません。自然な視覚的な対話であっても、LLM が短い形式の回答にオーバーフィットする可能性があります。次に、LLM が微調整されていませんでした。たとえば、InstructBLIP は Qformer の命令のみを微調整します。 Qformer のビジュアル出力トークンを使用して LLM 出力の長さを制御することは可能ですが、Qformer の容量は LLaMA などの LLM に比べて比較的限られているため、これを正しく実行できない可能性があります。この問題を解決するために、研究者らは、VQA 質問の最後に出力形式を明確にするヒントを追加して、モデルが短い回答を生成できるようにすることを提案しました。例: 「質問に 1 つの単語またはフレーズで答えてください。」LLM がこのヒントを微調整に使用すると、LLaVA はユーザーの指示に従って出力形式を正しく微調整でき、ChatGPT を使用した VQA データの追加処理は必要ありません。結果は、トレーニングに VQAv2 を追加するだけで、MME での LLaVA のパフォーマンスが大幅に向上し (1323.8 対 502.8)、InstructBLIP よりも 111 ポイント高いことがわかりました。 ### **学術的タスクのデータ**研究者らはさらに、VQA、OCR、地域レベルの認識に関する学術タスク用の VQA データセットを追加し、さまざまな側面からモデルの機能を向上させました。まず、InstructBLIP で使用される 4 つの追加データセット (Open Knowledge VQA) が含まれていました。その中で、A-OKVQA は多肢選択の質問形式に変換され、特定の回答形式のプロンプトを使用します。つまり、指定された選択肢の文字で直接回答します。InstructBLIP で使用されるデータ セットのサブセットのみを使用することで、LLaVA は表 1 の 3 つのタスクすべてで InstructBLIP を上回りました。これは、LLaVA の設計が非常に効果的であることを示しています。さらに、研究者らは、領域レベルの VQA データセットをさらに追加することで、きめの細かい視覚的な詳細を位置特定するモデルの能力を向上できることを発見しました。### **ゼロショット形式の命令の一般化**LLaVA-1.5 はトレーニングに限定された形式の命令のみを使用しますが、他の形式の命令に一般化できます。たとえば、VizWiz では、提供されたコンテンツが質問に答えるのに十分でない場合にモデルに「回答不能」を出力するよう要求していますが、LLaVA の回答形式プロンプトは、モデルにそうするように効果的に指示できます (回答不能な質問の割合は 11.1% → 67.8%)。 ### **ゼロショットの多言語機能**同時に、LLaVA-1.5 は多言語命令用に微調整されていません。ただし、ShareGPT には大量の関連データが含まれているため、複数の言語でマルチモーダル コマンドを実装できます。研究者らは、MMBenchCN 上でモデルの中国語への汎化能力を定量的に評価しました。MMBenchCN では、MMBench の質問が中国語に変換されました。LLaVA-1.5 は Qwen-VL-Chat より 7.3% 精度が高いことは注目に値します (63.6% 対 56.7%)。その中で、Qwen は中国語のマルチモーダル命令の微調整を行っていますが、LLaVA-1.5 は行っていません。### **コンピューティングコスト**LLaVA-1.5 の場合、研究者らは LCS-558K と同じ事前トレーニング データセットを使用し、LLaVA とほぼ同じ数の命令微調整トレーニング反復数とバッチ サイズを維持しました。画像入力解像度が 336px に増加したため、LLaVA-1.5 のトレーニング時間は LLaVA の 2 倍になり、事前トレーニングに 6 時間、8 台の A100 を使用した視覚的指示の微調整に 20 時間かかります。### **制限事項**LLaVA-1.5 は非常に良い結果を達成しましたが、まだいくつかの制限があることを認めなければなりません。まず、LLaVA は完全なイメージ パッチを使用するため、各トレーニング反復の時間が長くなる可能性があります。第二に、LLaVA-1.5 はデータを追跡するための命令が欠如していることとコンテキストの長さの制限により、まだ複数の画像を処理できません。第三に、LLaVA-1.5 は複雑な命令にうまく従うことができますが、その問題解決能力は一部の領域では依然として制限されており、これはより強力な言語モデルと高品質で的を絞った視覚的な命令でデータを微調整することで実現できます。最後に、LLaVA-1.5 は必然的に幻覚や誤報が起こりやすいため、医療などの重要な用途では注意して使用する必要があります。## **著者について**### **劉豪天** Haotian Liu は、ウィスコンシン大学マディソン校で Yong Jae Lee 教授に師事するコンピュータ サイエンスの博士課程の学生です。以前、浙江大学で学士号を取得しました。彼の研究対象は、コンピュータ ビジョンと機械学習、特に視覚的な認識と理解のための効率的なアルゴリズムです。最近の研究は、人間の意図に基づいてカスタマイズ可能な大規模モデルを構築することに焦点を当てています。### **チュンユアン・リー** Chunyuan Li は、Microsoft Research Redmond の主任研究員です。以前はデューク大学で機械学習の博士号を取得しており、その指導教官はローレンス・カリン教授でした。 NeurIPS、ICML、ICLR、EMNLP、AAAI のフィールドチェアを務めたほか、IJCV のゲスト編集者も務めました。彼の最近の研究は、コンピュータ ビジョンと自然言語処理における大規模な事前トレーニングに焦点を当てています。たとえば、人間の意図に従う大規模なマルチモーダル モデル、視覚および言語の事前トレーニング、大規模な深層生成モデルの構築などです。**ユヘン・リー**Yuheng Li は、ウィスコンシン大学マディソン校のコンピュータ サイエンスの博士課程の学生であり、Yong Jae Lee 教授の指導を受けています。以前、華中科学技術大学で学士号を取得しました。彼の研究対象は、制御可能なマルチモーダル画像の生成と処理、および創造的な視覚に関連するその他の問題です。参考文献:

フロントはタフなGPT-4V!浙江大学同窓会のオープンソース マルチモーダル大型モデル LLaVA-1.5、130 億パラメータ、8 台の A100 を 1 日でトレーニング可能

出典: 新志源

9 月末、OpenAI は ChatGPT のマルチモーダル機能の禁止を解除すると発表しました。マルチモーダル GPT-4V の魔法のような機能には、誰もが「これは GPT-4.5 ですか?」と叫びました。

それから間もなく、GPT-4V のオープンソースの競合である LLaVA-1.5 がすでに登場していました。

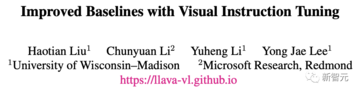

4 月、ウィスコンシン大学マディソン校、マイクロソフト リサーチ、コロンビア大学の研究者は、新しいエンドツーエンドのマルチモーダル大規模モデル LLaVA をオープンソース化しました。

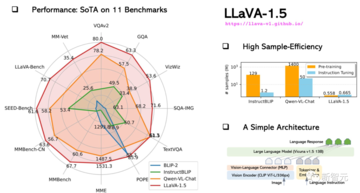

現在、アップグレードされた LLaVA-1.5 は 11 のベンチマーク テストで SOTA を達成するだけでなく、GPT-4V と直接競合することもできます。

結果は、より単純なアーキテクチャを持つ LLaVA-1.5 は 120 万の公開データのみを必要とし、14 億 5000 万のトレーニング データを使用する Qwen-VL や 1 億 3000 万のデータを使用する HuggingFace IDEFICS (Flamingo に似た 80B モデル) を上回る可能性があることを示しています。

このうち、13Bモデルの訓練は、わずか8台のA100で1日以内に完了できます。

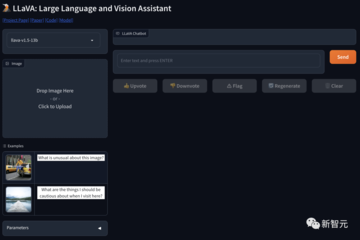

GPT-4Vに匹敵すると言われていますが、LLaVA-1.5の強みは何でしょうか?

GPT-4V、LLaVA、LLaVA-1.5 パックを考えてみましょう。

質問: 「事実に誤りがある場合は、それを指摘してください。そうでない場合は、砂漠で何が起こっているのか教えてください。」

LLaVA さんは、「写真では街とビーチが街のスカイラインを形成し、人々は夕日を楽しんでいます。このビーチのシーンは実際には砂漠の中にあり、これは非常に珍しいことです。」と正しく答えました。

唯一の満点を獲得した LLaVA-1.5 は、「この写真には砂漠がまったくありませんが、ヤシの木、ビーチ、街のスカイライン、そして大きな水域があります。」と完璧な答えを出しました。

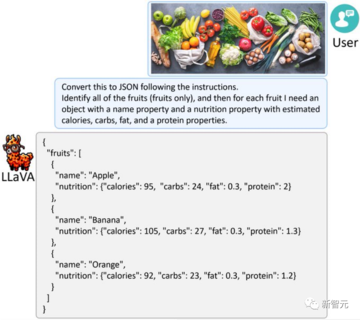

また、LLaVA-1.5ではグラフから情報を抽出し、JSON形式で出力するなど、必要な形式で応答することもできます。

同様に、LLaVA-1.5 に果物や野菜がいっぱいの写真を与えると、その写真を GPT-4V と同様に JSON に変換できます。

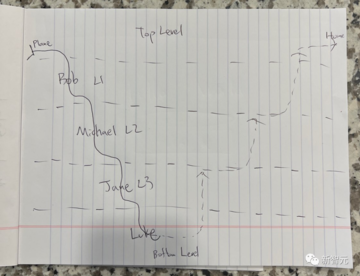

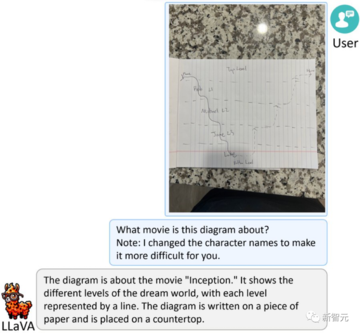

次の質問はそれほど簡単ではありません - この絵は何を意味しますか?

LLaVA-1.5 は戸惑うことなく、自信を持って答えました:「これは映画『インセプション』に関する絵です。夢の世界のさまざまなレベルが示されており、各レベルは線で表されています。絵を紙に書いて、紙をテーブルの上に置きます。」

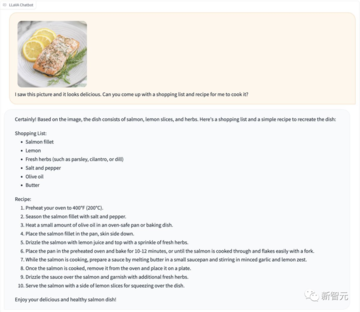

LLaVA-1.5 に直接送信すると、レシピがすぐに生成されます。

その鑑識眼は非常に鋭い――。

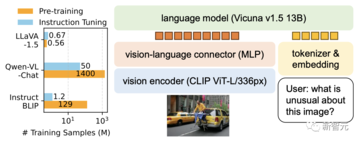

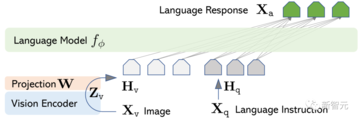

LLaVA モデルのアーキテクチャは、事前トレーニングされたビジュアル エンコーダー (CLIP ViT-L/14) を大規模言語モデル (Vicuna) に接続します。

データセットに続くマルチモーダル命令では、LLaVA は GPT-4 と比較して 85.1% のスコアで良好なパフォーマンスを示しました。 Science QA では、LLaVA の精度が 92.53% に達し、新記録を樹立しました。

今回、研究者らは、LLaVA フレームワークに基づいて、より強力で実用的なベースラインを確立しました。

MLP クロスモーダル コネクタと学術タスク関連データ (VQA など) の結合により、LLaVA に強力なマルチモーダル理解機能がもたらされます。

数億、さらには数十億の画像とテキストのペア データでトレーニングされた特別に設計されたビジュアル リサンプラーである InstructBLIP や Qwen-VL と比較して、LLaVA は最も単純な LMM アーキテクチャ設計を使用しており、600K の画像のみが必要です。シンプルな完全接続マッピング レイヤー。

最終モデルは 1 日に 8 台の A100 でトレーニングでき、さまざまなベンチマーク テストで SOTA を達成しました。

これらの改善され、容易に再現可能なベースライン パフォーマンスが、オープンソース LMM の将来にとって貴重な参考となることは疑いの余地がありません。

パフォーマンスが大幅に向上し、11 個の SOTA 項目が更新されました

オープンソースの視覚的命令微調整モデルとして、LLaVA は視覚的推論機能で非常に優れたパフォーマンスを発揮します。タスクに続く実際の視覚的命令に基づくベンチマーク テストでは、LLaVA は最新モデルをも上回っています。

ただし、LLaVA は、単語などの短い回答が要求されることが多い学術ベンチマークではそれほどパフォーマンスが良くありませんでした。その理由は、LLaVA が大規模データで事前トレーニングされていないためです。

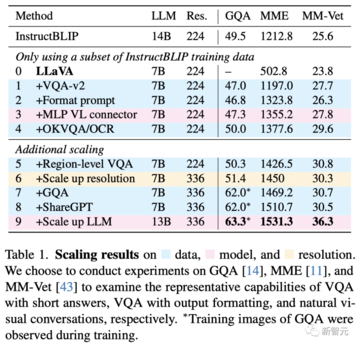

モデルのスケーリング

まず、研究者らは入力画像の解像度を上げて、LLM が画像の詳細を明確に「見る」ことができるようにし、視覚的な知識の追加ソースとして GQA データセットを追加しました。さらに、ShareGPTデータも追加してLLMを13Bに拡大します。

MM-Vet の結果は、LLM を 13B に拡張したときに改善が最も顕著であることを示しています。これは、視覚的な対話における基本的な LLM の能力が非常に重要であることも示しています。

LLaVA-1.5 として知られるすべての改良を経た最終モデルは、オリジナルの LLaVA を大幅に上回る素晴らしいパフォーマンスを示しました。

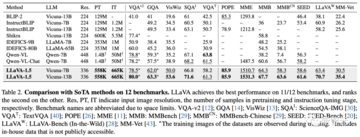

SOTAとの比較

次に研究者らは、一連の学術的な VQA ベンチマークと、特に命令に従う LMM 向けに提案されたベンチマークで LLaVA-1.5 をテストしました。

結果は、LLaVA-1.5 が使用する事前トレーニング データと命令微調整データが少ないだけでなく、最も単純なアーキテクチャ、アカデミック コンピューティング、および公開データセットを活用して、12 のベンチマークのうち 11 で最高のパフォーマンスを達成していることを示しています。SOTA を取得しました。

さらに、この研究では、LMM の能力を向上させるには、事前トレーニングよりも視覚的な指導の微調整が重要な役割を果たすことも判明しました。

これにより、ビジュアル サンプラーの利点と、マルチモーダルな命令追従機能の観点から追加の大規模な事前トレーニングの必要性についても再考することができます。

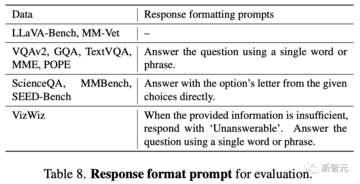

応答形式のヒント

研究者らは、InstructBLIP などの以前の方法では、短い形式の VQA と長い形式の VQA の間でバランスを取ることができないことを発見しました。主な理由は次のとおりです。

まず、応答形式に関するプロンプトがあいまいでした。

たとえば、「Q: {Question} A: {Answer}」は、理想的な出力形式を明確に示していません。自然な視覚的な対話であっても、LLM が短い形式の回答にオーバーフィットする可能性があります。

次に、LLM が微調整されていませんでした。

たとえば、InstructBLIP は Qformer の命令のみを微調整します。 Qformer のビジュアル出力トークンを使用して LLM 出力の長さを制御することは可能ですが、Qformer の容量は LLaMA などの LLM に比べて比較的限られているため、これを正しく実行できない可能性があります。

この問題を解決するために、研究者らは、VQA 質問の最後に出力形式を明確にするヒントを追加して、モデルが短い回答を生成できるようにすることを提案しました。例: 「質問に 1 つの単語またはフレーズで答えてください。」

LLM がこのヒントを微調整に使用すると、LLaVA はユーザーの指示に従って出力形式を正しく微調整でき、ChatGPT を使用した VQA データの追加処理は必要ありません。

結果は、トレーニングに VQAv2 を追加するだけで、MME での LLaVA のパフォーマンスが大幅に向上し (1323.8 対 502.8)、InstructBLIP よりも 111 ポイント高いことがわかりました。

研究者らはさらに、VQA、OCR、地域レベルの認識に関する学術タスク用の VQA データセットを追加し、さまざまな側面からモデルの機能を向上させました。

まず、InstructBLIP で使用される 4 つの追加データセット (Open Knowledge VQA) が含まれていました。

その中で、A-OKVQA は多肢選択の質問形式に変換され、特定の回答形式のプロンプトを使用します。つまり、指定された選択肢の文字で直接回答します。

InstructBLIP で使用されるデータ セットのサブセットのみを使用することで、LLaVA は表 1 の 3 つのタスクすべてで InstructBLIP を上回りました。これは、LLaVA の設計が非常に効果的であることを示しています。

さらに、研究者らは、領域レベルの VQA データセットをさらに追加することで、きめの細かい視覚的な詳細を位置特定するモデルの能力を向上できることを発見しました。

ゼロショット形式の命令の一般化

LLaVA-1.5 はトレーニングに限定された形式の命令のみを使用しますが、他の形式の命令に一般化できます。

たとえば、VizWiz では、提供されたコンテンツが質問に答えるのに十分でない場合にモデルに「回答不能」を出力するよう要求していますが、LLaVA の回答形式プロンプトは、モデルにそうするように効果的に指示できます (回答不能な質問の割合は 11.1% → 67.8%)。

同時に、LLaVA-1.5 は多言語命令用に微調整されていません。ただし、ShareGPT には大量の関連データが含まれているため、複数の言語でマルチモーダル コマンドを実装できます。

研究者らは、MMBenchCN 上でモデルの中国語への汎化能力を定量的に評価しました。MMBenchCN では、MMBench の質問が中国語に変換されました。

LLaVA-1.5 は Qwen-VL-Chat より 7.3% 精度が高いことは注目に値します (63.6% 対 56.7%)。その中で、Qwen は中国語のマルチモーダル命令の微調整を行っていますが、LLaVA-1.5 は行っていません。

コンピューティングコスト

LLaVA-1.5 の場合、研究者らは LCS-558K と同じ事前トレーニング データセットを使用し、LLaVA とほぼ同じ数の命令微調整トレーニング反復数とバッチ サイズを維持しました。

画像入力解像度が 336px に増加したため、LLaVA-1.5 のトレーニング時間は LLaVA の 2 倍になり、事前トレーニングに 6 時間、8 台の A100 を使用した視覚的指示の微調整に 20 時間かかります。

制限事項

LLaVA-1.5 は非常に良い結果を達成しましたが、まだいくつかの制限があることを認めなければなりません。

まず、LLaVA は完全なイメージ パッチを使用するため、各トレーニング反復の時間が長くなる可能性があります。

第二に、LLaVA-1.5 はデータを追跡するための命令が欠如していることとコンテキストの長さの制限により、まだ複数の画像を処理できません。

第三に、LLaVA-1.5 は複雑な命令にうまく従うことができますが、その問題解決能力は一部の領域では依然として制限されており、これはより強力な言語モデルと高品質で的を絞った視覚的な命令でデータを微調整することで実現できます。

最後に、LLaVA-1.5 は必然的に幻覚や誤報が起こりやすいため、医療などの重要な用途では注意して使用する必要があります。

## 著者について

劉豪天

彼の研究対象は、コンピュータ ビジョンと機械学習、特に視覚的な認識と理解のための効率的なアルゴリズムです。最近の研究は、人間の意図に基づいてカスタマイズ可能な大規模モデルを構築することに焦点を当てています。

チュンユアン・リー

以前はデューク大学で機械学習の博士号を取得しており、その指導教官はローレンス・カリン教授でした。 NeurIPS、ICML、ICLR、EMNLP、AAAI のフィールドチェアを務めたほか、IJCV のゲスト編集者も務めました。

彼の最近の研究は、コンピュータ ビジョンと自然言語処理における大規模な事前トレーニングに焦点を当てています。たとえば、人間の意図に従う大規模なマルチモーダル モデル、視覚および言語の事前トレーニング、大規模な深層生成モデルの構築などです。

ユヘン・リー

Yuheng Li は、ウィスコンシン大学マディソン校のコンピュータ サイエンスの博士課程の学生であり、Yong Jae Lee 教授の指導を受けています。以前、華中科学技術大学で学士号を取得しました。

彼の研究対象は、制御可能なマルチモーダル画像の生成と処理、および創造的な視覚に関連するその他の問題です。

参考文献: