元のソース:デコード 画像ソース:無制限のAIによって生成Intel CPUはよく売れていて、成功したハードウェア会社に帰しているという幻想がしばしばありますが、実際には、Intelのデスクトッププロセッサの支配は86年に生まれたX1978アーキテクチャです。同じ錯覚がNvidiaにも見られます。NVIDIAが人工知能トレーニングチップ市場を独占できる理由は、CUDAアーキテクチャが間違いなく舞台裏のヒーローの1つです。2006年に生まれたこのアーキテクチャは、コンピューターコンピューティングのすべての分野に関与しており、NVIDIAの形にほぼ形作られています。 航空宇宙、バイオサイエンス研究、機械および流体シミュレーション、およびエネルギー探査の研究の80%は、CUDAに基づいて行われています。最もホットなAI分野では、ほとんどすべての大手メーカーがプランBの準備をしています:グーグル、アマゾン、ファーウェイ、マイクロソフト、OpenAI、バイドゥ... 誰も自分の未来を他人の手に委ねることを望んでいません。起業家サービスコンサルティングエージェンシー Dealroom.co 一連のデータをリリースし、この生成AI熱波の波で、米国は世界の投資と資金調達の89%を獲得し、AIチップの投資と資金調達では、中国のAIチップの投資と資金調達は世界で1位であり、米国の2倍以上です。つまり、中国とアメリカの企業の大規模モデルの開発方法と段階には多くの違いがありますが、誰もが計算能力の制御に特に一貫しています。 ## なぜCUDAはこの魔法を持っているのですか? ** 2003年、4コアCPUを導入したIntelと競争するために、NVIDIAはユニファイドコンピューティングデバイスアーキテクチャテクノロジー(CUDA)の開発を開始しました。CUDAの当初の目的は、開発者が複雑なシェーディング言語やグラフィックス処理プリミティブを学ぶ必要がないように、GPUに使いやすいプログラミングインターフェイスを追加することでした。 Nvidiaの当初のアイデアは、ゲーム開発者にグラフィックスコンピューティングの分野でのアプリケーションを提供することであり、Huangはこれを「グラフィックスをプログラム可能にする」と呼んでいます。ただし、CUDAの発売以来、主要なアプリケーションを見つけることができず、重要なカスタマーサポートが不足しています。 また、NVIDIAは、アプリケーションの開発、サービスの維持、宣伝とマーケティングに多額の費用を費やす必要があり、2008年までに金融嵐に遭遇し、NVIDIAの収益はグラフィックカードの販売不振で急激に減少し、株価はかつてAMDの最悪の時期よりも悪い1.50ドルに下落しました。2012 年まで、2 人の Hinton の学生が NVIDIA の GPU を使用して ImageNet と呼ばれる画像認識速度を競いました。 彼らはGTX580グラフィックカードを使用し、CUDAテクノロジーでトレーニングしましたが、結果は2位の数十倍の速さで、精度は2位よりも10%以上高くなりました。 業界に衝撃を与えたのはImageNetモデルだけではありませんでした。 このニューラルネットワークは、1400万枚の画像と合計262兆個の浮動小数点演算を必要とし、1週間のトレーニングで4台のGTX 580しか使用しませんでした。 参考までに、Google Catは1,000万枚の画像、16,000個のCPU、および1,000台のコンピューターを使用しました。この競争は、AIにとって歴史的なターニングポイントであるだけでなく、NVIDIAのブレークスルーを開くものでもあります。 NVIDIAは、AIエコシステムを促進し、オープンソースのAIフレームワークを促進し、Google、Facebook、その他の企業と協力してTensorFlowなどのAIテクノロジーの開発を促進するために業界と協力し始めました。これは、Huang氏が言った「あらゆる種類のことのプログラマビリティのためにGPUを開く」という2番目のステップを完了することと同じです。GPUの計算能力の価値が発見されたとき、大手メーカーも、NVIDIAが数年間繰り返し舗装してきたCUDAがAIが避けられない高い壁になっていたという事実に突然目覚めました。CUDAエコシステムを構築するために、NVIDIAは、開発者がディープラーニング、線形代数、推論アクセラレーションなどのタスクを実行するのに便利な、cuDNN、cuBLAS、TensorRTなどの豊富なライブラリとツールを開発者に提供します。 さらに、NVIDIAはCUDAコンパイラとオプティマイザーを含む完全な開発ツールチェーンを提供し、開発者にとってGPUプログラミングとパフォーマンスの最適化を容易にします。同時に、NVIDIAは、TensorFlow、PyTorch、MXNetなどの多くの一般的なディープラーニングフレームワークとも緊密に連携しており、CUDAにディープラーニングタスクにおいて大きな利点を提供しています。「馬を助け、乗せる」というこの献身により、NVIDIAはわずか2年半でCUDAエコシステムの開発者の数を2倍にすることができました。過去10年間、NVIDIAはCUDAの教育コースを350以上の大学に宣伝し、プラットフォーム上のプロの開発者とドメインエキスパートが経験を共有し、難しい質問に答えることでCUDAアプリケーションの豊富なサポートを提供してきました。さらに重要なことに、NVIDIAは、堀としてのハードウェアの欠陥はユーザーの粘着性がないことを知っているため、ハードウェアとソフトウェアをバンドルし、GPUレンダリングはCUDAを使用し、AIノイズリダクションはOptiXを使用し、自動運転コンピューティングにはCUDAが必要です...NVIDIAは現在、GPU + NVlink + CUDAでAIコンピューティングパワー市場の90%を独占していますが、帝国には複数の亀裂があります。 ## **亀裂** AIメーカーは長い間CUDAに苦しんでおり、警戒心はありません。CUDAの魔法は、ソフトウェアのエコシステム全体の基盤であるソフトウェアとハ ードウェアの組み合わせの重要な位置にあり、競合他社がCUDAをバイパスしてNVIDIAのエコシステムと互換性を持たせるのが難しいことです。 ハードウェアの場合、CUDAの設計は基本的にNVIDIAハードウェアの形式のソフトウェア抽象化であり、基本的に各コアコンセプトはGPUのハードウェアコンセプトに対応しています。次に、競合他社の場合、残っているオプションは2つだけです。1 CUDAをバイパスし、NVIDIAのユーザーの粘着性という大きな課題に直面する必要があるソフトウェアエコシステムを再構築します。2 CUDAと互換性がありますが、ハードウェアルートがNVIDIAと矛盾している場合、非効率的で不快な結果になる可能性があることと、CUDAがNVIDIAハードウェア特性の進化に従い、互換性が従うことしか選択できないことです。しかし、Nvidiaのグリップを取り除くために、両方のオプションが試されました。2016年、AMDはオープンソースプロジェクトに基づくGPUエコシステムであるROCmを立ち上げ、CUDAと完全に互換性のあるHIPツールを提供しました。ただし、ツールチェーンライブラリのリソースが不足し、開発とイテレーションの互換性のコストが高いため、ROCmエコシステムの成長は困難です。 Githubでは、32,600人以上の開発者がCUDAパッケージリポジトリに貢献していますが、ROCmは600人未満です。NVIDIA互換のCUDAルートを採用することの難しさは、その更新反復速度がCUDAに追いつくことができず、完全な互換性を達成するのが難しいことです。1 回のイテレーションは常に 1 ステップ遅くなります: NVIDIA GPU はマイクロアーキテクチャと命令セットで迅速にイテレーションを行い、上位のソフトウェア スタックの多くの場所でも対応する機能の更新を行う必要があります。 しかし、AMDはNVIDIAの製品ロードマップを知ることができず、ソフトウェアの更新は常にNVIDIAよりも一歩遅くなります。 たとえば、AMDはCUDA11のサポートを発表したばかりかもしれませんが、NVIDIAはすでにCUDA12をリリースしています。2完全な互換性の難しさは開発者の作業負荷を増加させます:CUDA自体などの大規模なソフトウェアは非常に複雑であり、AMDは追いつくために数年または10年以上にわたって多くの人的資源と物的資源を投資する必要があります。 どうしても機能の違いはあるので、互換性がうまくいかないとパフォーマンスに影響が出てしまいます(99%は似ていますが、残りの1%の違いを解くと開発者の時間の99%が浪費される可能性があります)。2022年1月に設立されたモジュラーなど、CUDAをバイパスすることを選択する企業もあります。 Modularのアイデアは、バーをできるだけ低く抑えることですが、それは奇襲攻撃のようなものです。 「モジュラー」アプローチを通じて「現在のAIアプリケーションスタックが特定のハードウェアおよびソフトウェアと結合されることが多い」という問題を解決するために、「人工知能モデルのパフォーマンスを向上させるための」AIエンジンを提案しています。このAIエンジンに付随して、モジュラーはオープンソースのプログラミング言語Mojoも開発しました。 「AI用に構築された」プログラミング言語と考えることができ、モジュラーはそれを使用して、Pythonとシームレスに統合して学習コストを削減しながら、前述のAIエンジンに統合するツールを開発します。ただし、Modularの問題は、「全プラットフォーム開発ツール」のビジョンが理想主義的すぎることです。「Beyond Python」というタイトルを持ち、Chris Lattnerの評判によって承認されていますが、Mojoは新しい言語として、プロモーションの観点から多くの開発者によってテストされる必要があります。AIエンジンは、多くのハードウェア会社との契約だけでなく、プラットフォーム間の互換性についても、より多くの問題に直面しています。 これらはすべて、完了するまでに長い時間の研磨を必要とするタスクであり、その時点でNvidiaが何に進化するかは、誰も知らないのではないかと思います。 ## **チャレンジャーファーウェイ** 10月17日、米国はAIチップの輸出管理規則を更新し、NVIDIAなどの企業が高度なAIチップを中国に輸出することを禁止しました。 最新の規則によると、A800やH800を含むNVIDIAの中国へのチップ輸出が影響を受けます。 以前は、NVIDIA A100とH100の2つのモデルが中国への輸出が制限された後、中国専用の「去勢バージョン」A800とH800が規制に準拠するように設計されていました。 インテルはまた、中国市場向けにAIチップGaudi2を発売しました。 今、企業は新しい輸出禁止の下で対応を調整しなければならないようです。今年8月、Huaweiの自社開発のKirin 60Sチップを搭載したMate9000Proが突然発売され、即座に世論の大きな波を引き起こし、ほぼ同時に別のニュースがすぐにかき消されました。iFLYTEKのLiu Qingfeng会長は、公開イベントで珍しい声明を発表し、HuaweiのGPUはNVIDIA A100に対してベンチマークできるが、HuaweiがiFLYTEKの作業を最適化するための特別なワーキンググループを派遣した場合に限られると述べた。このような突然の発言には深い意図があることが多く、それを予測する能力はありませんが、2か月後のチップ禁止に対応することの有用性は依然としてあります。Ascend AIフルスタックソフトウェアおよびハードウェアプラットフォームであるHuawei GPUには、Atlasシリーズハードウェア、ヘテロジニアスコンピューティングアーキテクチャ、AIフレームワーク、アプリケーションイネーブルメント、およびボトムアップの業界アプリケーションの5つのレイヤーが含まれています。基本的に、HuaweiはNVIDIAの一連の代替品を作成し、チップ層はAscend 910とAscend 310であり、ヘテロジニアスコンピューティングアーキテクチャ(CANN)はNVIDIA CUDA + CuDNNコアソフトウェア層をベンチマークしていることがわかります。 もちろん、ギャップは欠くことはできず、一部の関連する実務家は2つの点を要約しました。1シングルカードのパフォーマンスは遅れており、Ascend 910とA100の間にはまだギャップがありますが、勝利は価格が安く、金額を積み重ねることができ、クラスター規模に達した後の全体的なギャップは大きくありません。2 生態学的な欠点は存在しますが、Huaweiは、たとえば、PyTorchコミュニティとAscendの協力を通じて、PyTorchバージョン2.1がAscend NPUを同期的にサポートしているため、開発者はPyTorch 2.1でAscendに基づくモデルを直接開発できます。現在、Huawei Ascendは主にHuawei独自のクローズドループ大型モデル製品を実行しており、Huaweiのプラットフォームで実行するには、Huaweiがパブリックモデルを深く最適化する必要があり、最適化作業のこの部分はHuaweiに大きく依存しています。現在の文脈では、アセンドは特別な意味を持っています。今年5月、ファーウェイのAscendコンピューティング事業のZhang Dixuan社長は、「Ascend AI」の基本的なソフトウェアとハードウェアのプラットフォームが30以上の主流の大型モデルにインキュベートされ、適応しており、中国のネイティブの大型モデルの半分以上が、鵬城シリーズ、Zidongシリーズ、HUAWEI CLOUD Panguシリーズを含む「Ascend AI」の基本的なソフトウェアとハードウェアプラットフォームに基づいていることを明らかにした。 今年8月、BaiduはAscend AIのフライングオール+ウェンシンモデルへの適応も正式に発表しました。 また、インターネットで流通している写真によると、中国のインテリジェントスーパーコンピューティングセンターは、非公開を除いて基本的にAscendであり、新しいチップ制限の後、Huaweiのチップ生産能力の30〜40%がAscendクラスターに予約され、残りはキリンであると言われています。 ## エピローグ** 2006年、NVIDIAがその壮大な物語を展開していたとき、誰もCUDAが革新的な製品になるとは思っていなかったため、黄は取締役会を説得して、10年以上の未知の回収期間に賭けるために年間5億ドルを投資しなければならず、NVIDIAの収益はその年のわずか30億ドルでした。しかし、テクノロジーとイノベーションをキーワードとして使用するすべてのビジネスストーリーには、長期的な目標を永続的に遵守しているため、常に大きな成功を収めている人々がおり、NVIDIAとHuaweiは最高です。リソース[1] NVIDIAの「鎌」はAIチップではなく、シリコンベースの研究所です[2] 「NVIDIAの代替品」になるために、大手モデルメーカーが本を開き、小さなディナーテーブルが服を作成しました[3] 設立からわずか1年で、このAIスタースタートアップはNVIDIAとマグネシウムケネットに挑戦したいと考えています[4] エヌビディア帝国の亀裂、江津川研究所[5] 米国は中国へのチップ輸出を強化する計画であり、ファーウェイは国内生産の増加をリードし、西中国証券は[6] AIGC業界詳細レポート(11):ファーウェイのコンピューティングパワースピンオフ:世界のAIコンピューティングパワーの第2極、西中国証券[7] 2023年AIGC業界特別レポート:AIチップの4つの主要な技術ルート、カンブリア紀コピーNVIDIA、シェンワンホンユアン[8] CUDAがNVIDIAを達成する方法:AIの大きなブレークスルー、テンセントクラウドコミュニティ

NVIDIA:帝国の亀裂1つずつ

元のソース:デコード

Intel CPUはよく売れていて、成功したハードウェア会社に帰しているという幻想がしばしばありますが、実際には、Intelのデスクトッププロセッサの支配は86年に生まれたX1978アーキテクチャです。

同じ錯覚がNvidiaにも見られます。

NVIDIAが人工知能トレーニングチップ市場を独占できる理由は、CUDAアーキテクチャが間違いなく舞台裏のヒーローの1つです。

2006年に生まれたこのアーキテクチャは、コンピューターコンピューティングのすべての分野に関与しており、NVIDIAの形にほぼ形作られています。 航空宇宙、バイオサイエンス研究、機械および流体シミュレーション、およびエネルギー探査の研究の80%は、CUDAに基づいて行われています。

最もホットなAI分野では、ほとんどすべての大手メーカーがプランBの準備をしています:グーグル、アマゾン、ファーウェイ、マイクロソフト、OpenAI、バイドゥ... 誰も自分の未来を他人の手に委ねることを望んでいません。

起業家サービスコンサルティングエージェンシー Dealroom.co 一連のデータをリリースし、この生成AI熱波の波で、米国は世界の投資と資金調達の89%を獲得し、AIチップの投資と資金調達では、中国のAIチップの投資と資金調達は世界で1位であり、米国の2倍以上です。

つまり、中国とアメリカの企業の大規模モデルの開発方法と段階には多くの違いがありますが、誰もが計算能力の制御に特に一貫しています。

なぜCUDAはこの魔法を持っているのですか? **

2003年、4コアCPUを導入したIntelと競争するために、NVIDIAはユニファイドコンピューティングデバイスアーキテクチャテクノロジー(CUDA)の開発を開始しました。

CUDAの当初の目的は、開発者が複雑なシェーディング言語やグラフィックス処理プリミティブを学ぶ必要がないように、GPUに使いやすいプログラミングインターフェイスを追加することでした。 Nvidiaの当初のアイデアは、ゲーム開発者にグラフィックスコンピューティングの分野でのアプリケーションを提供することであり、Huangはこれを「グラフィックスをプログラム可能にする」と呼んでいます。

ただし、CUDAの発売以来、主要なアプリケーションを見つけることができず、重要なカスタマーサポートが不足しています。 また、NVIDIAは、アプリケーションの開発、サービスの維持、宣伝とマーケティングに多額の費用を費やす必要があり、2008年までに金融嵐に遭遇し、NVIDIAの収益はグラフィックカードの販売不振で急激に減少し、株価はかつてAMDの最悪の時期よりも悪い1.50ドルに下落しました。

2012 年まで、2 人の Hinton の学生が NVIDIA の GPU を使用して ImageNet と呼ばれる画像認識速度を競いました。 彼らはGTX580グラフィックカードを使用し、CUDAテクノロジーでトレーニングしましたが、結果は2位の数十倍の速さで、精度は2位よりも10%以上高くなりました。

この競争は、AIにとって歴史的なターニングポイントであるだけでなく、NVIDIAのブレークスルーを開くものでもあります。 NVIDIAは、AIエコシステムを促進し、オープンソースのAIフレームワークを促進し、Google、Facebook、その他の企業と協力してTensorFlowなどのAIテクノロジーの開発を促進するために業界と協力し始めました。

これは、Huang氏が言った「あらゆる種類のことのプログラマビリティのためにGPUを開く」という2番目のステップを完了することと同じです。

GPUの計算能力の価値が発見されたとき、大手メーカーも、NVIDIAが数年間繰り返し舗装してきたCUDAがAIが避けられない高い壁になっていたという事実に突然目覚めました。

CUDAエコシステムを構築するために、NVIDIAは、開発者がディープラーニング、線形代数、推論アクセラレーションなどのタスクを実行するのに便利な、cuDNN、cuBLAS、TensorRTなどの豊富なライブラリとツールを開発者に提供します。 さらに、NVIDIAはCUDAコンパイラとオプティマイザーを含む完全な開発ツールチェーンを提供し、開発者にとってGPUプログラミングとパフォーマンスの最適化を容易にします。

同時に、NVIDIAは、TensorFlow、PyTorch、MXNetなどの多くの一般的なディープラーニングフレームワークとも緊密に連携しており、CUDAにディープラーニングタスクにおいて大きな利点を提供しています。

「馬を助け、乗せる」というこの献身により、NVIDIAはわずか2年半でCUDAエコシステムの開発者の数を2倍にすることができました。

過去10年間、NVIDIAはCUDAの教育コースを350以上の大学に宣伝し、プラットフォーム上のプロの開発者とドメインエキスパートが経験を共有し、難しい質問に答えることでCUDAアプリケーションの豊富なサポートを提供してきました。

さらに重要なことに、NVIDIAは、堀としてのハードウェアの欠陥はユーザーの粘着性がないことを知っているため、ハードウェアとソフトウェアをバンドルし、GPUレンダリングはCUDAを使用し、AIノイズリダクションはOptiXを使用し、自動運転コンピューティングにはCUDAが必要です...

NVIDIAは現在、GPU + NVlink + CUDAでAIコンピューティングパワー市場の90%を独占していますが、帝国には複数の亀裂があります。

亀裂

AIメーカーは長い間CUDAに苦しんでおり、警戒心はありません。

CUDAの魔法は、ソフトウェアのエコシステム全体の基盤であるソフトウェアとハ ードウェアの組み合わせの重要な位置にあり、競合他社がCUDAをバイパスしてNVIDIAのエコシステムと互換性を持たせるのが難しいことです。 ハードウェアの場合、CUDAの設計は基本的にNVIDIAハードウェアの形式のソフトウェア抽象化であり、基本的に各コアコンセプトはGPUのハードウェアコンセプトに対応しています。

次に、競合他社の場合、残っているオプションは2つだけです。

1 CUDAをバイパスし、NVIDIAのユーザーの粘着性という大きな課題に直面する必要があるソフトウェアエコシステムを再構築します。

2 CUDAと互換性がありますが、ハードウェアルートがNVIDIAと矛盾している場合、非効率的で不快な結果になる可能性があることと、CUDAがNVIDIAハードウェア特性の進化に従い、互換性が従うことしか選択できないことです。

しかし、Nvidiaのグリップを取り除くために、両方のオプションが試されました。

2016年、AMDはオープンソースプロジェクトに基づくGPUエコシステムであるROCmを立ち上げ、CUDAと完全に互換性のあるHIPツールを提供しました。

ただし、ツールチェーンライブラリのリソースが不足し、開発とイテレーションの互換性のコストが高いため、ROCmエコシステムの成長は困難です。 Githubでは、32,600人以上の開発者がCUDAパッケージリポジトリに貢献していますが、ROCmは600人未満です。

NVIDIA互換のCUDAルートを採用することの難しさは、その更新反復速度がCUDAに追いつくことができず、完全な互換性を達成するのが難しいことです。

1 回のイテレーションは常に 1 ステップ遅くなります: NVIDIA GPU はマイクロアーキテクチャと命令セットで迅速にイテレーションを行い、上位のソフトウェア スタックの多くの場所でも対応する機能の更新を行う必要があります。 しかし、AMDはNVIDIAの製品ロードマップを知ることができず、ソフトウェアの更新は常にNVIDIAよりも一歩遅くなります。 たとえば、AMDはCUDA11のサポートを発表したばかりかもしれませんが、NVIDIAはすでにCUDA12をリリースしています。

2完全な互換性の難しさは開発者の作業負荷を増加させます:CUDA自体などの大規模なソフトウェアは非常に複雑であり、AMDは追いつくために数年または10年以上にわたって多くの人的資源と物的資源を投資する必要があります。 どうしても機能の違いはあるので、互換性がうまくいかないとパフォーマンスに影響が出てしまいます(99%は似ていますが、残りの1%の違いを解くと開発者の時間の99%が浪費される可能性があります)。

2022年1月に設立されたモジュラーなど、CUDAをバイパスすることを選択する企業もあります。

このAIエンジンに付随して、モジュラーはオープンソースのプログラミング言語Mojoも開発しました。 「AI用に構築された」プログラミング言語と考えることができ、モジュラーはそれを使用して、Pythonとシームレスに統合して学習コストを削減しながら、前述のAIエンジンに統合するツールを開発します。

ただし、Modularの問題は、「全プラットフォーム開発ツール」のビジョンが理想主義的すぎることです。

「Beyond Python」というタイトルを持ち、Chris Lattnerの評判によって承認されていますが、Mojoは新しい言語として、プロモーションの観点から多くの開発者によってテストされる必要があります。

AIエンジンは、多くのハードウェア会社との契約だけでなく、プラットフォーム間の互換性についても、より多くの問題に直面しています。 これらはすべて、完了するまでに長い時間の研磨を必要とするタスクであり、その時点でNvidiaが何に進化するかは、誰も知らないのではないかと思います。

チャレンジャーファーウェイ

10月17日、米国はAIチップの輸出管理規則を更新し、NVIDIAなどの企業が高度なAIチップを中国に輸出することを禁止しました。 最新の規則によると、A800やH800を含むNVIDIAの中国へのチップ輸出が影響を受けます。

以前は、NVIDIA A100とH100の2つのモデルが中国への輸出が制限された後、中国専用の「去勢バージョン」A800とH800が規制に準拠するように設計されていました。 インテルはまた、中国市場向けにAIチップGaudi2を発売しました。 今、企業は新しい輸出禁止の下で対応を調整しなければならないようです。

今年8月、Huaweiの自社開発のKirin 60Sチップを搭載したMate9000Proが突然発売され、即座に世論の大きな波を引き起こし、ほぼ同時に別のニュースがすぐにかき消されました。

iFLYTEKのLiu Qingfeng会長は、公開イベントで珍しい声明を発表し、HuaweiのGPUはNVIDIA A100に対してベンチマークできるが、HuaweiがiFLYTEKの作業を最適化するための特別なワーキンググループを派遣した場合に限られると述べた。

このような突然の発言には深い意図があることが多く、それを予測する能力はありませんが、2か月後のチップ禁止に対応することの有用性は依然としてあります。

Ascend AIフルスタックソフトウェアおよびハードウェアプラットフォームであるHuawei GPUには、Atlasシリーズハードウェア、ヘテロジニアスコンピューティングアーキテクチャ、AIフレームワーク、アプリケーションイネーブルメント、およびボトムアップの業界アプリケーションの5つのレイヤーが含まれています。

基本的に、HuaweiはNVIDIAの一連の代替品を作成し、チップ層はAscend 910とAscend 310であり、ヘテロジニアスコンピューティングアーキテクチャ(CANN)はNVIDIA CUDA + CuDNNコアソフトウェア層をベンチマークしていることがわかります。

1シングルカードのパフォーマンスは遅れており、Ascend 910とA100の間にはまだギャップがありますが、勝利は価格が安く、金額を積み重ねることができ、クラスター規模に達した後の全体的なギャップは大きくありません。

2 生態学的な欠点は存在しますが、Huaweiは、たとえば、PyTorchコミュニティとAscendの協力を通じて、PyTorchバージョン2.1がAscend NPUを同期的にサポートしているため、開発者はPyTorch 2.1でAscendに基づくモデルを直接開発できます。

現在、Huawei Ascendは主にHuawei独自のクローズドループ大型モデル製品を実行しており、Huaweiのプラットフォームで実行するには、Huaweiがパブリックモデルを深く最適化する必要があり、最適化作業のこの部分はHuaweiに大きく依存しています。

現在の文脈では、アセンドは特別な意味を持っています。

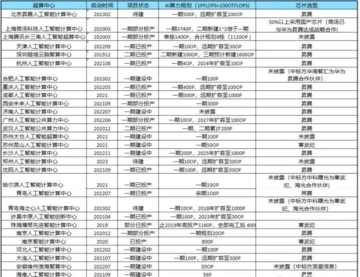

今年5月、ファーウェイのAscendコンピューティング事業のZhang Dixuan社長は、「Ascend AI」の基本的なソフトウェアとハードウェアのプラットフォームが30以上の主流の大型モデルにインキュベートされ、適応しており、中国のネイティブの大型モデルの半分以上が、鵬城シリーズ、Zidongシリーズ、HUAWEI CLOUD Panguシリーズを含む「Ascend AI」の基本的なソフトウェアとハードウェアプラットフォームに基づいていることを明らかにした。 今年8月、BaiduはAscend AIのフライングオール+ウェンシンモデルへの適応も正式に発表しました。

エピローグ**

2006年、NVIDIAがその壮大な物語を展開していたとき、誰もCUDAが革新的な製品になるとは思っていなかったため、黄は取締役会を説得して、10年以上の未知の回収期間に賭けるために年間5億ドルを投資しなければならず、NVIDIAの収益はその年のわずか30億ドルでした。

しかし、テクノロジーとイノベーションをキーワードとして使用するすべてのビジネスストーリーには、長期的な目標を永続的に遵守しているため、常に大きな成功を収めている人々がおり、NVIDIAとHuaweiは最高です。

リソース

[1] NVIDIAの「鎌」はAIチップではなく、シリコンベースの研究所です

[2] 「NVIDIAの代替品」になるために、大手モデルメーカーが本を開き、小さなディナーテーブルが服を作成しました

[3] 設立からわずか1年で、このAIスタースタートアップはNVIDIAとマグネシウムケネットに挑戦したいと考えています

[4] エヌビディア帝国の亀裂、江津川研究所

[5] 米国は中国へのチップ輸出を強化する計画であり、ファーウェイは国内生産の増加をリードし、西中国証券は

[6] AIGC業界詳細レポート(11):ファーウェイのコンピューティングパワースピンオフ:世界のAIコンピューティングパワーの第2極、西中国証券

[7] 2023年AIGC業界特別レポート:AIチップの4つの主要な技術ルート、カンブリア紀コピーNVIDIA、シェンワンホンユアン

[8] CUDAがNVIDIAを達成する方法:AIの大きなブレークスルー、テンセントクラウドコミュニティ