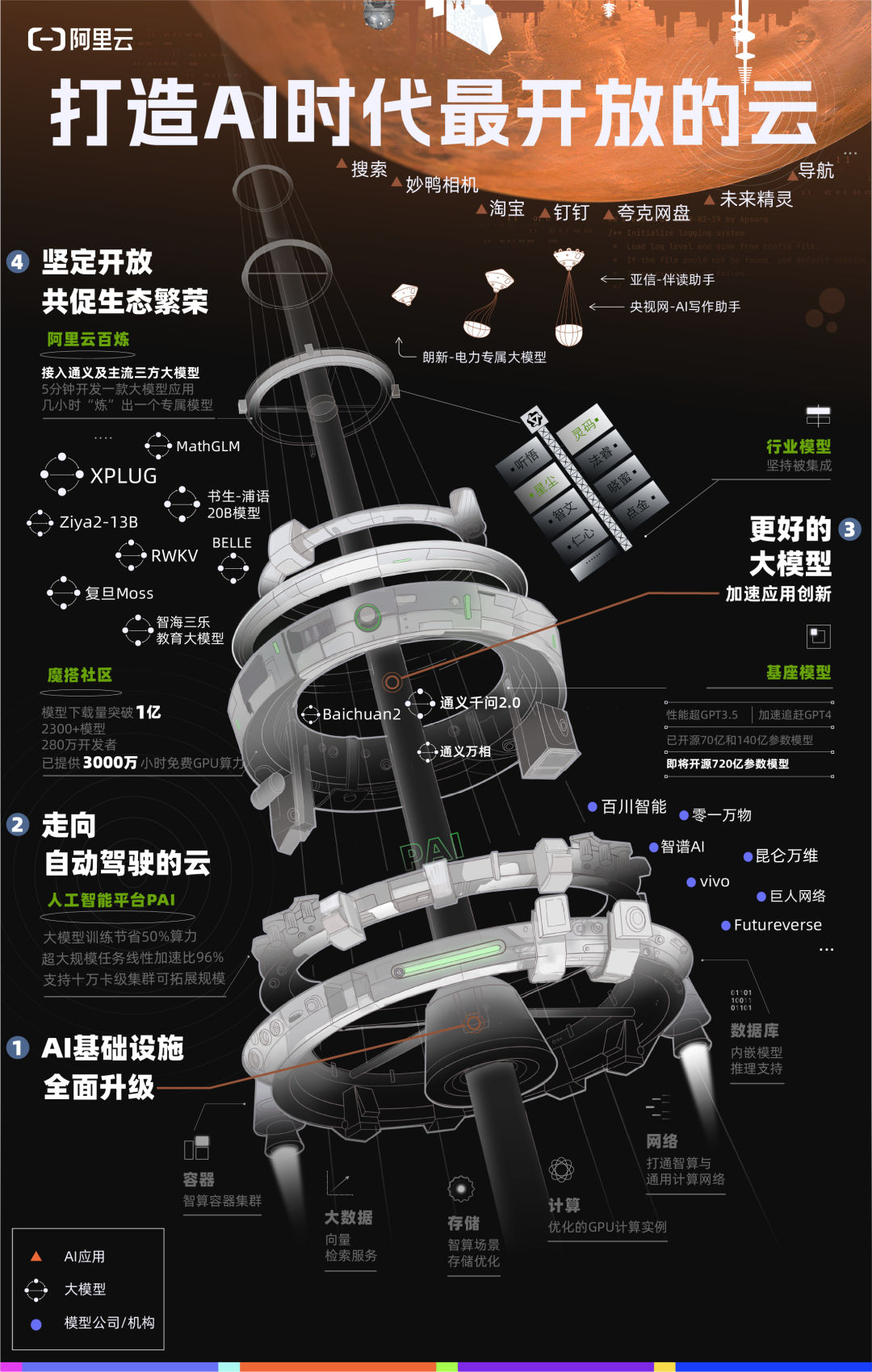

出典:シリコン・スター・ピープル 画像ソース: Unbounded AIによって生成**雲! **ビッグモデルに関するメディア報道を毎日見ていると、モデルの多様性と短命な怖いアプリケーションに目がくらみ、モデルの未来は次のオールラウンドオールラウンドモデルにあると考えます。 つまり、AIはOpenAIかAnthropicのどちらかが勝つという話のようです。 ## 驚異的なスピードとボリュームで完了した資金調達は、この認識を証明しているようです。 OpenAIの最大のライバルの1つと見なされているAnthropicは、月間20億ドルのサイクルで資金調達を行っています - 10月27日、GoogleはAmazonが40億ドルを投資してから1か月も経たないうちに、さらに20億ドルを投資したと発表し、コンテキストの長さなどの機能で競合するモデルClaudeは、ChatGPTの最強の競争相手の1つと見なされています。 同時に、OpenAIもさまざまなリソースを集めており、その一挙手一投足の裏には、ソフトバンク、マイクロソフト、アップルなど、さまざまな形でOpenAIが噂されています。しかし、実際にはこれがすべてではありません。開業医にとって、話の反対側はもっと深いです。明らかに、より多くのお金を持っていて、やることが少ない投資家のお金を取る方が良い選択ですが、彼らは皆、クラウドコンピューティング機能を持っているという理由だけで、大きな工場を次々と選び、さらには彼らに目を向けている大きな工場さえも選びます。 OpenAIのMicrosoft Azureへの貢献は、成功への道のりで何度も言われてきたが、Anthropicは現在、GoogleとAmazonのクラウドコンピューティングパワーサポートを同時に保証しており、資金調達の重要な目的の1つは、次世代のモデルをトレーニングするためのコンピューティングパワーの保証を構築することだと述べている。これは、大規模なモデルにクラウドが必要であることを示す優れた証拠です。 10 月 31 日に開催された Apsara Conference では、Alibaba Cloud の一連のデータから同様のことが示されました。Alibaba Cloud は、独自の Tongyi 大規模モデルから、Baichuan Intelligence、Zhipu AI、Zero One Everything、Kunlun Wanwei、vivo、復旦大学など、中国の大手モデル企業や機関の半数がここでトレーニングを受けているなど、サービス上で動作するモデルの一部を発表しました。中国のこれらの主流モデルは、Tongyiシリーズ、Baichuanシリーズ、Zhipu AI ChatGLMシリーズ、Jiang Ziya一般モデルなど、Alibaba Cloudを通じてAPIサービスも提供しています。これらのモデルは、同時にトップレベルに追いつくが、また、中国で最もヘッド大規模なモデル企業Baichuanインテリジェンスの1つの中で、独自の特性を成長させ始め、大規模なモデルのレコードのバージョンを反復するために28日の平均を設定している、それは10月30日Baichuan2 - 192Kの最新リリースは、大規模なモデルのコンテキストウィンドウのための世界最長のサポートとなっている、一度に350,000語を入力することができ、Claude2 - 100Kをリードしています。これらの利点はすべて、より現実的なアプリケーションを示しています。 Baichuan IntelligenceのWang Xiaochuan最高経営責任者(CEO)は、これを「理想より1歩遅く、地上では3歩速い」と表現した。 一方、クラウドインフラストラクチャは、高速な可能性を提供します。Wang Xiaochuan氏は、白川モデルが毎月反復される重要な理由は、クラウドコンピューティングのサポートであると紹介しました。 「このモデルの迅速な反復と展開は、クラウドコンピューティングと切り離せません。Baichuan Intelligence と Alibaba Cloud は綿密な協力関係を築いてきました。 両当事者の共同の取り組みにより、Baichuanはキロカロリー大規模モデルのトレーニングタスクを無事に完了し、モデル推論のコストを効果的に削減し、モデル展開の効率を向上させました。 "クラウドコンピューティングの重要性が見落とされてきたもう一つの理由は、AI分野が「すべての人のためのカードの欠如」に気を取られてきたことです。「人々はGPUに注意を払いすぎています」 多くの大規模モデル実務家は、コンピューティングユニットとしては常に強化されているが、AIの問題を解決するために最終的に必要なのは、体系的で最適なコンピューティングパワーソリューションであると私に言いました。 クラウドでさえ、1つのユニットでは強度が足りないという問題を、その誕生以来解決するものでした。「カードだけでは不十分で、紙の中の素晴らしいモデルだけでは不十分です。最終的に雲に頼って着陸し、理想を実現します。」 とおっしゃっていました。 注意深く耳を澄ませて、モデルエコロジーの最前線にいるこれらの実際の参加者の「叫び」に耳を傾けると、次の一言が聞こえるかもしれません。雲!AIの未来がどのように進化するかは、これまで以上にクラウドにかかっています。 ## **新しいクラウド** しかし、だからといって、優位性を確立したクラウドベンダーが手をこまねいて勝てるわけではありません。GoogleとMicrosoftが最近同じ日に決算報告を発表した後に何が起こったかを見てください。Googleは10月25日、前年同期比11%増と予想を上回る決算を発表し、中核となる広告事業も9%増となった。 しかし、その後、株価は下落しました。 その理由はただ一つ、クラウドコンピューティングが22%成長したことですが、市場はそれだけでは十分ではないと考えています。 特に、同日に発表されたMicrosoftの財務報告では、インテリジェントクラウド部門が最大の収益源となったことが示されました。巨人たちは、かつて話題にした広告などのビジネスから初めて脇に追いやられていることに気づいたのは、クラウドコンピューティングが、まだ幻想的なモデルによって生み出される直接的な収益と比較して、観察可能な指標と見なされているからです。 この指標の背景には、クラウドベンダーがAIがもたらす課題に適応する能力があります。市場シェアNo.1のAWSでさえプレッシャーを感じており、AmazonのAnthropicへの投資も今回の決算発表で行われました。 MicrosoftのAzure収益の3%はAIによるものと報じられており、顧客にはOpenAIユーザーも多数含まれており、AWSは様々なモデル向けのサービスに力を入れ始めています。 Anthropicに20億を投じた後、モデル会社後のLLMはAWSのトレーニングアクセラレーションチップTrainiumと推論チップInferentiaで構築されることがすぐに発表されました。 また、Microsoftの財務報告で取り上げられた新しいクラスタソリューションや、AWS向けのフルマネージドベーシックモデルサービスであるBedrockなども、新しいAIニーズに対する独自の変革を強調しています。 「インテリジェント時代に直面して、Alibaba Cloud は、基盤となるコンピューティングパワーから AI プラットフォーム、モデルサービスまで、フルスタックの技術革新を通じてクラウドコンピューティングシステムをアップグレードします。」 Alibaba Cloud のテクニカルルートを決定する Zhou Jingren 氏も、Apsara Conference で回答しました。 今回Alibaba Cloudに反映された変更は決定的で徹底しており、テクスチャからコアまで、すべてがAI向けに変換されています。Zhou Jingren氏の紹介によると、Alibaba Cloudは最初に大規模モデルを使用して自らを変革し、30以上のクラウドプロダクトが大規模モデル機能に接続されています。たとえば、Alibaba Cloud のビッグデータガバナンスプラットフォームである DataWorks は、ユーザーが自然言語入力で SQL ステートメントを生成し、対応するデータ ETL 操作を自動的に実行できる新しいインタラクティブフォームである Copilot を追加し、全体的な開発と分析の効率を 30% 以上向上させました。Zhou Jingren氏は、これをクラウドコンピューティングの自動運転モードと表現し、クラウドを使用する開発者の効率とエクスペリエンスを大幅に向上させると説明しました。同時に、Alibaba Cloud は人工知能プラットフォーム PAI もアップグレードしました。 PAIの基盤層はHPN 7.0次世代AIクラスターネットワークアーキテクチャを使用し、最大100,000枚のカードのスケーラブルなクラスタースケールをサポートし、超大規模分散トレーニングの加速率は96%と高く、業界レベルをはるかに超えています。 大規模なモデルのトレーニングタスクでは、コンピューティングリソースを50%以上節約でき、パフォーマンスは世界をリードしています。これらの専門用語は少し複雑で、単純な顧客事例で説明されており、Zhou Jingren氏は同日、「当社のPAIプラットフォームを通じて、推論を最適化し、小紅書がコストを30%節約し、小紅書の急速なビジネス成長とさまざまなビジネスニーズを実際に促進することができます」といくつかのケースを共有しました。 "Alibaba Cloud を含むクラウドベンダーは、基本的に新しいインフラストラクチャを模索しています。 大規模モデルなどのAIテクノロジーがもたらす変化は、モデルの最下層からトレーニングのアイデアまで、データ要件からインタラクティブなインターフェースまで、フルスタックであり、変化しており、「やり直し」さえ必要です。Alibaba Cloud のすべての変革の出発点は、Zhou Jingren が初期に提案した MaaS (Model as a Service) です。「モデル自体は、データと計算を高レベルで抽象化したものです」 周景仁は、その日、私たちとの小さなやり取りの中で言った。「たとえば、以前はログやデータベースからのデータをより多く使用していました。 モデルは何ですか? モデルは処理されたデータの集合体であり、高度に知的な抽象化です。 したがって、この観点から、元のデータは、元の計算能力に依存した、より原始的な生産材料であると考えることができます。 現在のモデルは、データ原料をベースとしたより抽象的な生産要素である加工層であり、このような生産要素を利用して、より高次元の業務システムを開発できます。 以前は、運用要素であるインフラストラクチャがありましたが、今日ではモデルも運用要素です。 "このモデルを取り巻くこの新しいインフラストラクチャには、以前よりも複雑なシステム機能が必要です。AIアプリケーションの敷居はどんどん低くなっていますが、新しいAI時代のニーズを満たすクラウドコンピューティングを提供するための敷居はますます高くなるでしょう。 この新しいことを探求するには、クラウド コンピューティングのコア テクノロジを習得する必要があることは明らかであり、大規模なモデルのテクノロジを真に理解する必要があります。「クラウドコンピューティングの蓄積に基づいて、完全なAIインフラストラクチャを構築しました。 ネットワーク、ストレージ、スケジューリング、コンパイル、フォールトトレランスなどにおける今日の一連の最適化を通じて。 AI大規模モデルのための完全なトレーニングプラットフォームを確立しました。 周景仁は言った。 同時に、クラウド自体の高い弾力性と組み合わせた一連の最適化により、非常に完全なモデルトレーニングおよび推論サービスを提供できます。 "同日、Alibaba Cloudは自社開発の1,000億レベルのパラメータモデル「Tongyi Qianwen 2.0」もリリースしました。  Tongyi Qianwen 2.0は性能が大きく進歩し、複雑な指示を理解する能力、文学的創造能力、一般的な数学能力、知識記憶、錯覚耐性などが大幅に向上し、その総合的な性能はGPT-3.5を上回り、GPT-4に追いつくために加速しました。同時に、Tongyiモデルの公式Webサイトが完全に更新され、マルチモーダルインタラクションとプラグイン機能が追加され、ユーザーは写真を介してTongyi Qianwen 2.0と対話したり、より豊富な新しいプラグイン機能を呼び出すことができます。Zhou Jingren氏は「Tongyi Qianwen 2.0はより成熟し、使いやすい」と述べた。 ## **開く、開く、または開く** このような包括的な変革では、モデルもインフラも、いずれは審判員とアスリートを兼ねる状況になるのかという疑問が当然湧いてきます。Alibaba Cloud が提示する答えは、最大限のオープン性です。Alibaba Cloud は、自社開発の大規模モデルをオープンソース化した中国で最も早いテクノロジー企業であり、現在、Alibaba Cloud は Tongyi Qianwen 7B および 14B バージョンをオープンソース化しており、100 万回以上ダウンロードされています。 現場で、Zhou Jingrenは、Tongyi Qianwen 72Bモデルがまもなくオープンソースになり、中国で最大のオープンソースモデルになると発表しました。実は、このようなオープンさは、ChatGPTの後に起こることではありません。 1年前のApsara Conferenceで、Alibaba Cloudはモデルコミュニティマジックビルディングの構築に着手し、実際、当時のオープンソースの最初のバッチはAlibaba Cloud独自のコアモデルでした。 当時のModaの計画は、Alibaba Cloudを使って箱の底にあるものを手渡し、過去のAIの閉鎖的な状態を誰もが変えられるように促し、オープン性を利用して真に一般に公開することでした。Zhou Jingren氏は、コミュニティは現在2,300以上のAIモデルを収集し、280万人のAI開発者を引き付け、AIモデルのダウンロード数が1億を超え、中国で最大かつ最も活発なAIコミュニティになっていることを明らかにしました。 この成果は、その外界への開放性を最も直接的に認めたものです。 現在、マジックコミュニティでは、Baichuan Intelligence、Zhipu AI、Shanghai Artificial Intelligence Laboratory、IDEA Research Instituteなどがコアの大規模モデルをオープンソース化し、Alibaba Cloudは、これまでに3,000万時間を超えた大規模モデルの「アーリーアダプター」にGPUコンピューティングパワーを開発者に無料で提供しています。「今日の私たちのポジショニングは、さまざまなニーズを持つさまざまなお客様にサービスを提供することです。」 周景仁は言った。Alibaba Cloud エコシステムには、復旦大学と共同で構築したスーパーコンピューターがあり、数千億のパラメーターを持つ大規模なモデルトレーニングをサポートし、全体的な計算能力の点で世界のトップ 15 にランクされています。 その背後にあるコンピューティングクラスターは、復旦キャンパスの Jinsi No. 1 と、1,500 km 離れた Alibaba Cloud の Ulanqab データセンターの Qiewen No. 1 で構成されています。vivo は、コンピューティング能力、プラットフォーム機能、トレーニングパフォーマンスなどから、Alibaba Cloud の人工知能プラットフォーム PAI のトレーニング最適化フレームワークまで、自社開発の大規模モデルを備えており、大規模モデルの SFT 監視と微調整、強化学習の観点から、vivo と Alibaba Cloud は協力して大規模モデルをより効率的に反復します。また、人気の「Wonderful Duck Camera」は、写真の生成にはピークレベルで少なくとも数千台のGPUサーバーが必要であり、オフライン展開は実用的ではなく、クラウド展開はスタートアップのコストと時間を大幅に節約できます。 さらに、Miaoyaのようなアプリケーションは、将来、推論の必要性がトレーニングの必要性を上回る傾向を表しており、AIサービスの持続可能性にとってクラウドコンピューティングの重要性が高まるだけです。このようなポジショニングの下では、Alibaba Cloud の大規模モデルは、Alibaba が過去に常に使用してきたアイデア、つまりベストプラクティスの延長線上にあるようなものです。 その考え方は、最も複雑なタスクを実行し、それを使用してインフラストラクチャをテストした場合にのみ、より信頼性の高いサービスとテクノロジーを外部に提供できるというものです。 そして、これらの取り組みはすべて、最終的にはAIの産業化を促進するという1つの目標を目指しています。この目標を念頭に置いて、Alibaba Cloud は、ワンストップの大規模モデルアプリケーション開発プラットフォームである Alibaba Cloud Bailian もリリースしました。 Alibaba Cloud は、システマティックでオープンなインテグレーターです。 Alibaba Cloudによると、開発者はこれに基づいて大規模なモデルアプリケーションを5分で開発し、エンタープライズ固有のモデルを数時間で「改良」できるという。 開発者が最適なモデルを選択できるように支援した後、SFTやLoRAなどのさまざまな微調整方法も提供し、モデルを微調整できます。 トレーニングが完了したら、Alibaba Cloud からワンクリックでデプロイすることもできます。 アプリケーションの開発も大幅に簡素化され、最新のエージェントやその他のプラグインもユーザーが選択できます。「すべてのリンクとすべての人々のグループは、今日の開発者エコシステム全体の重要な部分です。」 周景仁は言った。「私たちの目標は、Alibaba Cloud を最もオープンなクラウドにすることです。今日、Alibaba Cloud が 1 つのタイプの顧客だけでなく、さまざまな方法で言及されている今日のすべての顧客にサービスを提供し、人工知能の時代に効果的にサポートを提供し、それぞれの専門分野で革新とブレークスルーを実現できることを願っています。 これが私たちの目標であり、今日の製品のデザインに反映されています。 "今日の「理想的な一歩遅れ」では、活発なモデルエコシステムは実際の開発にクラウドを必要とするだけでなく、中国のテクノロジー企業にとってのクラウドコンピューティングのインスピレーションも、今日のAIおよびモデルの実践者にとって非常に重要です。 中国のクラウドコンピューティング開発プロセスは、常に象徴的な意味を持っていました、つまり、強力な技術開発の才能と最も広範な産業アプリケーションのニーズがある場合、基盤となる技術を自発的に把握する方法です。 そして、あなたが特定の技術的不利な立場にあるとき、そのような機会は、大きな技術システムが完全に変革されたときにのみ現れます。新たな技術革命が再び到来し、基盤となる技術を再構築する必要があるとき、クラウドコンピューティングは、先進的な同業他社と格闘し続けるための中国のモデルの自信とコストとなり、インスピレーションと警告でもあります。 AI産業やAIの活用が加速する中、独自の最先端技術基盤を持ち、それに基づくオープンで相互扶助的な関係を形成することは、エコシステム全体が共に発展していく上で重要であり、この技術革新をどう捉えるかを思い出させることも重要であり、継続的な努力でこの競争の優位性となることも期待されています。

大きなモデルを見つめるだけではダメで、AIの未来はかつてないほどクラウドにかかっています

出典:シリコン・スター・ピープル

**雲! **

ビッグモデルに関するメディア報道を毎日見ていると、モデルの多様性と短命な怖いアプリケーションに目がくらみ、モデルの未来は次のオールラウンドオールラウンドモデルにあると考えます。 つまり、AIはOpenAIかAnthropicのどちらかが勝つという話のようです。

驚異的なスピードとボリュームで完了した資金調達は、この認識を証明しているようです。

OpenAIの最大のライバルの1つと見なされているAnthropicは、月間20億ドルのサイクルで資金調達を行っています - 10月27日、GoogleはAmazonが40億ドルを投資してから1か月も経たないうちに、さらに20億ドルを投資したと発表し、コンテキストの長さなどの機能で競合するモデルClaudeは、ChatGPTの最強の競争相手の1つと見なされています。 同時に、OpenAIもさまざまなリソースを集めており、その一挙手一投足の裏には、ソフトバンク、マイクロソフト、アップルなど、さまざまな形でOpenAIが噂されています。

しかし、実際にはこれがすべてではありません。

開業医にとって、話の反対側はもっと深いです。

明らかに、より多くのお金を持っていて、やることが少ない投資家のお金を取る方が良い選択ですが、彼らは皆、クラウドコンピューティング機能を持っているという理由だけで、大きな工場を次々と選び、さらには彼らに目を向けている大きな工場さえも選びます。 OpenAIのMicrosoft Azureへの貢献は、成功への道のりで何度も言われてきたが、Anthropicは現在、GoogleとAmazonのクラウドコンピューティングパワーサポートを同時に保証しており、資金調達の重要な目的の1つは、次世代のモデルをトレーニングするためのコンピューティングパワーの保証を構築することだと述べている。

これは、大規模なモデルにクラウドが必要であることを示す優れた証拠です。

Alibaba Cloud は、独自の Tongyi 大規模モデルから、Baichuan Intelligence、Zhipu AI、Zero One Everything、Kunlun Wanwei、vivo、復旦大学など、中国の大手モデル企業や機関の半数がここでトレーニングを受けているなど、サービス上で動作するモデルの一部を発表しました。

中国のこれらの主流モデルは、Tongyiシリーズ、Baichuanシリーズ、Zhipu AI ChatGLMシリーズ、Jiang Ziya一般モデルなど、Alibaba Cloudを通じてAPIサービスも提供しています。

これらのモデルは、同時にトップレベルに追いつくが、また、中国で最もヘッド大規模なモデル企業Baichuanインテリジェンスの1つの中で、独自の特性を成長させ始め、大規模なモデルのレコードのバージョンを反復するために28日の平均を設定している、それは10月30日Baichuan2 - 192Kの最新リリースは、大規模なモデルのコンテキストウィンドウのための世界最長のサポートとなっている、一度に350,000語を入力することができ、Claude2 - 100Kをリードしています。

これらの利点はすべて、より現実的なアプリケーションを示しています。 Baichuan IntelligenceのWang Xiaochuan最高経営責任者(CEO)は、これを「理想より1歩遅く、地上では3歩速い」と表現した。 一方、クラウドインフラストラクチャは、高速な可能性を提供します。

Wang Xiaochuan氏は、白川モデルが毎月反復される重要な理由は、クラウドコンピューティングのサポートであると紹介しました。 「このモデルの迅速な反復と展開は、クラウドコンピューティングと切り離せません。Baichuan Intelligence と Alibaba Cloud は綿密な協力関係を築いてきました。 両当事者の共同の取り組みにより、Baichuanはキロカロリー大規模モデルのトレーニングタスクを無事に完了し、モデル推論のコストを効果的に削減し、モデル展開の効率を向上させました。 "

クラウドコンピューティングの重要性が見落とされてきたもう一つの理由は、AI分野が「すべての人のためのカードの欠如」に気を取られてきたことです。

「人々はGPUに注意を払いすぎています」 多くの大規模モデル実務家は、コンピューティングユニットとしては常に強化されているが、AIの問題を解決するために最終的に必要なのは、体系的で最適なコンピューティングパワーソリューションであると私に言いました。 クラウドでさえ、1つのユニットでは強度が足りないという問題を、その誕生以来解決するものでした。

「カードだけでは不十分で、紙の中の素晴らしいモデルだけでは不十分です。最終的に雲に頼って着陸し、理想を実現します。」 とおっしゃっていました。 注意深く耳を澄ませて、モデルエコロジーの最前線にいるこれらの実際の参加者の「叫び」に耳を傾けると、次の一言が聞こえるかもしれません。

雲!

AIの未来がどのように進化するかは、これまで以上にクラウドにかかっています。

新しいクラウド

しかし、だからといって、優位性を確立したクラウドベンダーが手をこまねいて勝てるわけではありません。

GoogleとMicrosoftが最近同じ日に決算報告を発表した後に何が起こったかを見てください。

Googleは10月25日、前年同期比11%増と予想を上回る決算を発表し、中核となる広告事業も9%増となった。 しかし、その後、株価は下落しました。 その理由はただ一つ、クラウドコンピューティングが22%成長したことですが、市場はそれだけでは十分ではないと考えています。 特に、同日に発表されたMicrosoftの財務報告では、インテリジェントクラウド部門が最大の収益源となったことが示されました。

巨人たちは、かつて話題にした広告などのビジネスから初めて脇に追いやられていることに気づいたのは、クラウドコンピューティングが、まだ幻想的なモデルによって生み出される直接的な収益と比較して、観察可能な指標と見なされているからです。 この指標の背景には、クラウドベンダーがAIがもたらす課題に適応する能力があります。

市場シェアNo.1のAWSでさえプレッシャーを感じており、AmazonのAnthropicへの投資も今回の決算発表で行われました。 MicrosoftのAzure収益の3%はAIによるものと報じられており、顧客にはOpenAIユーザーも多数含まれており、AWSは様々なモデル向けのサービスに力を入れ始めています。 Anthropicに20億を投じた後、モデル会社後のLLMはAWSのトレーニングアクセラレーションチップTrainiumと推論チップInferentiaで構築されることがすぐに発表されました。 また、Microsoftの財務報告で取り上げられた新しいクラスタソリューションや、AWS向けのフルマネージドベーシックモデルサービスであるBedrockなども、新しいAIニーズに対する独自の変革を強調しています。

Zhou Jingren氏の紹介によると、Alibaba Cloudは最初に大規模モデルを使用して自らを変革し、30以上のクラウドプロダクトが大規模モデル機能に接続されています。

たとえば、Alibaba Cloud のビッグデータガバナンスプラットフォームである DataWorks は、ユーザーが自然言語入力で SQL ステートメントを生成し、対応するデータ ETL 操作を自動的に実行できる新しいインタラクティブフォームである Copilot を追加し、全体的な開発と分析の効率を 30% 以上向上させました。

Zhou Jingren氏は、これをクラウドコンピューティングの自動運転モードと表現し、クラウドを使用する開発者の効率とエクスペリエンスを大幅に向上させると説明しました。

同時に、Alibaba Cloud は人工知能プラットフォーム PAI もアップグレードしました。 PAIの基盤層はHPN 7.0次世代AIクラスターネットワークアーキテクチャを使用し、最大100,000枚のカードのスケーラブルなクラスタースケールをサポートし、超大規模分散トレーニングの加速率は96%と高く、業界レベルをはるかに超えています。 大規模なモデルのトレーニングタスクでは、コンピューティングリソースを50%以上節約でき、パフォーマンスは世界をリードしています。

これらの専門用語は少し複雑で、単純な顧客事例で説明されており、Zhou Jingren氏は同日、「当社のPAIプラットフォームを通じて、推論を最適化し、小紅書がコストを30%節約し、小紅書の急速なビジネス成長とさまざまなビジネスニーズを実際に促進することができます」といくつかのケースを共有しました。 "

Alibaba Cloud を含むクラウドベンダーは、基本的に新しいインフラストラクチャを模索しています。 大規模モデルなどのAIテクノロジーがもたらす変化は、モデルの最下層からトレーニングのアイデアまで、データ要件からインタラクティブなインターフェースまで、フルスタックであり、変化しており、「やり直し」さえ必要です。

Alibaba Cloud のすべての変革の出発点は、Zhou Jingren が初期に提案した MaaS (Model as a Service) です。

「モデル自体は、データと計算を高レベルで抽象化したものです」 周景仁は、その日、私たちとの小さなやり取りの中で言った。

「たとえば、以前はログやデータベースからのデータをより多く使用していました。 モデルは何ですか? モデルは処理されたデータの集合体であり、高度に知的な抽象化です。 したがって、この観点から、元のデータは、元の計算能力に依存した、より原始的な生産材料であると考えることができます。 現在のモデルは、データ原料をベースとしたより抽象的な生産要素である加工層であり、このような生産要素を利用して、より高次元の業務システムを開発できます。 以前は、運用要素であるインフラストラクチャがありましたが、今日ではモデルも運用要素です。 "

このモデルを取り巻くこの新しいインフラストラクチャには、以前よりも複雑なシステム機能が必要です。

AIアプリケーションの敷居はどんどん低くなっていますが、新しいAI時代のニーズを満たすクラウドコンピューティングを提供するための敷居はますます高くなるでしょう。 この新しいことを探求するには、クラウド コンピューティングのコア テクノロジを習得する必要があることは明らかであり、大規模なモデルのテクノロジを真に理解する必要があります。

「クラウドコンピューティングの蓄積に基づいて、完全なAIインフラストラクチャを構築しました。 ネットワーク、ストレージ、スケジューリング、コンパイル、フォールトトレランスなどにおける今日の一連の最適化を通じて。 AI大規模モデルのための完全なトレーニングプラットフォームを確立しました。 周景仁は言った。 同時に、クラウド自体の高い弾力性と組み合わせた一連の最適化により、非常に完全なモデルトレーニングおよび推論サービスを提供できます。 "

同日、Alibaba Cloudは自社開発の1,000億レベルのパラメータモデル「Tongyi Qianwen 2.0」もリリースしました。

同時に、Tongyiモデルの公式Webサイトが完全に更新され、マルチモーダルインタラクションとプラグイン機能が追加され、ユーザーは写真を介してTongyi Qianwen 2.0と対話したり、より豊富な新しいプラグイン機能を呼び出すことができます。

Zhou Jingren氏は「Tongyi Qianwen 2.0はより成熟し、使いやすい」と述べた。

開く、開く、または開く

このような包括的な変革では、モデルもインフラも、いずれは審判員とアスリートを兼ねる状況になるのかという疑問が当然湧いてきます。

Alibaba Cloud が提示する答えは、最大限のオープン性です。

Alibaba Cloud は、自社開発の大規模モデルをオープンソース化した中国で最も早いテクノロジー企業であり、現在、Alibaba Cloud は Tongyi Qianwen 7B および 14B バージョンをオープンソース化しており、100 万回以上ダウンロードされています。 現場で、Zhou Jingrenは、Tongyi Qianwen 72Bモデルがまもなくオープンソースになり、中国で最大のオープンソースモデルになると発表しました。

実は、このようなオープンさは、ChatGPTの後に起こることではありません。 1年前のApsara Conferenceで、Alibaba Cloudはモデルコミュニティマジックビルディングの構築に着手し、実際、当時のオープンソースの最初のバッチはAlibaba Cloud独自のコアモデルでした。 当時のModaの計画は、Alibaba Cloudを使って箱の底にあるものを手渡し、過去のAIの閉鎖的な状態を誰もが変えられるように促し、オープン性を利用して真に一般に公開することでした。

Zhou Jingren氏は、コミュニティは現在2,300以上のAIモデルを収集し、280万人のAI開発者を引き付け、AIモデルのダウンロード数が1億を超え、中国で最大かつ最も活発なAIコミュニティになっていることを明らかにしました。 この成果は、その外界への開放性を最も直接的に認めたものです。

「今日の私たちのポジショニングは、さまざまなニーズを持つさまざまなお客様にサービスを提供することです。」 周景仁は言った。

Alibaba Cloud エコシステムには、復旦大学と共同で構築したスーパーコンピューターがあり、数千億のパラメーターを持つ大規模なモデルトレーニングをサポートし、全体的な計算能力の点で世界のトップ 15 にランクされています。 その背後にあるコンピューティングクラスターは、復旦キャンパスの Jinsi No. 1 と、1,500 km 離れた Alibaba Cloud の Ulanqab データセンターの Qiewen No. 1 で構成されています。

vivo は、コンピューティング能力、プラットフォーム機能、トレーニングパフォーマンスなどから、Alibaba Cloud の人工知能プラットフォーム PAI のトレーニング最適化フレームワークまで、自社開発の大規模モデルを備えており、大規模モデルの SFT 監視と微調整、強化学習の観点から、vivo と Alibaba Cloud は協力して大規模モデルをより効率的に反復します。

また、人気の「Wonderful Duck Camera」は、写真の生成にはピークレベルで少なくとも数千台のGPUサーバーが必要であり、オフライン展開は実用的ではなく、クラウド展開はスタートアップのコストと時間を大幅に節約できます。 さらに、Miaoyaのようなアプリケーションは、将来、推論の必要性がトレーニングの必要性を上回る傾向を表しており、AIサービスの持続可能性にとってクラウドコンピューティングの重要性が高まるだけです。

このようなポジショニングの下では、Alibaba Cloud の大規模モデルは、Alibaba が過去に常に使用してきたアイデア、つまりベストプラクティスの延長線上にあるようなものです。 その考え方は、最も複雑なタスクを実行し、それを使用してインフラストラクチャをテストした場合にのみ、より信頼性の高いサービスとテクノロジーを外部に提供できるというものです。 そして、これらの取り組みはすべて、最終的にはAIの産業化を促進するという1つの目標を目指しています。

この目標を念頭に置いて、Alibaba Cloud は、ワンストップの大規模モデルアプリケーション開発プラットフォームである Alibaba Cloud Bailian もリリースしました。 Alibaba Cloud は、システマティックでオープンなインテグレーターです。

「すべてのリンクとすべての人々のグループは、今日の開発者エコシステム全体の重要な部分です。」 周景仁は言った。

「私たちの目標は、Alibaba Cloud を最もオープンなクラウドにすることです。今日、Alibaba Cloud が 1 つのタイプの顧客だけでなく、さまざまな方法で言及されている今日のすべての顧客にサービスを提供し、人工知能の時代に効果的にサポートを提供し、それぞれの専門分野で革新とブレークスルーを実現できることを願っています。 これが私たちの目標であり、今日の製品のデザインに反映されています。 "

今日の「理想的な一歩遅れ」では、活発なモデルエコシステムは実際の開発にクラウドを必要とするだけでなく、中国のテクノロジー企業にとってのクラウドコンピューティングのインスピレーションも、今日のAIおよびモデルの実践者にとって非常に重要です。

新たな技術革命が再び到来し、基盤となる技術を再構築する必要があるとき、クラウドコンピューティングは、先進的な同業他社と格闘し続けるための中国のモデルの自信とコストとなり、インスピレーションと警告でもあります。 AI産業やAIの活用が加速する中、独自の最先端技術基盤を持ち、それに基づくオープンで相互扶助的な関係を形成することは、エコシステム全体が共に発展していく上で重要であり、この技術革新をどう捉えるかを思い出させることも重要であり、継続的な努力でこの競争の優位性となることも期待されています。