- Rubrique

33126 Popularité

11406 Popularité

5070 Popularité

15799 Popularité

60858 Popularité

30245 Popularité

1775 Popularité

94700 Popularité

26631 Popularité

26776 Popularité

- Épingler

33126 Popularité

11406 Popularité

5070 Popularité

15799 Popularité

60858 Popularité

30245 Popularité

1775 Popularité

94700 Popularité

26631 Popularité

26776 Popularité

Nouveaux développements dans les modèles à gros octets : la première introduction du positionnement visuel pour parvenir à une compréhension conjointe multimodale fine, open source et démo jouable

Source originale : Qubit

Modèle Big Byte, BuboGPT est là.

Prend en charge trois modes de texte, d'image et d'audio pour obtenir une compréhension conjointe multimodale fine.

Où répondre et quoi dire, ce qui est dit et ce qui n'est pas dit, c'est clair en un coup d'œil :

Audio-1-chime-bird-breeze, qubit, 20 secondes

Compréhension conjointe trimodale, description du texte + positionnement de l'image + positionnement du son, un clic pour l'obtenir et déterminer avec précision la source du son :

Audio-7-dork-bark, qubit, 6 secondes

Même s'il n'y a pas de relation directe entre le son et les images, la relation possible entre les deux peut être raisonnablement décrite. Il est également possible de raconter des histoires en regardant des images et en identifiant des sons :

Audio-11-six-heures, qubit, 1 minute

Selon les chercheurs :

Par conséquent, lorsque BuboGPT décrit l'image, il peut indiquer l'emplacement spécifique de l'objet dans l'image.

BuboGPT : introduction de la connectivité visuelle à LLM pour la première fois

En plus des exemples ci-dessus partagés par l'auteur sur YouTube, l'équipe de recherche a également démontré diverses astuces jouées par BuboGPT dans l'article.

Longtemps pour voir une grenouille jouer du piano ! Un tel graphique BuboGPT peut-il également décrire avec précision?

Demandez-lui quels sont les endroits intéressants de l'image, et il peut également tout résumer en arrière-plan de l'image.

BuboGPT "test de la vue + de l'ouïe + de l'expressivité", les chercheurs le jouent comme ça, écoutons d'abord cet audio.

Audio-9-sèche-cheveux, qubit, 5 secondes

Jetons un coup d'œil à la description de BuboGPT :

L'effet est si bon parce que Byte a utilisé cette fois la méthode d'introduction du positionnement visuel dans LLM.

La méthode spécifique que nous regardons ensuite vers le bas.

L'architecture de BuboGPT consiste à parvenir à une compréhension multimodale en apprenant un espace sémantique partagé et en explorant davantage les relations fines entre différents objets visuels et différentes modalités.

Afin d'explorer la relation fine entre différents objets visuels et diverses modalités, les chercheurs ont d'abord construit un pipeline de localisation visuelle prêt à l'emploi basé sur SAM.

Ce pipeline se compose de trois modules : Tagging Module (Tagging Module), Location Module (Grounding Module) et Entity-matching Module (Entity-matching Module).

Premièrement, le module d'étiquetage est un modèle pré-entraîné qui peut générer plusieurs étiquettes de texte associées à une image d'entrée.

Le module de localisation basé sur SAM localise en outre le masque sémantique ou le cadre de délimitation associé à chaque étiquette de texte sur l'image.

Ensuite, le module de correspondance d'entités utilise la capacité de raisonnement de LLM pour récupérer les entités correspondantes à partir des étiquettes et des descriptions d'images.

C'est ainsi que les chercheurs utilisent le langage comme un pont pour connecter des objets visuels à d'autres modalités.

Afin de permettre à toute combinaison des trois entrées modales d'avoir de bons résultats, les chercheurs ont adopté un programme d'entraînement en deux étapes similaire au Mini-GTP4 :

Pré-formation monomodale et ajustement des instructions multimodales.

Dans la phase de pré-formation unimodale, les couches Q-Former et projection linéaire de modalité correspondantes sont formées sur une grande quantité de données appariées modalité-texte.

Pour la perception visuelle, nous formons uniquement la couche de projection pour la partie de génération de légendes d'image et gardons le Q-Former de BLIP2 fixe.

Pour la compréhension audio, ils ont formé à la fois Q-Former et les parties de génération de sous-titres audio.

Dans les deux paramètres, sans utiliser d'indices ( ), le modèle reçoit simplement l'image ou l'audio correspondant en entrée et prédit la légende correspondante (légende).

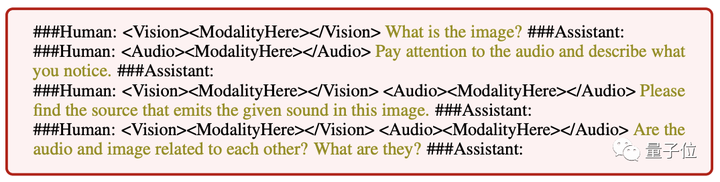

** **###### △ Différentes instructions d'entrée suivent l'exemple

**###### △ Différentes instructions d'entrée suivent l'exemple

Dans l'étape d'ajustement des instructions multimodales, un ensemble de données d'instructions multimodales de haute qualité est construit pour affiner la couche de projection linéaire, notamment :

Il convient de noter qu'en introduisant des échantillons négatifs "paires image-audio" pour la correspondance sémantique, BuboGPT peut être mieux aligné et la capacité de compréhension conjointe multimodale est plus forte.

À l'heure actuelle, le code et l'ensemble de données BuboGPT sont en open source, et la démo a également été publiée. Essayons-la rapidement.

Expérience de jeu superficielle de démonstration

La zone de fonction de la page de démonstration BuboGPT est claire en un coup d'œil et l'opération est également très simple.Vous pouvez télécharger des images ou de l'audio sur le côté droit, et la fenêtre de réponse BuboGPT et la fenêtre de question de l'utilisateur sur le côté gauche :

Voici une autre image, avec un morceau d'audio, et BuboGPT correspond également correctement à la source sonore :

Audio-8-bicycle_bell, qubit, 22 secondes

Portail: [1] [2]