出典:シン・ジユアン本日、Metaは、人を見つけて部屋を掃除するのを手伝うことを学んだ、それによって訓練されたAIエージェントであるHabitat3.0をリリースしました。 ソーシャルボット、次のマイルストーン!今日から、人間は家事を手伝うロボットに一歩近づいています! Metaは、ソーシャルAIエージェントの開発を目的としてHabitat 3.0を発表しました。 これらの具体化された知能の背後にある鍵は、もちろんAIエージェントです。 それらを使用すると、ロボットは人間と協力し、日常のタスクを完了するのに役立ちます。 論文住所:プロジェクトアドレス:実際、Metaは本日、3つの主要な開発を同時に発表しました-**1. Habitat 3.0は、多様で現実的な屋内環境での人間と機械の相互作用タスクに関する大規模なトレーニングをサポートする最初のシミュレーターです。 **ロボットとヒューマノイドアバターの両方をサポートし、部屋の掃除を手伝うなど、人間とロボットが家庭環境で協力できるようにします。 **2. ハビタット合成シーンデータセット(HSSD-200)は、アーティストによって作成された3次元データセットで、211のシーンの466の意味カテゴリに18,000を超えるオブジェクトが含まれています。 **HSSD-200は、同様のデータセットで最高の品質を持ち、ナビゲーションエージェントを訓練することができ、物理世界の3次元再構成シーンに非常に優れた汎化効果があり、使用されるシーンの数は2桁少ないです。 **3. HomeRobotは、ホームロボットアシスタント向けの非常に手頃なハードウェアおよびソフトウェアプラットフォームであり、ロボットがシミュレートされた物理環境で自由形式の語彙タスクを実行できるようにします。 **大規模な学習では、Habitat 3.0 は 1 つの GPU で毎秒 1,000 ステップ以上を完了できます。 ## **ネチズン:家事ができるロボットはいつ出てくるのか** ネチズンは言った:これはロボット工学の大きな飛躍です。 ため息をつく人もいます:これは非常に高度なシムズゲームです。 メタクエストVRでハビタット3.0を体験することを楽しみにしている人もいます。 夢、ハウスキーピング支援ロボットは遠く離れてはいけません。 ## **生息地3.0** ハビタット3.0では、メタは人間の外見と姿勢のリアルなシミュレーションを提供するだけではありません。 また、単純なアクション(歩く、手を振るなど)から複雑なアクション(オブジェクトとの対話など)まで、さまざまなタイプのアクションをサポートし、モーションキャプチャと互換性があります。 さらに、アバターはパフォーマンスを低下させることなくプログラムで制御することができ、人間と機械のシミュレーション速度はロボットとロボットのシミュレーション速度とほぼ同じです。 ### ** ループ内の人々**ハビタット3.0のもう一つの重要な特徴は、「ループ内の人間」です。 マウス、キーボード、またはVRを使用すると、驚くべき人間とコンピューターの相互作用制御を実現できます。 タスクが完了すると、システムはロボットの戦略とデータを収集し、人間と機械の相互作用を評価します。### **ソーシャルタスク**さらに、Habitat 3.0 は、現実世界のさまざまなソーシャル シナリオをシミュレートできます。たとえば、ソーシャルナビゲーションと呼ばれるタスクでは、ロボットは安全を保ちながら人間を見つけて追跡する必要があります。 別のタスクでは、ロボットは人間と協力して、部屋を片付けるなどのタスクを完了する必要があります。この時点で、人間とロボットは別々に目標の場所に行く必要があり、ロボットは人間でこの目標を達成する方法をできるだけ効率的に見つける必要があります。 さまざまな社会的行動を実現できる訓練されたロボット!ロボットは、人間と安全な距離を保つだけでなく、必要に応じて後退し、人間が歩く余地を残します。 ## **AI エージェントが現実世界で人間と対話できるようにする** これまで、AIアシスタントについて考えるとき、私たちは通常、Webベースのチャットボット、またはスマートスピーカーを思い浮かべました。メタの研究者は、一般的な知能を備えた具体化されたAIエージェントを実装して、環境を感知し、デジタルおよび物理世界で人間と通信し、支援できるようにすることを望んでいます。ビジョンの1つは、人間が使用するための終日ウェアラブルARヘッドセットを作ることです。さらに、研究者はソーシャルインテリジェントロボットの背後にある技術を改善しており、家事で人間を助け、パートナーの要件に合わせて人間の個別の好みに適応できるようにしています。この作業は、次世代のARおよびVR体験をより良くするための組み込みシステムの詳細な研究に焦点を当てています。 ただし、ロボットやARメガネなど、物理的なハードウェア上で実際の人物を使用して具体化されたAIエージェントをトレーニングおよびテストするには、スケーラビリティの制限があり、セキュリティ上の問題が発生する可能性があります。これには、標準化されたベンチマーク手順の確立が必要です。そのため、Metaの研究者は、シミュレーターとデータセットにわたるロボット研究のための新しいツールセットを開発しました。彼らはまた、研究のこの側面をより簡単かつ手頃な価格にするためのハードウェアとソフトウェアを含むテクノロジースタックを開発しました。ロボットの能力を迅速に向上させるために、研究者はシミュレーターで新しいアルゴリズムとモデルを開発およびテストし、それらを物理的なロボットに移植します。長年にわたり、ハビタットシミュレーターは多くの重要な進歩を遂げてきました。 Habitat 1.0で訓練された仮想ロボットは、毎秒10,000歩(SPS)以上の速度で物理的な世界の家の3Dスキャンをナビゲートできます。Habitat 2.0は、インタラクティブな環境(拾うアイテム、開けることができる引き出しなど)を導入し、アイテムを再配置して家を掃除するように仮想ロボットを訓練します。Habitat 3.0はさらに一歩進んで、ロボットとヒューマノイドアバターの両方をサポートできるため、人間と機械のコラボレーションにより、リビングルームの片付けやキッチンでのレシピの準備などの日常のタスクを完了できます。これにより、多様で現実的、視覚的、意味的に豊富なタスクにおける人間とロボットのコラボレーションを研究するための新しい道が開かれます。さらに、Habitat 3.0は、リアルな外観、自然な歩行、動きを備えたヒューマノイドアバターをサポートしており、リアルな低レベルおよび高レベルの相互作用をシミュレートできます。 これらのアバターは、学習した戦略によって、または「ヒューマンインザループ」インターフェイスを介して実際の人々によって制御できます。このインターフェイスは、キーボード、マウス、および VR ヘッドセットをサポートします。シミュレートされた環境で人間とロボットが共存することで、人間はロボットAI戦略を学び、日常のタスクを完了し、ヒューマノイドアバターの存在下で家族のような環境で初めてそれらを評価することができます。これは間違いなく非常に重要です-1.強化学習アルゴリズムは通常、意味のある知識を学習するために何百万もの反復を必要とするため、物理的な世界でこれらの実験を実施するには何年もかかる場合があります。シミュレーション実験では、数日で実行できます。 2.物理的な世界のさまざまな家でデータを収集することは、ロボットを別の場所に移動し、環境を設定する必要があるため、実用的ではありません。シミュレーションでは、ほんの一瞬で環境を変更し、すぐに新しい環境で実験を開始できます。3.モデルが適切にトレーニングされていない場合、ロボットは環境に損害を与えたり、物理的な世界の人々に害を及ぼす可能性があります。シミュレーターを使用すると、研究者は物理的な世界に展開する前に安全な環境でメソッドをテストできるため、セキュリティが保証されます。4.今日の最先端のAIモデルは、トレーニングに大量のデータを必要とし、シミュレーションにより、研究者はデータ収集を簡単にスケールアップできます。物理的な世界では、データ収集は非常に高価で時間がかかる可能性があります。 さらに、研究者は、社会的に具体化されたAIの分野でベンチマークを確立するために、2つの非常に関連性の高いタスクと一連のベンチマークを提案します。最初のタスクは「ソーシャル片付け」で、ロボットとヒューマノイドアバターが協力して、家の掃除などの一連のピックアンドプレースタスクを実行します。このタスクでは、ロボットと人間が協力して共通の目標を達成する必要があります。 このインテリジェントな動作は、大規模なシミュレーション トレーニングの後に発生します。2つ目は、ロボットが安全な距離を保ちながら人の位置を特定して追跡できるようにする「ソーシャルナビゲーション」です。 ## **生息地合成シーンデータセット** 3Dシーンデータセットは、シミュレートされた環境でロボットをトレーニングするために不可欠です。現在、トレーニング データのスケーリングをサポートするデータセットは多数ありますが、データセットのサイズと信頼性のトレードオフは理解されていません。この目的のために、Metaは新しい合成3DシーンデータセットHSSD-200を立ち上げました。これは、466の意味カテゴリからの物理世界のオブジェクトの18,656のモデルを含む、実際の屋内環境を表す211の高品質の3Dシーンで構成されています。 以前のデータセットよりも実際の物理学に近い。 具体的には、HSSD-200は、より高品質で完全に人工的に作成された3Dインテリアシーンを提供し、WordNetオントロジーに対応するきめ細かいセマンティック分類を含みます。また、HSSD-200のアセット圧縮機能により、高性能なAIシミュレーションが可能です。 シーンに関しては、HSSD-200はフロアプランナーのインテリアデザインインターフェイスを使用して作成されており、レイアウトは主に実際の家を再現しています。その中で、個々のオブジェクトはプロの3Dアーティストによって作成され、ほとんどの場合、実際の家具や電化製品と一致します。 実験によると、より小さくて高品質のHSSD-200データセットは、オブジェクトをナビゲーションターゲットとしてオブジェクトNavエージェントを生成でき、そのパフォーマンスはより大きなデータセットでトレーニングされたエージェントのパフォーマンスに匹敵します。さらに、HSSD-200でエージェントをトレーニングするために必要なシナリオの数は2桁少なくなります-10,000のProcTHORシナリオでトレーニングされたエージェントと比較して、122のHSSD-200シナリオでトレーニングされたエージェントは、HM3DSemの物理世界のシナリオにより一般化されます。 ## **ホームロボット** 共通の共有プラットフォームは機械学習の進歩の重要な部分ですが、ロボット工学では、ハードウェアの成果を再現して拡張するのが難しいため、同様のプラットフォームが不足しています。この点に関して、Metaは再現可能なロボット研究プラットフォームの3つの目標を提案しています。**- 感動的な北極星:**プラットフォームは、研究者をやる気にさせ、彼らの仕事を支援するために、ガイド付きのノーススターミッションを提供する必要があります。 その中で、彼らはまた、興味深い現実世界の問題に関するさまざまな方法を比較することができます。たとえば、「オープンワード移動操作(OVMM)」–未知の環境でオブジェクトをピックアップし、指定された場所に配置します。 これには、非常に強力な長期知覚とシーンの理解が必要であり、幅広いタスクに役立ちます。 **- ソフトウェア機能:**プラットフォームは、ナビゲーションや操作などのさまざまなタスクでロボットを使いやすくするために、抽象化インターフェイスを提供する必要があります。**-コミュニティ:**プラットフォームは、開発者が参加して、コードベースを中心にコミュニティを構築しようとすることを奨励する必要があります。この分野の研究を進めるために、MetaはHello Robot Stretchのナビゲーションおよび操作機能のサポートを可能にする新しいHomeRobotライブラリを立ち上げました。 プロジェクトアドレス:具体的には、HomeRobotには2つのコンポーネントがあります。1.シミュレーションコンポーネント:新しい高品質のマルチルームホーム環境で大規模で多様なオブジェクトのセットを使用する。2.物理世界のコンポーネント:低コストのHello Robot StretchおよびBoston Dynamics製品のソフトウェアスタックを提供し、ラボ間での物理世界の実験の複製を促進します。 さらに、HomeRobotは非常に使いやすいソフトウェアスタックを提供するため、ユーザーはロボットをすばやくセットアップしてすぐにテストできます。 機能が含まれます:**-ポータビリティ:**各タスクのシミュレーションと物理ワールドの設定の間には統一された状態とアクション空間があり、高レベルのモーション空間(プリセットグリップ戦略など)または低レベルの連続関節制御を使用してロボットを簡単に操作できます。**-モジュール:**知覚とアクションのコンポーネントは、高レベルの状態(例えば、セマンティックマップ、セグメント化された点群)と高レベルのアクション(例えば、ターゲットの場所に行く、ターゲットオブジェクトを拾う)をサポートします。**- ベース エージェント:**これらの機能を使用して OVMM の基本機能を提供する戦略や、より複雑なエージェントを構築するためのツールは、他のチームが開発できます。 HomeRobot OVMMベンチマークでは、エージェントは家庭環境でノベルティアイテムを取得し、ターゲットコンテナ内またはターゲットコンテナ内に配置できます。その中で、Metaは強化学習とヒューリスティック(モデルベース)ベースラインを使用して、ナビゲーションと配置のスキルをシミュレーションから物理世界に移行できることを示しています。 結果は、ベースラインが物理的な世界で20%の成功率を達成できることを示しています。リソース:

メタ重アップデート、シャオザはメタバースで家事ができる犬を飼っています! ヒューマノイドアバターは非常にリアルで、AIエージェントは現実の物理世界で人々と対話します

出典:シン・ジユアン

本日、Metaは、人を見つけて部屋を掃除するのを手伝うことを学んだ、それによって訓練されたAIエージェントであるHabitat3.0をリリースしました。 ソーシャルボット、次のマイルストーン!

今日から、人間は家事を手伝うロボットに一歩近づいています!

プロジェクトアドレス:

実際、Metaは本日、3つの主要な開発を同時に発表しました-

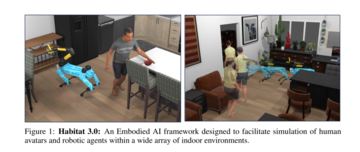

**1. Habitat 3.0は、多様で現実的な屋内環境での人間と機械の相互作用タスクに関する大規模なトレーニングをサポートする最初のシミュレーターです。 **

ロボットとヒューマノイドアバターの両方をサポートし、部屋の掃除を手伝うなど、人間とロボットが家庭環境で協力できるようにします。

HSSD-200は、同様のデータセットで最高の品質を持ち、ナビゲーションエージェントを訓練することができ、物理世界の3次元再構成シーンに非常に優れた汎化効果があり、使用されるシーンの数は2桁少ないです。

大規模な学習では、Habitat 3.0 は 1 つの GPU で毎秒 1,000 ステップ以上を完了できます。

ネチズン:家事ができるロボットはいつ出てくるのか

ネチズンは言った:これはロボット工学の大きな飛躍です。

生息地3.0

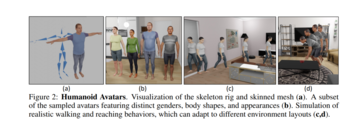

ハビタット3.0では、メタは人間の外見と姿勢のリアルなシミュレーションを提供するだけではありません。

ハビタット3.0のもう一つの重要な特徴は、「ループ内の人間」です。

ソーシャルタスク

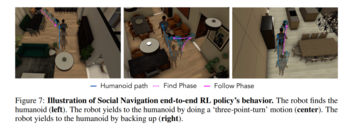

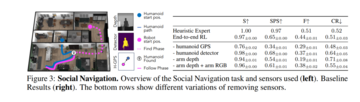

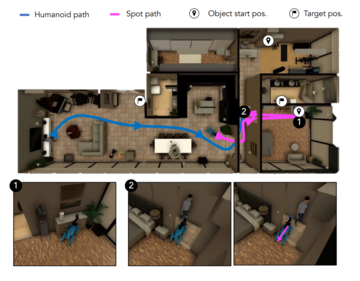

さらに、Habitat 3.0 は、現実世界のさまざまなソーシャル シナリオをシミュレートできます。

たとえば、ソーシャルナビゲーションと呼ばれるタスクでは、ロボットは安全を保ちながら人間を見つけて追跡する必要があります。

この時点で、人間とロボットは別々に目標の場所に行く必要があり、ロボットは人間でこの目標を達成する方法をできるだけ効率的に見つける必要があります。

ロボットは、人間と安全な距離を保つだけでなく、必要に応じて後退し、人間が歩く余地を残します。

AI エージェントが現実世界で人間と対話できるようにする

これまで、AIアシスタントについて考えるとき、私たちは通常、Webベースのチャットボット、またはスマートスピーカーを思い浮かべました。

メタの研究者は、一般的な知能を備えた具体化されたAIエージェントを実装して、環境を感知し、デジタルおよび物理世界で人間と通信し、支援できるようにすることを望んでいます。

ビジョンの1つは、人間が使用するための終日ウェアラブルARヘッドセットを作ることです。

さらに、研究者はソーシャルインテリジェントロボットの背後にある技術を改善しており、家事で人間を助け、パートナーの要件に合わせて人間の個別の好みに適応できるようにしています。

この作業は、次世代のARおよびVR体験をより良くするための組み込みシステムの詳細な研究に焦点を当てています。

これには、標準化されたベンチマーク手順の確立が必要です。

そのため、Metaの研究者は、シミュレーターとデータセットにわたるロボット研究のための新しいツールセットを開発しました。

彼らはまた、研究のこの側面をより簡単かつ手頃な価格にするためのハードウェアとソフトウェアを含むテクノロジースタックを開発しました。

ロボットの能力を迅速に向上させるために、研究者はシミュレーターで新しいアルゴリズムとモデルを開発およびテストし、それらを物理的なロボットに移植します。

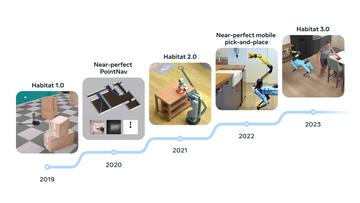

長年にわたり、ハビタットシミュレーターは多くの重要な進歩を遂げてきました。

Habitat 2.0は、インタラクティブな環境(拾うアイテム、開けることができる引き出しなど)を導入し、アイテムを再配置して家を掃除するように仮想ロボットを訓練します。

Habitat 3.0はさらに一歩進んで、ロボットとヒューマノイドアバターの両方をサポートできるため、人間と機械のコラボレーションにより、リビングルームの片付けやキッチンでのレシピの準備などの日常のタスクを完了できます。

これにより、多様で現実的、視覚的、意味的に豊富なタスクにおける人間とロボットのコラボレーションを研究するための新しい道が開かれます。

さらに、Habitat 3.0は、リアルな外観、自然な歩行、動きを備えたヒューマノイドアバターをサポートしており、リアルな低レベルおよび高レベルの相互作用をシミュレートできます。

このインターフェイスは、キーボード、マウス、および VR ヘッドセットをサポートします。

シミュレートされた環境で人間とロボットが共存することで、人間はロボットAI戦略を学び、日常のタスクを完了し、ヒューマノイドアバターの存在下で家族のような環境で初めてそれらを評価することができます。

これは間違いなく非常に重要です-

1.強化学習アルゴリズムは通常、意味のある知識を学習するために何百万もの反復を必要とするため、物理的な世界でこれらの実験を実施するには何年もかかる場合があります。

シミュレーション実験では、数日で実行できます。

シミュレーションでは、ほんの一瞬で環境を変更し、すぐに新しい環境で実験を開始できます。

3.モデルが適切にトレーニングされていない場合、ロボットは環境に損害を与えたり、物理的な世界の人々に害を及ぼす可能性があります。

シミュレーターを使用すると、研究者は物理的な世界に展開する前に安全な環境でメソッドをテストできるため、セキュリティが保証されます。

4.今日の最先端のAIモデルは、トレーニングに大量のデータを必要とし、シミュレーションにより、研究者はデータ収集を簡単にスケールアップできます。

物理的な世界では、データ収集は非常に高価で時間がかかる可能性があります。

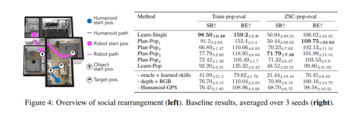

最初のタスクは「ソーシャル片付け」で、ロボットとヒューマノイドアバターが協力して、家の掃除などの一連のピックアンドプレースタスクを実行します。

このタスクでは、ロボットと人間が協力して共通の目標を達成する必要があります。 このインテリジェントな動作は、大規模なシミュレーション トレーニングの後に発生します。

2つ目は、ロボットが安全な距離を保ちながら人の位置を特定して追跡できるようにする「ソーシャルナビゲーション」です。

生息地合成シーンデータセット

3Dシーンデータセットは、シミュレートされた環境でロボットをトレーニングするために不可欠です。

現在、トレーニング データのスケーリングをサポートするデータセットは多数ありますが、データセットのサイズと信頼性のトレードオフは理解されていません。

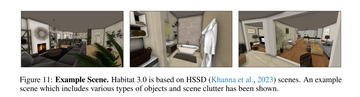

この目的のために、Metaは新しい合成3DシーンデータセットHSSD-200を立ち上げました。

これは、466の意味カテゴリからの物理世界のオブジェクトの18,656のモデルを含む、実際の屋内環境を表す211の高品質の3Dシーンで構成されています。 以前のデータセットよりも実際の物理学に近い。

また、HSSD-200のアセット圧縮機能により、高性能なAIシミュレーションが可能です。

その中で、個々のオブジェクトはプロの3Dアーティストによって作成され、ほとんどの場合、実際の家具や電化製品と一致します。

さらに、HSSD-200でエージェントをトレーニングするために必要なシナリオの数は2桁少なくなります-

10,000のProcTHORシナリオでトレーニングされたエージェントと比較して、122のHSSD-200シナリオでトレーニングされたエージェントは、HM3DSemの物理世界のシナリオにより一般化されます。

ホームロボット

共通の共有プラットフォームは機械学習の進歩の重要な部分ですが、ロボット工学では、ハードウェアの成果を再現して拡張するのが難しいため、同様のプラットフォームが不足しています。

この点に関して、Metaは再現可能なロボット研究プラットフォームの3つの目標を提案しています。

- 感動的な北極星:

プラットフォームは、研究者をやる気にさせ、彼らの仕事を支援するために、ガイド付きのノーススターミッションを提供する必要があります。 その中で、彼らはまた、興味深い現実世界の問題に関するさまざまな方法を比較することができます。

たとえば、「オープンワード移動操作(OVMM)」–未知の環境でオブジェクトをピックアップし、指定された場所に配置します。 これには、非常に強力な長期知覚とシーンの理解が必要であり、幅広いタスクに役立ちます。

プラットフォームは、ナビゲーションや操作などのさまざまなタスクでロボットを使いやすくするために、抽象化インターフェイスを提供する必要があります。

-コミュニティ:

プラットフォームは、開発者が参加して、コードベースを中心にコミュニティを構築しようとすることを奨励する必要があります。

この分野の研究を進めるために、MetaはHello Robot Stretchのナビゲーションおよび操作機能のサポートを可能にする新しいHomeRobotライブラリを立ち上げました。

具体的には、HomeRobotには2つのコンポーネントがあります。

1.シミュレーションコンポーネント:新しい高品質のマルチルームホーム環境で大規模で多様なオブジェクトのセットを使用する。

2.物理世界のコンポーネント:低コストのHello Robot StretchおよびBoston Dynamics製品のソフトウェアスタックを提供し、ラボ間での物理世界の実験の複製を促進します。

-ポータビリティ:

各タスクのシミュレーションと物理ワールドの設定の間には統一された状態とアクション空間があり、高レベルのモーション空間(プリセットグリップ戦略など)または低レベルの連続関節制御を使用してロボットを簡単に操作できます。

-モジュール:

知覚とアクションのコンポーネントは、高レベルの状態(例えば、セマンティックマップ、セグメント化された点群)と高レベルのアクション(例えば、ターゲットの場所に行く、ターゲットオブジェクトを拾う)をサポートします。

- ベース エージェント:

これらの機能を使用して OVMM の基本機能を提供する戦略や、より複雑なエージェントを構築するためのツールは、他のチームが開発できます。

その中で、Metaは強化学習とヒューリスティック(モデルベース)ベースラインを使用して、ナビゲーションと配置のスキルをシミュレーションから物理世界に移行できることを示しています。 結果は、ベースラインが物理的な世界で20%の成功率を達成できることを示しています。

リソース: