Esta onda de desenvolvimento da IA espalhou a sua influência a vários campos tão rapidamente que excedeu de facto as expectativas da maioria das pessoas. Na semana passada, a Sequoia (Sequoia America) acreditou que a IA abriu seu segundo capítulo e desenhou um novo mapa de IA e um mapa de pilha (pilha) de desenvolvedor LLM a partir da perspectiva dos cenários de aplicação.

No entanto, a julgar pela direção dos fundos, o atual desenvolvimento da IA parece ainda estar na fase de luta entre deuses, e esse padrão parece quase ter tomado forma. Depois que a OpenAI recebeu quase 11 bilhões de dólares americanos da Microsoft e outros e foi avaliada em quase 29 bilhões de dólares americanos, seu concorrente Anthropic anunciou ontem uma aliança com a Amazon. A Amazon investirá até 4 bilhões de dólares americanos nela, tornando a Anthropic atrás apenas da OpenAI em termos de financiamento de startups de IA.

Após esse financiamento, com exceção da Apple, a indústria de IA basicamente formou esse padrão de luta contra os deuses:

*Microsoft + OpenAI

Google + DeepMind

Meta + MetaAI

Amazônia + Antrópico

*Tesla + xAI

É claro que, como fornecedora de infraestrutura de nível inferior, a estratégia da Nvidia é obviamente que todos desejam isso, e não há uma postura muito séria em relação a nenhuma empresa específica. A seguir está uma situação geral dos 15 unicórnios de IA. Do ponto de vista da avaliação e do financiamento, os grandes modelos LLM representam uma grande parte, e 50% dos unicórnios de IA foram estabelecidos após 2021:

Hoje, a16z compartilhou suas conversas com fundadores de várias empresas importantes de IA, acreditando que estamos na terceira era da computação, e discutiu 16 tópicos interessantes da perspectiva do presente, do futuro e da abertura da IA. Os participantes desta conversa incluem:

Sócio a16z Martin Casado

CTO da OpenAI, Mira Murati

Cofundador e CEO da Roblox, David Baszucki

Cofundador e CEO da Figma, Dylan Field

Cofundador e CEO da Anthropic, Dario Amodei

CTO da Microsoft e vice-presidente executivo de IA, Kevin Scott

introdução Fundadora e CEO Daphne Koller

Cofundador e CEO da Databricks, Ali Ghodsi

Cofundador e CEO da Character.AI, Noam Shazeer

Como o artigo é muito longo, quase 10.000 palavras, usei IA para compilá-lo brevemente. Alguns termos podem não ser precisos. Amigos interessados podem ler o texto original em inglês:

1 Estamos no início da terceira era da computação

Martin Casado,a16z:

Eu realmente acho que podemos estar entrando na terceira era da computação. Os microchips reduziram o custo marginal da computação a zero, a Internet reduziu o custo marginal da distribuição a zero e agora os grandes modelos reduziram, na verdade, o custo marginal da criação a zero. Quando as eras anteriores aconteceram, você não tinha ideia de quais novas empresas seriam criadas. Ninguém previu a Amazon, ninguém previu o Yahoo. Devemos nos preparar para uma nova onda de empresas icônicas. Noam Shazeer, IA de personagem:

Estamos realmente no momento do “primeiro avião dos irmãos Wright”. Já temos algo que funciona e agora é útil para um grande número de cenários de aplicação. Parece que escala muito bem e ficará ainda melhor. Mas ainda há mais avanços por vir, porque agora todos os cientistas de IA do mundo estão trabalhando duro para melhorar essas coisas. Kevin Scott,Microsoft:

Principalmente nos últimos anos, e talvez principalmente nos últimos 12 meses, com o lançamento do ChatGPT e GPT-4, você pode realmente ver o potencial desta plataforma para ser igual a um PC ou smartphone. Uma série de tecnologias tornará possível uma série de coisas novas, e muitas pessoas construirão coisas em cima dessas coisas novas. ## 2 Esta onda de inteligência artificial generativa possui princípios econômicos que promovem a transformação do mercado.

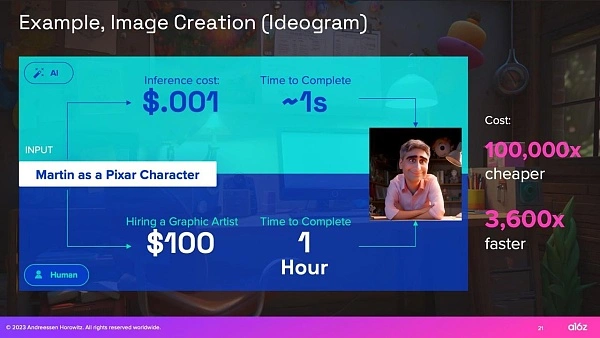

Para que a inovação tecnológica desencadeie a transformação do mercado, os benefícios económicos devem ser altamente atrativos. Embora tenha havido muitos avanços tecnológicos em ciclos anteriores de IA, faltaram-lhes benefícios económicos transformadores. Na onda atual da IA, já estamos vendo os primeiros sinais de melhorias econômicas de 10.000 vezes (ou mais) em alguns casos de uso, e a adoção e o desenvolvimento resultantes da IA parecem ser muito mais rápidos do que qualquer mudança anterior.

Martin Casado,a16z:

A transformação do mercado não ocorre através de uma melhoria económica dez vezes maior. Eles são criados quando são dez mil vezes melhores do que antes. Digamos que eu queira criar uma imagem que me transforme em um personagem da Pixar. Se eu usar um desses modelos de imagem, o custo de inferência será de um décimo de centavo e digamos que demore 1 segundo. Se compararmos com a contratação de um artista gráfico, vamos supor que a taxa horária seja de US$ 100. Em termos de custo e tempo, você verá uma enorme diferença de 4 a 5 ordens de grandeza. Para os economistas, este é o tipo de ponto de viragem que procuram, quando na verdade há uma enorme deslocação do mercado.

Se você quiser um exemplo de como isso pode ser louco, não vejo razão para que você não consiga gerar um jogo completo - modelos 3D, personagens, sons, música, história, etc. As startups estão a fazer todas estas coisas agora, e se compararmos o custo de centenas de milhões de dólares e anos com o custo de alguns dólares, temos agora uma assimetria na economia ao nível da Internet e dos microchips.

3 Para alguns cenários de aplicação iniciais: Criatividade > Correção

As alucinações são um problema bem conhecido nos LLMs de grandes modelos atuais, mas para algumas aplicações a capacidade de inventar coisas é um recurso e não um bug. Em comparação com os primeiros casos de uso de aprendizado de máquina aplicado, onde a correção de nível n é crítica (por exemplo, carros autônomos), muitos dos primeiros casos de uso para LLMs (amigos e companheiros virtuais, conceitos de brainstorming ou construção de jogos online) são caracterizados por: foco Em áreas onde a criatividade é mais importante que a correção.

Noam Shazeer, Personagem.AI:

O entretenimento é uma indústria que movimenta US$ 2 trilhões anualmente. E o segredo obscuro é que o entretenimento é como amigos virtuais inexistentes. Este é um primeiro caso de uso interessante para inteligência artificial geral. Se você quisesse lançar um médico, por exemplo, seria muito mais lento porque você precisa ter muito, muito, muito cuidado para não dar informações erradas. Mas com amigos você pode fazer isso muito rapidamente, é muito divertido e inventar coisas se torna um recurso. David Baszucki,Roblox:

Dos 65 milhões de usuários do Roblox, a maioria não está criando no nível que gostaria. Por muito tempo imaginamos um jogo de simulação do Project Runway onde você poderia usar uma máquina de costura e tecido e ter tudo simulado em 3D, mas mesmo isso era um pouco complicado para a maioria de nós. Acho que agora, quando o Project Runway for lançado no Roblox, será um prompt de texto, um prompt de imagem ou um prompt de voz. Se eu estivesse te ajudando a fazer essa camisa, eu diria: quero uma camisa jeans azul, com alguns botões e um corte mais justo. Na verdade, acho que veremos uma aceleração na criação. Dylan Campo, Figma:

No momento, estamos em um estágio em que é possível para a IA concluir um primeiro rascunho, mas passar disso até o produto final ainda é um tanto difícil e muitas vezes requer uma equipe para fazer isso. Mas se você conseguir que a IA sugira elementos de interface para as pessoas e faça isso de uma maneira que realmente faça sentido, acho que isso abrirá uma nova era de design, criando designs contextuais que respondam à intenção do usuário. Acredito que esta será uma era fascinante para todos os designers trabalharem em colaboração com estes sistemas de inteligência artificial. ## 4 Para outros exemplos, a precisão da programação do "co-piloto" melhorará com o uso humano.

Embora a IA tenha o potencial de aumentar o trabalho humano em muitas áreas, a programação de “copilotos” tornou-se o primeiro assistente de IA amplamente adotado por vários motivos:

Primeiro, os desenvolvedores costumam ser os primeiros a adotar novas tecnologias – uma análise das dicas do ChatGPT em maio/junho de 2023 descobriu que 30% das dicas do ChatGPT estavam relacionadas à programação. Em segundo lugar, os maiores LLMs são treinados em conjuntos de dados com muitos códigos (como a Internet), o que os torna particularmente bons em responder a consultas relacionadas à programação. Finalmente, as pessoas envolvidas são os usuários. Portanto, embora a precisão seja importante, um desenvolvedor humano com um copiloto de IA pode iterar até a correção mais rapidamente do que um desenvolvedor humano sozinho.

Martin Casado,a16z:

Se você precisar acertar e houver muitos casos de uso complexos, faça todo o trabalho técnico sozinho ou contrate pessoas. Normalmente contratamos pessoas. Este é um custo variável. Em segundo lugar, porque a cauda das soluções é muitas vezes muito longa – como as muitas anomalias que podem ocorrer na condução autónoma – o investimento necessário para se manter à frente aumenta e o valor diminui. Isso cria um efeito reverso de economia de escala.

Aquele ser humano no circuito que costumava estar em uma empresa central agora é o usuário, portanto não é mais um custo variável para o negócio e para a economia do custo do trabalho. A pessoa no loop foi removida, para que você possa fazer coisas onde a correção é importante, como desenvolver código, e por ser iterativo, a quantidade de bugs acumulados é reduzida porque você recebe constantemente feedback e correções dos usuários. Quando os desenvolvedores podem consultar um chatbot de IA para ajudá-los a escrever e solucionar problemas de código, isso muda a maneira como o desenvolvimento é feito de duas maneiras significativas: 1) Torna o desenvolvimento mais fácil para mais pessoas Colaboração porque acontece por meio de uma interface de linguagem natural, 2) Desenvolvedores humanos produzir mais produtos e mantê-los fluindo por mais tempo.

Mira Murati,OpenAI:

A programação se torna cada vez menos abstrata. Na verdade, podemos conversar com computadores de alta largura de banda em linguagem natural. Estamos usando a tecnologia e a tecnologia está nos ajudando a entender como trabalhar com ela, em vez de “programá-la”. Kevin Scott,Microsoft:

GitHub é o primeiro exemplo deste modelo copiloto que estamos tentando construir, que é: como você pega o trabalho de conhecimento que alguém está fazendo e usa IA para ajudá-lo a ser significativamente mais produtivo na realização de tipos específicos de trabalho cognitivo ? O melhor de tudo é que, com base no que observamos com os desenvolvedores, a IA os ajuda a permanecer em um estado de fluxo por mais tempo do que permaneceriam de outra forma.

Não fique paralisado ao escrever um pedaço de código e pensar: "Não sei como fazer a próxima coisa. Tenho que procurar a documentação. Tenho que perguntar a outro engenheiro que possa estar trabalhando em alguma coisa." "Ser capaz de se libertar do fluxo antes de sair do estado de fluxo é extremamente valioso. Para aqueles que estão considerando a utilidade de ferramentas generativas de IA construídas para outros fins que não o desenvolvimento de software, esse conceito de estados de fluxo é algo útil a se considerar. Campo Dylan, Figma:

Os melhores designers começam a pensar mais em código e os melhores desenvolvedores começam a pensar mais em design. Além dos designers e desenvolvedores, por exemplo, se você pensar no pessoal de produto, eles podem ter trabalhado em especificações antes, mas agora estão trabalhando mais em maquetes para comunicar suas ideias de maneira mais eficaz. Basicamente, isso permitirá que qualquer pessoa na organização passe da ideia ao design e, possivelmente, até à produção, com mais rapidez. Mas você ainda precisa aprimorar cada passo. Você precisa de alguém que realmente pense: "Ok, que ideias vamos explorar? Como vamos explorá-las? "Você vai querer ajustar os designs, vai querer lidar com eles corretamente, desde o primeiro rascunho até o produto final. ## 5 Combinar IA e biologia poderia acelerar novas formas de tratar doenças e ter um impacto profundo na saúde humana

A biologia é incrivelmente complexa – talvez até além da capacidade de compreensão plena da mente humana. No entanto, a intersecção da IA e da biologia poderia acelerar a nossa compreensão da biologia e levar a alguns dos avanços tecnológicos mais emocionantes e transformadores do nosso tempo. As plataformas biológicas baseadas em IA têm o potencial de desbloquear conhecimentos biológicos anteriormente desconhecidos, levando a novas descobertas médicas, novos métodos de diagnóstico e à capacidade de detectar e tratar doenças mais cedo, potencialmente até prevenindo-as antes que ocorram.

Daphne Koller, introdução:

Em determinados momentos da nossa história, certas disciplinas científicas fizeram progressos incríveis num período de tempo relativamente curto. Na década de 1950, a disciplina era a computação, e usávamos essas máquinas para realizar cálculos que, até então, apenas humanos conseguiam realizar. Depois, na década de 1990, houve esta divergência interessante. Por um lado, a ciência de dados e as estatísticas trouxeram-nos, em última análise, a aprendizagem automática moderna e a inteligência artificial. O outro lado é o que considero biologia quantitativa, que é a primeira vez que começamos a medir a biologia em uma escala além do rastreamento de 3 genes em um experimento que durou 5 anos.

Agora, 2020 é a última vez que as duas disciplinas convergiram verdadeiramente, trazendo-nos a era da biologia digital, a capacidade de medir a biologia com fidelidade e escala sem precedentes; interpretando o incompreensível usando ferramentas de aprendizagem automática e ciência de dados. escalas biológicas e diferentes sistemas; e depois usar ferramentas como a edição do genoma CRISPR para trazer esse entendimento de volta à biologia da engenharia, para que possamos fazer com que a biologia faça coisas que não deveria fazer.

Agora, podemos finalmente medir a biologia em escala, nos níveis celular (e às vezes subcelular) e do organismo. Isto permite-nos, pela primeira vez, implementar a aprendizagem automática de uma forma verdadeiramente significativa.

Construímos um modelo de linguagem biológica. É como GPT, mas para células. Temos a linguagem das células e a aparência das células. Você mede centenas de milhões de células em diferentes estados e, então, como um grande modelo de linguagem para linguagem natural, com uma pequena quantidade de dados, pode começar a perguntar: "Ok, como é que uma doença move um gene causador de doença de um estado para outro? lugar para outro?" ?Como o tratamento leva você de um estado de doença de volta a um estado de saúde? "Isso é superpoderoso. Tal como acontece com outros modelos de linguagem, quanto mais dados você alimenta, melhor fica. ## 6 Colocar o modelo nas mãos dos usuários nos ajudará a descobrir novos cenários de aplicação

Embora as iterações anteriores de modelos de IA visassem superar os humanos em determinadas tarefas, os LLMs baseados em Transformer se destacam no raciocínio geral. Mas só porque criamos um bom modelo geral não significa que descobrimos como aplicá-lo a um caso de uso específico. Assim como trazer os seres humanos para o circuito na forma de RLHF é fundamental para melhorar o desempenho dos modelos de IA atuais, colocar novas tecnologias nas mãos dos usuários e entender como eles as utilizam será fundamental para determinar quais aplicativos construir com base nessas tecnologias subjacentes. modelos. topo.

Kevin Scott,Microsoft:

Devemos lembrar: o modelo não é o produto. Como empreendedor, seu entendimento é: Quem são seus usuários? Qual é o problema deles? O que você pode fazer para ajudá-los? Em seguida, determine se a IA é de fato uma infraestrutura útil para resolver os problemas dos usuários – isso é uma constante. A inteligência artificial é como uma infraestrutura nova e interessante que permite resolver novas classes de problemas ou resolver classes antigas de problemas de maneiras melhores. Mira Murati,OpenAI:

Não sabemos exatamente como será o futuro, por isso estamos tentando disponibilizar essas ferramentas e técnicas para muitas outras pessoas para que possam experimentar e ver o que acontece. Essa é uma estratégia que usamos desde o início. Na semana anterior ao lançamento do ChatGPT, estávamos preocupados que não fosse bom o suficiente. Todos nós já vimos o que acontece: divulgamos e depois as pessoas nos dizem que é bom o suficiente para descobrir novos casos de uso, e você vê todos esses casos de uso emergentes. ## 7 As memórias dos seus amigos IA vão melhorar

Embora os dados, a computação e os parâmetros do modelo potencializem o raciocínio geral dos LLMs, as janelas contextuais alimentam sua memória de curto prazo. As janelas de contexto são normalmente medidas pelo número de tokens que podem manipular. Hoje, a maioria das janelas de contexto tem cerca de 32K, mas janelas de contexto maiores estão chegando e com elas vem a capacidade de executar documentos maiores com mais contexto por meio de LLMs.

Noam Shazeer,Personagem.AI:

Atualmente, os modelos que oferecemos utilizam janelas contextuais de milhares de tokens, o que significa que seus amigos de longa data se lembrarão do que aconteceu na última meia hora. Se você puder despejar muitas informações, as coisas vão melhorar. Deve ser capaz de aprender um bilhão de coisas sobre você. A largura de banda da HBM está lá. Dario Amodei,Antrópico:

Uma coisa que acho que ainda é subestimada é o contexto mais longo e as coisas que o acompanham. Acho que as pessoas têm essa imagem de ter esse chatbot. “Eu fiz uma pergunta e ele respondeu à pergunta. Mas você poderia fazer upload de um contrato legal e dizer: 'Quais são os cinco termos mais incomuns neste contrato legal?' Ou carregue um demonstrativo financeiro e diga: "Resumo de onde esta empresa está. O que é surpreendente em comparação com o que este analista disse há duas semanas? Todo esse conhecimento manipula e processa enormes quantidades de dados que as pessoas precisam contar." horas para ler. acho que isso é mais provável do que o que as pessoas estão fazendo. Estamos apenas começando." ## 8 Chatbots de voz, bots e outras formas de interagir com inteligência artificial são uma importante área de pesquisa

Hoje, a maioria das pessoas interage com a inteligência artificial na forma de chatbots, mas isso ocorre porque os chatbots costumam ser fáceis de construir, e não porque sejam a melhor interface para cada caso de uso.

Muitos construtores estão focados no desenvolvimento de novas maneiras de os usuários interagirem com modelos de IA por meio de IA multimodal. Os usuários poderão interagir com modelos multimodais da mesma forma que interagem com o resto do mundo: através de imagens, texto, voz e outras mídias. Indo um passo além: a IA incorporada concentra-se na inteligência artificial que pode interagir com o mundo físico, como carros autônomos.

Mira Murati,OpenAI:

Acho que o modelo básico de hoje representa bem o mundo em texto. Estamos adicionando outras modalidades, como imagens e vídeos, para que esses modelos possam ter uma imagem mais completa do mundo, semelhante à forma como entendemos e observamos o mundo. Noam Shazeer,Personagem.AI:

Talvez você queira ouvir uma voz, ver um rosto ou apenas interagir com várias pessoas. É como se você fosse eleito presidente, tivesse fones de ouvido e toda uma equipe de amigos ou conselheiros. Ou como se você entrasse em um “bar divertido” e todos soubessem seu nome e estivessem felizes por você ter vindo. Daphne Koller, introdução:

A próxima fronteira possível de impacto da IA é quando a IA começa a interagir com o mundo físico. Todos nós vemos como é difícil. Todos nós já vimos como é difícil construir um carro autônomo em comparação com construir um chatbot, certo? Estamos fazendo grandes progressos na construção de chatbots, e carros autônomos ainda bloqueiam caminhões de bombeiros em São Francisco. É importante compreender esta complexidade, mas também a escala do impacto ## 9 Teremos alguns modelos gerais, um monte de modelos especializados ou uma mistura de ambos?

Quais casos de uso são mais adequados para modelos básicos maiores de “inteligência superior” ou modelos e conjuntos de dados especializados menores? Assim como o debate nuvem versus arquitetura de borda de uma década atrás, a resposta depende de quanto você está disposto a pagar, quão preciso você precisa que o resultado seja e quanta latência você pode tolerar. As respostas a essas perguntas podem mudar com o tempo, à medida que os pesquisadores desenvolvem métodos computacionalmente mais eficientes para ajustar grandes modelos de base para casos de uso específicos.

A longo prazo, podemos alterar excessivamente os modelos utilizados e os casos de utilização, porque ainda estamos nas fases iniciais de construção da infraestrutura e da arquitetura para apoiar a próxima onda de aplicações de IA.

Ali Ghodsi, blocos de dados:

É um pouco como no ano 2000, a Internet está prestes a dominar tudo e o que importa é quem consegue construir o melhor roteador. A capitalização de mercado da Cisco atingiu o pico de US$ 5 trilhões em 2000, ultrapassando a Microsoft na época. Então, quem tem o maior LLM (modelo de linguagem)? Claramente, quem conseguir construir o maior e treiná-lo totalmente terá controle sobre toda a IA e os humanos do futuro. Mas, assim como a Internet, alguém terá ideias como Uber e táxi mais tarde. Haverá outras pessoas pensando: “Ei, quero ver o que meus amigos no Facebook estão fazendo.” Essas podem ser enormes oportunidades de negócios, e não são apenas empresas como OpenAI, Databricks ou Anthropic que podem construir um modelo. Dominar todos os aplicativos cenários. É preciso muito esforço para criar um médico em quem você confia. Dario Amodei,Antrópico:

O maior fator é investir mais dinheiro. Os modelos mais caros fabricados hoje custam cerca de US$ 100 milhões, mais ou menos uma ordem de grandeza. No próximo ano poderemos ver modelos de vários intervenientes no valor de cerca de mil milhões de dólares, e em 2025 veremos modelos na casa dos milhares de milhões ou mesmo de 10 mil milhões de dólares. Essa diferença de 100x é combinada com o fato de que os próprios cálculos do H100s se tornam mais rápidos - um salto especialmente grande devido à precisão reduzida. Junte todos esses fatores e, se as leis do escalonamento continuarem a ser aplicadas, haverá um enorme aumento nas capacidades. Mira Murati, OpenAI:

Depende do que você quer fazer. É claro que os sistemas de IA assumirão cada vez mais as tarefas que realizamos. Em termos da plataforma OpenAI, você pode ver que ainda hoje disponibilizamos muitos modelos através da API, desde modelos muito pequenos até modelos de ponta. Nem sempre é necessário usar o modelo mais poderoso ou competente. Às vezes, eles só precisam de um modelo que se adapte ao seu caso de uso específico e seja mais econômico. Queremos que as pessoas desenvolvam nosso modelo e lhes forneçam as ferramentas para tornar esse processo mais fácil. Queremos dar a eles cada vez mais acesso e controle para que você possa trazer seus próprios dados e personalizar esses modelos. Você realmente precisa focar em coisas que vão além do escopo do modelo e definem o produto. David Baszucki, Roblox:

Em qualquer empresa como a Roblox, existem provavelmente 20 ou 30 aplicativos verticais de usuário final que são muito personalizados – a filtragem de linguagem natural é muito diferente da geração 3D – e, no usuário final, queremos que todos esses aplicativos sejam executados. À medida que descemos [na pilha], em uma empresa como a nossa, pode haver um agrupamento natural de 2 ou 3 modelos maiores e mais gordos. Ajustamos muito bem as disciplinas que queremos poder treinar e fazer muitas inferências para essas disciplinas. ## 10 Quando a IA ganha adoção suficiente nas empresas, o que acontece com esses conjuntos de dados?

O impacto da IA generativa nas empresas ainda está na sua infância – em parte porque as empresas são normalmente mais lentas a mover-se e em parte porque perceberam o valor dos seus conjuntos de dados proprietários e não querem necessariamente entregar os dados a outra empresa. Não importa quão poderoso seja seu modelo. A maioria dos casos de uso corporativo exige um alto grau de precisão, e as empresas têm três opções para escolher o LLM: construir seu próprio LLM, usar um provedor de serviços de LLM para construí-lo para elas ou ajustar o modelo subjacente - construir seu próprio LLM não é fácil.

Ali Ghosdi, Databricks:

Uma coisa que acontece nos cérebros dos CEOs e dos conselhos de administração é que eles percebem: talvez eu consiga vencer a concorrência. Talvez seja a criptonita que mata seus inimigos. Eu tenho os dados para a IA generativa, então eles estão pensando: “Tenho que construí-los sozinho.” Tenho que possuir a propriedade intelectual. Você quer construir seu próprio LLM do zero? Não é trivial, ainda requer muitas GPUs, custa muito dinheiro e depende do seu conjunto de dados e caso de uso.

Temos muitos clientes que desejam um modelo mais barato, menor e específico, com precisão e desempenho muito altos. Eles dizem: "Ei, é isso que eu quero fazer. Quero obter uma boa classificação a partir dessas imagens desse defeito específico no processo de fabricação."A precisão é importante nesse caso. Cada grama de precisão que você pode me dar conta. Lá, você estará melhor se tiver um bom conjunto de dados para treinar e puder treinar um modelo menor. A latência será mais rápida, mais barata e, sim, você pode ter uma precisão que supera modelos realmente grandes. Mas o modelo que você constrói não irá entretê-lo nos fins de semana nem ajudar seus filhos com os deveres de casa. ## 11 A Lei da Escala nos levará até a AGI?

Atualmente, o LLM segue a lei do Scaling: o desempenho do modelo melhora à medida que você adiciona mais dados e cálculos, mesmo que a arquitetura e os algoritmos permaneçam os mesmos. Mas quanto tempo pode durar esta regra? Continuará indefinidamente ou atingirá os seus limites naturais antes de desenvolvermos a AGI?

Mira Murati, OpenAI:

Não há provas de que não conseguiremos modelos melhores e mais poderosos à medida que continuamos a expandir o acesso aos dados e à computação. Se isso leva você até o AGI - essa é uma questão diferente. Pode haver alguns outros avanços e avanços necessários ao longo do caminho, mas acho que ainda há um longo caminho a percorrer em termos das leis de escala e de realmente obter muitos benefícios desses modelos maiores. Dario Amodei, Antrópico:

Mesmo que não haja melhorias algorítmicas aqui e apenas avancemos até onde estivemos até agora, a lei do escalonamento continuará. Noam Shazeer, personagem.AI:

Nosso objetivo é ser uma empresa AGI e uma empresa que prioriza o produto, e a maneira de fazer isso é escolher os produtos certos, forçando-nos a fazer coisas que sejam generalizáveis, tornando os modelos mais inteligentes, tornando-os algo que as pessoas desejam e entregando. serviços baratos e em grande escala. A Lei da Escala nos levará muito longe. Essencialmente, a computação não é tão cara. Hoje, os custos operacionais giram em torno de US$ 10 a US$ 18. Se você puder fazer essas coisas com eficiência, o custo deverá ser muito menor do que o valor do seu tempo. Existe a capacidade de ampliar essas coisas em ordens de magnitude. ## 12 Quais são as capacidades emergentes?

Embora algumas pessoas desconsiderem rapidamente a capacidade de gerar inteligência artificial, a inteligência artificial já é muito melhor do que os humanos na execução de determinadas tarefas e continuará a melhorar. Os melhores construtores conseguiram identificar as capacidades emergentes mais promissoras da IA e construir modelos e empresas que transformam essas capacidades em capacidades fiáveis. Reconhecem que a escala tende a aumentar a fiabilidade das capacidades emergentes.

Mira Murati, OpenAI:

É importante prestar atenção a esses recursos emergentes, mesmo que não sejam confiáveis. Especialmente para as pessoas que estão construindo empresas hoje, você realmente quer pensar: "Ok, o que é possível hoje? O que você vê hoje? "Porque muito rapidamente esses modelos se tornarão confiáveis. Dario Amodei, Antrópico:

Quando lançamos o GPT-2, o que foi considerado mais impressionante na época foi: "Você alimenta esses cinco exemplos de tradução do inglês para o francês diretamente no modelo de idioma e, em seguida, alimenta a sexta frase em inglês, e ela realmente seria traduzida para o francês . Foi como, oh meu Deus, ele entende esse padrão. "Isso foi uma loucura para nós, embora tenha sido uma tradução ruim. Mas a nossa opinião é: “Olha, este é apenas o começo de uma jornada incrível porque não há limites e ela pode continuar a crescer.” Por que esses modelos que vimos antes não podem continuar a existir? Existem tantos objetivos para prever a próxima palavra, e há tantas coisas com as quais você pode desafiá-los, que definitivamente funciona. E então algumas pessoas olharam para ele e disseram: “Você fez uma ferramenta de tradução robótica muito ruim.” ## 13 O custo de manutenção desses modelos diminuirá?

Os custos computacionais são uma das principais limitações à expansão destes modelos, e a atual escassez de chips está a aumentar os custos ao limitar a oferta. No entanto, se a Nvidia produzir mais H100 no próximo ano, isso deverá aliviar a escassez de GPU e potencialmente reduzir os custos de computação.

Noam Shazeer, personagem.AI:

O modelo que oferecemos agora exigiu cerca de US$ 2 milhões em ciclos de computação para ser treinado no ano passado, e provavelmente faremos isso novamente por meio milhão de dólares. Portanto, lançaremos dezenas de pontos de QI de coisas mais inteligentes antes do final do ano. Vejo essas coisas aumentando enormemente. Só não é tão caro. Acho que vi um artigo ontem que a Nvidia iria fazer outro 1,5M H100 no próximo ano, que seria o 2M H100.

Isso representa cerca de um quarto de trilhão de operações por segundo por pessoa. Isto significa que para cada pessoa no planeta, num modelo com 100 mil milhões de parâmetros, poderia processar 1 palavra por segundo. Mas nem todo mundo tem acesso a isso, então não é tão caro. Essa coisa é muito escalável se você fizer isso direito, e estamos trabalhando duro para que isso aconteça. Dario Amodei, Antrópico:

Meu ponto básico é que a inferência não será tão cara. A lógica básica da lei de Scaling é que se você aumentar o cálculo por um fator de n, será necessário aumentar os dados por um fator da raiz quadrada de n e o tamanho do modelo por um fator da raiz quadrada de n. Essa raiz quadrada basicamente significa que o modelo em si não ficará maior e o hardware ficará mais rápido conforme você faz isso. Acho que essas coisas continuarão a ser relevantes nos próximos 3 ou 4 anos. Sem inovação arquitetônica, eles ficam um pouco mais caros. Se houver inovação arquitetônica, e espero que haja, elas ficarão mais baratas. Mas mesmo que os custos computacionais permaneçam constantes, as melhorias de eficiência ao nível do modelo parecem inevitáveis, especialmente com tantos talentos a entrar no terreno, e a própria IA pode ser a nossa ferramenta mais poderosa para melhorar a forma como a IA funciona.

Dario Amodei, Antrópico:

À medida que a IA se torna mais poderosa, ela tem melhor desempenho na maioria das tarefas cognitivas. Uma tarefa cognitiva relacionada é julgar a segurança dos sistemas de inteligência artificial e, em última análise, conduzir pesquisas de segurança. Há um componente autorreferencial nisso. Podemos ver isso lendo dentro das redes neurais, como o domínio da interpretabilidade. Sistemas de IA fortes podem nos ajudar a interpretar a atividade neuronal em sistemas de IA mais fracos. E estes insights de interpretabilidade muitas vezes nos dizem como o modelo funciona. Quando nos contam como um modelo funciona, muitas vezes sugerem maneiras de melhorá-lo ou torná-lo mais eficiente. Uma das áreas de pesquisa mais promissoras é o ajuste fino de modelos grandes para casos de uso específicos, sem executar o modelo inteiro.

Ali Ghodsi, blocos de dados:

Se você fizesse mil versões do LLM que fossem boas em mil coisas diferentes e tivesse que carregar cada uma delas na GPU e servi-las, isso ficaria muito caro. A grande coisa que todos procuram agora é: existe uma técnica que possa obter resultados muito bons com apenas pequenas modificações? Existem muitas tecnologias, como ajuste de prefixo, LoRA, CUBE LoRA, etc. Mas nenhuma solução verdadeiramente perfeita provou funcionar. Mas alguém vai encontrar. ## 14 Como medimos o progresso em direção à inteligência artificial geral?

Quando estendemos esses modelos, como sabemos quando uma IA se torna inteligência artificial geral? Quando ouvimos frequentemente o termo AGI, pode ser difícil defini-lo, talvez em parte porque é difícil de medir.

Benchmarks quantitativos como GLUE e SUPERGLUE têm sido usados há muito tempo como métricas padronizadas para medir o desempenho do modelo de IA. Mas, tal como os testes padronizados que aplicamos aos humanos, os benchmarks de IA levantam a questão: até que ponto se está a medir a capacidade de raciocínio de um LLM e até que ponto se está a medir a sua capacidade de passar num teste?

Ali Ghodsi, blocos de dados:

Eu meio que sinto que todos os benchmarks são uma besteira. Imagine se todas as nossas universidades dissessem: "Vamos dar-lhe as respostas para você ver na noite anterior ao exame. E então, no dia seguinte, pediremos que você responda às perguntas e as classifique". , todos poderiam passar no exame facilmente.

Por exemplo, MMLU é o benchmark que muitas pessoas usam para avaliar esses modelos. MMLU é apenas uma questão de múltipla escolha na internet. Faça uma pergunta: a resposta é A, B, C, D ou E? Então ele lhe dirá a resposta correta. Pode ser treinado online e criar um modelo LLM capaz de superá-lo. O teste qualitativo original para AGI foi o teste de Turing, mas convencer os humanos de que uma IA é humana não é um problema difícil. Fazer com que a inteligência artificial faça o que os humanos fazem no mundo real é um problema difícil. Então, quais testes podemos usar para entender a funcionalidade desses sistemas?

Dylan Campo, Figma:

O que estamos vendo agora com esses sistemas é que é fácil fazer as pessoas acreditarem que você é humano, mas é difícil realmente fazer coisas boas. Posso fazer com que o GPT-4 desenvolva um plano de negócios e venda para você, mas isso não significa que você investirá. Quando você realmente tem dois negócios concorrentes – um administrado por IA e outro administrado por humanos – e opta por investir no negócio de IA, isso me preocupa. David Baszucki, Roblox:

Tenho uma pergunta no teste de Turing para uma IA: se colocarmos uma IA no ano de 1633 e deixá-la treinar com todas as informações disponíveis naquele momento, ela preveria se a Terra ou o Sol seria o centro do sistema solar - mesmo embora 99,9% das informações digam que a Terra é o centro do sistema solar? Acho que 5 anos é o limite, mas se fizéssemos esse teste de AI Turing em 10 anos, provavelmente diria o sol. ## 15 Os humanos ainda precisam participar?

As novas tecnologias muitas vezes substituem alguns empregos e empregos humanos, mas também abrem áreas inteiramente novas, aumentam a produtividade e disponibilizam mais tipos de empregos para mais pessoas. Embora seja fácil imaginar a IA automatizando os trabalhos existentes, é muito mais difícil imaginar os próximos problemas e possibilidades que a IA trará.

Martin Casado, a16z:

Dito de forma muito simples, o Paradoxo de Jevons afirma: Se a procura for elástica e os preços caírem, a procura excederá a compensação. Muitas vezes, é muito mais do que compensado. Isso definitivamente se aplica à Internet. Você obtém mais valor e mais produtividade. Pessoalmente, acredito que a demanda é elástica quando se trata de automatizar qualquer ativo ou trabalho criativo. Quanto mais fazemos, mais as pessoas consomem. Estamos ansiosos por uma expansão massiva da produtividade, por uma infinidade de novos empregos e por muitas coisas novas, tal como vimos na era dos microchips e da Internet. Kevin Scott,Microsoft:

Cresci na região rural central da Virgínia, onde a economia era alimentada principalmente pela produção de tabaco, pela fabricação de móveis e pela indústria têxtil. Quando terminei o ensino médio, todos os três setores haviam acabado de entrar em colapso. Quando as pessoas nestas comunidades têm acesso a ferramentas incrivelmente poderosas, muitas vezes fazem coisas extraordinárias, criando oportunidades económicas para si próprias, para as suas famílias e para as suas comunidades. Eles resolvem problemas que você ou eu não conseguimos porque não vemos todo o cenário de problemas do mundo. Não temos a perspectiva deles. Essas ferramentas de IA estão agora mais fáceis de usar do que nunca. Você pode fazer coisas interessantes com essas ferramentas agora e se tornar um empreendedor em uma pequena cidade da Virgínia sem ter um doutorado em ciência da computação ou experiência em inteligência artificial clássica. Você apenas precisa permanecer curioso e empreendedor. Campo Dylan, Figma:

Se você observar cada mudança de tecnologia ou mudança de plataforma até o momento, verá que isso resultou em mais coisas para projetar. Há uma impressora e então você precisa descobrir o que colocar na página. Recentemente, com a Internet móvel, você pode pensar: “Bem, há menos pixels, há menos designers.” Mas não é o caso, foi quando vimos a maior explosão no número de designers. ## 16 Nunca houve um momento mais emocionante para construir uma startup de IA (especialmente se você for físico ou matemático)

Este é um momento único e entusiasmante para construir inteligência artificial: os modelos subjacentes estão a crescer rapidamente, a economia está finalmente a inclinar-se a favor das startups e há muitos problemas para resolver. A resolução destes problemas exige grande paciência e perseverança, e até agora os físicos e os matemáticos têm sido particularmente adequados para os resolver. Mas sendo um campo jovem e em rápido crescimento, a IA está totalmente aberta – e agora é o momento perfeito para a construir.

Dario Amodei, Antrópico:

A qualquer momento, existem dois tipos de reinos. Uma é uma área onde a experiência e o conhecimento acumulado são muito ricos e são necessários muitos anos para se tornar um especialista. A biologia é um exemplo clássico - se você trabalhar em biologia apenas por 6 meses, é muito difícil fazer um trabalho inovador ou no nível do Prêmio Nobel... O outro é um campo que é muito jovem ou está em desenvolvimento muito rápido. A inteligência artificial foi, e até certo ponto ainda é, uma dessas categorias. Generalistas realmente talentosos muitas vezes conseguem superar pessoas que estão na área há muito tempo porque as coisas mudam muito rapidamente. Na verdade, ter muito conhecimento prévio pode ser uma desvantagem. Mira Murati, OpenAI:

Uma conclusão do espaço teórico da matemática é que você precisa passar muito tempo pensando nos problemas. Às vezes você adormece e acorda com novas ideias, encontrando gradualmente a solução final ao longo de dias ou semanas. Não é um processo com retornos rápidos e, às vezes, não é algo iterativo. É quase uma forma diferente de pensar, onde você constrói intuição e disciplina para enfrentar um problema e confia em si mesmo para resolvê-lo. Com o tempo, você desenvolverá uma intuição sobre quais problemas realmente valem a pena trabalhar. Daphne Koller, introdução:

Não só o aprendizado de máquina está melhorando com o tempo, mas também as ferramentas biológicas nas quais confiamos. No passado, não existia tecnologia CRISPR, apenas siRNA. Depois veio a tecnologia de edição genética CRISPR, e agora existe a tecnologia principal CRISPR que pode substituir regiões genômicas inteiras. Como resultado, as ferramentas que estamos a construir estão cada vez melhores, o que abre a possibilidade de abordarmos mais doenças de formas mais significativas. Existem muitas oportunidades na intersecção da inteligência artificial/aprendizado de máquina com os campos da biologia e da medicina. Esta convergência é um momento que nos permite causar um enorme impacto no mundo em que vivemos, utilizando ferramentas que existem hoje, mas que não existiam há cinco anos. Kevin Scott,Microsoft:

Se você pensar em algumas das grandes mudanças de plataforma que aconteceram no passado, verá que as coisas mais valiosas nessas plataformas não foram aquelas que foram implantadas nos primeiros dois anos da mudança de plataforma. Se você pensar onde passa mais tempo em seu smartphone, não é um aplicativo de mensagens, nem um navegador da web, nem um cliente de e-mail. Pelo contrário, é algo novo que é criado alguns anos após a plataforma ser disponibilizada.

Que coisas que antes eram impossíveis agora são possíveis? É nisso que as pessoas deveriam pensar. Não persiga coisas triviais.

Ver original

Esta página pode conter conteúdo de terceiros, que é fornecido apenas para fins informativos (não para representações/garantias) e não deve ser considerada como um endosso de suas opiniões pela Gate nem como aconselhamento financeiro ou profissional. Consulte a Isenção de responsabilidade para obter detalhes.

Artigo a16z de 10.000 palavras: Estamos entrando na terceira era da computação

Esta onda de desenvolvimento da IA espalhou a sua influência a vários campos tão rapidamente que excedeu de facto as expectativas da maioria das pessoas. Na semana passada, a Sequoia (Sequoia America) acreditou que a IA abriu seu segundo capítulo e desenhou um novo mapa de IA e um mapa de pilha (pilha) de desenvolvedor LLM a partir da perspectiva dos cenários de aplicação.

No entanto, a julgar pela direção dos fundos, o atual desenvolvimento da IA parece ainda estar na fase de luta entre deuses, e esse padrão parece quase ter tomado forma. Depois que a OpenAI recebeu quase 11 bilhões de dólares americanos da Microsoft e outros e foi avaliada em quase 29 bilhões de dólares americanos, seu concorrente Anthropic anunciou ontem uma aliança com a Amazon. A Amazon investirá até 4 bilhões de dólares americanos nela, tornando a Anthropic atrás apenas da OpenAI em termos de financiamento de startups de IA.

Após esse financiamento, com exceção da Apple, a indústria de IA basicamente formou esse padrão de luta contra os deuses:

*Microsoft + OpenAI

É claro que, como fornecedora de infraestrutura de nível inferior, a estratégia da Nvidia é obviamente que todos desejam isso, e não há uma postura muito séria em relação a nenhuma empresa específica. A seguir está uma situação geral dos 15 unicórnios de IA. Do ponto de vista da avaliação e do financiamento, os grandes modelos LLM representam uma grande parte, e 50% dos unicórnios de IA foram estabelecidos após 2021:

Hoje, a16z compartilhou suas conversas com fundadores de várias empresas importantes de IA, acreditando que estamos na terceira era da computação, e discutiu 16 tópicos interessantes da perspectiva do presente, do futuro e da abertura da IA. Os participantes desta conversa incluem:

Como o artigo é muito longo, quase 10.000 palavras, usei IA para compilá-lo brevemente. Alguns termos podem não ser precisos. Amigos interessados podem ler o texto original em inglês:

1 Estamos no início da terceira era da computação

Martin Casado,a16z:

Eu realmente acho que podemos estar entrando na terceira era da computação. Os microchips reduziram o custo marginal da computação a zero, a Internet reduziu o custo marginal da distribuição a zero e agora os grandes modelos reduziram, na verdade, o custo marginal da criação a zero. Quando as eras anteriores aconteceram, você não tinha ideia de quais novas empresas seriam criadas. Ninguém previu a Amazon, ninguém previu o Yahoo. Devemos nos preparar para uma nova onda de empresas icônicas. Noam Shazeer, IA de personagem:

Estamos realmente no momento do “primeiro avião dos irmãos Wright”. Já temos algo que funciona e agora é útil para um grande número de cenários de aplicação. Parece que escala muito bem e ficará ainda melhor. Mas ainda há mais avanços por vir, porque agora todos os cientistas de IA do mundo estão trabalhando duro para melhorar essas coisas. Kevin Scott,Microsoft:

Principalmente nos últimos anos, e talvez principalmente nos últimos 12 meses, com o lançamento do ChatGPT e GPT-4, você pode realmente ver o potencial desta plataforma para ser igual a um PC ou smartphone. Uma série de tecnologias tornará possível uma série de coisas novas, e muitas pessoas construirão coisas em cima dessas coisas novas. ## 2 Esta onda de inteligência artificial generativa possui princípios econômicos que promovem a transformação do mercado.

Para que a inovação tecnológica desencadeie a transformação do mercado, os benefícios económicos devem ser altamente atrativos. Embora tenha havido muitos avanços tecnológicos em ciclos anteriores de IA, faltaram-lhes benefícios económicos transformadores. Na onda atual da IA, já estamos vendo os primeiros sinais de melhorias econômicas de 10.000 vezes (ou mais) em alguns casos de uso, e a adoção e o desenvolvimento resultantes da IA parecem ser muito mais rápidos do que qualquer mudança anterior.

Martin Casado,a16z:

A transformação do mercado não ocorre através de uma melhoria económica dez vezes maior. Eles são criados quando são dez mil vezes melhores do que antes. Digamos que eu queira criar uma imagem que me transforme em um personagem da Pixar. Se eu usar um desses modelos de imagem, o custo de inferência será de um décimo de centavo e digamos que demore 1 segundo. Se compararmos com a contratação de um artista gráfico, vamos supor que a taxa horária seja de US$ 100. Em termos de custo e tempo, você verá uma enorme diferença de 4 a 5 ordens de grandeza. Para os economistas, este é o tipo de ponto de viragem que procuram, quando na verdade há uma enorme deslocação do mercado. Se você quiser um exemplo de como isso pode ser louco, não vejo razão para que você não consiga gerar um jogo completo - modelos 3D, personagens, sons, música, história, etc. As startups estão a fazer todas estas coisas agora, e se compararmos o custo de centenas de milhões de dólares e anos com o custo de alguns dólares, temos agora uma assimetria na economia ao nível da Internet e dos microchips.

3 Para alguns cenários de aplicação iniciais: Criatividade > Correção

As alucinações são um problema bem conhecido nos LLMs de grandes modelos atuais, mas para algumas aplicações a capacidade de inventar coisas é um recurso e não um bug. Em comparação com os primeiros casos de uso de aprendizado de máquina aplicado, onde a correção de nível n é crítica (por exemplo, carros autônomos), muitos dos primeiros casos de uso para LLMs (amigos e companheiros virtuais, conceitos de brainstorming ou construção de jogos online) são caracterizados por: foco Em áreas onde a criatividade é mais importante que a correção.

Noam Shazeer, Personagem.AI:

O entretenimento é uma indústria que movimenta US$ 2 trilhões anualmente. E o segredo obscuro é que o entretenimento é como amigos virtuais inexistentes. Este é um primeiro caso de uso interessante para inteligência artificial geral. Se você quisesse lançar um médico, por exemplo, seria muito mais lento porque você precisa ter muito, muito, muito cuidado para não dar informações erradas. Mas com amigos você pode fazer isso muito rapidamente, é muito divertido e inventar coisas se torna um recurso. David Baszucki,Roblox:

Dos 65 milhões de usuários do Roblox, a maioria não está criando no nível que gostaria. Por muito tempo imaginamos um jogo de simulação do Project Runway onde você poderia usar uma máquina de costura e tecido e ter tudo simulado em 3D, mas mesmo isso era um pouco complicado para a maioria de nós. Acho que agora, quando o Project Runway for lançado no Roblox, será um prompt de texto, um prompt de imagem ou um prompt de voz. Se eu estivesse te ajudando a fazer essa camisa, eu diria: quero uma camisa jeans azul, com alguns botões e um corte mais justo. Na verdade, acho que veremos uma aceleração na criação. Dylan Campo, Figma:

No momento, estamos em um estágio em que é possível para a IA concluir um primeiro rascunho, mas passar disso até o produto final ainda é um tanto difícil e muitas vezes requer uma equipe para fazer isso. Mas se você conseguir que a IA sugira elementos de interface para as pessoas e faça isso de uma maneira que realmente faça sentido, acho que isso abrirá uma nova era de design, criando designs contextuais que respondam à intenção do usuário. Acredito que esta será uma era fascinante para todos os designers trabalharem em colaboração com estes sistemas de inteligência artificial. ## 4 Para outros exemplos, a precisão da programação do "co-piloto" melhorará com o uso humano.

Embora a IA tenha o potencial de aumentar o trabalho humano em muitas áreas, a programação de “copilotos” tornou-se o primeiro assistente de IA amplamente adotado por vários motivos:

Primeiro, os desenvolvedores costumam ser os primeiros a adotar novas tecnologias – uma análise das dicas do ChatGPT em maio/junho de 2023 descobriu que 30% das dicas do ChatGPT estavam relacionadas à programação. Em segundo lugar, os maiores LLMs são treinados em conjuntos de dados com muitos códigos (como a Internet), o que os torna particularmente bons em responder a consultas relacionadas à programação. Finalmente, as pessoas envolvidas são os usuários. Portanto, embora a precisão seja importante, um desenvolvedor humano com um copiloto de IA pode iterar até a correção mais rapidamente do que um desenvolvedor humano sozinho.

Martin Casado,a16z:

Se você precisar acertar e houver muitos casos de uso complexos, faça todo o trabalho técnico sozinho ou contrate pessoas. Normalmente contratamos pessoas. Este é um custo variável. Em segundo lugar, porque a cauda das soluções é muitas vezes muito longa – como as muitas anomalias que podem ocorrer na condução autónoma – o investimento necessário para se manter à frente aumenta e o valor diminui. Isso cria um efeito reverso de economia de escala. Aquele ser humano no circuito que costumava estar em uma empresa central agora é o usuário, portanto não é mais um custo variável para o negócio e para a economia do custo do trabalho. A pessoa no loop foi removida, para que você possa fazer coisas onde a correção é importante, como desenvolver código, e por ser iterativo, a quantidade de bugs acumulados é reduzida porque você recebe constantemente feedback e correções dos usuários. Quando os desenvolvedores podem consultar um chatbot de IA para ajudá-los a escrever e solucionar problemas de código, isso muda a maneira como o desenvolvimento é feito de duas maneiras significativas: 1) Torna o desenvolvimento mais fácil para mais pessoas Colaboração porque acontece por meio de uma interface de linguagem natural, 2) Desenvolvedores humanos produzir mais produtos e mantê-los fluindo por mais tempo.

Mira Murati,OpenAI:

A programação se torna cada vez menos abstrata. Na verdade, podemos conversar com computadores de alta largura de banda em linguagem natural. Estamos usando a tecnologia e a tecnologia está nos ajudando a entender como trabalhar com ela, em vez de “programá-la”. Kevin Scott,Microsoft:

GitHub é o primeiro exemplo deste modelo copiloto que estamos tentando construir, que é: como você pega o trabalho de conhecimento que alguém está fazendo e usa IA para ajudá-lo a ser significativamente mais produtivo na realização de tipos específicos de trabalho cognitivo ? O melhor de tudo é que, com base no que observamos com os desenvolvedores, a IA os ajuda a permanecer em um estado de fluxo por mais tempo do que permaneceriam de outra forma. Não fique paralisado ao escrever um pedaço de código e pensar: "Não sei como fazer a próxima coisa. Tenho que procurar a documentação. Tenho que perguntar a outro engenheiro que possa estar trabalhando em alguma coisa." "Ser capaz de se libertar do fluxo antes de sair do estado de fluxo é extremamente valioso. Para aqueles que estão considerando a utilidade de ferramentas generativas de IA construídas para outros fins que não o desenvolvimento de software, esse conceito de estados de fluxo é algo útil a se considerar. Campo Dylan, Figma:

Os melhores designers começam a pensar mais em código e os melhores desenvolvedores começam a pensar mais em design. Além dos designers e desenvolvedores, por exemplo, se você pensar no pessoal de produto, eles podem ter trabalhado em especificações antes, mas agora estão trabalhando mais em maquetes para comunicar suas ideias de maneira mais eficaz. Basicamente, isso permitirá que qualquer pessoa na organização passe da ideia ao design e, possivelmente, até à produção, com mais rapidez. Mas você ainda precisa aprimorar cada passo. Você precisa de alguém que realmente pense: "Ok, que ideias vamos explorar? Como vamos explorá-las? "Você vai querer ajustar os designs, vai querer lidar com eles corretamente, desde o primeiro rascunho até o produto final. ## 5 Combinar IA e biologia poderia acelerar novas formas de tratar doenças e ter um impacto profundo na saúde humana

A biologia é incrivelmente complexa – talvez até além da capacidade de compreensão plena da mente humana. No entanto, a intersecção da IA e da biologia poderia acelerar a nossa compreensão da biologia e levar a alguns dos avanços tecnológicos mais emocionantes e transformadores do nosso tempo. As plataformas biológicas baseadas em IA têm o potencial de desbloquear conhecimentos biológicos anteriormente desconhecidos, levando a novas descobertas médicas, novos métodos de diagnóstico e à capacidade de detectar e tratar doenças mais cedo, potencialmente até prevenindo-as antes que ocorram.

Daphne Koller, introdução:

Em determinados momentos da nossa história, certas disciplinas científicas fizeram progressos incríveis num período de tempo relativamente curto. Na década de 1950, a disciplina era a computação, e usávamos essas máquinas para realizar cálculos que, até então, apenas humanos conseguiam realizar. Depois, na década de 1990, houve esta divergência interessante. Por um lado, a ciência de dados e as estatísticas trouxeram-nos, em última análise, a aprendizagem automática moderna e a inteligência artificial. O outro lado é o que considero biologia quantitativa, que é a primeira vez que começamos a medir a biologia em uma escala além do rastreamento de 3 genes em um experimento que durou 5 anos. Agora, 2020 é a última vez que as duas disciplinas convergiram verdadeiramente, trazendo-nos a era da biologia digital, a capacidade de medir a biologia com fidelidade e escala sem precedentes; interpretando o incompreensível usando ferramentas de aprendizagem automática e ciência de dados. escalas biológicas e diferentes sistemas; e depois usar ferramentas como a edição do genoma CRISPR para trazer esse entendimento de volta à biologia da engenharia, para que possamos fazer com que a biologia faça coisas que não deveria fazer. Agora, podemos finalmente medir a biologia em escala, nos níveis celular (e às vezes subcelular) e do organismo. Isto permite-nos, pela primeira vez, implementar a aprendizagem automática de uma forma verdadeiramente significativa. Construímos um modelo de linguagem biológica. É como GPT, mas para células. Temos a linguagem das células e a aparência das células. Você mede centenas de milhões de células em diferentes estados e, então, como um grande modelo de linguagem para linguagem natural, com uma pequena quantidade de dados, pode começar a perguntar: "Ok, como é que uma doença move um gene causador de doença de um estado para outro? lugar para outro?" ?Como o tratamento leva você de um estado de doença de volta a um estado de saúde? "Isso é superpoderoso. Tal como acontece com outros modelos de linguagem, quanto mais dados você alimenta, melhor fica. ## 6 Colocar o modelo nas mãos dos usuários nos ajudará a descobrir novos cenários de aplicação

Embora as iterações anteriores de modelos de IA visassem superar os humanos em determinadas tarefas, os LLMs baseados em Transformer se destacam no raciocínio geral. Mas só porque criamos um bom modelo geral não significa que descobrimos como aplicá-lo a um caso de uso específico. Assim como trazer os seres humanos para o circuito na forma de RLHF é fundamental para melhorar o desempenho dos modelos de IA atuais, colocar novas tecnologias nas mãos dos usuários e entender como eles as utilizam será fundamental para determinar quais aplicativos construir com base nessas tecnologias subjacentes. modelos. topo.

Kevin Scott,Microsoft:

Devemos lembrar: o modelo não é o produto. Como empreendedor, seu entendimento é: Quem são seus usuários? Qual é o problema deles? O que você pode fazer para ajudá-los? Em seguida, determine se a IA é de fato uma infraestrutura útil para resolver os problemas dos usuários – isso é uma constante. A inteligência artificial é como uma infraestrutura nova e interessante que permite resolver novas classes de problemas ou resolver classes antigas de problemas de maneiras melhores. Mira Murati,OpenAI:

Não sabemos exatamente como será o futuro, por isso estamos tentando disponibilizar essas ferramentas e técnicas para muitas outras pessoas para que possam experimentar e ver o que acontece. Essa é uma estratégia que usamos desde o início. Na semana anterior ao lançamento do ChatGPT, estávamos preocupados que não fosse bom o suficiente. Todos nós já vimos o que acontece: divulgamos e depois as pessoas nos dizem que é bom o suficiente para descobrir novos casos de uso, e você vê todos esses casos de uso emergentes. ## 7 As memórias dos seus amigos IA vão melhorar

Embora os dados, a computação e os parâmetros do modelo potencializem o raciocínio geral dos LLMs, as janelas contextuais alimentam sua memória de curto prazo. As janelas de contexto são normalmente medidas pelo número de tokens que podem manipular. Hoje, a maioria das janelas de contexto tem cerca de 32K, mas janelas de contexto maiores estão chegando e com elas vem a capacidade de executar documentos maiores com mais contexto por meio de LLMs.

Noam Shazeer,Personagem.AI:

Atualmente, os modelos que oferecemos utilizam janelas contextuais de milhares de tokens, o que significa que seus amigos de longa data se lembrarão do que aconteceu na última meia hora. Se você puder despejar muitas informações, as coisas vão melhorar. Deve ser capaz de aprender um bilhão de coisas sobre você. A largura de banda da HBM está lá. Dario Amodei,Antrópico:

Uma coisa que acho que ainda é subestimada é o contexto mais longo e as coisas que o acompanham. Acho que as pessoas têm essa imagem de ter esse chatbot. “Eu fiz uma pergunta e ele respondeu à pergunta. Mas você poderia fazer upload de um contrato legal e dizer: 'Quais são os cinco termos mais incomuns neste contrato legal?' Ou carregue um demonstrativo financeiro e diga: "Resumo de onde esta empresa está. O que é surpreendente em comparação com o que este analista disse há duas semanas? Todo esse conhecimento manipula e processa enormes quantidades de dados que as pessoas precisam contar." horas para ler. acho que isso é mais provável do que o que as pessoas estão fazendo. Estamos apenas começando." ## 8 Chatbots de voz, bots e outras formas de interagir com inteligência artificial são uma importante área de pesquisa

Hoje, a maioria das pessoas interage com a inteligência artificial na forma de chatbots, mas isso ocorre porque os chatbots costumam ser fáceis de construir, e não porque sejam a melhor interface para cada caso de uso.

Muitos construtores estão focados no desenvolvimento de novas maneiras de os usuários interagirem com modelos de IA por meio de IA multimodal. Os usuários poderão interagir com modelos multimodais da mesma forma que interagem com o resto do mundo: através de imagens, texto, voz e outras mídias. Indo um passo além: a IA incorporada concentra-se na inteligência artificial que pode interagir com o mundo físico, como carros autônomos.

Mira Murati,OpenAI:

Acho que o modelo básico de hoje representa bem o mundo em texto. Estamos adicionando outras modalidades, como imagens e vídeos, para que esses modelos possam ter uma imagem mais completa do mundo, semelhante à forma como entendemos e observamos o mundo. Noam Shazeer,Personagem.AI:

Talvez você queira ouvir uma voz, ver um rosto ou apenas interagir com várias pessoas. É como se você fosse eleito presidente, tivesse fones de ouvido e toda uma equipe de amigos ou conselheiros. Ou como se você entrasse em um “bar divertido” e todos soubessem seu nome e estivessem felizes por você ter vindo. Daphne Koller, introdução:

A próxima fronteira possível de impacto da IA é quando a IA começa a interagir com o mundo físico. Todos nós vemos como é difícil. Todos nós já vimos como é difícil construir um carro autônomo em comparação com construir um chatbot, certo? Estamos fazendo grandes progressos na construção de chatbots, e carros autônomos ainda bloqueiam caminhões de bombeiros em São Francisco. É importante compreender esta complexidade, mas também a escala do impacto ## 9 Teremos alguns modelos gerais, um monte de modelos especializados ou uma mistura de ambos?

Quais casos de uso são mais adequados para modelos básicos maiores de “inteligência superior” ou modelos e conjuntos de dados especializados menores? Assim como o debate nuvem versus arquitetura de borda de uma década atrás, a resposta depende de quanto você está disposto a pagar, quão preciso você precisa que o resultado seja e quanta latência você pode tolerar. As respostas a essas perguntas podem mudar com o tempo, à medida que os pesquisadores desenvolvem métodos computacionalmente mais eficientes para ajustar grandes modelos de base para casos de uso específicos.

A longo prazo, podemos alterar excessivamente os modelos utilizados e os casos de utilização, porque ainda estamos nas fases iniciais de construção da infraestrutura e da arquitetura para apoiar a próxima onda de aplicações de IA.

Ali Ghodsi, blocos de dados:

É um pouco como no ano 2000, a Internet está prestes a dominar tudo e o que importa é quem consegue construir o melhor roteador. A capitalização de mercado da Cisco atingiu o pico de US$ 5 trilhões em 2000, ultrapassando a Microsoft na época. Então, quem tem o maior LLM (modelo de linguagem)? Claramente, quem conseguir construir o maior e treiná-lo totalmente terá controle sobre toda a IA e os humanos do futuro. Mas, assim como a Internet, alguém terá ideias como Uber e táxi mais tarde. Haverá outras pessoas pensando: “Ei, quero ver o que meus amigos no Facebook estão fazendo.” Essas podem ser enormes oportunidades de negócios, e não são apenas empresas como OpenAI, Databricks ou Anthropic que podem construir um modelo. Dominar todos os aplicativos cenários. É preciso muito esforço para criar um médico em quem você confia. Dario Amodei,Antrópico:

O maior fator é investir mais dinheiro. Os modelos mais caros fabricados hoje custam cerca de US$ 100 milhões, mais ou menos uma ordem de grandeza. No próximo ano poderemos ver modelos de vários intervenientes no valor de cerca de mil milhões de dólares, e em 2025 veremos modelos na casa dos milhares de milhões ou mesmo de 10 mil milhões de dólares. Essa diferença de 100x é combinada com o fato de que os próprios cálculos do H100s se tornam mais rápidos - um salto especialmente grande devido à precisão reduzida. Junte todos esses fatores e, se as leis do escalonamento continuarem a ser aplicadas, haverá um enorme aumento nas capacidades. Mira Murati, OpenAI:

Depende do que você quer fazer. É claro que os sistemas de IA assumirão cada vez mais as tarefas que realizamos. Em termos da plataforma OpenAI, você pode ver que ainda hoje disponibilizamos muitos modelos através da API, desde modelos muito pequenos até modelos de ponta. Nem sempre é necessário usar o modelo mais poderoso ou competente. Às vezes, eles só precisam de um modelo que se adapte ao seu caso de uso específico e seja mais econômico. Queremos que as pessoas desenvolvam nosso modelo e lhes forneçam as ferramentas para tornar esse processo mais fácil. Queremos dar a eles cada vez mais acesso e controle para que você possa trazer seus próprios dados e personalizar esses modelos. Você realmente precisa focar em coisas que vão além do escopo do modelo e definem o produto. David Baszucki, Roblox:

Em qualquer empresa como a Roblox, existem provavelmente 20 ou 30 aplicativos verticais de usuário final que são muito personalizados – a filtragem de linguagem natural é muito diferente da geração 3D – e, no usuário final, queremos que todos esses aplicativos sejam executados. À medida que descemos [na pilha], em uma empresa como a nossa, pode haver um agrupamento natural de 2 ou 3 modelos maiores e mais gordos. Ajustamos muito bem as disciplinas que queremos poder treinar e fazer muitas inferências para essas disciplinas. ## 10 Quando a IA ganha adoção suficiente nas empresas, o que acontece com esses conjuntos de dados?

O impacto da IA generativa nas empresas ainda está na sua infância – em parte porque as empresas são normalmente mais lentas a mover-se e em parte porque perceberam o valor dos seus conjuntos de dados proprietários e não querem necessariamente entregar os dados a outra empresa. Não importa quão poderoso seja seu modelo. A maioria dos casos de uso corporativo exige um alto grau de precisão, e as empresas têm três opções para escolher o LLM: construir seu próprio LLM, usar um provedor de serviços de LLM para construí-lo para elas ou ajustar o modelo subjacente - construir seu próprio LLM não é fácil.

Ali Ghosdi, Databricks:

Uma coisa que acontece nos cérebros dos CEOs e dos conselhos de administração é que eles percebem: talvez eu consiga vencer a concorrência. Talvez seja a criptonita que mata seus inimigos. Eu tenho os dados para a IA generativa, então eles estão pensando: “Tenho que construí-los sozinho.” Tenho que possuir a propriedade intelectual. Você quer construir seu próprio LLM do zero? Não é trivial, ainda requer muitas GPUs, custa muito dinheiro e depende do seu conjunto de dados e caso de uso. Temos muitos clientes que desejam um modelo mais barato, menor e específico, com precisão e desempenho muito altos. Eles dizem: "Ei, é isso que eu quero fazer. Quero obter uma boa classificação a partir dessas imagens desse defeito específico no processo de fabricação."A precisão é importante nesse caso. Cada grama de precisão que você pode me dar conta. Lá, você estará melhor se tiver um bom conjunto de dados para treinar e puder treinar um modelo menor. A latência será mais rápida, mais barata e, sim, você pode ter uma precisão que supera modelos realmente grandes. Mas o modelo que você constrói não irá entretê-lo nos fins de semana nem ajudar seus filhos com os deveres de casa. ## 11 A Lei da Escala nos levará até a AGI?

Atualmente, o LLM segue a lei do Scaling: o desempenho do modelo melhora à medida que você adiciona mais dados e cálculos, mesmo que a arquitetura e os algoritmos permaneçam os mesmos. Mas quanto tempo pode durar esta regra? Continuará indefinidamente ou atingirá os seus limites naturais antes de desenvolvermos a AGI?

Mira Murati, OpenAI:

Não há provas de que não conseguiremos modelos melhores e mais poderosos à medida que continuamos a expandir o acesso aos dados e à computação. Se isso leva você até o AGI - essa é uma questão diferente. Pode haver alguns outros avanços e avanços necessários ao longo do caminho, mas acho que ainda há um longo caminho a percorrer em termos das leis de escala e de realmente obter muitos benefícios desses modelos maiores. Dario Amodei, Antrópico:

Mesmo que não haja melhorias algorítmicas aqui e apenas avancemos até onde estivemos até agora, a lei do escalonamento continuará. Noam Shazeer, personagem.AI:

Nosso objetivo é ser uma empresa AGI e uma empresa que prioriza o produto, e a maneira de fazer isso é escolher os produtos certos, forçando-nos a fazer coisas que sejam generalizáveis, tornando os modelos mais inteligentes, tornando-os algo que as pessoas desejam e entregando. serviços baratos e em grande escala. A Lei da Escala nos levará muito longe. Essencialmente, a computação não é tão cara. Hoje, os custos operacionais giram em torno de US$ 10 a US$ 18. Se você puder fazer essas coisas com eficiência, o custo deverá ser muito menor do que o valor do seu tempo. Existe a capacidade de ampliar essas coisas em ordens de magnitude. ## 12 Quais são as capacidades emergentes?

Embora algumas pessoas desconsiderem rapidamente a capacidade de gerar inteligência artificial, a inteligência artificial já é muito melhor do que os humanos na execução de determinadas tarefas e continuará a melhorar. Os melhores construtores conseguiram identificar as capacidades emergentes mais promissoras da IA e construir modelos e empresas que transformam essas capacidades em capacidades fiáveis. Reconhecem que a escala tende a aumentar a fiabilidade das capacidades emergentes.

Mira Murati, OpenAI:

É importante prestar atenção a esses recursos emergentes, mesmo que não sejam confiáveis. Especialmente para as pessoas que estão construindo empresas hoje, você realmente quer pensar: "Ok, o que é possível hoje? O que você vê hoje? "Porque muito rapidamente esses modelos se tornarão confiáveis. Dario Amodei, Antrópico:

Quando lançamos o GPT-2, o que foi considerado mais impressionante na época foi: "Você alimenta esses cinco exemplos de tradução do inglês para o francês diretamente no modelo de idioma e, em seguida, alimenta a sexta frase em inglês, e ela realmente seria traduzida para o francês . Foi como, oh meu Deus, ele entende esse padrão. "Isso foi uma loucura para nós, embora tenha sido uma tradução ruim. Mas a nossa opinião é: “Olha, este é apenas o começo de uma jornada incrível porque não há limites e ela pode continuar a crescer.” Por que esses modelos que vimos antes não podem continuar a existir? Existem tantos objetivos para prever a próxima palavra, e há tantas coisas com as quais você pode desafiá-los, que definitivamente funciona. E então algumas pessoas olharam para ele e disseram: “Você fez uma ferramenta de tradução robótica muito ruim.” ## 13 O custo de manutenção desses modelos diminuirá?

Os custos computacionais são uma das principais limitações à expansão destes modelos, e a atual escassez de chips está a aumentar os custos ao limitar a oferta. No entanto, se a Nvidia produzir mais H100 no próximo ano, isso deverá aliviar a escassez de GPU e potencialmente reduzir os custos de computação.

Noam Shazeer, personagem.AI:

O modelo que oferecemos agora exigiu cerca de US$ 2 milhões em ciclos de computação para ser treinado no ano passado, e provavelmente faremos isso novamente por meio milhão de dólares. Portanto, lançaremos dezenas de pontos de QI de coisas mais inteligentes antes do final do ano. Vejo essas coisas aumentando enormemente. Só não é tão caro. Acho que vi um artigo ontem que a Nvidia iria fazer outro 1,5M H100 no próximo ano, que seria o 2M H100. Isso representa cerca de um quarto de trilhão de operações por segundo por pessoa. Isto significa que para cada pessoa no planeta, num modelo com 100 mil milhões de parâmetros, poderia processar 1 palavra por segundo. Mas nem todo mundo tem acesso a isso, então não é tão caro. Essa coisa é muito escalável se você fizer isso direito, e estamos trabalhando duro para que isso aconteça. Dario Amodei, Antrópico:

Meu ponto básico é que a inferência não será tão cara. A lógica básica da lei de Scaling é que se você aumentar o cálculo por um fator de n, será necessário aumentar os dados por um fator da raiz quadrada de n e o tamanho do modelo por um fator da raiz quadrada de n. Essa raiz quadrada basicamente significa que o modelo em si não ficará maior e o hardware ficará mais rápido conforme você faz isso. Acho que essas coisas continuarão a ser relevantes nos próximos 3 ou 4 anos. Sem inovação arquitetônica, eles ficam um pouco mais caros. Se houver inovação arquitetônica, e espero que haja, elas ficarão mais baratas. Mas mesmo que os custos computacionais permaneçam constantes, as melhorias de eficiência ao nível do modelo parecem inevitáveis, especialmente com tantos talentos a entrar no terreno, e a própria IA pode ser a nossa ferramenta mais poderosa para melhorar a forma como a IA funciona.

Dario Amodei, Antrópico:

À medida que a IA se torna mais poderosa, ela tem melhor desempenho na maioria das tarefas cognitivas. Uma tarefa cognitiva relacionada é julgar a segurança dos sistemas de inteligência artificial e, em última análise, conduzir pesquisas de segurança. Há um componente autorreferencial nisso. Podemos ver isso lendo dentro das redes neurais, como o domínio da interpretabilidade. Sistemas de IA fortes podem nos ajudar a interpretar a atividade neuronal em sistemas de IA mais fracos. E estes insights de interpretabilidade muitas vezes nos dizem como o modelo funciona. Quando nos contam como um modelo funciona, muitas vezes sugerem maneiras de melhorá-lo ou torná-lo mais eficiente. Uma das áreas de pesquisa mais promissoras é o ajuste fino de modelos grandes para casos de uso específicos, sem executar o modelo inteiro.

Ali Ghodsi, blocos de dados:

Se você fizesse mil versões do LLM que fossem boas em mil coisas diferentes e tivesse que carregar cada uma delas na GPU e servi-las, isso ficaria muito caro. A grande coisa que todos procuram agora é: existe uma técnica que possa obter resultados muito bons com apenas pequenas modificações? Existem muitas tecnologias, como ajuste de prefixo, LoRA, CUBE LoRA, etc. Mas nenhuma solução verdadeiramente perfeita provou funcionar. Mas alguém vai encontrar. ## 14 Como medimos o progresso em direção à inteligência artificial geral?

Quando estendemos esses modelos, como sabemos quando uma IA se torna inteligência artificial geral? Quando ouvimos frequentemente o termo AGI, pode ser difícil defini-lo, talvez em parte porque é difícil de medir.

Benchmarks quantitativos como GLUE e SUPERGLUE têm sido usados há muito tempo como métricas padronizadas para medir o desempenho do modelo de IA. Mas, tal como os testes padronizados que aplicamos aos humanos, os benchmarks de IA levantam a questão: até que ponto se está a medir a capacidade de raciocínio de um LLM e até que ponto se está a medir a sua capacidade de passar num teste?

Ali Ghodsi, blocos de dados:

Eu meio que sinto que todos os benchmarks são uma besteira. Imagine se todas as nossas universidades dissessem: "Vamos dar-lhe as respostas para você ver na noite anterior ao exame. E então, no dia seguinte, pediremos que você responda às perguntas e as classifique". , todos poderiam passar no exame facilmente. Por exemplo, MMLU é o benchmark que muitas pessoas usam para avaliar esses modelos. MMLU é apenas uma questão de múltipla escolha na internet. Faça uma pergunta: a resposta é A, B, C, D ou E? Então ele lhe dirá a resposta correta. Pode ser treinado online e criar um modelo LLM capaz de superá-lo. O teste qualitativo original para AGI foi o teste de Turing, mas convencer os humanos de que uma IA é humana não é um problema difícil. Fazer com que a inteligência artificial faça o que os humanos fazem no mundo real é um problema difícil. Então, quais testes podemos usar para entender a funcionalidade desses sistemas?

Dylan Campo, Figma:

O que estamos vendo agora com esses sistemas é que é fácil fazer as pessoas acreditarem que você é humano, mas é difícil realmente fazer coisas boas. Posso fazer com que o GPT-4 desenvolva um plano de negócios e venda para você, mas isso não significa que você investirá. Quando você realmente tem dois negócios concorrentes – um administrado por IA e outro administrado por humanos – e opta por investir no negócio de IA, isso me preocupa. David Baszucki, Roblox:

Tenho uma pergunta no teste de Turing para uma IA: se colocarmos uma IA no ano de 1633 e deixá-la treinar com todas as informações disponíveis naquele momento, ela preveria se a Terra ou o Sol seria o centro do sistema solar - mesmo embora 99,9% das informações digam que a Terra é o centro do sistema solar? Acho que 5 anos é o limite, mas se fizéssemos esse teste de AI Turing em 10 anos, provavelmente diria o sol. ## 15 Os humanos ainda precisam participar?

As novas tecnologias muitas vezes substituem alguns empregos e empregos humanos, mas também abrem áreas inteiramente novas, aumentam a produtividade e disponibilizam mais tipos de empregos para mais pessoas. Embora seja fácil imaginar a IA automatizando os trabalhos existentes, é muito mais difícil imaginar os próximos problemas e possibilidades que a IA trará.

Martin Casado, a16z:

Dito de forma muito simples, o Paradoxo de Jevons afirma: Se a procura for elástica e os preços caírem, a procura excederá a compensação. Muitas vezes, é muito mais do que compensado. Isso definitivamente se aplica à Internet. Você obtém mais valor e mais produtividade. Pessoalmente, acredito que a demanda é elástica quando se trata de automatizar qualquer ativo ou trabalho criativo. Quanto mais fazemos, mais as pessoas consomem. Estamos ansiosos por uma expansão massiva da produtividade, por uma infinidade de novos empregos e por muitas coisas novas, tal como vimos na era dos microchips e da Internet. Kevin Scott,Microsoft:

Cresci na região rural central da Virgínia, onde a economia era alimentada principalmente pela produção de tabaco, pela fabricação de móveis e pela indústria têxtil. Quando terminei o ensino médio, todos os três setores haviam acabado de entrar em colapso. Quando as pessoas nestas comunidades têm acesso a ferramentas incrivelmente poderosas, muitas vezes fazem coisas extraordinárias, criando oportunidades económicas para si próprias, para as suas famílias e para as suas comunidades. Eles resolvem problemas que você ou eu não conseguimos porque não vemos todo o cenário de problemas do mundo. Não temos a perspectiva deles. Essas ferramentas de IA estão agora mais fáceis de usar do que nunca. Você pode fazer coisas interessantes com essas ferramentas agora e se tornar um empreendedor em uma pequena cidade da Virgínia sem ter um doutorado em ciência da computação ou experiência em inteligência artificial clássica. Você apenas precisa permanecer curioso e empreendedor. Campo Dylan, Figma: