- Tópico

34k Popularidade

12k Popularidade

6k Popularidade

16k Popularidade

61k Popularidade

31k Popularidade

2k Popularidade

95k Popularidade

27k Popularidade

27k Popularidade

- Pino

34k Popularidade

12k Popularidade

6k Popularidade

16k Popularidade

61k Popularidade

31k Popularidade

2k Popularidade

95k Popularidade

27k Popularidade

27k Popularidade

Novos desenvolvimentos em modelos de bytes grandes: a primeira introdução de posicionamento visual para obter entendimento conjunto multimodal refinado, código aberto e reprodução de demonstração

Fonte original: Qubit

Modelo de byte grande, BuboGPT está aqui.

Ele oferece suporte a três modos de texto, imagem e áudio para obter uma compreensão conjunta multimodal refinada.

Onde responder e o que dizer, o que se diz e o que não se diz, fica claro à primeira vista:

Audio-1-chime-bird-breeze, qubit, 20 segundos

Compreensão conjunta trimodal, descrição do texto + posicionamento da imagem + posicionamento do som, um clique para obtê-lo e determinar com precisão a fonte do som:

Áudio-7-dork-bark, qubit, 6 segundos

Mesmo que não haja relação direta entre áudio e imagens, a possível relação entre os dois pode ser razoavelmente descrita. Também é possível contar histórias olhando para fotos e identificando sons:

Áudio-11-seis-horas, qubit, 1 minuto

Segundo os pesquisadores:

Portanto, quando o BuboGPT descreve a imagem, ele pode apontar a localização específica do objeto na imagem.

BuboGPT: Apresentando a conectividade visual ao LLM pela primeira vez

Além dos exemplos acima compartilhados pelo autor no YouTube, a equipe de pesquisa também demonstrou vários truques do BuboGPT no artigo.

Muito tempo para ver um sapo tocando piano! Esse gráfico BuboGPT também pode descrever com precisão?

Pergunte quais são os lugares interessantes na imagem, e também pode resumir tudo no fundo da imagem.

BuboGPT "teste de visão + audição + expressividade", os pesquisadores jogam assim, vamos ouvir este áudio primeiro.

Audio-9-hair-dryer, qubit, 5 segundos

Vamos dar uma olhada na descrição do BuboGPT:

O efeito é tão bom porque a Byte usou o método de introdução de posicionamento visual no LLM desta vez.

O método específico, então, olhamos para baixo.

A arquitetura do BuboGPT é alcançar a compreensão multimodal aprendendo um espaço semântico compartilhado e explorando ainda mais as relações refinadas entre diferentes objetos visuais e diferentes modalidades.

Para explorar a relação refinada entre diferentes objetos visuais e várias modalidades, os pesquisadores primeiro construíram um pipeline de localização visual pronto com base no SAM.

Este pipeline consiste em três módulos: Módulo de marcação (Módulo de marcação), Módulo de localização (Módulo de aterramento) e Módulo de correspondência de entidade (Módulo de correspondência de entidade).

Primeiro, o módulo de rotulagem é um modelo pré-treinado que pode gerar vários rótulos de texto associados a uma imagem de entrada.

O módulo de localização baseado em SAM localiza ainda mais a máscara semântica ou a caixa delimitadora associada a cada rótulo de texto na imagem.

Em seguida, o módulo de correspondência de entidades utiliza a capacidade de raciocínio do LLM para recuperar entidades correspondentes de rótulos e descrições de imagens.

É assim que os pesquisadores usam a linguagem como uma ponte para conectar objetos visuais a outras modalidades.

Para que a entrada de qualquer combinação dos três modos tenha bons resultados, os pesquisadores adotaram um esquema de treinamento em duas etapas semelhante ao Mini-GTP4:

Pré-treinamento de modalidade única e ajuste de instrução multimodal.

No estágio de pré-treinamento unimodal, a modalidade Q-Former correspondente e as camadas de projeção linear são treinadas em uma grande quantidade de dados emparelhados de texto de modalidade.

Para a percepção visual, treinamos apenas a camada de projeção para a parte de geração da legenda da imagem e mantemos o Q-Former do BLIP2 fixo.

Para a compreensão do áudio, eles treinaram as partes do Q-Former e da geração de legendas de áudio.

Em ambas as configurações sem usar nenhuma dica ( ), o modelo apenas recebe a imagem ou áudio correspondente como entrada e prevê a legenda correspondente (caption).

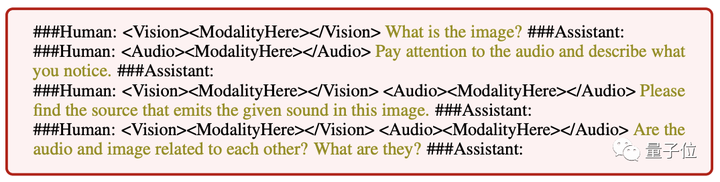

** **###### △ Diferentes instruções de entrada seguem o exemplo

**###### △ Diferentes instruções de entrada seguem o exemplo

No estágio de ajuste de instrução multimodal, um conjunto de dados de instrução multimodal de alta qualidade é construído para ajustar a camada de projeção linear, incluindo:

Vale a pena notar que, ao introduzir amostras negativas "pares imagem-áudio" para correspondência semântica, o BuboGPT pode ser melhor alinhado e a capacidade de compreensão conjunta multimodal é mais forte.

No momento, o código BuboGPT e o conjunto de dados são de código aberto e a demonstração também foi lançada. Vamos experimentá-lo rapidamente.

experiência de jogo superficial de demonstração

A área de funções da página de demonstração do BuboGPT é clara à primeira vista e a operação também é muito simples. Você pode fazer upload de fotos ou áudio no lado direito e a janela de resposta do BuboGPT e a janela de perguntas do usuário no lado esquerdo:

Aqui está outra foto, com um trecho de áudio, e o BuboGPT também corresponde corretamente à fonte de som:

Audio-8-bicycle_bell, qubit, 22 segundos

Portal: [1] [2]