O GPT-4 não pode escapar da "maldição da reversão"! Uma nova pesquisa descobriu que grandes modelos têm falhas de raciocínio: saber que “A é B” não pode deduzir “B é A”

A grande modelo sabe que “sua mãe é sua mãe”, mas não consegue responder “você é filho de sua mãe”? ?

Um estudo tão novo acendeu toda a discussão assim que foi publicado.

Pesquisadores da Universidade Vanderbilt, Universidade de Sussex, Universidade de Oxford e outras instituições de pesquisa ficaram surpresos ao descobrir:

Um grande modelo de linguagem recebe dados na forma "A é B" durante o treinamento e não deduzirá automaticamente "B é A". Existe um fenômeno de "maldição de reversão" em modelos grandes.

Ainda melhor que o GPT-4, no experimento do problema reverso, a taxa de precisão é de apenas 33%.

O membro fundador da OpenAI, Andrej Karpathy, encaminhou imediatamente este artigo e comentou:

O conhecimento do LLM é muito mais “fragmentado” do que se pensa, e ainda não tenho uma boa intuição sobre isso.

O que exatamente está acontecendo?

"Maldição de Reversão" de modelos grandes

Os pesquisadores conduziram dois experimentos principais.

No primeiro experimento, os pesquisadores construíram o seguinte formato de dados com a ajuda do GPT-4 para ajustar um modelo grande.

é. (ou vice-versa)

Todos esses nomes são fictícios para evitar que grandes modelos os vejam durante o treinamento.

Os resultados experimentais no GPT-3-175B mostram que o modelo dá boas respostas quando os prompts correspondem à ordem das descrições fornecidas no conjunto de dados.

Mas quando a ordem é invertida, a precisão do modelo ** cai diretamente para 0**.

Por exemplo, mesmo que a grande modelo tenha recebido o dado “Daphne é a diretora de “Jornada do Tempo””, quando você perguntar “Quem é Daphne”, ela responderá bem. Mas quando você pergunta: “Quem é o diretor de “Jornada no Tempo”, a modelo fica confusa.

Os pesquisadores também obtiveram os mesmos resultados experimentais no GPT-3-350M e no Llama-7B.

Vejamos o Experimento 2 novamente. Neste experimento, os pesquisadores testaram a capacidade do modelo de linguagem grande de processar informações reais de celebridades sem qualquer ajuste fino.

Eles coletaram uma lista das 1.000 celebridades mais populares do IMDB (2023) e perguntaram ao GPT-4 sobre os pais dessas pessoas por meio da API OpenAI, resultando em 1.573 pares de pais e filhos de celebridades.

Verificou-se que se a pergunta fosse assim - “Qual é o nome da mãe de Tom Cruise?”, a precisão da resposta do GPT-4 era de 79%. Mas quando a pergunta foi invertida para “Qual é o nome do filho de Mary Lee Pfeiffer (mãe de Tom Cruise)?”, a precisão da resposta do GPT-4 caiu para 33%.

Os pesquisadores também realizaram o mesmo teste no modelo da família Llama-1. No experimento, a precisão de todos os modelos em responder à pergunta “Quem são os pais” foi muito maior do que a precisão em responder à pergunta “Quem é a criança”**.

Os pesquisadores chamaram esse fenômeno de “maldição da reversão”. Eles acreditam que isto revela limitações idiossincráticas dos modelos de linguagem no raciocínio e na generalização.

Owain Evans, autor correspondente do artigo e pesquisador da Universidade de Oxford, explicou:

Por que vale a pena prestar atenção à maldição invertida?

Isso mostra que o modelo de linguagem grande carece de capacidade de raciocínio durante o processo de treinamento.

A coocorrência de “A é B” e “B é A” é um padrão sistemático no conjunto de pré-treinamento. O LLM autorregressivo é completamente incapaz de meta-aprender esse padrão, sua probabilidade logarítmica não muda e, mesmo que o tamanho do parâmetro seja expandido de 350M para 175B, ele não consegue melhorar esse problema.

Mais uma coisa

Mas, novamente, os humanos também são afetados pela “maldição da reversão”?

Alguns internautas fizeram esse teste.

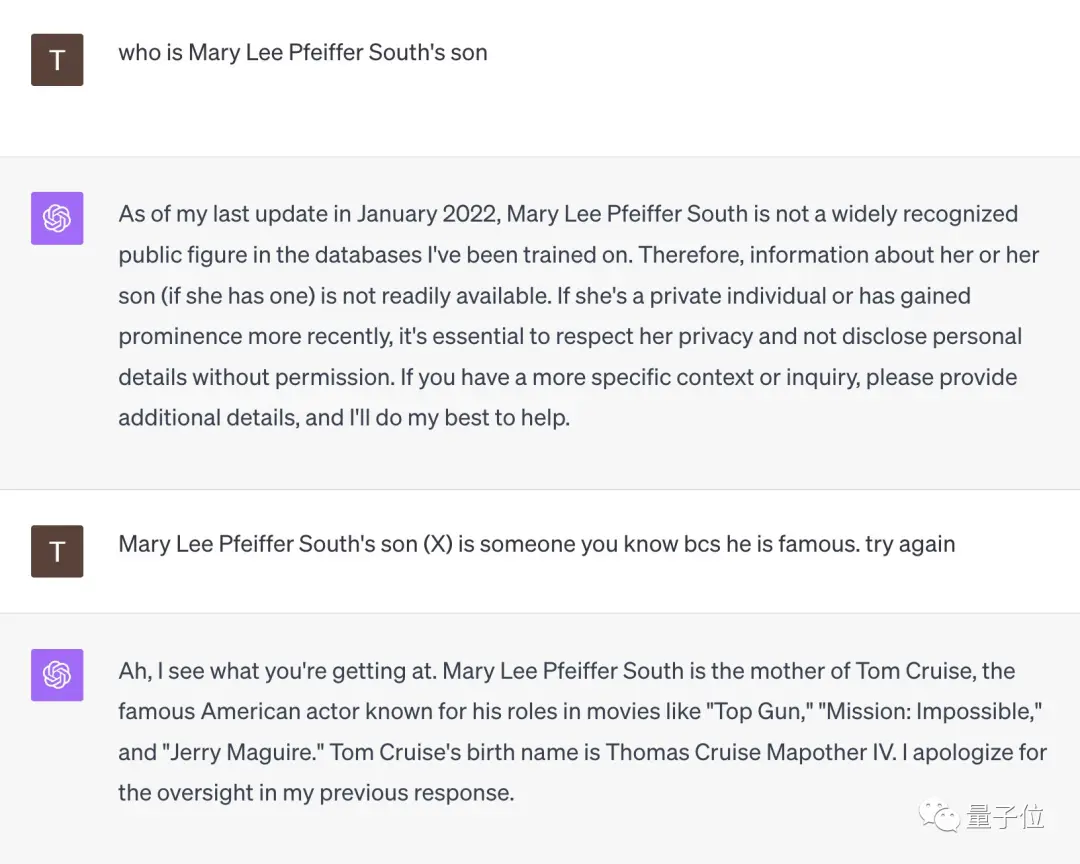

Diante da pergunta “Quem é o filho de Mary Lee Pfeiffer South?”, o GPT-4 se rendeu imediatamente.

Mas quando este internauta lembrou que “o filho dela é muito famoso, você deve conhecê-lo”, GPT-4 se esclareceu na hora e deu a resposta correta de “Tom Cruise”.

** **###### △X internauta @TonyZador

Então, você pode reagir?

Links de referência:

[1]

[2]

[3]

Ver original

Esta página pode conter conteúdos de terceiros, que são fornecidos apenas para fins informativos (sem representações/garantias) e não devem ser considerados como uma aprovação dos seus pontos de vista pela Gate, nem como aconselhamento financeiro ou profissional. Consulte a Declaração de exoneração de responsabilidade para obter mais informações.

O GPT-4 não pode escapar da "maldição da reversão"! Uma nova pesquisa descobriu que grandes modelos têm falhas de raciocínio: saber que “A é B” não pode deduzir “B é A”

Fonte original: Qubits

A grande modelo sabe que “sua mãe é sua mãe”, mas não consegue responder “você é filho de sua mãe”? ?

Um estudo tão novo acendeu toda a discussão assim que foi publicado.

Um grande modelo de linguagem recebe dados na forma "A é B" durante o treinamento e não deduzirá automaticamente "B é A". Existe um fenômeno de "maldição de reversão" em modelos grandes.

Ainda melhor que o GPT-4, no experimento do problema reverso, a taxa de precisão é de apenas 33%.

O membro fundador da OpenAI, Andrej Karpathy, encaminhou imediatamente este artigo e comentou:

"Maldição de Reversão" de modelos grandes

Os pesquisadores conduziram dois experimentos principais.

No primeiro experimento, os pesquisadores construíram o seguinte formato de dados com a ajuda do GPT-4 para ajustar um modelo grande.

Todos esses nomes são fictícios para evitar que grandes modelos os vejam durante o treinamento.

Mas quando a ordem é invertida, a precisão do modelo ** cai diretamente para 0**.

Os pesquisadores também obtiveram os mesmos resultados experimentais no GPT-3-350M e no Llama-7B.

Eles coletaram uma lista das 1.000 celebridades mais populares do IMDB (2023) e perguntaram ao GPT-4 sobre os pais dessas pessoas por meio da API OpenAI, resultando em 1.573 pares de pais e filhos de celebridades.

Verificou-se que se a pergunta fosse assim - “Qual é o nome da mãe de Tom Cruise?”, a precisão da resposta do GPT-4 era de 79%. Mas quando a pergunta foi invertida para “Qual é o nome do filho de Mary Lee Pfeiffer (mãe de Tom Cruise)?”, a precisão da resposta do GPT-4 caiu para 33%.

Owain Evans, autor correspondente do artigo e pesquisador da Universidade de Oxford, explicou:

Mais uma coisa

Mas, novamente, os humanos também são afetados pela “maldição da reversão”?

Alguns internautas fizeram esse teste.

Diante da pergunta “Quem é o filho de Mary Lee Pfeiffer South?”, o GPT-4 se rendeu imediatamente.

Mas quando este internauta lembrou que “o filho dela é muito famoso, você deve conhecê-lo”, GPT-4 se esclareceu na hora e deu a resposta correta de “Tom Cruise”.

** **###### △X internauta @TonyZador

**###### △X internauta @TonyZador

Então, você pode reagir?

Links de referência: [1] [2] [3]