- Тема

34k Популярность

12k Популярность

6k Популярность

16k Популярность

61k Популярность

31k Популярность

2k Популярность

95k Популярность

27k Популярность

27k Популярность

- Закрепить

34k Популярность

12k Популярность

6k Популярность

16k Популярность

61k Популярность

31k Популярность

2k Популярность

95k Популярность

27k Популярность

27k Популярность

Новые разработки в моделях больших байтов: первое введение визуального позиционирования для достижения детального мультимодального совместного понимания, открытый исходный код и демо-игра

Первоисточник: Кубит

Модель большого байта, BuboGPT здесь.

Поддерживает три режима текста, изображения и звука для достижения детального мультимодального совместного понимания.

Где отвечать и что говорить, что сказано и что не сказано, понятно с первого взгляда:

Audio-1-chime-bird-breeze, кубит, 20 секунд

Трехмодальное совместное понимание, текстовое описание + позиционирование изображения + позиционирование звука, один щелчок, чтобы получить его, и точно определить источник звука:

Аудио-7-дорк-барк, кубит, 6 секунд

Даже если нет прямой связи между звуком и изображением, возможную связь между ними можно разумно описать.Также можно рассказывать истории, глядя на картинки и идентифицируя звуки:

Аудио-11-6 часов, кубит, 1 минута

По мнению исследователей:

Поэтому, когда BuboGPT описывает изображение, он может указать конкретное местонахождение объекта на картинке.

BuboGPT: впервые визуальная связь с LLM

В дополнение к приведенным выше примерам, опубликованным автором на YouTube, исследовательская группа также продемонстрировала в статье различные трюки BuboGPT.

Давно пора увидеть лягушку, играющую на пианино! Можно ли точно описать такой граф BuboGPT?

Спросите его, какие интересные места есть на картинке, и он также может обобщить все, что находится на заднем плане картины.

BuboGPT «тест на зрение + слух + выразительность», исследователи обыгрывают его так, давайте сначала послушаем этот звук.

Аудио-9-фен, кубит, 5 секунд

Давайте посмотрим на описание BuboGPT:

Эффект настолько хорош, потому что Byte на этот раз использовал метод введения визуального позиционирования в LLM.

Конкретный метод мы затем смотрим вниз.

Архитектура BuboGPT предназначена для достижения мультимодального понимания путем изучения общего семантического пространства и дальнейшего изучения тонких взаимосвязей между различными визуальными объектами и различными модальностями.

Для того чтобы изучить детализированную взаимосвязь между различными визуальными объектами и различными модальностями, исследователи сначала создали готовый конвейер визуальной локализации на основе SAM.

Этот конвейер состоит из трех модулей: Модуль тегирования (модуль тегирования), Модуль местоположения (модуль заземления) и Модуль сопоставления объектов (модуль сопоставления объектов).

Во-первых, модуль маркировки представляет собой предварительно обученную модель, которая может генерировать несколько текстовых меток, связанных с входным изображением.

Модуль локализации на основе SAM дополнительно локализует семантическую маску или ограничивающую рамку, связанную с каждой текстовой меткой на изображении.

Затем модуль сопоставления сущностей использует способность рассуждений LLM для извлечения совпавших сущностей из меток и описаний изображений.

Именно так исследователи используют язык в качестве моста для соединения визуальных объектов с другими модальностями.

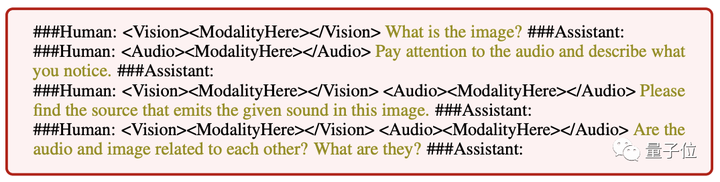

Чтобы ввод любой комбинации трех режимов дал хорошие результаты, исследователи приняли двухэтапную схему обучения, аналогичную Mini-GTP4:

Одномодальная предварительная подготовка и многомодальная корректировка инструкций.

На этапе унимодальной предварительной подготовки соответствующий Q-Former модальности и слои линейной проекции обучаются на большом количестве парных данных модальность-текст.

Для визуального восприятия мы тренируем проекционный слой только для части генерации подписи к изображению и оставляем фиксированным Q-Former из BLIP2.

Для понимания звука они обучили как Q-Former, так и части генерации аудиозаголовков.

В обеих настройках без использования каких-либо подсказок ( ) модель просто получает на вход соответствующее изображение или звук и предсказывает соответствующую подпись (caption).

** **###### △ Различные инструкции ввода следуют примеру

**###### △ Различные инструкции ввода следуют примеру

На этапе настройки мультимодальных инструкций создается высококачественный набор данных мультимодальных инструкций для точной настройки уровня линейной проекции, включая:

Стоит отметить, что, вводя отрицательные образцы «пары изображение-аудио» для семантического сопоставления, BuboGPT может быть лучше выровнен, и способность мультимодального совместного понимания становится сильнее.

В настоящее время код и набор данных BuboGPT находятся в открытом доступе, а также выпущена демоверсия. Давайте быстро попробуем.

демонстрация неглубокой игры

Функциональная область демонстрационной страницы BuboGPT понятна с первого взгляда, и операция также очень проста.Вы можете загружать изображения или аудио с правой стороны, а окно ответа BuboGPT и окно вопроса пользователя с левой стороны:

Вот еще одна картинка, с кусочком аудио, и BuboGPT тоже правильно соответствует источнику звука:

Аудио-8-велосипед_колокол, кубит, 22 секунды

Портал: [1] [2]