Большая модель знает: «Твоя мать — это твоя мать», но не может ответить: «Ты сын своей матери»? ?

Такое новое исследование вызвало всю дискуссию, как только оно было опубликовано.

Исследователи из Университета Вандербильта, Университета Сассекса, Оксфордского университета и других исследовательских институтов были удивлены, обнаружив:

В большую языковую модель во время обучения подаются данные в форме «A есть B», и она не делает автоматический вывод «B есть A». В больших моделях существует явление «обратного проклятия».

Даже лучше, чем GPT-4, в эксперименте с обратной задачей точность составляет всего 33%.

Член-основатель OpenAI Андрей Карпати немедленно переслал эту статью и прокомментировал:

Знания LLM гораздо более «фрагментированы», чем думают люди, и у меня до сих пор нет хорошего представления об этом.

Что именно происходит?

"Проклятие обращения" больших моделей

Исследователи провели два основных эксперимента.

В первом эксперименте исследователи с помощью GPT-4 создали следующую форму данных для точной настройки большой модели.

есть (или наоборот)

Все эти имена вымышлены, чтобы крупные модели не увидели их во время тренировок.

Результаты экспериментов на GPT-3-175B показывают, что модель дает хорошие ответы, когда подсказки соответствуют порядку описаний, приведенных в наборе данных.

Но когда порядок меняется на обратный, точность модели ** даже падает сразу до 0**.

Например, даже если большая модель получила данные «Дафна — режиссер «Путешествия во времени»», на вопрос «Кто такая Дафна?» она может ответить хорошо. Но когда вы в свою очередь спрашиваете: «Кто режиссер «Путешествия во времени», модель приходит в замешательство.

Такие же экспериментальные результаты исследователи получили и на ГПТ-3-350М и Ламе-7Б.

Давайте еще раз посмотрим на Эксперимент 2. В этом эксперименте исследователи проверили способность большой языковой модели обратно обрабатывать реальную информацию о знаменитостях без какой-либо тонкой настройки.

Они собрали список из 1000 самых популярных знаменитостей из IMDB (2023 г.) и запросили GPT-4 о родителях этих людей через API OpenAI, в результате чего было получено 1573 пары детей и родителей знаменитостей.

Выяснилось, что если вопрос был такой: «Как зовут мать Тома Круза?», точность ответа GPT-4 составила 79%. Но когда вопрос был изменен на «Как зовут сына Мэри Ли Пфайффер (матери Тома Круза)?», точность ответа GPT-4 упала до 33%.

Исследователи также провели тот же тест на модели семейства Llama-1. В эксперименте точность всех моделей в ответе на вопрос «Кто родители» оказалась значительно выше точности ответа на вопрос «Кто ребенок»**.

Исследователи назвали это явление «проклятием обращения». Они считают, что это раскрывает идиосинкразические ограничения языковых моделей в рассуждениях и обобщениях.

Оуайн Эванс, автор статьи и исследователь Оксфордского университета, объяснил:

Почему на «Обратное проклятие» стоит обратить внимание?

Это показывает, что модель большого языка не обладает способностью к рассуждению в процессе обучения.

Совместное появление фраз «A есть B» и «B есть A» является систематической закономерностью в предварительном обучающем наборе. Авторегрессионный LLM совершенно не способен мета-обучить этот шаблон, его логарифмическая вероятность не меняется, и даже если размер параметра увеличить с 350 МБ до 175 Б, он не сможет решить эту проблему.

Еще кое-что

Но опять же, затронуты ли люди также «обратным проклятием»?

Некоторые пользователи сети провели такой тест.

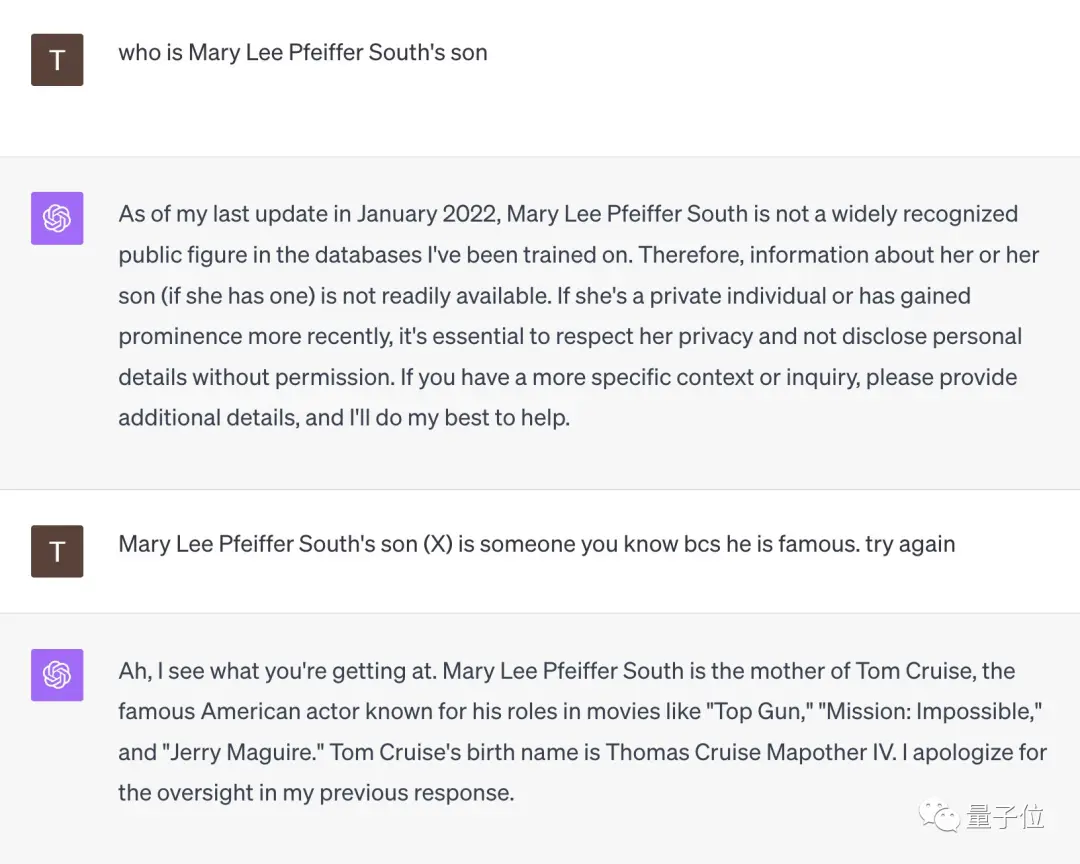

Столкнувшись с вопросом «Кто сын Мэри Ли Пфайффер Саут?», GPT-4 немедленно сдался.

Но когда этот пользователь сети напомнил ей, что «ее сын очень известен, вы должны его знать», GPT-4 тут же просветился и дал правильный ответ: «Том Круз».

** **###### △X пользователей сети @TonyZador

Итак, вы можете отреагировать?

Справочные ссылки:

[1]

[2]

[3]

Посмотреть Оригинал

На этой странице может содержаться сторонний контент, который предоставляется исключительно в информационных целях (не в качестве заявлений/гарантий) и не должен рассматриваться как поддержка взглядов компании Gate или как финансовый или профессиональный совет. Подробности смотрите в разделе «Отказ от ответственности» .

GPT-4 не может избежать «проклятия разворота»! Новое исследование показывает, что у больших моделей есть недостатки в рассуждении.

Первоисточник: Кубиты

Большая модель знает: «Твоя мать — это твоя мать», но не может ответить: «Ты сын своей матери»? ?

Такое новое исследование вызвало всю дискуссию, как только оно было опубликовано.

В большую языковую модель во время обучения подаются данные в форме «A есть B», и она не делает автоматический вывод «B есть A». В больших моделях существует явление «обратного проклятия».

Даже лучше, чем GPT-4, в эксперименте с обратной задачей точность составляет всего 33%.

Член-основатель OpenAI Андрей Карпати немедленно переслал эту статью и прокомментировал:

"Проклятие обращения" больших моделей

Исследователи провели два основных эксперимента.

В первом эксперименте исследователи с помощью GPT-4 создали следующую форму данных для точной настройки большой модели.

Все эти имена вымышлены, чтобы крупные модели не увидели их во время тренировок.

Но когда порядок меняется на обратный, точность модели ** даже падает сразу до 0**.

Такие же экспериментальные результаты исследователи получили и на ГПТ-3-350М и Ламе-7Б.

Они собрали список из 1000 самых популярных знаменитостей из IMDB (2023 г.) и запросили GPT-4 о родителях этих людей через API OpenAI, в результате чего было получено 1573 пары детей и родителей знаменитостей.

Выяснилось, что если вопрос был такой: «Как зовут мать Тома Круза?», точность ответа GPT-4 составила 79%. Но когда вопрос был изменен на «Как зовут сына Мэри Ли Пфайффер (матери Тома Круза)?», точность ответа GPT-4 упала до 33%.

Оуайн Эванс, автор статьи и исследователь Оксфордского университета, объяснил:

Еще кое-что

Но опять же, затронуты ли люди также «обратным проклятием»?

Некоторые пользователи сети провели такой тест.

Столкнувшись с вопросом «Кто сын Мэри Ли Пфайффер Саут?», GPT-4 немедленно сдался.

Но когда этот пользователь сети напомнил ей, что «ее сын очень известен, вы должны его знать», GPT-4 тут же просветился и дал правильный ответ: «Том Круз».

** **###### △X пользователей сети @TonyZador

**###### △X пользователей сети @TonyZador

Итак, вы можете отреагировать?

Справочные ссылки: [1] [2] [3]