- Тема

34k Популярність

12k Популярність

6k Популярність

16k Популярність

61k Популярність

31k Популярність

2k Популярність

95k Популярність

27k Популярність

27k Популярність

- Закріпити

34k Популярність

12k Популярність

6k Популярність

16k Популярність

61k Популярність

31k Популярність

2k Популярність

95k Популярність

27k Популярність

27k Популярність

Нові розробки у великих байтових моделях: перше представлення візуального позиціонування для досягнення детального мультимодального спільного розуміння, відкритий вихідний код і відтворення в демонстраційних версіях

Перше джерело: Qubit

Велика байтова модель BuboGPT тут.

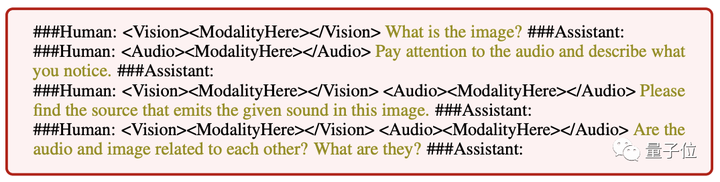

Підтримує три режими тексту, зображення та аудіо для досягнення точного мультимодального спільного розуміння.

Де відповісти і що сказати, що сказано і що не сказано, зрозуміло з першого погляду:

Audio-1-chime-bird-breeze, кубіт, 20 секунд

Тримодальне спільне розуміння, опис тексту + позиціонування зображення + позиціонування звуку, отримати його в один клік і точно визначити джерело звуку:

Audio-7-dork-bark, кубіт, 6 секунд

Навіть якщо немає прямого зв’язку між аудіо та зображеннями, можливий зв’язок між ними можна розумно описати.Також можна розповідати історії, дивлячись на зображення та визначаючи звуки:

Аудіо-11-шість годин, кубіт, 1 хвилина

За словами дослідників:

Тому, коли BuboGPT описує зображення, він може вказати конкретне розташування об’єкта на зображенні.

BuboGPT: вперше представлено візуальне підключення до LLM

Окрім наведених вище прикладів, якими автор поділився на YouTube, дослідницька група також продемонструвала різні трюки BuboGPT у статті.

Давно бачив жабу, що грає на піаніно! Чи може такий графік BuboGPT також точно описати?

Запитайте його, які цікаві місця на малюнку, і він також може підсумувати все на задньому плані зображення.

BuboGPT «тест на зір + слух + експресивність», дослідники відтворюють його так, давайте спочатку послухаємо це аудіо.

Аудіо-9-фен, кубіт, 5 секунд

Давайте подивимося на опис BuboGPT:

Ефект настільки хороший, тому що Byte цього разу використав метод впровадження візуального позиціонування в LLM.

Конкретний метод ми дивимося вниз.

Архітектура BuboGPT полягає в досягненні мультимодального розуміння шляхом вивчення спільного семантичного простору та подальшого вивчення тонких зв’язків між різними візуальними об’єктами та різними модальностями.

Для того, щоб дослідити дрібнозернистий зв’язок між різними візуальними об’єктами та різними модальностями, дослідники спочатку створили готовий конвеєр візуальної локалізації на основі SAM.

Цей конвеєр складається з трьох модулів: Модуль тегів (Модуль тегів), Модуль розташування (Модуль заземлення) і Модуль зіставлення сутностей (Модуль зіставлення сутностей).

По-перше, модуль міток — це попередньо навчена модель, яка може генерувати кілька текстових міток, пов’язаних із вхідним зображенням.

Модуль локалізації на основі SAM додатково локалізує семантичну маску або обмежувальну рамку, пов’язану з кожною текстовою міткою на зображенні.

Потім модуль зіставлення сутностей використовує здатність аргументації LLM для отримання відповідних сутностей із міток і описів зображень.

Ось як дослідники використовують мову як міст для зв’язку візуальних об’єктів з іншими модальностями.

Для того, щоб введення будь-якої комбінації з трьох режимів давало хороші результати, дослідники застосували двоетапну схему навчання, подібну до Mini-GTP4:

Однорежимне попереднє навчання та адаптація мультимодального навчання.

На унімодальному етапі попереднього навчання відповідний Q-Former модальності та шари лінійної проекції навчаються на великій кількості даних, що поєднуються модальність-текст.

Для візуального сприйняття ми лише навчаємо проекційний шар для частини генерації підписів до зображень і залишаємо Q-Former від BLIP2 фіксованим.

Для розуміння аудіо вони навчили як Q-Former, так і частини створення аудіотитрів.

В обох налаштуваннях без використання будь-яких підказок ( ) модель просто отримує відповідне зображення або аудіо як вхідні дані та передбачає відповідний заголовок (підпис).

** **###### △ Дотримуйтеся прикладу іншої інструкції введення

**###### △ Дотримуйтеся прикладу іншої інструкції введення

На етапі коригування мультимодальних інструкцій створюється високоякісний набір даних мультимодальних інструкцій для точного налаштування рівня лінійної проекції, включаючи:

Варто зазначити, що шляхом введення негативних зразків «пари зображення-аудіо» для семантичної відповідності BuboGPT можна краще узгодити, а здатність спільного мультимодального розуміння стає сильнішою.

Наразі код і набір даних BuboGPT є відкритими, а також випущено демонстрацію. Давайте швидко спробуємо.

демонстраційний досвід неглибокої гри

Функціональна область демонстраційної сторінки BuboGPT зрозуміла з першого погляду, а операція також дуже проста.Ви можете завантажити зображення або аудіо з правого боку, а вікно відповідей BuboGPT і вікно запитань користувача зліва:

Ось ще одне зображення з аудіо, і BuboGPT також правильно відповідає джерелу звуку:

Audio-8-bicycle_bell, кубіт, 22 секунди

Портал: [1] [2]