GPT-4 не може уникнути «прокляття перевороту»! Нове дослідження виявило, що великі моделі мають недоліки міркування. Знаючи, що «А є Б», неможливо зробити висновок, що «В є А»

Велика модель знає: «Твоя мама — це твоя мама», але не може відповісти: «Ти — син твоєї мами»? ?

Таке нове дослідження розпалило всю дискусію, щойно було опубліковано.

Дослідники з Університету Вандербільта, Університету Сассекса, Оксфордського університету та інших дослідницьких установ були здивовані, виявивши:

Велика мовна модель отримує дані у формі «А є В» під час навчання, і вона не буде автоматично виводити «В є А». У великих моделях існує феномен "зворотного прокляття".

Навіть краще, ніж GPT-4, в експерименті зі зворотною задачею показник точності становить лише 33%.

Засновник OpenAI Андрій Карпаті негайно переслав цей документ і прокоментував:

Знання LLM набагато більш «фрагментовані», ніж думають люди, і я досі не маю доброї інтуїції щодо цього.

Що саме відбувається?

"Зворотне прокляття" великих моделей

Дослідники провели два основних експерименти.

У першому експерименті дослідники побудували наступну форму даних за допомогою GPT-4 для точного налаштування великої моделі.

це . (або навпаки)

Усі ці імена є вигаданими, щоб великі моделі не бачили їх під час тренувань.

Експериментальні результати на GPT-3-175B показують, що модель дає хороші відповіді, коли підказки відповідають порядку описів, наведеному в наборі даних.

Але коли порядок змінюється, точність моделі ** навіть падає прямо до 0**.

Наприклад, навіть якщо велика модель отримала дані «Дафна — режисер фільму «Подорож у часі»», коли ви запитаєте її «Хто така Дафна?», вона може добре відповісти. Але коли ви по черзі запитуєте: «Хто режисер «Подорожі в часі», модель розгублена.

Дослідники також отримали такі ж експериментальні результати на GPT-3-350M і Llama-7B.

Давайте знову подивимося на експеримент 2. У цьому експерименті дослідники перевірили здатність великої мовної моделі обробляти реальну інформацію про знаменитостей без будь-яких тонких налаштувань.

Вони зібрали список із 1000 найпопулярніших знаменитостей на сайті IMDB (2023) і запитали GPT-4 про батьків цих людей через OpenAI API, у результаті чого було отримано 1573 пари «діти-батьки» знаменитостей.

З’ясувалося, що якщо питання було таким – «Як звуть маму Тома Круза?», то точність відповіді GPT-4 становила 79%. Але коли запитання змінили на «Як звуть сина Мері Лі Пфайффер (матері Тома Круза)?», точність відповіді GPT-4 впала до 33%.

Дослідники також провели такий же тест на моделі сімейства Llama-1. В експерименті точність відповіді всіх моделей на запитання «Хто батьки» була значно вищою, ніж точність відповіді на запитання «Хто така дитина»**.

Дослідники назвали це явище «переворотним прокляттям». Вони вважають, що це виявляє ідіосинкратичні обмеження мовних моделей у міркуванні та узагальненні.

Оуайн Еванс, автор-кореспондент статті та дослідник Оксфордського університету, пояснив:

Чому варто звернути увагу на Перевернуте прокляття?

Це показує, що велика мовна модель не має здатності міркувати під час процесу навчання.

Співвідношення «А є В» і «В є А» є систематичною схемою в попередньому тренінгу. Авторегресійний LLM абсолютно не в змозі метавивчити цей шаблон, його логарифмічна ймовірність не змінюється, і навіть якщо розмір параметра розширюється з 350M до 175B, він не може вирішити цю проблему.

І ще одна річ

Але знову ж таки, чи на людей також впливає «прокляття зворотного зв’язку»?

Деякі користувачі мережі зробили такий тест.

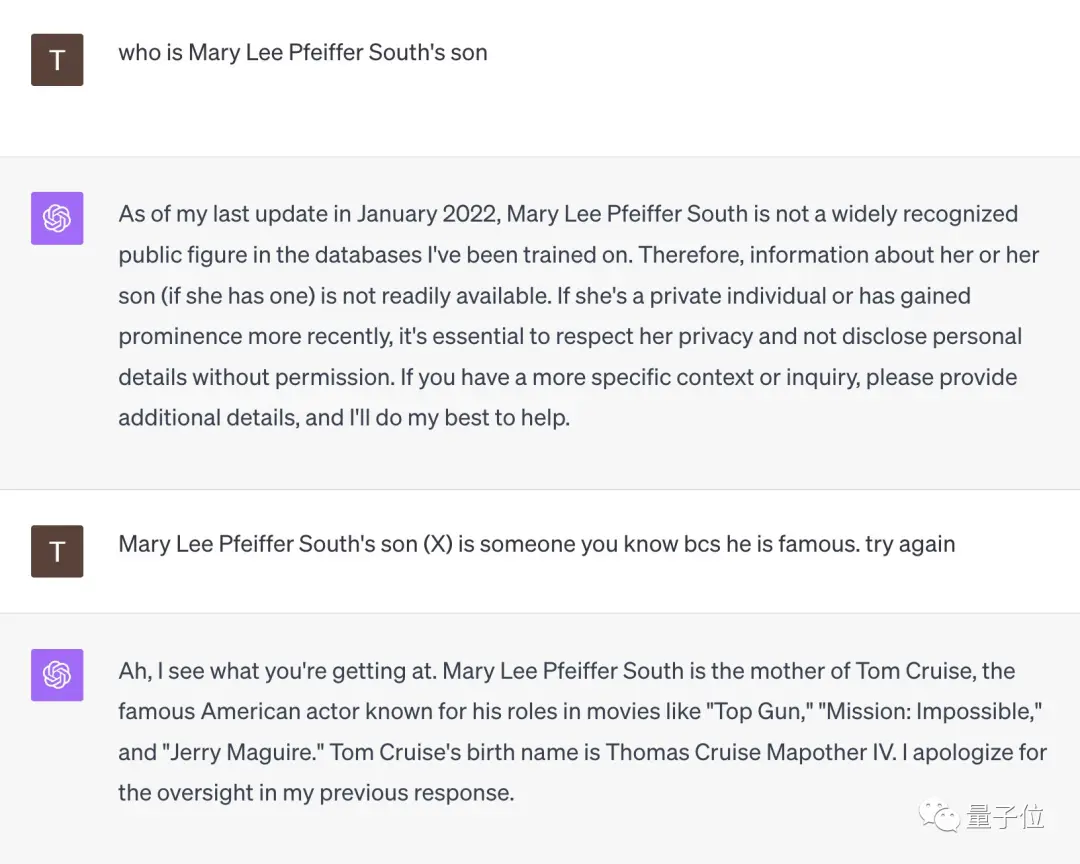

Зіткнувшись із запитанням «Хто син Мері Лі Пфайфер Саут?», GPT-4 негайно здався.

Але коли цей користувач мережі нагадав їй, що «її син дуже відомий, ви повинні його знати», GPT-4 відразу осяяла і дала правильну відповідь «Том Круз».

** **###### △X користувач мережі @TonyZador

Отже, ви можете відреагувати?

Довідкові посилання:

[1]

[2]

[3]

Переглянути оригінал

Ця сторінка може містити контент третіх осіб, який надається виключно в інформаційних цілях (не в якості запевнень/гарантій) і не повинен розглядатися як схвалення його поглядів компанією Gate, а також як фінансова або професійна консультація. Див. Застереження для отримання детальної інформації.

GPT-4 не може уникнути «прокляття перевороту»! Нове дослідження виявило, що великі моделі мають недоліки міркування. Знаючи, що «А є Б», неможливо зробити висновок, що «В є А»

Оригінальне джерело: Qubits

Велика модель знає: «Твоя мама — це твоя мама», але не може відповісти: «Ти — син твоєї мами»? ?

Таке нове дослідження розпалило всю дискусію, щойно було опубліковано.

Велика мовна модель отримує дані у формі «А є В» під час навчання, і вона не буде автоматично виводити «В є А». У великих моделях існує феномен "зворотного прокляття".

Навіть краще, ніж GPT-4, в експерименті зі зворотною задачею показник точності становить лише 33%.

Засновник OpenAI Андрій Карпаті негайно переслав цей документ і прокоментував:

"Зворотне прокляття" великих моделей

Дослідники провели два основних експерименти.

У першому експерименті дослідники побудували наступну форму даних за допомогою GPT-4 для точного налаштування великої моделі.

Усі ці імена є вигаданими, щоб великі моделі не бачили їх під час тренувань.

Але коли порядок змінюється, точність моделі ** навіть падає прямо до 0**.

Дослідники також отримали такі ж експериментальні результати на GPT-3-350M і Llama-7B.

Вони зібрали список із 1000 найпопулярніших знаменитостей на сайті IMDB (2023) і запитали GPT-4 про батьків цих людей через OpenAI API, у результаті чого було отримано 1573 пари «діти-батьки» знаменитостей.

З’ясувалося, що якщо питання було таким – «Як звуть маму Тома Круза?», то точність відповіді GPT-4 становила 79%. Але коли запитання змінили на «Як звуть сина Мері Лі Пфайффер (матері Тома Круза)?», точність відповіді GPT-4 впала до 33%.

Оуайн Еванс, автор-кореспондент статті та дослідник Оксфордського університету, пояснив:

І ще одна річ

Але знову ж таки, чи на людей також впливає «прокляття зворотного зв’язку»?

Деякі користувачі мережі зробили такий тест.

Зіткнувшись із запитанням «Хто син Мері Лі Пфайфер Саут?», GPT-4 негайно здався.

Але коли цей користувач мережі нагадав їй, що «її син дуже відомий, ви повинні його знати», GPT-4 відразу осяяла і дала правильну відповідь «Том Круз».

** **###### △X користувач мережі @TonyZador

**###### △X користувач мережі @TonyZador

Отже, ви можете відреагувати?

Довідкові посилання: [1] [2] [3]