- Chủ đề

34k Phổ biến

12k Phổ biến

6k Phổ biến

16k Phổ biến

61k Phổ biến

31k Phổ biến

2k Phổ biến

95k Phổ biến

27k Phổ biến

27k Phổ biến

- Ghim

34k Phổ biến

12k Phổ biến

6k Phổ biến

16k Phổ biến

61k Phổ biến

31k Phổ biến

2k Phổ biến

95k Phổ biến

27k Phổ biến

27k Phổ biến

Những phát triển mới trong các mô hình byte lớn: lần đầu tiên giới thiệu định vị trực quan để đạt được sự hiểu biết chung đa phương thức chi tiết, mã nguồn mở và bản demo có thể chơi được

Nguồn gốc: Qubit

Mô hình byte lớn, BuboGPT ở đây.

Hỗ trợ ba chế độ văn bản, hình ảnh và âm thanh để đạt được sự hiểu biết chung đa phương thức chi tiết.

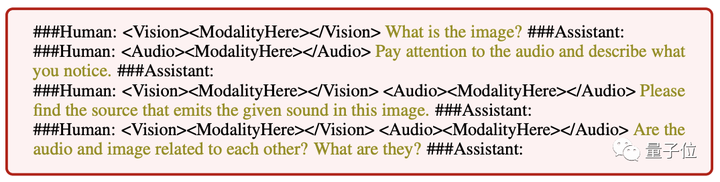

Trả lời ở đâu và nói gì, nói gì và không nói gì, chỉ cần nhìn thoáng qua là rõ ràng:

Audio-1-chime-bird-breeze, qubit, 20 giây

Hiểu khớp ba phương thức, mô tả văn bản + định vị hình ảnh + định vị âm thanh, một cú nhấp chuột để lấy nó và xác định chính xác nguồn âm thanh:

Audio-7-dork-bark, qubit, 6 giây

Ngay cả khi không có mối quan hệ trực tiếp giữa âm thanh và hình ảnh, mối quan hệ có thể có giữa hai điều này có thể được mô tả một cách hợp lý. Cũng có thể kể chuyện bằng cách nhìn vào hình ảnh và xác định âm thanh:

Âm thanh-11-sáu giờ, qubit, 1 phút

Theo các nhà nghiên cứu:

Do đó, khi BuboGPT mô tả hình ảnh, nó có thể chỉ ra vị trí cụ thể của đối tượng trong hình.

BuboGPT: Lần đầu tiên giới thiệu kết nối hình ảnh với LLM

Ngoài các ví dụ trên được tác giả chia sẻ trên YouTube, nhóm nghiên cứu cũng trình diễn nhiều thủ thuật khác nhau của BuboGPT trong bài báo.

Lâu lắm mới thấy một chú ếch chơi piano! Một biểu đồ như vậy BuboGPT cũng có thể mô tả chính xác?

Hãy hỏi nó những địa điểm thú vị trong bức tranh, và nó cũng có thể tóm tắt mọi thứ trong nền của bức tranh.

BuboGPT "kiểm tra thị lực + thính giác + biểu cảm", các nhà nghiên cứu chơi nó như thế này, chúng ta hãy nghe đoạn âm thanh này trước.

Âm thanh-9-máy sấy tóc, qubit, 5 giây

Hãy cùng xem mô tả về BuboGPT:

Hiệu quả tốt như vậy là do lần này Byte đã sử dụng phương pháp đưa định vị trực quan vào LLM.

Các phương pháp cụ thể sau đó chúng tôi nhìn xuống.

Kiến trúc của BuboGPT là để đạt được sự hiểu biết đa phương thức bằng cách tìm hiểu một không gian ngữ nghĩa được chia sẻ và khám phá thêm các mối quan hệ chi tiết giữa các đối tượng hình ảnh khác nhau và các phương thức khác nhau.

Để khám phá mối quan hệ chi tiết giữa các đối tượng trực quan khác nhau và các phương thức khác nhau, trước tiên, các nhà nghiên cứu đã xây dựng một quy trình bản địa hóa trực quan được tạo sẵn dựa trên SAM.

Quy trình này bao gồm ba mô-đun: Mô-đun gắn thẻ (Mô-đun gắn thẻ), Mô-đun vị trí (Mô-đun tiếp đất) và Mô-đun khớp thực thể (Mô-đun khớp thực thể).

Đầu tiên, mô-đun ghi nhãn là một mô hình được đào tạo trước có thể tạo nhiều nhãn văn bản được liên kết với một hình ảnh đầu vào.

Mô-đun bản địa hóa dựa trên SAM bản địa hóa thêm mặt nạ ngữ nghĩa hoặc hộp giới hạn được liên kết với từng nhãn văn bản trên hình ảnh.

Sau đó, mô-đun đối sánh thực thể sử dụng khả năng lập luận của LLM để truy xuất các đối tượng phù hợp từ nhãn và mô tả hình ảnh.

Đây là cách các nhà nghiên cứu sử dụng ngôn ngữ làm cầu nối để kết nối các đối tượng trực quan với các phương thức khác.

Để làm cho đầu vào của bất kỳ sự kết hợp nào trong ba chế độ đều có kết quả tốt, các nhà nghiên cứu đã áp dụng sơ đồ đào tạo hai giai đoạn tương tự như Mini-GTP4:

Điều chỉnh hướng dẫn đào tạo trước đơn phương thức và đa phương thức.

Trong giai đoạn đào tạo trước không theo phương thức, lớp Q-Former và phép chiếu tuyến tính của phương thức tương ứng được đào tạo trên một lượng lớn dữ liệu được ghép nối giữa văn bản và phương thức.

Đối với nhận thức trực quan, chúng tôi chỉ đào tạo lớp chiếu cho phần tạo chú thích hình ảnh và giữ cố định Q-Former từ BLIP2.

Để hiểu âm thanh, họ đã đào tạo cả Q-Former và phần tạo phụ đề âm thanh.

Trong cả hai cài đặt không sử dụng bất kỳ gợi ý nào ( ), mô hình chỉ nhận hình ảnh hoặc âm thanh tương ứng làm đầu vào và dự đoán chú thích (caption) tương ứng.

** **###### △ Hướng dẫn đầu vào khác nhau làm theo ví dụ

**###### △ Hướng dẫn đầu vào khác nhau làm theo ví dụ

Trong giai đoạn điều chỉnh hướng dẫn đa phương thức, bộ dữ liệu hướng dẫn đa phương thức chất lượng cao được xây dựng để tinh chỉnh lớp chiếu tuyến tính, bao gồm:

Điều đáng chú ý là bằng cách giới thiệu các mẫu âm thanh "cặp hình ảnh-âm thanh" để khớp ngữ nghĩa, BuboGPT có thể được căn chỉnh tốt hơn và khả năng hiểu khớp đa phương thức mạnh hơn.

Hiện tại bộ mã và dữ liệu BuboGPT đã được mã nguồn mở và bản demo cũng đã được phát hành, hãy nhanh chóng dùng thử.

trải nghiệm chơi thử demo

Nhìn thoáng qua khu vực chức năng của trang demo BuboGPT rõ ràng và thao tác cũng rất đơn giản, bạn có thể tải lên hình ảnh hoặc âm thanh ở bên phải và cửa sổ câu trả lời BuboGPT và cửa sổ câu hỏi của người dùng ở bên trái:

Đây là một hình ảnh khác, với một đoạn âm thanh và BuboGPT cũng khớp chính xác với nguồn âm thanh:

Audio-8-bicycle_bell, qubit, 22 giây

Cổng thông tin: [1] [2]