- 話題

33368 熱度

146 熱度

202 熱度

15799 熱度

4939 熱度

1775 熱度

94700 熱度

26631 熱度

26776 熱度

- 10美加徵關稅

17199 熱度

- 置頂

- 穩健,是 Gate 持續增長的核心動力。

真正的成長,不是順風順水,而是在市場低迷時依然堅定前行。我們或許能預判牛熊市的大致節奏,但絕無法精準預測它們何時到來。特別是在熊市週期,才真正考驗一家交易所的實力。

Gate 今天發布了2025年第二季度的報告。作爲內部人,看到這些數據我也挺驚喜的——用戶規模突破3000萬,現貨交易量逆勢環比增長14%,成爲前十交易所中唯一實現雙位數增長的平台,並且登頂全球第二大交易所;合約交易量屢創新高,全球化戰略穩步推進。

更重要的是,穩健並不等於守成,而是在面臨嚴峻市場的同時,還能持續創造新的增長空間。

歡迎閱讀完整報告:https://www.gate.com/zh/announcements/article/46117 - 📢 Gate廣場 #创作者活动第一期# 火熱開啓,助力 PUMP 公募上線!

Solana 爆火項目 Pump.Fun($PUMP)現已登入 Gate 平台開啓公開發售!

參與 Gate廣場創作者活動,釋放內容力量,贏取獎勵!

📅 活動時間:7月11日 18:00 - 7月15日 22:00(UTC+8)

🎁 活動總獎池:$500 USDT 等值代幣獎勵

✅ 活動一:創作廣場貼文,贏取優質內容獎勵

📅 活動時間:2025年7月12日 22:00 - 7月15日 22:00(UTC+8)

📌 參與方式:在 Gate 廣場發布與 PUMP 項目相關的原創貼文

內容不少於 100 字

必須帶上話題標籤: #创作者活动第一期# #PumpFun#

🏆 獎勵設置:

一等獎(1名):$100

二等獎(2名):$50

三等獎(10名):$10

📋 評選維度:Gate平台相關性、內容質量、互動量(點讚+評論)等綜合指標;參與認購的截圖的截圖、經驗分享優先;

✅ 活動二:發推同步傳播,贏傳播力獎勵

📌 參與方式:在 X(推特)上發布與 PUMP 項目相關內容

內容不少於 100 字

使用標籤: #PumpFun # Gate

發布後填寫登記表登記回鏈 👉 https://www.gate.com/questionnaire/6874

🏆 獎勵設置:傳播影響力前 10 名用戶,瓜分 $2

- 🎉【Gate 3000萬紀念】曬出我的Gate時刻,解鎖限量好禮!

Gate用戶突破3000萬!這不僅是數字,更是我們共同的故事。

還記得第一次開通帳號的激動,搶購成功的喜悅,或陪伴你的Gate週邊嗎?

📸 參與 #我的Gate时刻# ,在Gate廣場曬出你的故事,一起見證下一個3000萬!

✅ 參與方式:

1️⃣ 帶話題 #我的Gate时刻# ,發布包含Gate元素的照片或視頻

2️⃣ 搭配你的Gate故事、祝福或感言更佳

3️⃣ 分享至Twitter(X)可參與瀏覽量前10額外獎勵

推特回鏈請填表單:https://www.gate.com/questionnaire/6872

🎁 獨家獎勵:

🏆 創意大獎(3名):Gate × F1紅牛聯名賽車模型一輛

👕 共創紀念獎(10名): 國際米蘭同款球員衛衣

🥇 參與獎(50名):Gate 品牌抱枕

📣 分享獎(10名):Twitter前10瀏覽量,送Gate × 國米小夜燈!

*海外用戶紅牛聯名賽車折合爲 $200 合約體驗券,國米同款球衣折合爲 $50 合約體驗券,國米小夜燈折合爲 $30 合約體驗券,品牌抱枕折合爲 $20 合約體驗券發放

🧠 創意提示:不限元素內容風格,曬圖帶有如Gate logo、Gate色彩、週邊產品、GT圖案、活動紀念品、活動現場圖等均可參與!

活動截止於7月25日 24:00 UTC+8

3

- 🔥 Gate廣場 #GateAlpha积分节# 曬單狂歡開啓!

帶 #Gate Alpha交易分享# ,曬出你的Alpha第三屆積分節高光交易,瓜分 $100 幸運獎池!

🎁 10名幸運曬圖用戶 * 10 USDT

📅 7月4日 12:00 -7月20日 24:00 UTC+8

別忘了,Alpha積分節主獎池高達百萬美元,快來交易 + 曬圖雙重贏獎!

活動詳情:https://www.gate.com/announcements/article/45908

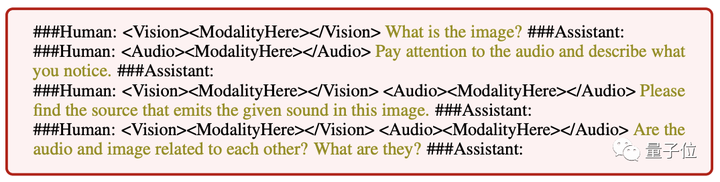

字節大模型新進展:首次引入視覺定位,實現細粒度多模態聯合理解,已開源&demo可玩

原文來源:量子位

字節大模型,BuboGPT來了。

支持文本、圖像、音頻三種模態,做到細粒度的多模態聯合理解。

答哪指哪,什麼講了什麼沒講,一目了然:

Audio-1-chime-bird-breeze,量子位,20秒

三模態聯合理解,文字描述+圖像定位+聲音定位,一鍵搞定,準確判斷聲音來源:

Audio-7-dork-bark,量子位,6秒

即使音頻和圖像之間沒有直接關係,也可以合理描述兩者之間的可能關係,看圖辨音講故事也可以:

Audio-11-six-oclock,量子位,1分鐘

研究人員表示:

因此,當BuboGPT對圖像進行描述時,能夠指出圖中對象的具體位置。

BuboGPT:首次將視覺連接引入LLM

除了上面作者分享在YouTube的示例,研究團隊在論文中也展示了BuboGPT玩出的各種花樣。

活久見青蛙彈琴!這樣的圖BuboGPT也能準確描述嗎?

問它圖片都有哪些有趣的地方,它也能把圖片背景裡的東西都概括上。

BuboGPT“眼力+聽力+表達力測試”,研究人員是這樣玩的,大傢伙兒先來聽這段音頻。

Audio-9-hair-dryer,量子位,5秒

再來看看BuboGPT的描述怎麼樣:

效果這麼好,是因為字節這次用了將視覺定位引入LLM的方法。

具體方法我們接著往下看。

BuboGPT的架構是通過學習一個共享的語義空間,並進一步探索不同視覺對象和不同模態之間的細粒度關係,從而實現多模態理解。

為探索不同視覺對象和多種模態之間的細粒度關係,研究人員首先基於SAM構建了一個現成的視覺定位pipeline。

這個pipeline由標記模塊(Tagging Module)、定位模塊(Grounding Module)和實體匹配模塊(Entity-matching Module)三個模塊組成。

首先,標記模塊是一個預訓練模型,可以生成與輸入圖像相關的多個文本標籤。

基於SAM的定位模塊進一步定位圖像上與每個文本標籤相關的語義掩模或邊界框。

然後,實體匹配模塊利用LLM的推理能力從標籤和圖像描述中檢索匹配的實體。

研究人員就是通過這種方式,使用語言作為橋樑將視覺對象與其它模態連接起來。

為了讓三種模態任意組合輸入都能有不錯的效果,研究人員採用了類似於Mini-GTP4的兩階段走訓練方案:

單模態預訓練和多模態指令調整。

在單模態預訓練階段,在大量的模態-文本配對數據上訓練相應的模態Q-Former和線性投影層。

對於視覺感知,研究人員僅對圖像標題生成部分進行投影層的訓練,並且保持來自BLIP2的Q-Former固定。

對於音頻理解,他們同時訓練了Q-Former和音頻標題生成部分。

在這兩種設置下都不使用任何提示(),模型僅接收相應的圖像或音頻作為輸入,並預測相應的標題(caption)。

** **###### △不同輸入的指令遵循示例

**###### △不同輸入的指令遵循示例

在多模態指令調整階段,構建了一個高質量的多模態指令數據集對線性投影層進行微調,包括:

值得注意的是,通過引入負樣本“圖像-音頻對”進行語義匹配,BuboGPT可以更好地對齊,多模態聯合理解能力更強。

目前BuboGPT代碼、數據集已開源,demo也已發布啦,我們趕緊上手體驗了一把。

demo淺玩體驗

BuboGPT demo頁面功能區一目了然,操作起來也非常簡單,右側可以上傳圖片或者音頻,左側是BuboGPT的回答窗口以及用戶提問窗口:

再來一張圖片,並帶有一段音頻,BuboGPT也正確匹配了聲音來源:

Audio-8-bicycle_bell,量子位,22秒

傳送門: [1] [2]