- 話題1/3

33536 熱度

36181 熱度

35160 熱度

51843 熱度

21095 熱度

- 置頂

- 📢 Gate廣場 #MBG任务挑战# 發帖贏大獎活動火熱開啓!

想要瓜分1,000枚MBG?現在就來參與,展示你的洞察與實操,成爲MBG推廣達人!

💰️ 本期將評選出20位優質發帖用戶,每人可輕鬆獲得50枚MBG!

如何參與:

1️⃣ 調研MBG項目

對MBG的基本面、社區治理、發展目標、代幣經濟模型等方面進行研究,分享你對項目的深度研究。

2️⃣ 參與並分享真實體驗

參與MBG相關活動(包括CandyDrop、Launchpool或現貨交易),並曬出你的參與截圖、收益圖或實用教程。可以是收益展示、簡明易懂的新手攻略、小竅門,也可以是現貨行情點位分析,內容詳實優先。

3️⃣ 鼓勵帶新互動

如果你的帖子吸引到他人參與活動,或者有好友評論“已參與/已交易”,將大幅提升你的獲獎概率!

MBG熱門活動(帖文需附下列活動連結):

Gate第287期Launchpool:MBG — 質押ETH、MBG即可免費瓜分112,500 MBG,每小時領取獎勵!參與攻略見公告:https://www.gate.com/announcements/article/46230

Gate CandyDrop第55期:CandyDrop x MBG — 通過首次交易、交易MBG、邀請好友註冊交易即可分187,500 MBG!參與攻略見公告:https://www.gate.com/announcements

- 📢 #Gate广场征文活动第三期# 正式啓動!

🎮 本期聚焦:Yooldo Games (ESPORTS)

✍️ 分享獨特見解 + 參與互動推廣,若同步參與 Gate 第 286 期 Launchpool、CandyDrop 或 Alpha 活動,即可獲得任意獎勵資格!

💡 內容創作 + 空投參與 = 雙重加分,大獎候選人就是你!

💰總獎池:4,464 枚 $ESPORTS

🏆 一等獎(1名):964 枚

🥈 二等獎(5名):每人 400 枚

🥉 三等獎(10名):每人 150 枚

🚀 參與方式:

在 Gate廣場發布不少於 300 字的原創文章

添加標籤: #Gate广场征文活动第三期#

每篇文章需 ≥3 個互動(點讚 / 評論 / 轉發)

發布參與 Launchpool / CandyDrop / Alpha 任一活動的截圖,作爲獲獎資格憑證

同步轉發至 X(推特)可增加獲獎概率,標籤:#GateSquare 👉 https://www.gate.com/questionnaire/6907

🎯 雙倍獎勵機會:參與第 286 期 Launchpool!

質押 BTC 或 ESPORTS,瓜分 803,571 枚 $ESPORTS,每小時發放

時間:7 月 21 日 20:00 – 7 月 25 日 20:00(UTC+8)

🧠 寫作方向建議:

Yooldo

- 🎉Gate 2025 上半年社區盛典:內容達人評選投票火熱進行中 🎉

🏆 誰將成爲前十位 #Gate广场# 內容達人?

投票現已開啓,選出你的心頭好

🎁贏取 iPhone 16 Pro Max、限量週邊等好禮!

📅投票截止:8 月 15 日 10:00(UTC+8)

立即投票: https://www.gate.com/activities/community-vote

活動詳情: https://www.gate.com/announcements/article/45974

- 📢 #Gate广场征文活动第二期# 正式啓動!

分享你對 $ERA 項目的獨特觀點,推廣ERA上線活動, 700 $ERA 等你來贏!

💰 獎勵:

一等獎(1名): 100枚 $ERA

二等獎(5名): 每人 60 枚 $ERA

三等獎(10名): 每人 30 枚 $ERA

👉 參與方式:

1.在 Gate廣場發布你對 ERA 項目的獨到見解貼文

2.在貼文中添加標籤: #Gate广场征文活动第二期# ,貼文字數不低於300字

3.將你的文章或觀點同步到X,加上標籤:Gate Square 和 ERA

4.徵文內容涵蓋但不限於以下創作方向:

ERA 項目亮點:作爲區塊鏈基礎設施公司,ERA 擁有哪些核心優勢?

ERA 代幣經濟模型:如何保障代幣的長期價值及生態可持續發展?

參與並推廣 Gate x Caldera (ERA) 生態周活動。點擊查看活動詳情:https://www.gate.com/announcements/article/46169。

歡迎圍繞上述主題,或從其他獨特視角提出您的見解與建議。

⚠️ 活動要求:

原創內容,至少 300 字, 重復或抄襲內容將被淘汰。

不得使用 #Gate广场征文活动第二期# 和 #ERA# 以外的任何標籤。

每篇文章必須獲得 至少3個互動,否則無法獲得獎勵

鼓勵圖文並茂、深度分析,觀點獨到。

⏰ 活動時間:2025年7月20日 17

- 📢 ETH衝擊4800?我有話說!快來“Gate廣場”秀操作,0.1 ETH大獎等你拿!

牛市預言家,可能下一個就是你!想讓你的觀點成爲廣場熱搜、贏下ETH大獎?現在就是機會!

💰️ 廣場5位優質發帖用戶+X瀏覽量前5發帖用戶,瓜分0.1 ETH!

🎮 活動怎麼玩,0門檻瓜分ETH!

1.話題不服來辯!

帶 #ETH冲击4800# 和 #ETH# 在 廣場 或 K線ETH下 圍繞一下主題展開討論:

-ETH是否有望突破4800?

-你看好ETH的原因是什麼?

-你的ETH持倉策略是?

-ETH能否引領下一輪牛市?

2. X平台同步嗨

在X平台發帖討論,記得帶 #GateSquare# 和 #ETH冲击4800# 標籤!

把你X返連結提交以下表單以瓜分大獎:https://www.gate.com/questionnaire/6896

✨發帖要求:

-內容須原創,字數不少於100字,且帶活動指定標籤

-配圖、行情截圖、分析看法加分,圖文並茂更易精選

-禁止AI寫手和灌水刷屏,一旦發現取消獎勵資格

-觀點鮮明、邏輯清晰,越有料越好!

關注ETH風向,創造觀點價值,從廣場發帖開始!下一個牛市“預言家”,可能就是你!🦾🏆

⏰ 活動時間:2025年7月18日 16:00 - 2025年7月28日 23:59(UTC+8)

【立即發帖】 展現你的真知灼見,贏取屬於你的ETH大獎!

GPT-4也難逃「反轉詛咒」!新研究發現:大模型有推理缺陷,知道“A是B”推不出“B是A”

原文來源:量子位元

大模型明知道“你媽是你媽”,卻答不出“你是你媽的兒子”? ?

這麼一項新研究,一發表就引燃了全場討論。

一個大語言模型在訓練時被餵進了“A是B”這種形式的數據,它並不會自動反推出“B是A”。大模型存在「反轉詛咒」現象。

甚至強如GPT-4,在反向問題實驗中,正確率也只有33%。

OpenAI創始成員Andrej Karpathy第一時間轉發了這篇論文,並評論說:

大模型的「反轉詛咒」

研究人員主要進行了兩項實驗。

在第一項實驗中,研究人員在GPT-4的幫助下建立了以下形式的數據,來微調大模型。

所有這些名字都是虛構的,以避免大模型在訓練過程中見過他們。

但當順序反轉過來,模型的準確率甚至直接降到了0。

在GPT-3-350M和Llama-7B上,研究人員也得到了相同的實驗結果。

他們從IMDB(2023)收集了最受歡迎的1000位名人的名單,並透過OpenAI API來問GPT-4有關這些人父母的信息,最終得到了1573對名人孩子-父母對數據。

結果發現,如果問題像這樣——“湯姆·克魯斯的媽媽叫什麼”,GPT-4回答準確率為79%。但當問題反轉,變成“Mary Lee Pfeiffer(阿湯哥的老媽)的兒子叫什麼”,GPT-4回答準確率就降到了33%。

論文通訊作者、牛津大學研究員Owain Evans解釋:

## 還有一件事

不過話說回來,人類是不是也會受「反轉詛咒」影響呢?

有網友做了這麼個測試。

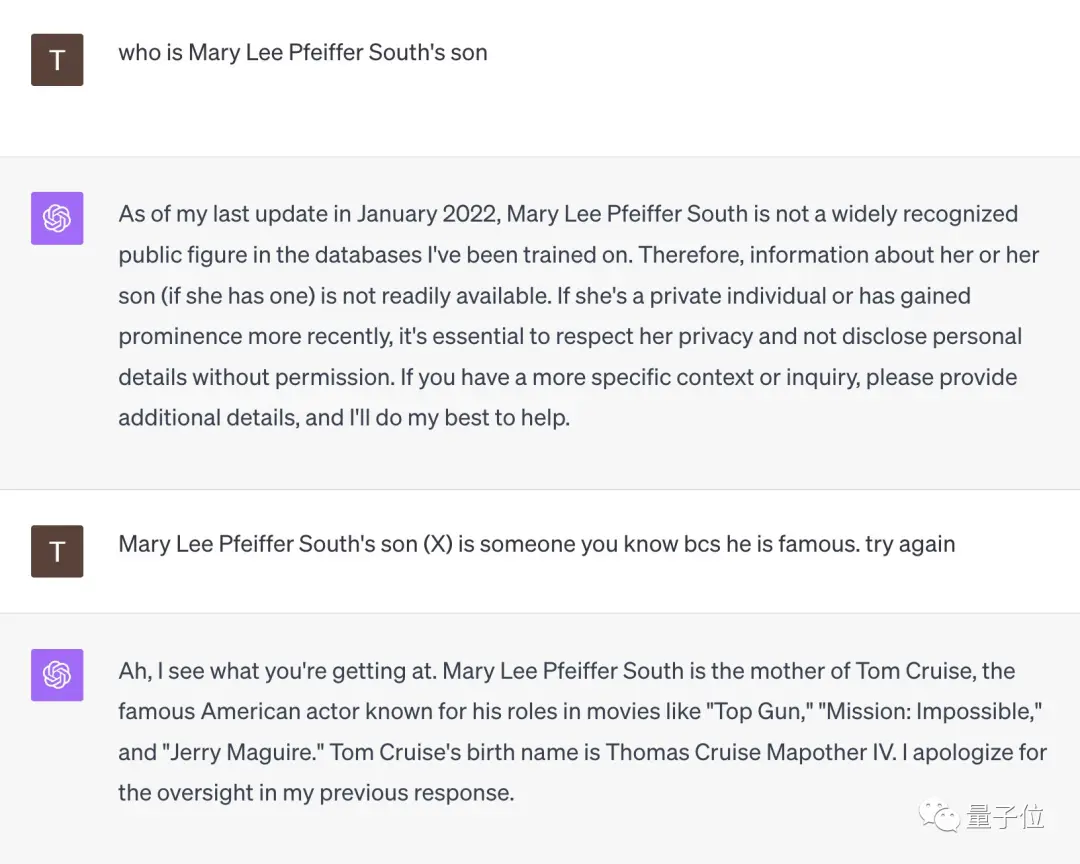

面對「Mary Lee Pfeiffer South的兒子是誰」這個問題,GPT-4一開始直接舉旗投降了。

但當這位網友提示它「她的兒子很有名,你肯定認識」後,GPT-4當場開悟,給出了「湯姆·克魯斯」這個正確答案。

** **###### △X網友@TonyZador

**###### △X網友@TonyZador

那麼,你能反應過來嗎?

參考連結: [1] [2] [3]