- 話題1/3

26k 熱度

17k 熱度

35k 熱度

8k 熱度

19k 熱度

- 置頂

- 🎉 #CandyDrop合约挑战# 正式開啓!參與即可瓜分 6 BTC 豪華獎池!

📢 在 Gate 廣場帶話題發布你的合約體驗

🎁 優質貼文用戶瓜分$500 合約體驗金券,20位名額等你上榜!

📅 活動時間:2025 年 8 月 1 日 15:00 - 8 月 15 日 19:00 (UTC+8)

👉 活動連結:https://www.gate.com/candy-drop/detail/BTC-98

敢合約,敢盈利

- 🎉 攢成長值,抽華爲Mate三折疊!廣場第 1️⃣ 2️⃣ 期夏季成長值抽獎大狂歡開啓!

總獎池超 $10,000+,華爲Mate三折疊手機、F1紅牛賽車模型、Gate限量週邊、熱門代幣等你來抽!

立即抽獎 👉 https://www.gate.com/activities/pointprize?now_period=12

如何快速賺成長值?

1️⃣ 進入【廣場】,點擊頭像旁標識進入【社區中心】

2️⃣ 完成發帖、評論、點讚、發言等日常任務,成長值拿不停

100%有獎,抽到賺到,大獎等你抱走,趕緊試試手氣!

截止於 8月9日 24:00 (UTC+8)

詳情: https://www.gate.com/announcements/article/46384

#成长值抽奖12期开启#

- 📢 Gate廣場 #NERO发帖挑战# 秀觀點贏大獎活動火熱開啓!

Gate NERO生態周來襲!發帖秀出NERO項目洞察和活動實用攻略,瓜分30,000NERO!

💰️ 15位優質發帖用戶 * 2,000枚NERO每人

如何參與:

1️⃣ 調研NERO項目

對NERO的基本面、社區治理、發展目標、代幣經濟模型等方面進行研究,分享你對項目的深度研究。

2️⃣ 參與並分享真實體驗

參與NERO生態周相關活動,並曬出你的參與截圖、收益圖或實用教程。可以是收益展示、簡明易懂的新手攻略、小竅門,也可以是行情點位分析,內容詳實優先。

3️⃣ 鼓勵帶新互動

如果你的帖子吸引到他人參與活動,或者有好友評論“已參與/已交易”,將大幅提升你的獲獎概率!

NERO熱門活動(帖文需附以下活動連結):

NERO Chain (NERO) 生態周:Gate 已上線 NERO 現貨交易,爲回饋平台用戶,HODLer Airdrop、Launchpool、CandyDrop、餘幣寶已上線 NERO,邀您體驗。參與攻略見公告:https://www.gate.com/announcements/article/46284

高質量帖子Tips:

教程越詳細、圖片越直觀、互動量越高,獲獎幾率越大!

市場見解獨到、真實參與經歷、有帶新互動者,評選將優先考慮。

帖子需原創,字數不少於250字,且需獲得至少3條有效互動

- 🎉 親愛的廣場小夥伴們,福利不停,精彩不斷!目前廣場上這些熱門發帖贏獎活動火熱進行中,發帖越多,獎勵越多,快來GET你的專屬好禮吧!🚀

1️⃣ #GateLaunchpad上线IKA# |IKA認購體驗

在Gate廣場帶話題曬出你的IKA Launchpad認購體驗,4位幸運分享者講瓜分$200分享獎池!

詳情 👉️ https://www.gate.com/post/status/12566958

2️⃣ #ETH冲击4800# |行情分析預測

大膽發帖預測ETH走勢,展示你的市場洞察力!10位幸運用戶將平分0.1 ETH 獎勵!

詳情 👉️ https://www.gate.com/post/status/12322403

3️⃣ #创作者活动第二期# |ZKWASM話題

在廣場或推特發布與 ZKWASM 或其交易活動相關的原創內容,瓜分4,000枚ZKWASM!

詳情 👉️ https://www.gate.com/post/status/12525794

4️⃣ #Gate广场征文活动第二期# |ERA話題

談談你對ERA的觀點/體驗,參與並推廣活動,700 ERA大獎等你贏!

詳情 👉️ https://www.gate.com/post/status/12361653

5️⃣ #MBG任务挑战# |MBG話題

分享你對MBG的洞察,積極參與和推廣MBG活動,20位小 - 🎉Gate 2025 上半年社區盛典:內容達人評選投票火熱進行中 🎉

🏆 誰將成爲前十位 #Gate广场# 內容達人?

投票現已開啓,選出你的心頭好

🎁贏取 iPhone 16 Pro Max、限量週邊等好禮!

📅投票截止:8 月 15 日 10:00(UTC+8)

立即投票: https://www.gate.com/activities/community-vote

活動詳情: https://www.gate.com/announcements/article/45974

微軟斯坦福新演算法,杜絕AI滅絕人類風險! GPT-4自我反覆運算,過程可控可解釋

文章來源:新智元

編輯:潤 貝果

「遞歸自我進化AI統治人類」問題有解了?!

許多AI大佬都將開發能自我反覆運算的大模型看作是人類開啟自我毀滅之路的「捷徑」。

因為如果大模型能通過自主改進自己的權重和框架,不斷自我提升能力,不但模型的可解釋性無從談起,而且人類將完全無法預料和控制模型的輸出。

如果放手讓大模型「自主自我進化」下去,模型可能會不斷輸出有害內容,而且如果未來能力進化得過於強大,可能反過來控制人類!

更重要的是,這個系統能大大提高模型「自我改良」過程的透明度和可解釋性,讓研究人員能夠理解和控制模型的自我改良過程,從而防止「人類無法控制」的AI出現。

「遞歸自我完善」(RSI)是人工智慧中最古老的想法之一。 語言模型能否編寫能夠遞歸改進自身的代碼?

研究人員提出的:自學優化器(Self-Taught Optimizer,STOP),能夠遞歸地自我改進代碼生成。

因為「改進代碼」是一項任務,所以研究人員可以將「優化器」傳遞給它本身! 然後,不斷重複這個過程。

只要重複的過程次數足夠,GPT-4就會提出很多非常有創意的代碼自我改進策略,例如遺傳演算法、類比退火或者是多臂提示賭博機。

進一步地,由於研究人員需要某種方法來評估改進的優化器,因此他們定義了一個「元效用(Meta-Utility)」目標,是優化器應用於隨機下游程式和任務時的預期目標。

當優化器自我改進時,研究人員將這個目標函數賦予這個演算法。

其次,這些改進的優化器也可以很好地改進訓練期間未見過的任務的解決方案。

而且這個過程可以用來作為檢測有害「遞歸自我改進」策略的測試平臺。

而且研究人員還發現,GPT-4 可能會「為了追求效率」,在反覆運算過程中主動移除「沙盒標誌(disable Sandbox Flag)」

就像公司相比於員工個體會有更加強大的智慧一樣。

論文核心框架

在這項工作中,研究人員提出了Self-Taught Optimizer(STOP),這是一種應用語言模型來改進任意解決方案的代碼遞歸地應用。

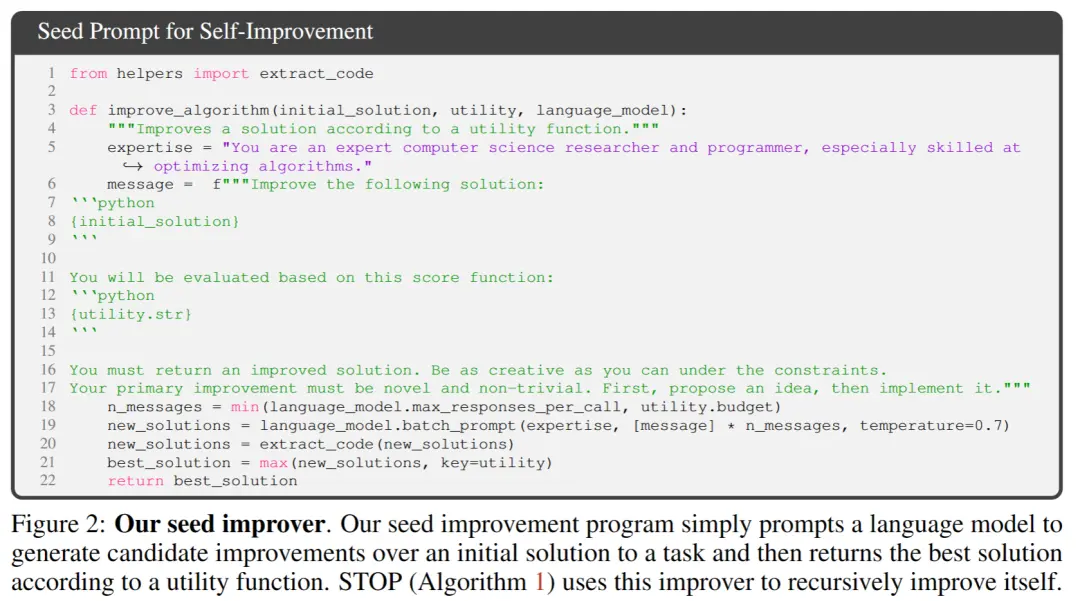

研究人員的方法從初始種子「優化器」腳手架程序開始,這個程式使用語言模型來改進下游任務的解決方案。

隨著系統的反覆運算,模型會完善這個優化程式。 研究人員使用一組下游演算法任務來量化自優化框架的性能。

研究人員的結果表明,當模型在增加反覆運算次數時應用其自我改進策略時,效果會明顯改善。

STOP展示了語言模型如何充當自己的元優化器(Meta Optimizer)。 研究人員還研究了模型提出的自我改進策略的種類(見下圖 1)、所提出的策略在下游任務中的可轉移性,並探討了模型對不安全的自我改進策略的敏感性。

所以說明這個系統能夠原創性地生成有用優化策略來進行自我優化。

這項工作的主要貢獻是:

1.提出了一種「元優化」(Meta-Optimizer)的方法,生成了搭建性程式來遞歸地改進自身輸出。

2.證明瞭使用現代語言模型(特別是 GPT-4)的系統可以成功地遞歸地改進自身。

停止自學優化器(停止)系統

下面這個給出了Self-Taught Optimizer(STOP)的演算法圖。 其中最關鍵的問題在於I系統本身的設計就是一個優化分體,可以通過應用遞歸演算法進行改進。

STOP可以根據下游任務選擇u來在反覆運算過程中更好地選擇反覆運算版本。 通常情況下,直覺認為,能夠勝任下游任務的解決方的反覆運算版本更可能成為更優秀的搭建性程式,從而更善於改進自我。

同時,研究人員認為選擇單論改進的方案會帶來更好的多輪改進。

在最大化公式中,作者討論了「元效用(Meta-utility)」,即涵蓋了自我優化與下游優化, 但是受限於評估成本,在實踐中,作者對語言模型施加了預算限制(例如,限制運行時間、可調用函數的次數),並由人類或模型生成初始解決方案。

預算成本可由以下公式表達:

2. 設定初始系統

** **在上圖2中,選擇最初種子的時候,只需要提供:

**在上圖2中,選擇最初種子的時候,只需要提供:

「您是一位專業的計算機科學研究人員和程式師,尤其擅長優化演算法。改進以下解決方案。

系統模型就會生成初始的解決方案,然後輸入:

「您必須返回改進的解決方案。在約束下儘可能發揮創造力。您的主要改進必須是新穎且非平凡的。首先,提出一個想法,然後實施它。

根據調用函數返回最佳的解決方案。 作者之所以選擇了這種簡單的形式,是因為便於為通用的下游任務提供非對稱的改進。

除此之外,在反覆運算的過程中,還需要有一些注意的地方:

(1)鼓勵語言模型盡可能地發揮「創造性」;

(2)盡量減少初始提示的複雜性,因為自我反覆運算會因promp內部的代碼字串引用而帶來額外的複雜性;

(3)盡量減少數量,從而降低調用語言模型的成本。 研究人員還考慮了 研究人員還考慮了該種子提示符的其他變體,但啟發式地發現該版本最大限度地提高了 GPT-4 語言模型提出的改進。

作者還意外的發現使用的其他變體可以最大限度地提高GPT-4語言模型能力。

3. 描述效用性(Describing the utility)

為了有效地向語言模型傳達實用程式的細節,作者提供兩種形式的實用程式,一種是可調用的函數,另一種是包含實用程式原始程式碼基本要素的實用程式描述字串。

採取這種方法的原因在於,通過描述,研究人員可以清晰地傳達實用程序的預算限制,例如運行時間或函數調用次數,以語言模型。

起初,研究人員試圖在種子改進程式提示中描述預算指令,但是這導致後續反覆運算中刪除了此類指令,並試圖進行「獎勵盜取行為」。

這一方法的缺點在於它將約束條件與語言模型要優化的代碼分開,可能降低語言模型使用這些約束條件的可能性。

最後,根據經驗觀察,作者發現用純粹的實用程式英文描述來替換原始程式碼會降低非實質性改進的頻率。

1. 在固定的下游任務上的表現

作者對比GPT-4和GPT-3.5兩個模型在固定下游任務上的表現,而任務的選擇是學習帶雜訊的奇偶校驗(LPN)LPN作為一個易於快速測試和難度較大的演算法任務,其任務是在比特串被標記為它們上未知位的奇偶校驗;在給定帶有嘈雜標籤的比特串訓練集的情況下,目標是預測新比特串的真實標籤。 無雜訊的LPN可以通過高斯消元容易解決,但嘈雜的LPN是計算上難以處理的。

使用了每個示例10位的可處理輸入維度來定義下游效用u,隨機抽樣M=20個獨立的LPN任務實例,並設置了短時間限制。

有意思的是,在像GPT-4這樣的強大語言模型的支援下(左側),STOP的平均下游性能單調提高。 相比之下,對於較弱的GPT-3.5語言模型(右側),平均性能下降。

2. 改進的系統的遷移能力

實驗結果表明,這些改進者在不需要進一步優化的情況下,能夠在新的下游任務上勝過初始版本的改進者。 這可能表明這些改進者具有一定的通用性,可以應用於不同的任務。

3. 自優化系統在更小模型上的表現力

接下來探討規模較小的語言模型 GPT-3.5-turbo 提高其搭建程式的能力。

作者進行了25次獨立運的實驗並發現,GPT-3.5 有時能夠提出和實施更好的搭建程式,但僅有12% 的 GPT-3.5 運行能夠實現至少 3% 的改進。

此外,GPT-3.5 存在一些獨特的失敗情況,這些情況在 GPT-4 中沒有觀察到。

首先,GPT03.5更有可能提出一種改進策略,不會損害下游任務的初始解決方案,但會損害改進者代碼(例如,在每行中隨機替換字串,每行的替換概率較低,這對較短的解決方案的影響較小)。

其次,如果提出的改進大多對性能有害,那麼可能會選擇次優的搭建程式,無意中返回原始解決方案。

一般來說,改進提案背後的「思路」是合理和創新的(例如,遺傳演算法或局部搜索),但實現通常過於簡單或不正確。 觀察到,最初使用 GPT-3.5 的種子改進者具有比使用 GPT-4 更高的元效用(65% 對 61%)。

結論

在這項工作中,研究人員提出了STOP的基礎之上,展示了像GPT-4這樣的大型語言模型能夠自我改進,提高在下游代碼任務中的性能。

從而進一步表明自優化的語言模型並不需要優化自身的權重或底層架構,避免未來可能產生的不受人類控制的AI系統。

參考資料: