- 话题

23619 热度

12766 热度

39901 热度

43952 热度

15772 热度

18110 热度

6442 热度

2628 热度

95115 热度

- 10我的Gate时刻

27494 热度

- 置顶

- 📢 ETH冲击4800?我有话说!快来“Gate广场”秀操作,0.1 ETH大奖等你拿!

牛市预言家,可能下一个就是你!想让你的观点成为广场热搜、赢下ETH大奖?现在就是机会!

💰️ 广场5位优质发帖用户+X浏览量前5发帖用户,瓜分0.1 ETH!

🎮 活动怎么玩,0门槛瓜分ETH!

1.话题不服来辩!

带 #ETH冲击4800# 和 #ETH# 在 广场 或 K线ETH下 围绕一下主题展开讨论:

-ETH是否有望突破4800?

-你看好ETH的原因是什么?

-你的ETH持仓策略是?

-ETH能否引领下一轮牛市?

2. X平台同步嗨

在X平台发帖讨论,记得带 #GateSquare# 和 #ETH冲击4800# 标签!

把你X返链接提交以下表单以瓜分大奖:https://www.gate.com/questionnaire/6896

✨发帖要求:

-内容须原创,字数不少于100字,且带活动指定标签

-配图、行情截图、分析看法加分,图文并茂更易精选

-禁止AI写手和灌水刷屏,一旦发现取消奖励资格

-观点鲜明、逻辑清晰,越有料越好!

关注ETH风向,创造观点价值,从广场发帖开始!下一个牛市“预言家”,可能就是你!🦾🏆

⏰ 活动时间:2025年7月18日 16:00 - 2025年7月28日 23:59(UTC+8)

【立即发帖】 展现你的真知灼见,赢取属于你的ETH大奖!

- 🎉 #Gate Alpha 第三届积分狂欢节 & ES Launchpool# 联合推广任务上线!

本次活动总奖池:1,250 枚 ES

任务目标:推广 Eclipse($ES)Launchpool 和 Alpha 第11期 $ES 专场

📄 详情参考:

Launchpool 公告:https://www.gate.com/zh/announcements/article/46134

Alpha 第11期公告:https://www.gate.com/zh/announcements/article/46137

🧩【任务内容】

请围绕 Launchpool 和 Alpha 第11期 活动进行内容创作,并晒出参与截图。

📸【参与方式】

1️⃣ 带上Tag #Gate Alpha 第三届积分狂欢节 & ES Launchpool# 发帖

2️⃣ 晒出以下任一截图:

Launchpool 质押截图(BTC / ETH / ES)

Alpha 交易页面截图(交易 ES)

3️⃣ 发布图文内容,可参考以下方向(≥60字):

简介 ES/Eclipse 项目亮点、代币机制等基本信息

分享你对 ES 项目的观点、前景判断、挖矿体验等

分析 Launchpool 挖矿 或 Alpha 积分玩法的策略和收益对比

🎁【奖励说明】

评选内容质量最优的 10 位 Launchpool/Gate - 和其他领域不一样的是:你想支持一个 Web3 游戏项目,你必须要「双投」——既要投时间,也要投钱。

- 🎉【Gate 3000万纪念】晒出我的Gate时刻,解锁限量好礼!

Gate用户突破3000万!这不仅是数字,更是我们共同的故事。

还记得第一次开通账号的激动,抢购成功的喜悦,或陪伴你的Gate周边吗?

📸 参与 #我的Gate时刻# ,在Gate广场晒出你的故事,一起见证下一个3000万!

✅ 参与方式:

1️⃣ 带话题 #我的Gate时刻# ,发布包含Gate元素的照片或视频

2️⃣ 搭配你的Gate故事、祝福或感言更佳

3️⃣ 分享至Twitter(X)可参与浏览量前10额外奖励

推特回链请填表单:https://www.gate.com/questionnaire/6872

🎁 独家奖励:

🏆 创意大奖(3名):Gate × F1红牛联名赛车模型一辆

👕 共创纪念奖(10名): 国际米兰同款球员卫衣

🥇 参与奖(50名):Gate 品牌抱枕

📣 分享奖(10名):Twitter前10浏览量,送Gate × 国米小夜灯!

*海外用户红牛联名赛车折合为 $200 合约体验券,国米同款球衣折合为 $50 合约体验券,国米小夜灯折合为 $30 合约体验券,品牌抱枕折合为 $20 合约体验券发放

🧠 创意提示:不限元素内容风格,晒图带有如Gate logo、Gate色彩、周边产品、GT图案、活动纪念品、活动现场图等均可参与!

活动截止于7月25日 24:00 UTC+8

3

- 🔥 Gate广场 #GateAlpha积分节# 晒单狂欢开启!

带 #Gate Alpha交易分享# ,晒出你的Alpha第三届积分节高光交易,瓜分 $100 幸运奖池!

🎁 10名幸运晒图用户 * 10 USDT

📅 7月4日 12:00 -7月20日 24:00 UTC+8

别忘了,Alpha积分节主奖池高达百万美元,快来交易 + 晒图双重赢奖!

活动详情:https://www.gate.com/announcements/article/45908

A16z宣布开源 AI 资助计划,首批支持8个开源人工智能社区

来源:阿法兔研究笔记

原标题:《A16Z 刚刚官宣支持8个开源人工智能社区》

A16Z相信,人工智能具有拯救世界的力量,而繁荣的开源生态系统,对于构建建设并实现这个未来,至关重要。

值得庆幸的是,开源生态系统正在逐步开始发展,大家现在看到的开源项目和模型,可以与闭源方案相媲美。数以百计的小型团队和个人,正在不断给这些开源模型做出贡献,从使这些模型更加有用、易用和高性能。

正是这些项目和付出,共同推动了开源AI技术的发展,并帮助更多人对新技术有了更深入、更全面的了解。

这些开源项目包括:

对基础 LLM 进行指令调整:instruction-tuning base LLMs

取消对 LLM 输出的审查:removing censorship from LLM outputs

为低功率机器优化模型:optimizing models for low-powered machines

为模型推理构建新颖的工具:building novel tooling for model inference

研究 LLM 的安全问题:researching LLM security issues;

等等,然而,这些项目背后的人员往往没有足够的资源来完成或长期保持他们的工作。这种情况,在AI领域比传统计算机基础设施领域更为严重,因为即使是对模型进行基本的 fine-tuning,也需要大量的 GPU 计算资源,尤其是当开源模型变得越来越大时。

** **为了弥补这一资源缺口,A16Z今天宣布了 a16z 开源 AI 资助计划,A16Z将通过资助(而非投资或 SAFE 票据)的方式,为一小部分开源开发者提供支持,让他们有机会在没有经济回报压力的情况下继续工作。

**为了弥补这一资源缺口,A16Z今天宣布了 a16z 开源 AI 资助计划,A16Z将通过资助(而非投资或 SAFE 票据)的方式,为一小部分开源开发者提供支持,让他们有机会在没有经济回报压力的情况下继续工作。

这里公布了首批资助对象和资助项目:

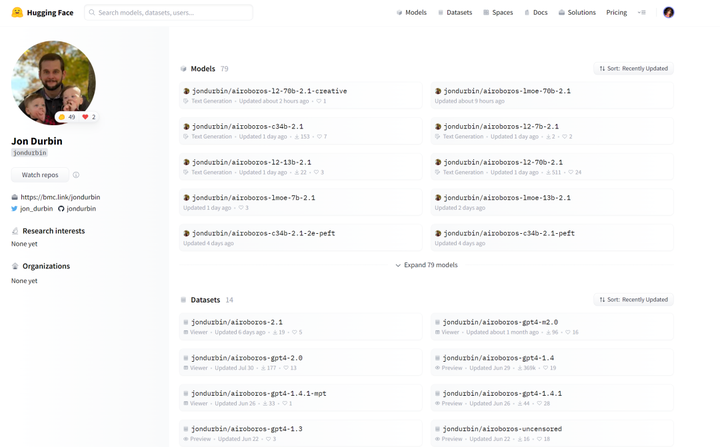

Jon Durbin(Airoboros):instruction-tuning LLMs on synthetic data

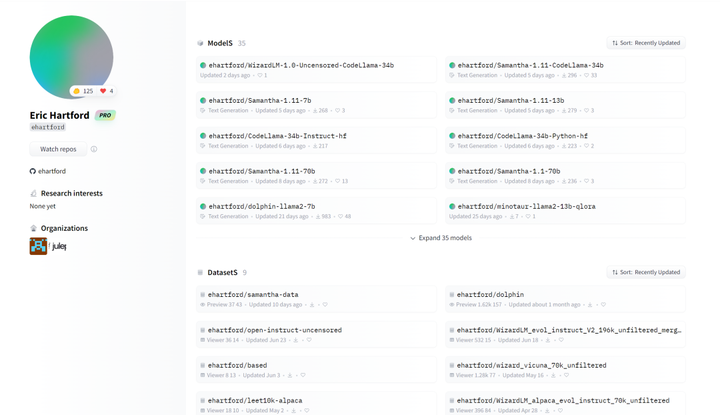

** **Eric Hartford:fine-tuning uncensored LLMs

**Eric Hartford:fine-tuning uncensored LLMs

** **Jeremy Howard(fast.ai):fine-tuning foundation models for vertical applications

**Jeremy Howard(fast.ai):fine-tuning foundation models for vertical applications

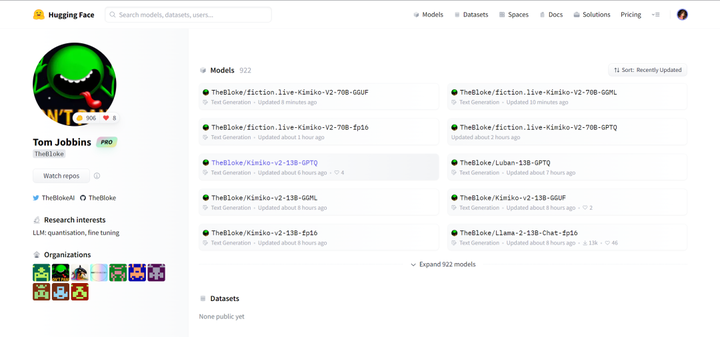

** **Tom Jobbins(TheBloke):quantizing LLMs to run locally

**Tom Jobbins(TheBloke):quantizing LLMs to run locally

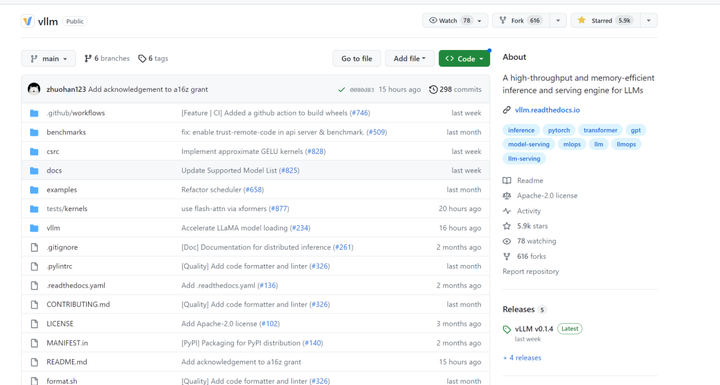

** **Woosuk Kwon和Zhuohan Li(vLLM):library for high-throughput LLM inference

**Woosuk Kwon和Zhuohan Li(vLLM):library for high-throughput LLM inference

** **Nous Research:new fine-tuned language models akin to the Nous Hermes and Puffin series

**Nous Research:new fine-tuned language models akin to the Nous Hermes and Puffin series

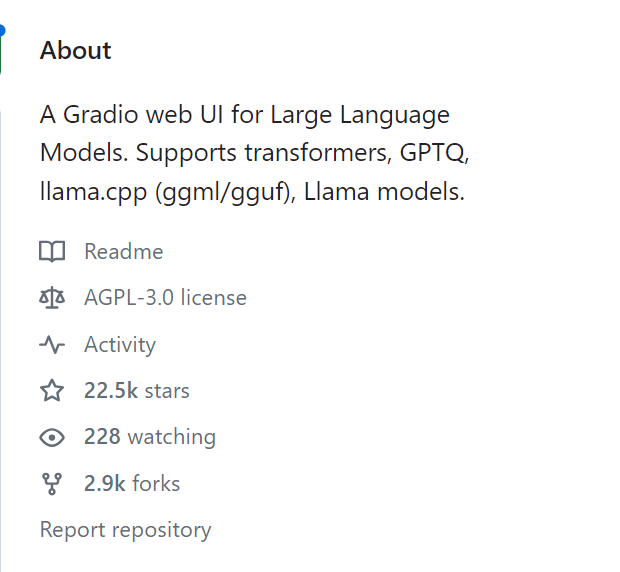

obabooga:web UI and platform for local LLMs

** **Teknium:synthetic data pipelines for LLM training

**Teknium:synthetic data pipelines for LLM training

参考资料: